DiffFit: Unlocking Transferability of Large Diffusion Models via Simple Parameter-Efficient Fine-Tuning

Enze Xie, Lewei Yao, Han Shi, Zhili Liu, Daquan Zhou, Zhaoqiang Liu, Jiawei Li, Zhenguo Li

[Huawei Noah’s Ark Lab]

华为诺亚方舟实验室:http://dev3.noahlab.com.hk

DiffFit: 通过简单的参数高效微调解锁大扩散模型可迁移性

要点:

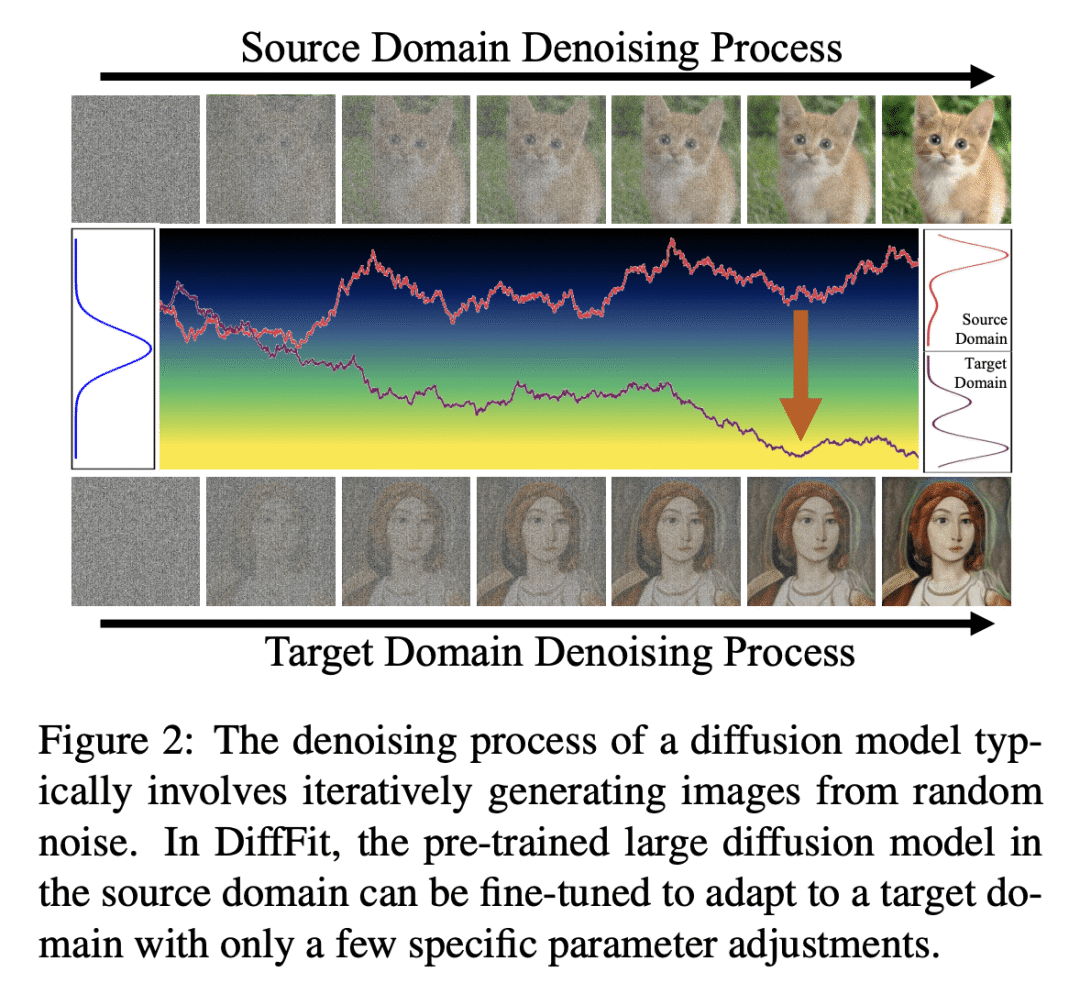

- 动机:虽然扩散模型在生成高质量图像方面表现出色,但将大型预训练扩散模型应用于新领域仍然是一个挑战。本文的动机是开发一种简单且高效的微调策略,以提高扩散模型在实际应用中的适用性。

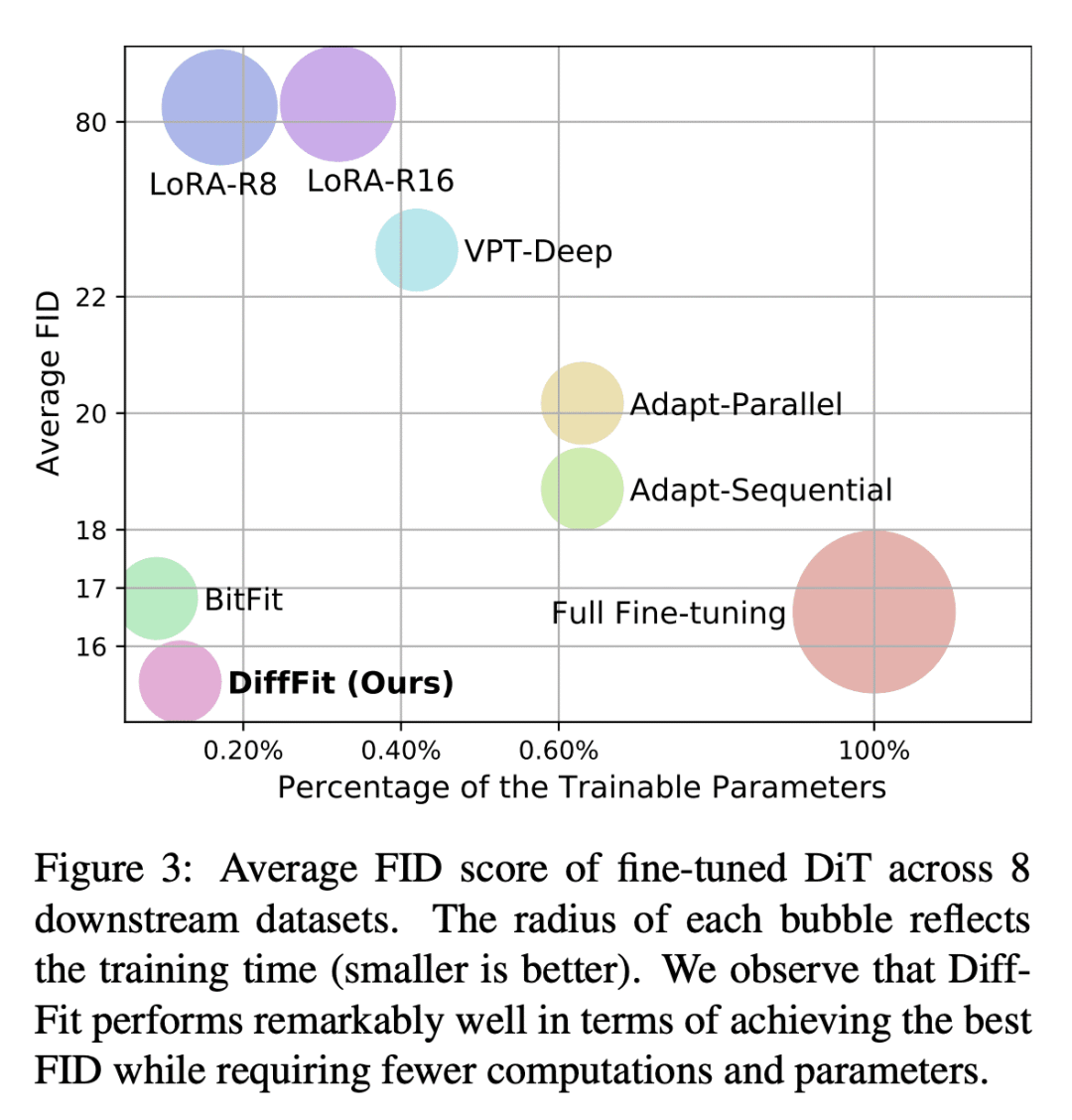

- 方法:本文提出DiffFit,一种参数高效的微调策略,仅微调特定层中的偏置项和新添加的缩放因子,以快速适应新领域,还提供了直观的理论分析和详细的消融研究,以进一步深入了解这种简单的参数高效微调策略如何快速适应新的分布。

- 优势:DiffFit可以快速适应新领域,并且仅使用0.12%的可训练参数。在8个下游数据集上,DiffFit表现优异,与现有的微调策略相比具有更高的效率和更好的性能。此外,DiffFit可以将低分辨率生成模型无缝扩展到高分辨率图像生成,从而实现更好的生成效果和更快的训练时间。

一句话总结:

提出一种名为DiffFit的参数高效的微调策略,可以快速适应新的领域。该方法仅微调特定层中的偏置项和新添加的缩放因子,而不需要微调所有参数,从而降低了模型存储成本和训练时间,并且能够在多个数据集上实现较好的效果。

https://arxiv.org/abs/2304.06648

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง