M2T: Masking Transformers Twice for Faster Decoding

F Mentzer, E Agustsson, M Tschannen

[Google Research]

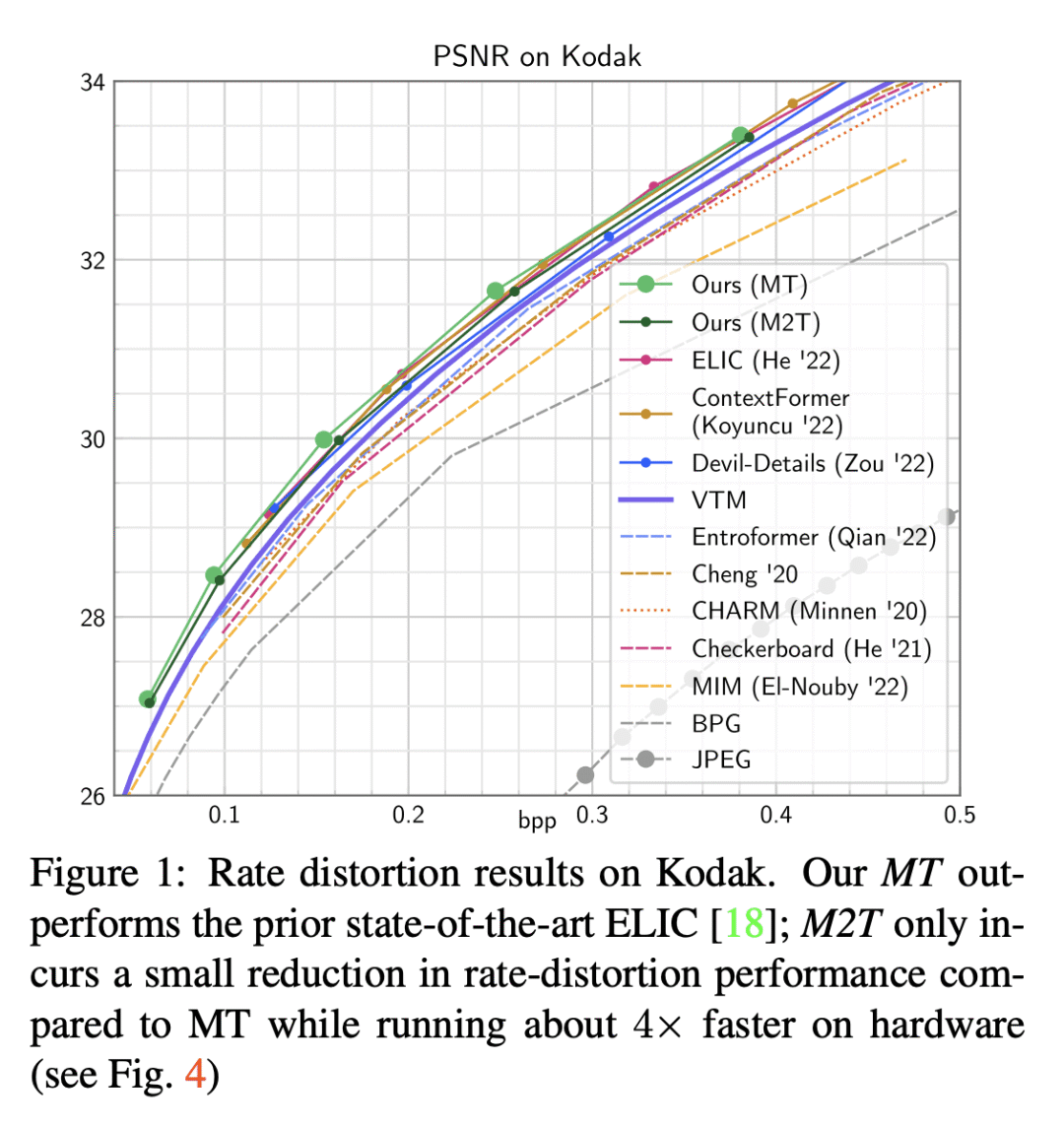

- 动机:提高神经图像压缩的效果,加速神经图像压缩模型的推理速度。

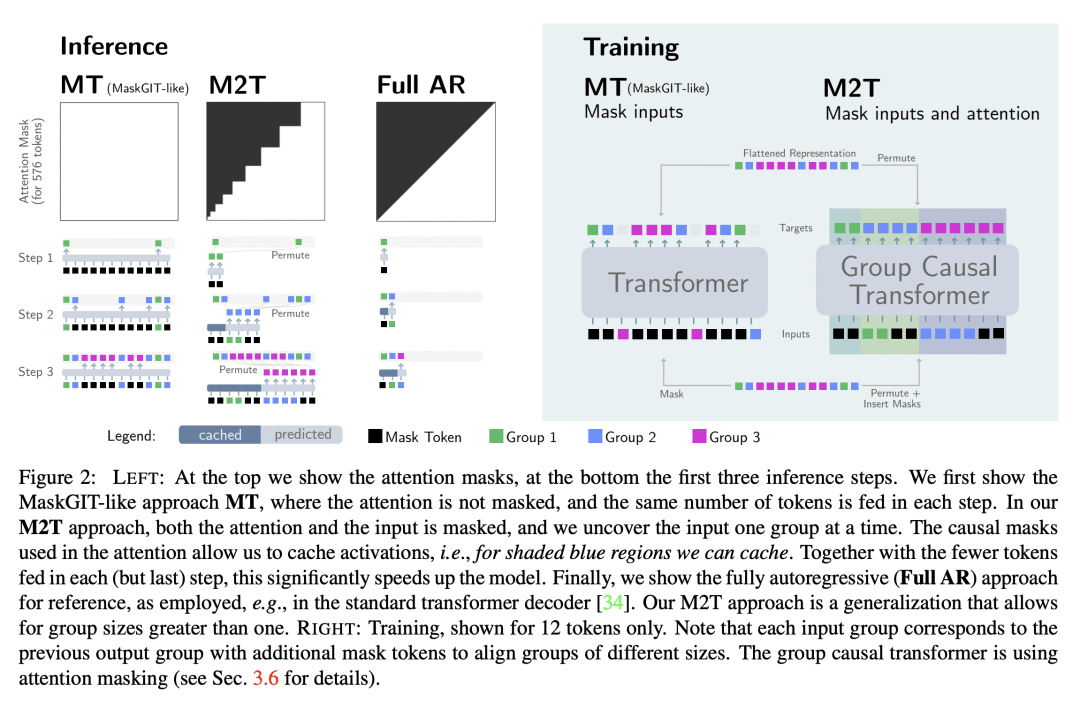

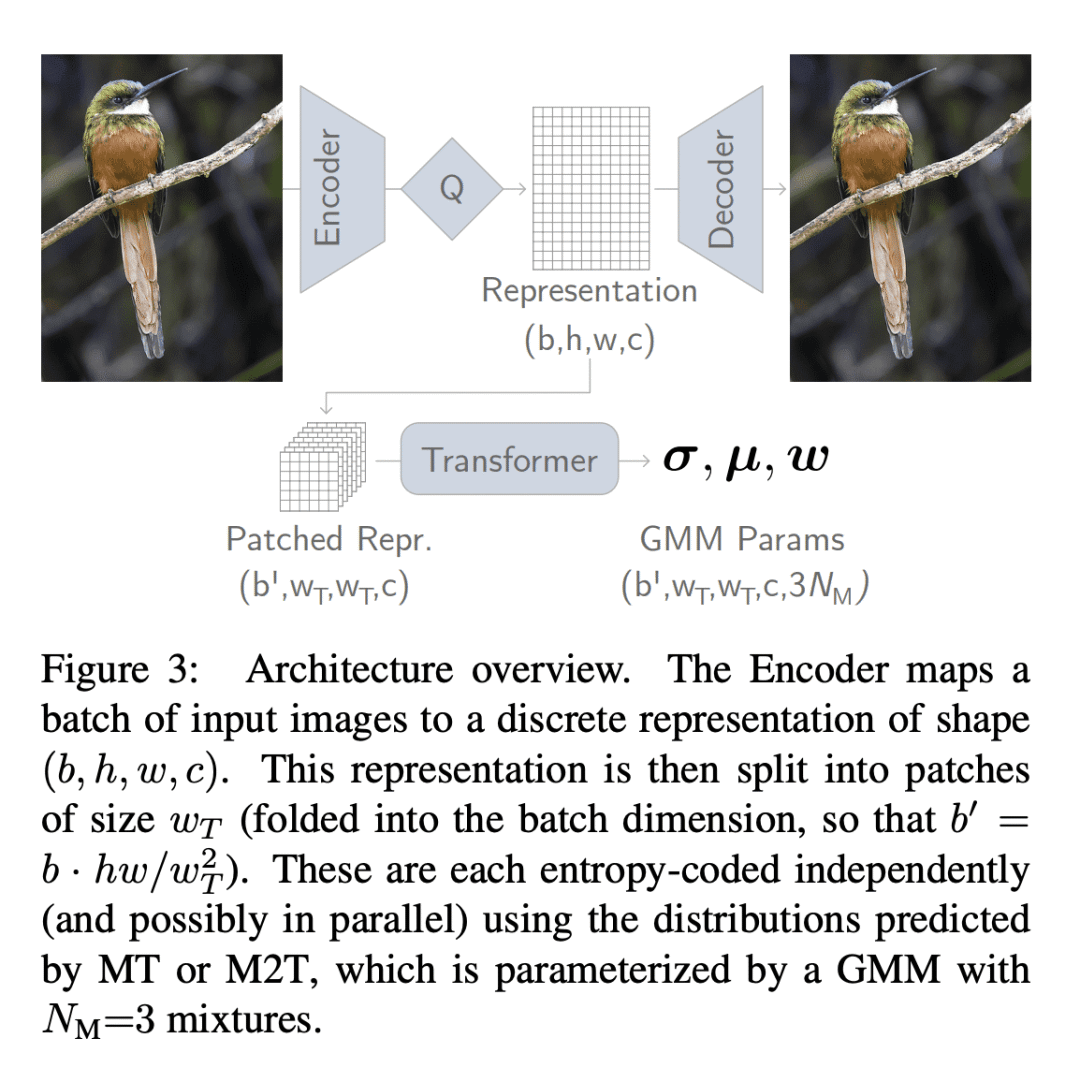

- 方法:利用预先定义的、确定性的时间表对掩码Transformer进行双掩码,从而加速模型并提高压缩效果。同时,使用掩码的注意力机制进行训练,并在推理过程中使用激活缓存技术,进一步提高模型的推理速度。

- 优势:相比之前的方法,这种新的神经图像压缩方法不需要使用多尺度模型,而是使用标准的Transformer应用于瓷砖,从而实现了更快速的推理和更好的压缩效果。此外,这种方法可以在固定、确定性的时间表下表现良好,进一步提高了模型的可靠性和实用性。

提出一种新的神经图像压缩方法,利用预先定义的、确定性的时间表对掩码Transformer进行双掩码,从而加速模型并提高压缩效果。

https://arxiv.org/abs/2304.07313

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง