Learning to Compress Prompts with Gist Tokens

Jesse Mu, Xiang Lisa Li, Noah Goodman

Jesse Mu是斯坦福大学CS博士的5年级学生,Anthropic的兼职

Noah Goodman,斯坦福大学心理学、计算机科学和语言学副教授

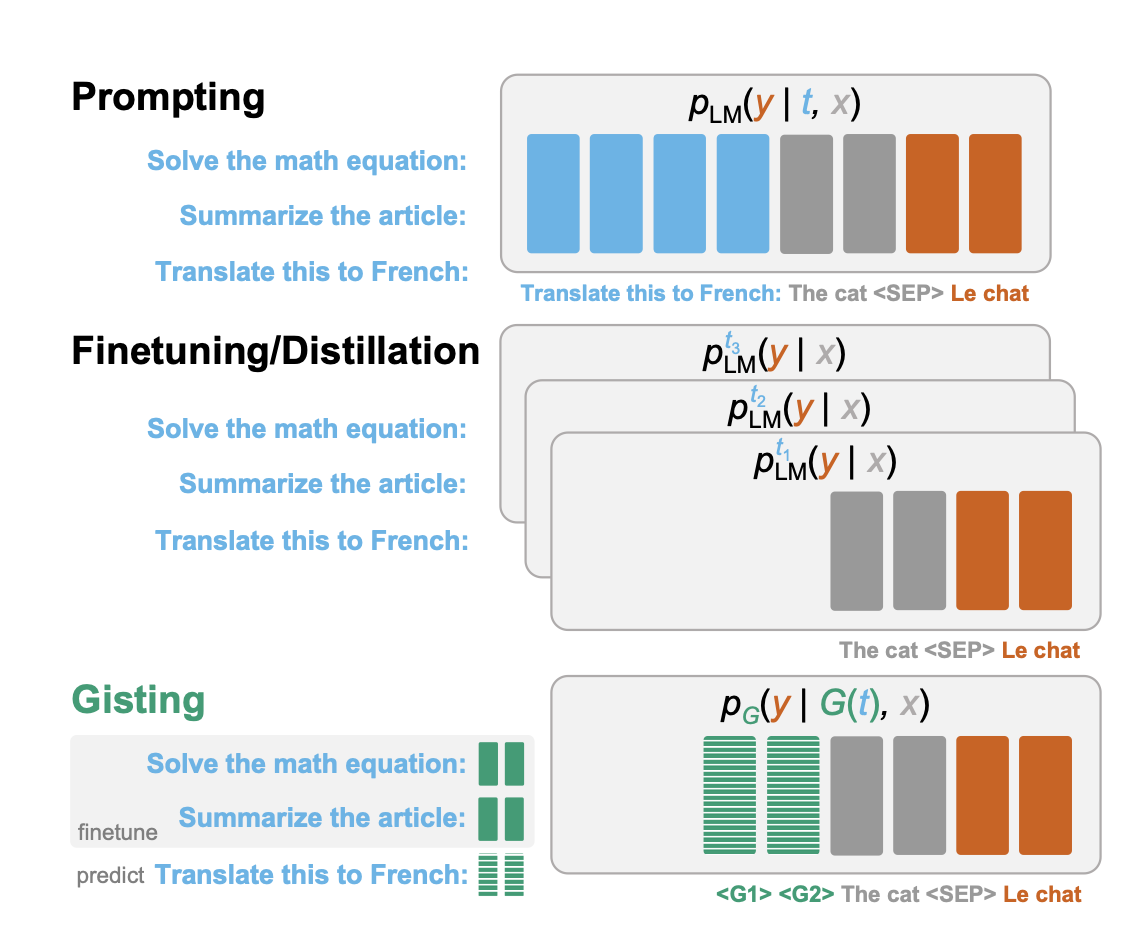

提示是目前利用语言模型(LM)的多任务能力的主要方式,但提示占用了输入上下文窗口的宝贵空间,而且对同一提示进行重新编码在计算上也很低效。微调和蒸馏方法允许在没有提示的情况下实现LM的专业化,但需要为每个任务重新训练模型。

https://arxiv.org/abs/2304.08467

为了完全避免这种权衡,我们提出了gisting,它训练LM将提示压缩成较小的 “gist “标记集,可以重复使用以提高计算效率。Gist模型可以很容易地被训练成指令微调的一部分,通过一个限制性的注意力面具来鼓励提示压缩。在解码器(LLaMA-7B)和编码器-解码器(FLAN-T5-XXL)LM上,Gisting可以实现高达26倍的提示压缩,从而使FLOPs减少40%,挂壁时间加快4.2%,节省存储,并且输出质量损失最小。

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง