【论文速读】是OpenBMB发起的大模型论文学习栏目,用 高效的思维导图 形式,带领大家在 10min 内快速掌握一篇 前沿经典 论文。我们邀请来自清华大学自然语言处理实验室以及各大高校、科研机构的 学术达人 作为主讲人分享 大模型领域 的论文。

本期论文速读带大家了解如何利用现有的大语言模型和图像模型来高效率地训练一个多模态的预训练模型——BLIP-2: Bootstrapping Language-Image Pre-training with Frozen Image encoders and Large Language Models,由清华大学自然语言处理实验室硕士研究生余天予进行领读讲解。

01 作者信息

Junnan Li,Dongxu Li,Silvio Savarese,Steven Hoi

02 论文简介

关键词 KeyWords

Vision-language Pre-training

Efficient Pre-training

Instruction Following

摘要概览 Abstract

利用现成的大语言模型和图像模型来高效率地训练一个多模态模型

03 研究设计

研究思路

将视觉特征表示和文本特征表示进行对齐

研究方法

-

第一阶段

固定视觉预训练模型,通过三个任务来训练一个 Q-Former 将图像输入中的语义编码到一个和文本特征空间相似的特征空间中。具体来讲,模型基于 K 个可学习的 query 嵌入和 cross-attention 机制从图像中获取特征,三个任务包括:

-

1. 图文匹配:对输入的(图像,文本)二元组分类,判断其是否相关

-

2. 基于图像的文本生成:给定图像输入,生成对应的文本描述

-

3. 图文对比学习:拉近图像特征和对应文本特征的距离,增大其和无关文本特征的距离

-

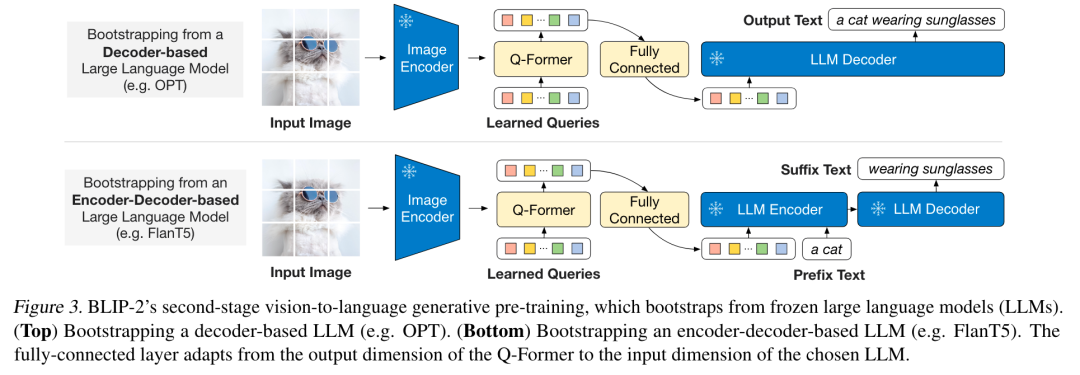

第二阶段

将 Q-Former 的输出通过一个全联接网络输入给固定的大语言模型,通过【基于图像的文本生成】任务将与文本特征进行了初步对齐的视觉特征进一步编码为大语言模型可以理解的输入。

04 实验结果

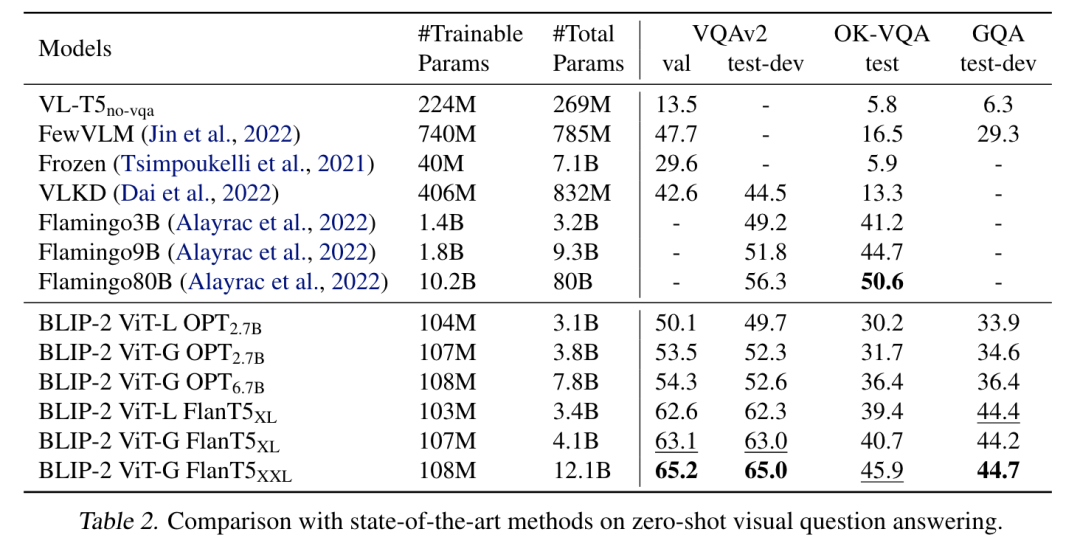

零样本性能

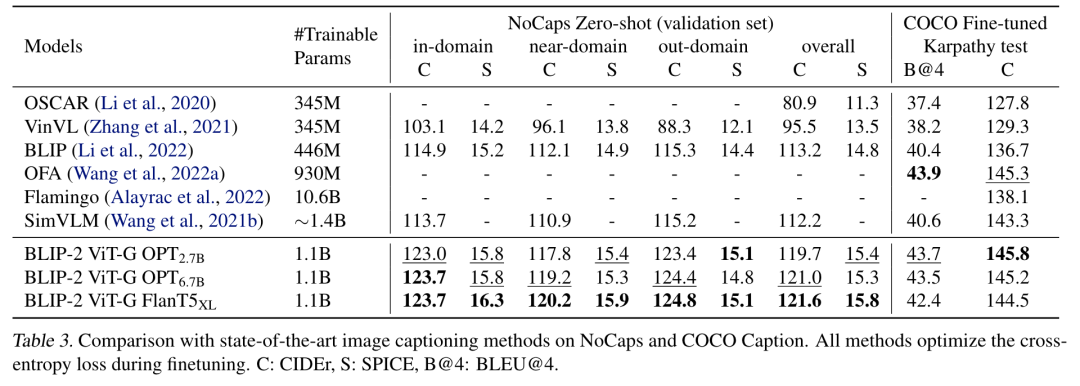

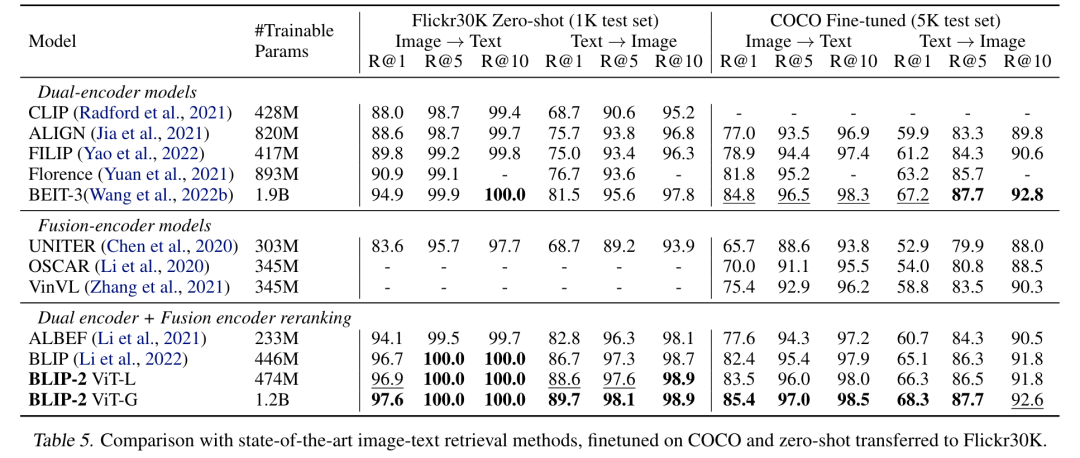

BLIP-2 仅仅通过训练轻量的 Q-Former 和一个很小的全连接网络,便可以在零样本的 VQA 任务或是零样本的 Image Captioning 任务上实现 SoTA (state-of-the-art)的性能。

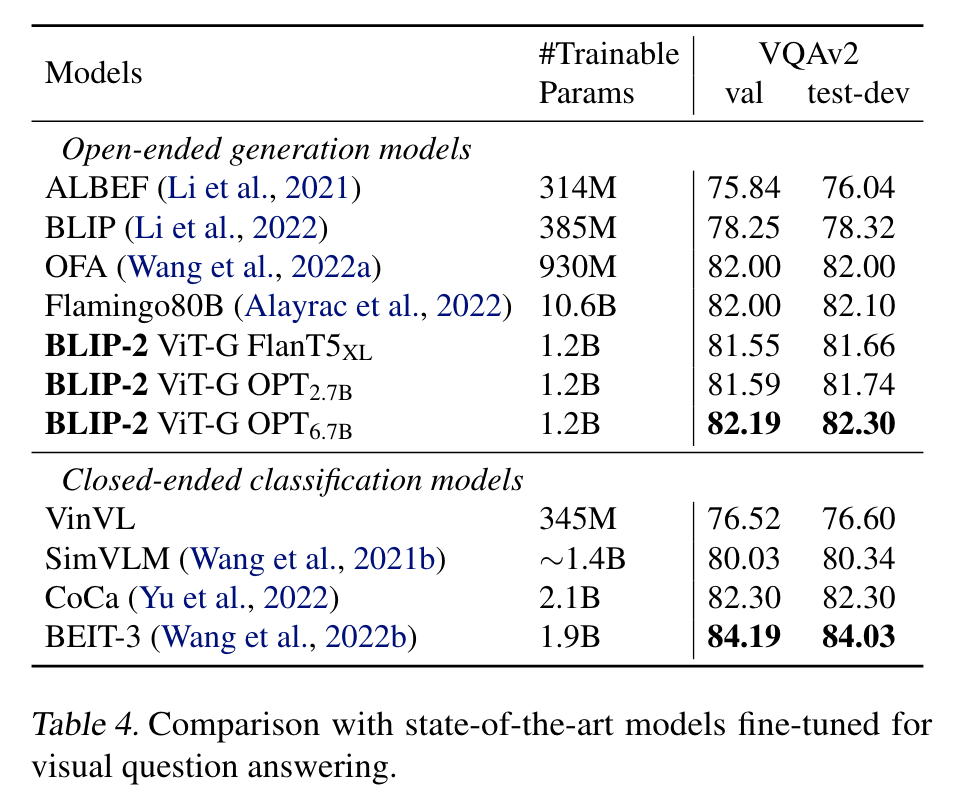

微调性能

在微调的场景下(例如 QA 任务)也能够取得不错的性能,相比一些更大的模型, BLIP-2 能够以更少的可训练参数取得更好的性能。

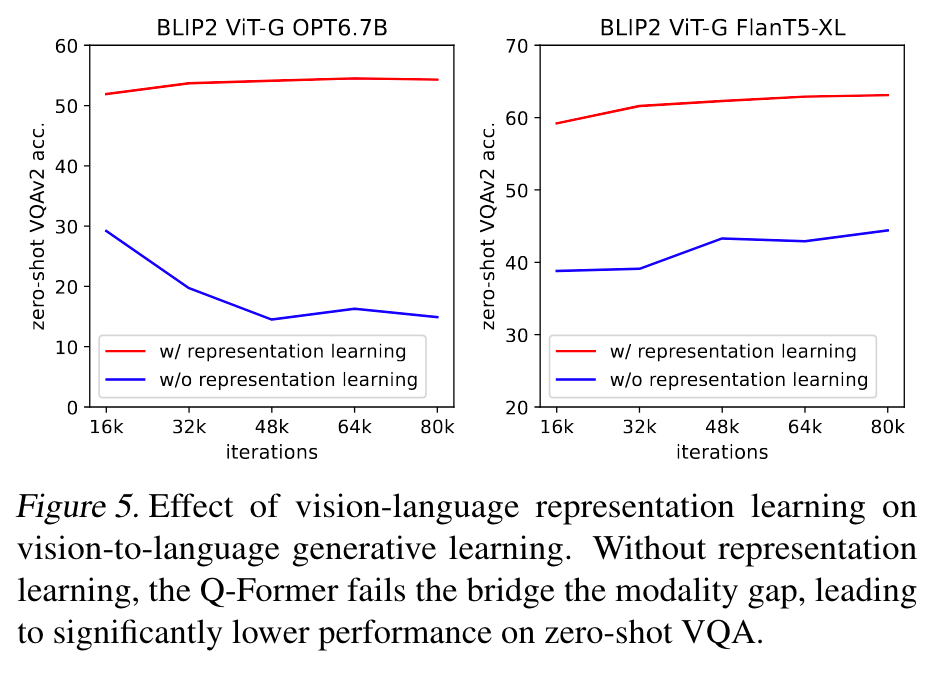

第一阶段消融实验

进行第一阶段的微调/训练之后,模型能够在下游任务上有更好的表现

05 论文贡献

优点

-

通过固定单模态的预训练模型,BLIP-2 大大减少了预训练所需的计算和数据资源。

-

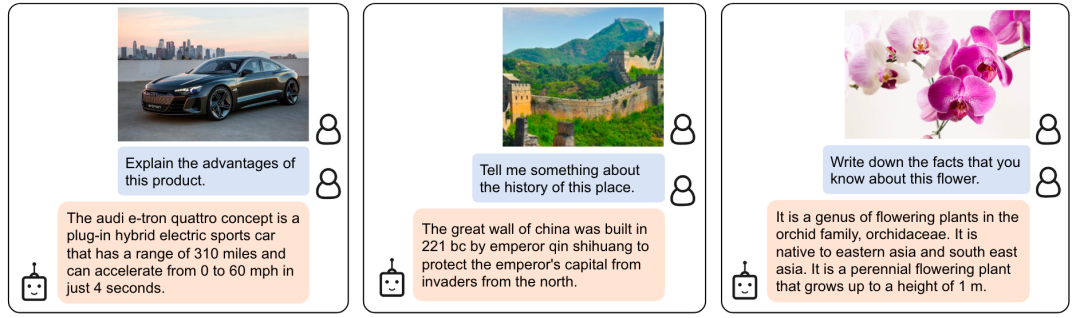

通过固定大语言模型的参数,BLIP-2 保留了大语言模型的 Instruction Following 能力。

缺点

-

模型没有多模态的 In-Context-Learning 能力

-

保留了大语言模型的一些缺点,比如可能输出不准确的信息

▾ 传送门 论文链接

🔗 https://arxiv.org/abs/2301.12597

▾ 公众号回复 「论文速读」

即可获得高清完整版思维导图

我们为读者准备了一份高清思维导图,包括了论文中的重点亮点以及直观的示意图。点击下方名片 关注 OpenBMB ,后台发送“论文速读” ,即可领取论文学习高清思维导图和 FreeMind !

以上是本期论文速读的全部内容,后续 OpenBMB 会围绕大模型介绍更多前沿论文,欢迎大家持续关注!👏

➤ 加社群/ 提建议/ 有疑问

请找 OpenBMB 万能小助手:

官方网站

https://www.openbmb.org

GitHub

https://github.com/OpenBMB

https://github.com/thunlp

技术文章

Delta Tuning 登陆 Nature子刊 | 大模型工具学习引擎 BMTools

CPM-Ant 训练完成 | BMInf 适配GLM-130B

高效训练工具 BMTrain | BMTrain 技术原理

CPM-Live 邀请函 | CPM-Live 训练启动

OpenBMB 社区介绍 | 大模型课程

大模型榜单 BMList

长期开放招聘|含实习

开发岗 | 研发岗 | 运营岗

交流QQ群

735930538

欢迎转载

商务合作请联系

openbmb@gmail.com

👏期待您的关注与加入👏

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง