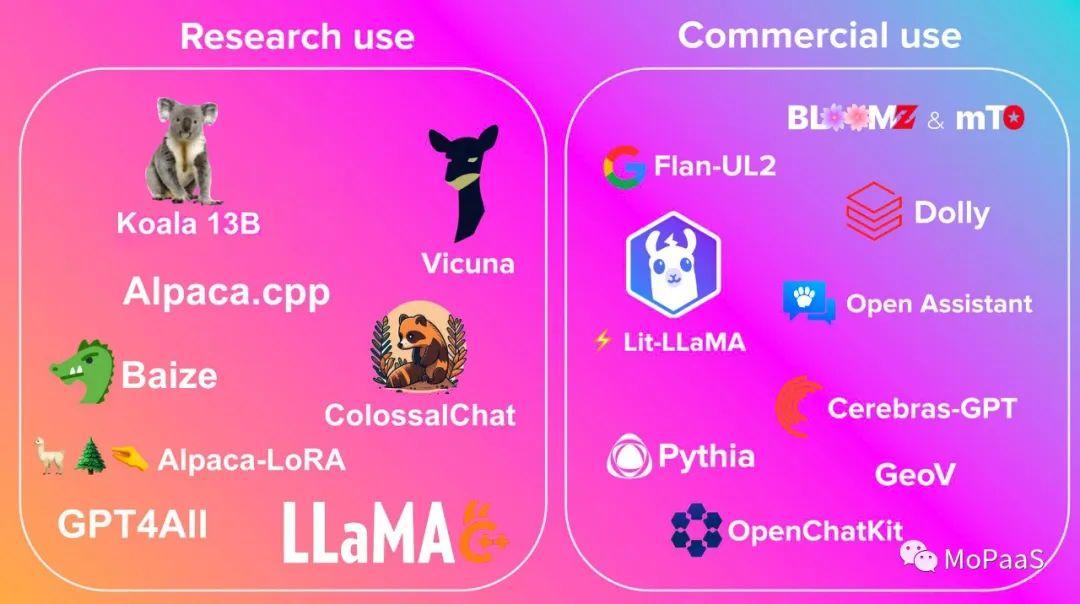

【编者按:自 C++hatGPT 发布之后,大型语言模型(LLM)俨然已经成为当下 AI 技术研发与应用中最重要的方向,以下是当今开源 LLM 的一个清单(此清单不包括国内的开源大模型);它是以 Stripe 的 AI 产品经理 Sahar Mor 在领英上发布并由图灵奖得主 Yann LeCun 转发推荐的一个清单为基础补充整理而成 ;其中大多数是在近几周内发布的,欢迎大家进一步补充交流 。如需转载,请联系我们(ID:15937102830)】

商业使用(可以商用)

—

𝗙𝗹𝗮𝗻-𝗨𝗟𝟮

谷歌的开源LLM,Flan-UL2是一种基于T5架构的编解码器模型。它使用与去年早些时候发布的UL2型号相同的配置。使用“Flan”提示调优和数据集收集对其进行了微调。

演示链接:https://lnkd.in/gWj6deRJ

𝗢𝗽𝗲𝗻𝗖𝗵𝗮𝘁𝗞𝗶𝘁

创建专用和通用的聊天机器人

演示链接:https://lnkd.in/gfY9t7Vu

𝗖𝗲𝗿𝗲𝗯𝗿𝗮𝘀-𝗚𝗣𝗧

Cerebras-GPT系列的发布是为了促进使用开放架构和数据集研究 LLM 缩放定律,并展示在 Cerebras 软件和硬件堆栈上训练 LLM 的简单性和可扩展性。所有 Cerebras-GPT 模型都可用于 Hugging Face。该系列包括 111M、256M、590M、1.3B、2.7B、6.7B 和 13B 型号。

Cerebras-GPT系列中的所有模型都根据计算最优的Chinchilla 缩放法则(每个模型参数 20 个标记)进行了训练。

这些模型在由 16 个 CS-2 晶圆级系统组成的Andromeda AI 超级计算机上进行训练。Cerebras 的权重流技术通过将计算与模型存储分离来简化 LLM 的训练。这允许使用简单的数据并行性有效地扩展跨节点的训练。

用于预训练和微调的 Cerebras 系统可通过Cerebras Model Studio在云中获得。Cerebras 模型动物园中提供 Cerebras CS-2 兼容检查点。

演示链接:https://lnkd.in/gr4sqB_w

𝗣𝘆𝘁𝗵𝗶𝗮

PythiaScaling Suite是一组为促进可解释性研究而开发的模型。它包含两组八个型号,尺寸分别为 70M、160M、410M、1B、1.4B、2.8B、6.9B 和 12B。对于每种尺寸,有两种模型:一种是在 Pile 上训练的,另一种是在对数据集进行全局去重后在 Pile 上训练的。所有 8 种模型尺寸都以完全相同的顺序在完全相同的数据上进行训练。我们还为每个模型提供154 个中间检查点,作为分支托管在 Hugging Face 上。

Pythia模型套件旨在促进大型语言模型的科学研究,特别是可解释性研究。尽管没有将下游性能作为设计目标,但我们发现这些模型的性能达到或超过了类似和相同尺寸模型的性能,例如 OPT 和GPT-Neo 套件中的模型。

演示链接:https://lnkd.in/gcE9qXkE

代码链接:https://lnkd.in/gRVJTVKv

𝗕𝗹𝗼𝗼𝗺 & 𝗺𝗧𝗢

BLOOMZ 和 mT0,这是一个模型系列,能够零样本地遵循数十种语言的人类指令的模型。我们在跨语言任务混合 (xP3) 上微调 BLOOM 和mT5 预训练的多语言语言模型,并发现生成的模型能够跨语言泛化到看不见的任务和语言。

演示链接:https://lnkd.in/gURNQjsC

𝗢𝗽𝗲𝗻𝗔𝘀𝘀𝗶𝘀𝘁𝗮𝗻𝘁

一种基于聊天的助手,可以理解任务,可以与第三方系统交互,并动态检索信息。演示使用了一个经过微调的30B LLaMA。

演示链接: https://lnkd.in/gu4GTtTD

𝗻𝗮𝗻𝗼𝗧𝟱

预训练和微调t5风格模型。

演示链接:https://lnkd.in/gf5rXKrn

𝗚𝗲𝗼𝗩

GeoV 模型由 Georges Harik 设计,并使用 由Georges Hark和Varuna Jayasiri设计的具有相对距离的旋转位置嵌入 (RoPER)。

RoPER除了在 RoPE 嵌入的注意力分数计算中使用相对位置外,还将相对位置信息显式添加到值嵌入中。具体来说,它包含了关注的令牌的相对位置。RoPER 在一些算法任务中给出了更好的性能,并且在语言建模方面似乎可以与 RoPE 相媲美。

GeoV分词器使用SentencePiece unigram语言模型,将符号、数字和换行符分别分词,以在数学内容和代码上取得更好的性能。

这个模型是由gharik和vpj贡献的。

代码链接:https://lnkd.in/gbsk8NeZ

研究使用(只能用于研究,不能用于商业)

—

𝗕𝗮𝗶𝘇𝗲

Baize 是一种使用LoRA训练的开源聊天模型。它使用让 ChatGPT 与自身聊天生成的 100k 对话。我们还使用 Alpaca 的数据来提高其性能。我们已经发布了 7B、13B 和 30B 型号。

演示链接:https://lnkd.in/g_npB3ut

代码链接:https://lnkd.in/ghCwWeg6

𝗩𝗶𝗰𝘂𝗻𝗮

一个开源聊天机器人,其性能几乎与谷歌的Bard和ChatGPT相同。

演示链接:https://chat.lmsys.org/

代码链接:https://lnkd.in/grTJA5G5

𝗞𝗼𝗮𝗹𝗮

Koala 是我们在LLaMA 之上微调的新聊天机器人。大型语言模型 (LLM) 变得简单,EasyLM 是用于在 JAX/Flax 中预训练、微调、评估和服务 LLM 的一站式解决方案。EasyLM 可以利用 JAX 的 pjit 功能将 LLM 训练扩展到数百个 TPU/GPU 加速器。

建立在 Hugginface 的转换器和数据集之上,这个 repo 提供了一个易于使用和易于定制的代码库,用于训练大型语言模型,而没有许多其他框架的复杂性。

EasyLM 是用 JAX/Flax 构建的。通过利用 JAX 的 pjit 实用程序,EasyLM能够通过跨多个加速器共享模型权重和训练数据来训练不适合单个加速器的大型模型。目前,EasyLM 支持单个主机上的多个 TPU/GPU 训练以及 Google Cloud TPU Pod 上的多主机训练。

演示链接:https://lnkd.in/gKWAgq58

代码链接:https://lnkd.in/g7Tm_MRq

𝗚𝗣𝗧𝟰𝗔𝗹𝗹

训练基于 LLaMa 的 ~800k GPT-3.5-Turbo 世代的助手式 LLM。

代码链接:https://lnkd.in/gB3gKBud

𝗟𝗶𝘁-𝗟𝗟𝗮𝗠𝗔

基于nanoGPT的LLaMA的独立实现。

代码链接:https://lnkd.in/gfA5rb4Z

𝗗𝗼𝗹𝗹𝘆 (𝗗𝗮𝘁𝗮𝗯𝗿𝗶𝗰𝗸𝘀)

Databricks 的Dolly是一种指令遵循大型语言模型,在已获得商业使用许可的 Databricks 机器学习平台上进行训练。基于pythia-12b,Dolly 接受了 databricks-dolly-15kDatabricks员工在 InstructGPT 论文的能力域中生成的约 15k指令/响应微调记录的训练,包括头脑风暴、分类、封闭 QA、生成、信息提取、开放 QA 和总结。dolly-v2-12b不是最先进的模型,但确实表现出令人惊讶的高质量指令遵循行为,而不是它所基于的基础模型的特征。

Databricks 致力于确保每个组织和个人都能从人工智能的变革力量中受益。Dolly 模型系列代表了我们在这一旅程中迈出的第一步,我们很高兴与全世界分享这项技术。

该模型作为databricks/dolly-v2-12b在 Hugging Face 上可用。

代码链接:https://lnkd.in/gw_b2jdf

𝗔𝗹𝗽𝗮𝗰𝗮.𝗰𝗽𝗽

在您的设备上本地运行类似 ChatGPT 的快速模型。

代码链接:https://lnkd.in/gDRzZWSc

𝗔𝗹𝗽𝗮𝗰𝗮-𝗟𝗼𝗥𝗔

与text-davinci-003 质量相似的指示模型,可在本地设备上运行。

演示链接: https://lnkd.in/gfh7FM7X

代码链接: https://lnkd.in/gZ5dKGKW

𝗹𝗹𝗮𝗺𝗮.𝗰𝗽𝗽

在纯C/C++中推断LLaMA模型,支持LLaMA,Alpaca,GPT4All和Vicuna

代码链接: https://lnkd.in/gkZ8XaJJ

𝗖𝗼𝗹𝗼𝘀𝘀𝗮𝗹𝗖𝗵𝗮𝘁

LLM由Colossal-AI驱动的RLHF训练

代码链接: https://lnkd.in/gTezhGXD

补充:Dolly和Lit-LLaMA仅被允许用于研究用途。

想要了解更多,欢迎入群交流!

权益福利:

1、AI 行业、生态和政策等前沿资讯解析;

2、最新 AI 技术包括大模型的技术前沿、工程实践和应用落地交流(社群邀请人数已达上限,可先加小编微信:15937102830)

关于MoPaaS魔泊云

源于硅谷、扎根中国,上海殷泊信息科技有限公司(MoPaaS)是中国领先的人工智能(AI)平台和服务提供商,为用户的数字转型、智能升级和融合创新直接赋能。针对中国AI应用和工程市场的需求,基于自主的智能 PaaS 云平台专利技术,MoPaaS 在业界率先推出开放的AI平台为加速客户AI应用项目落地提供高效的GPU算力优化和模型开发运维 (ModelOps) 能力和服务。MoPaaS AI平台已经服务在教学科研、工业制造、能源交通、互联网、医疗卫生、政府和金融等行业超过300家国内外满意的客户的AI技术研发、人才培养和应用落地工程需求。MoPaaS 致力打造全方位开放的AI技术和应用生态圈。MoPaaS 被Forrester评为中国企业级云平台市场的卓越表现者(Strong Performer)。

END

▼ 往期精选 ▼

1、Ilya Sutskever(OpenAI 首席科学家)谈论构建 AGI、alignment、未来模型和启蒙等问题

4、分布式人工智能框架 Ray 如何帮助 OpenAI 驱动 ChatGPT

▼点击下方“阅读原文”,查看文章来源!

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง