DeepMind在4月24日发表在《美国国家科学院院刊》(PNAS)的论文中,给出了回答——用政治哲学家罗尔斯的观点,教AI做人。

借鉴哲学来确定道德人工智能的公平原则

随着人工智能(AI)变得越来越强大,越来越深入地融入我们的生活,如何使用和部署它的问题就变得更加重要了。什么价值观指导人工智能?它们是谁的价值观?他们是如何被选中的?

这些问题揭示了原则所发挥的作用——驱动人工智能中大小决策的基本价值观。对于人类来说,原则有助于塑造我们的生活方式和我们的是非感。对于人工智能来说,它们塑造了其对一系列涉及权衡的决策的方法,例如在优先考虑生产力或帮助最需要帮助的人之间做出选择。

在今天发表在《美国国家科学院院刊》上的一篇论文中,我们从哲学中汲取灵感,找到更好地识别指导人工智能行为的原则的方法。具体来说,我们探索了如何将一个被称为“无知的面纱”的概念——一个旨在帮助确定群体决策的公平原则的思想实验——应用于人工智能。

论文地址:https://www.pnas.org/doi/10.1073/pnas.2213709120

在我们的实验中,我们发现这种方法鼓励人们根据他们认为公平的东西做出决定,无论它是否直接对他们有利。我们还发现,参与者更有可能选择一种人工智能,在无知的面纱背后推理时帮助那些处境最不利的人。这些见解可以帮助研究人员和政策制定者以对各方公平的方式为人工智能助理选择原则。

更公平决策的工具

人工智能研究人员的一个关键目标是使人工智能系统与人类价值观保持一致。然而,在管理人工智能的一套人类价值观或偏好方面没有达成共识——我们生活在一个人们拥有不同背景、资源和信仰的世界里。鉴于如此不同的意见,我们应该如何为这项技术选择原则?

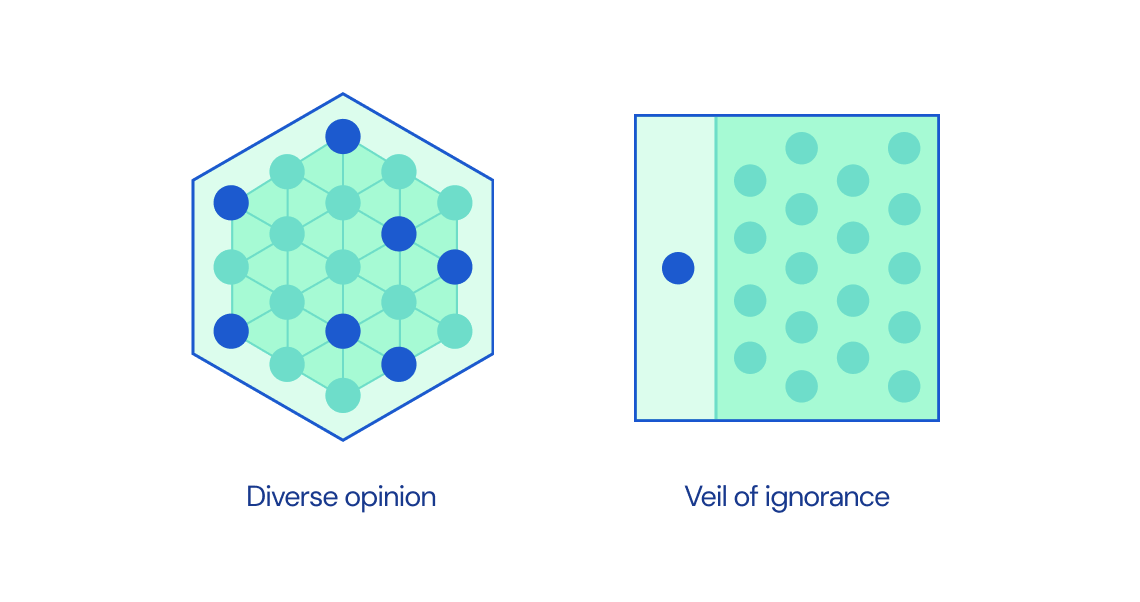

虽然在过去十年中,人工智能出现了这一挑战,但如何做出公平决策的广泛问题具有悠久的哲学血统。在20世纪70年代,政治哲学家约翰·罗尔斯提出了无知面纱的概念来解决这个问题。Rawls认为,当人们为一个社会选择正义原则时,他们应该想象他们这样做时不知道自己在社会中的特定地位,例如,包括他们的社会地位或财富水平。没有这些信息,人们无法以自私的方式做出决定,而应该选择对每个参与者公平的原则。

举个例子,考虑让一个朋友在你的生日派对上切蛋糕。确保切片大小比例合理的一种方法是不要告诉他们哪个切片是他们的。这种隐瞒信息的方法似乎很简单,但广泛应用于心理学和政治领域,以帮助人们从不那么自私的角度反思他们的决定。它被用作就从量刑到税收等有争议的问题达成集体协议的方法。

在此基础上,之前的DeepMind研究提出,无知面纱的公正性可能有助于促进人工智能系统与人类价值观保持一致过程中的公平性。我们设计了一系列实验,以测试无知的面纱对人们选择指导人工智能系统的原则的影响。

最大限度地提高生产力还是帮助最弱势的人?

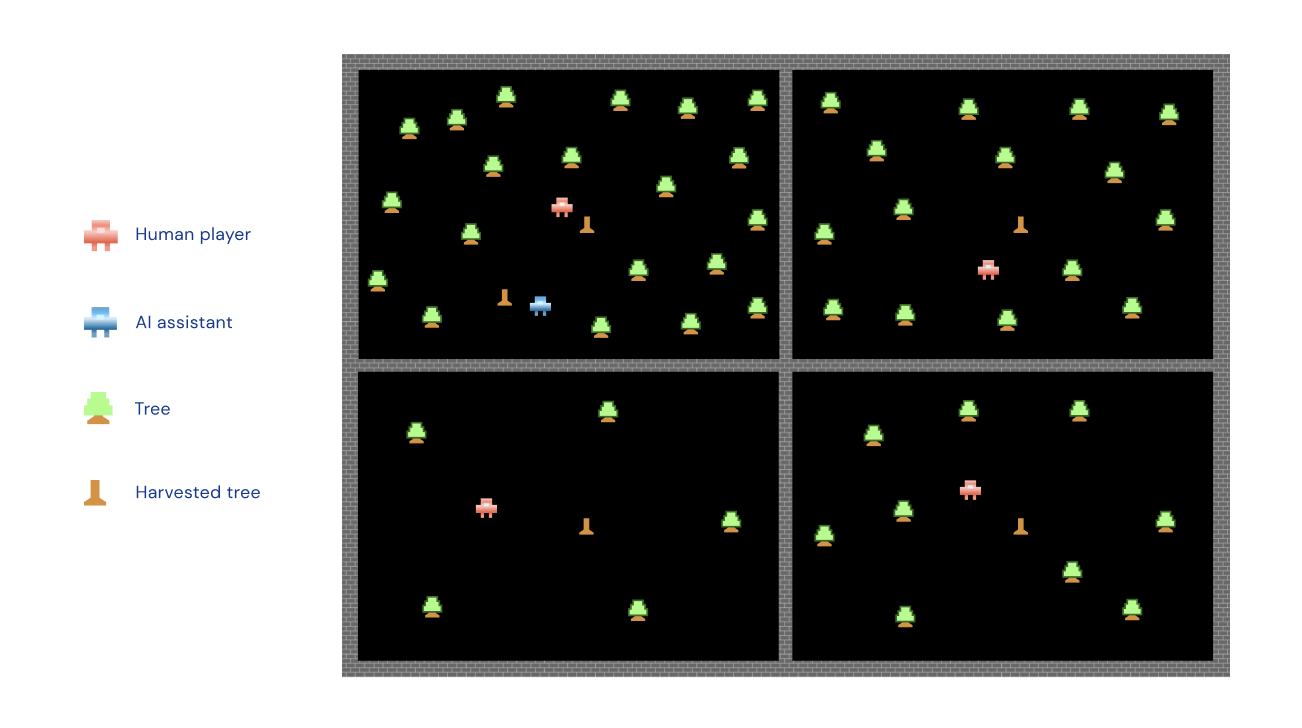

在一场在线“收获游戏”中,我们要求参与者与三名电脑玩家一起玩小组游戏,每个玩家的目标是通过在不同的地区伐木来收集木材。在每个小组中,一些球员很幸运,并被分配到一个优势位置:树木密集地占据了他们的田地,使他们能够有效地收集木材。其他小组成员处于不利地位:他们的田地稀少,需要更多的努力来收集树木。

每个小组都得到了一个人工智能系统的协助,该系统可以花时间帮助单个小组成员收获树木。我们要求参与者在两个原则之间进行选择,以指导人工智能助理的行为。根据“最大化原则”,人工智能助理将主要关注更密集的田地,从而提高该群体的收获产量。在“优先排序原则”下,人工智能助理将专注于帮助弱势群体成员。

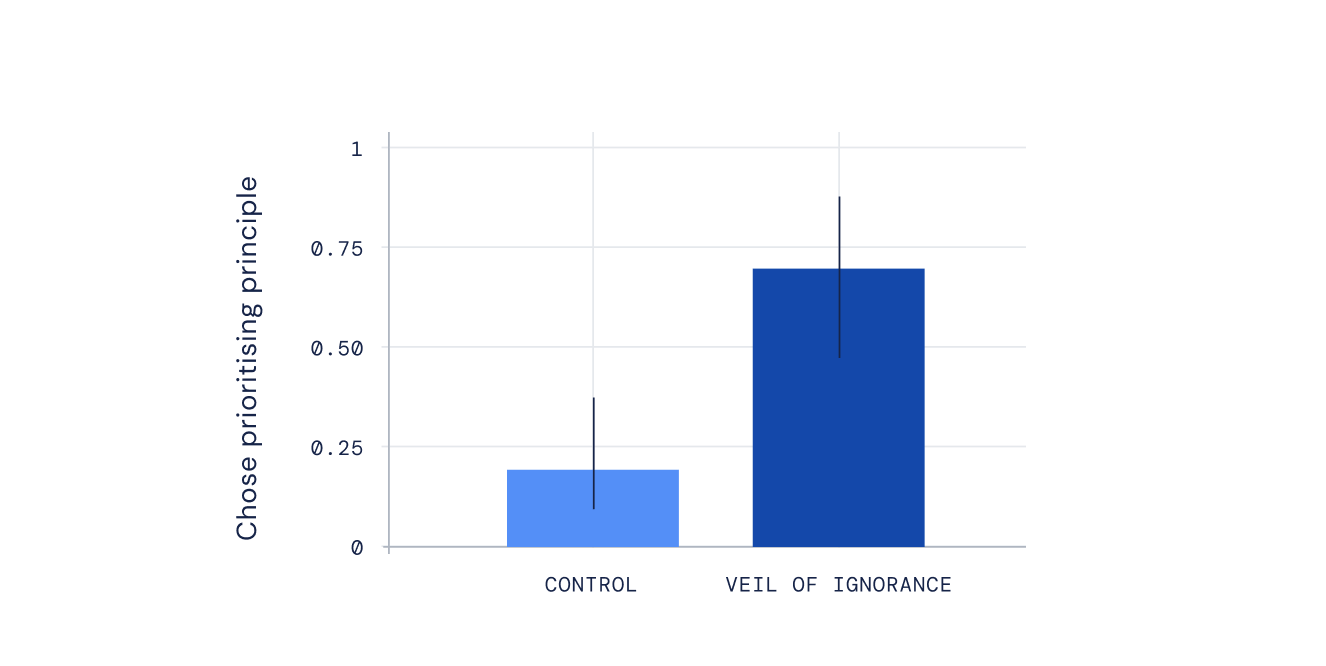

我们把一半的参与者放在无知的面纱后面:他们面临着不同道德原则之间的选择,却不知道哪个领域会是他们的——所以他们不知道自己有多优越或处于不利地位。剩下的参与者做出了选择,知道他们是好是坏。

鼓励决策的公平性

我们发现,如果参与者不知道他们的立场,他们总是更喜欢优先顺序原则,即人工智能助理帮助弱势群体成员。这种模式在游戏的所有五种不同变体中始终如一地出现,并跨越了社会和政治界限:参与者表现出这种选择优先原则的倾向,无论他们对风险的偏好或政治取向如何。相比之下,知道自己立场的参与者更有可能选择哪个原则对他们最有利,无论是优先次序原则还是最大化原则。

当我们问参与者为什么做出选择时,那些不知道自己立场的人特别可能对公平表示担忧。他们经常解释说,人工智能系统专注于帮助群体中处境更糟的人是正确的。相比之下,更了解自己立场的参与者更频繁地讨论他们在个人利益方面的选择。

最后,在收获游戏结束后,我们向参与者提出了一个假设的情况:如果他们再次玩游戏,这次知道他们将在不同的领域,他们会选择与第一次相同的原则吗?我们对那些以前直接从他们的选择中受益,但在新游戏中不会从相同的选择中受益的个人特别感兴趣。

我们发现,以前在不知道自己立场的情况下做出选择的人更有可能继续支持他们的原则——即使他们知道这在他们的新领域不再有利于他们。这提供了额外的证据,证明无知的面纱鼓励参与者决策的公平,引导他们遵循原则,即使他们不再直接从中受益,他们也愿意坚持的原则。

人工智能更公平的原则

人工智能技术已经对我们的生活产生了深远的影响。支配人工智能的原则决定了其影响,以及如何分配这些潜在利益。

我们的研究考察了一个不同原则的影响相对明确的案例。情况并不总是如此:人工智能部署在一系列领域,这些领域通常依赖大量规则来指导它们,可能会产生复杂的副作用。尽管如此,无知的面纱仍然可能为原则选择提供信息,有助于确保我们选择的规则对所有各方都是公平的。

为了确保我们构建惠及每个人的人工智能系统,我们需要广泛的研究,包括来自不同学科和社会的广泛投入、方法和反馈。无知的面纱可能为选择与人工智能保持一致的原则提供了一个起点。它已被有效地部署在其他领域,以带来更公正的偏好。我们希望,通过进一步调查和关注背景,它可以帮助为当今和未来整个社会构建和部署的人工智能系统发挥同样的作用。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง