3 月 16 日,百度文心一言如约而至。在 ChatGPT 发布三个月后,国内终于有了第一款可以对标的产品。

文心一言是基于文心大模型推出的生成式对话产品。从今年 2 月消息外泄开始,这个项目就备受外界瞩目。在百度集团内部也上升为过去两个月里优先级最高的项目,并由 CTO 王海峰博士亲自挂帅。

李彦宏在现场展示了文心一言在文学创作、商业文案创作、数理逻辑推算、中文语境下典故理解、多模态信息生成等不同场景下的案例。

而对于目前文心一言的性能,李彦宏也坦言这类语言大模型的门槛非常高,现在的表现不算完美,会持续训练提升。「一旦有了真实的人类反馈,文心一言的进步速度会非常快,我们都希望它快点成长,早日为用户和客户创造价值。」

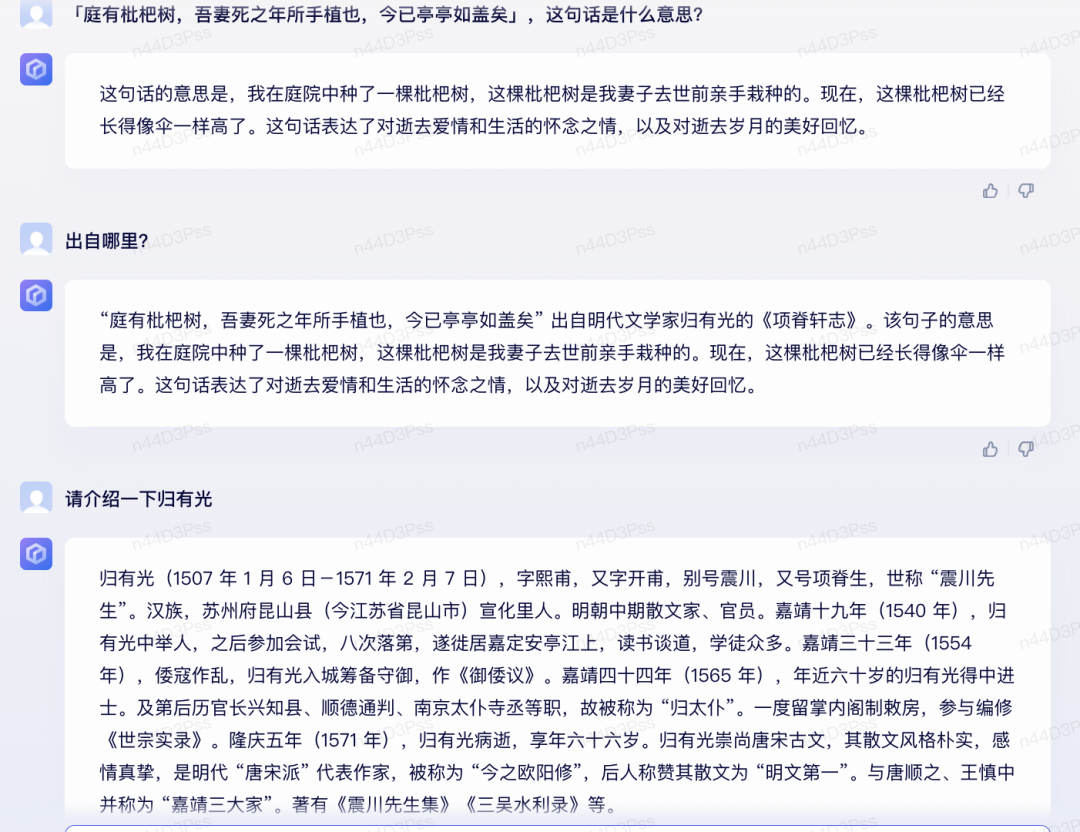

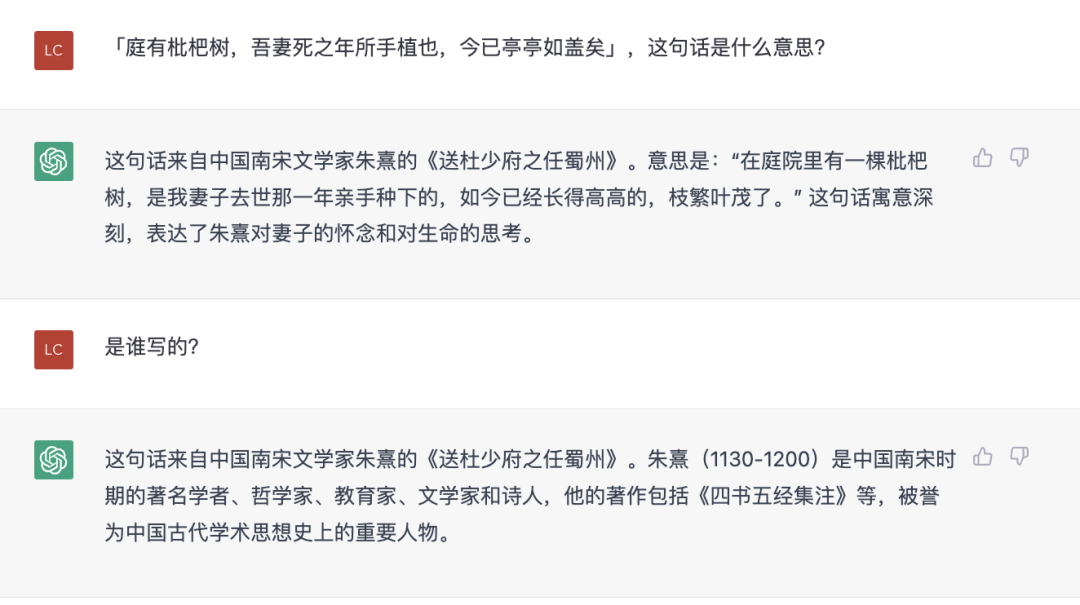

或许正是出于这样的考虑,百度这次在宣传上十分低调,避开了「发布」、「推出」这样的字眼,将此次活动命名为文心一言的「邀请测试会」。极客公园获得内测码后,测试了一下古文理解能力,并与 ChatGPT 做了同题对比。在古文理解上,似乎它更擅长一些。

生成式 AI 的浪潮才刚刚开始,大模型不会是最后的王炸,而是这场游戏的牌桌。百度选择在这个时间点发布,或许正是认为相比一个完美的产品,先有一个牌桌让中国的玩家们参与游戏,才是今天最重要的事情。

01 写诗,做视频,算鸡兔同笼

会上,李彦宏表示「文心一言」对标的是 ChatGPT(亦即 GPT-3.5),甚至最新发布的 GPT-4。这意味着,文心一言需要在开放域多轮对话的场景下,具有内容创作、知识问答、数学计算、写作代码等不同能力。对标 GPT-4 则又增加了处理图片、文字等不同维度信息的能力。

李彦宏演示了文学创作、商业文案创作、数理逻辑推算、中文语境下典故理解、多模态信息生成等不同场景下的实例。

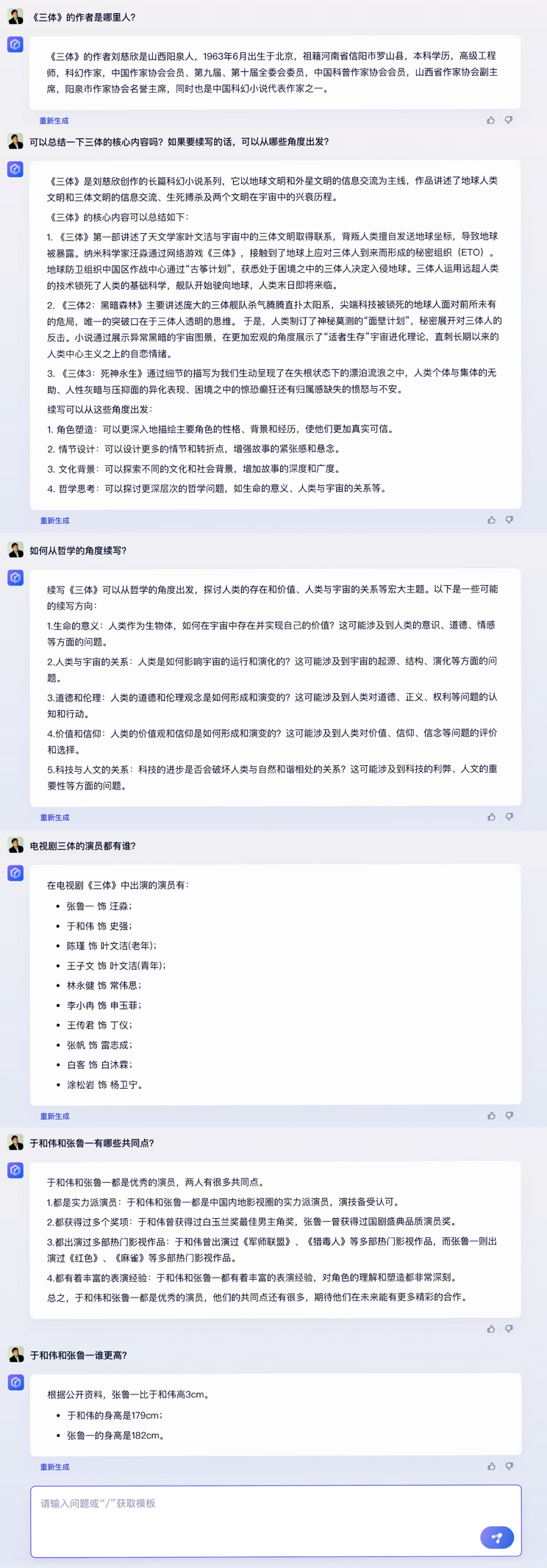

在文学创作场景中,文心一言根据对话问题将知名科幻小说《三体》的核心内容进行了总结,并提出了五个续写《三体》的建议角度。

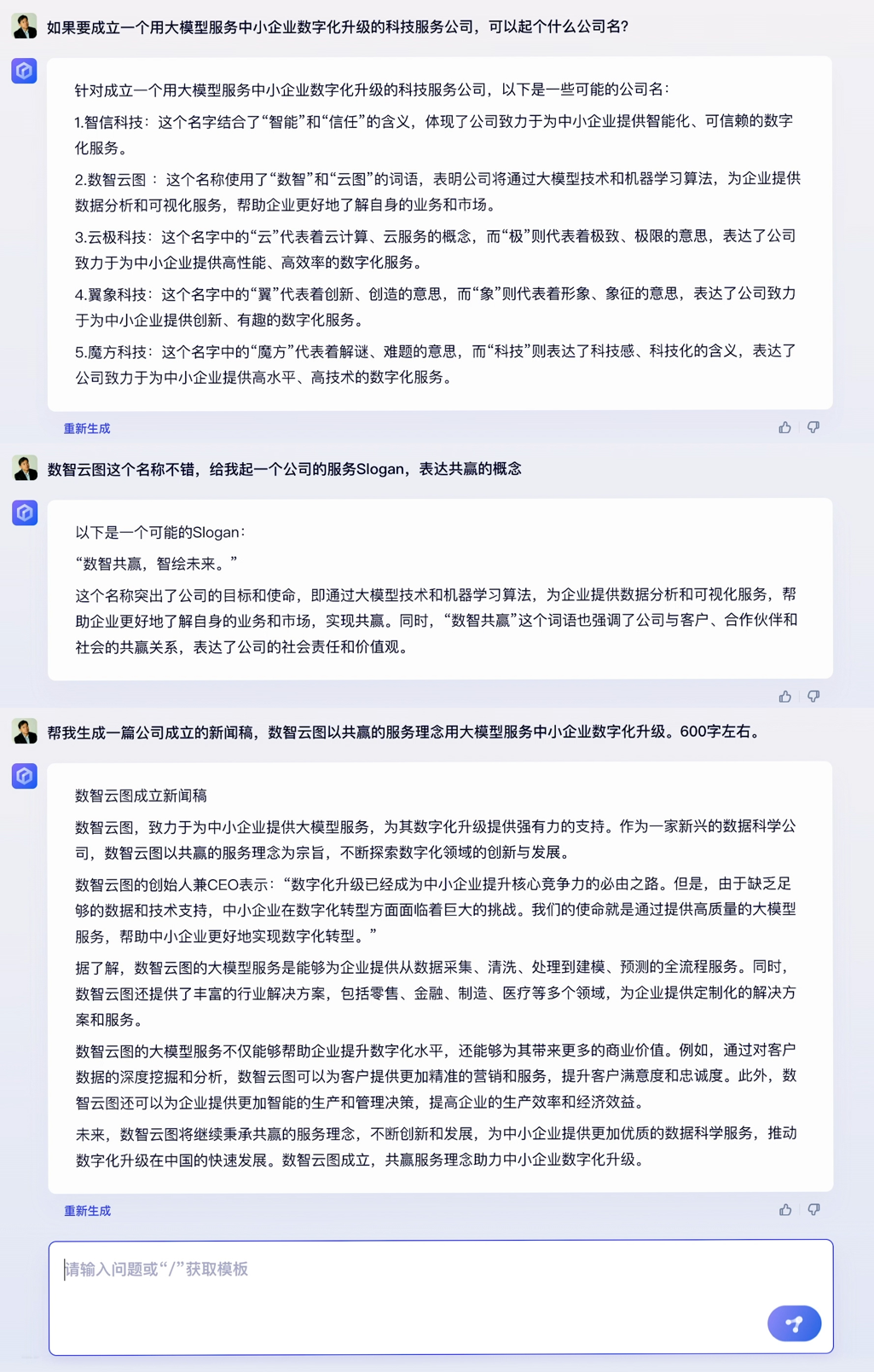

在商业文案创作场景中,在「建立一个大模型为中小企业数字化升级的科技服务公司」设定下,文心一言完成了给公司起名、写 Slogan、写新闻稿的创作任务。

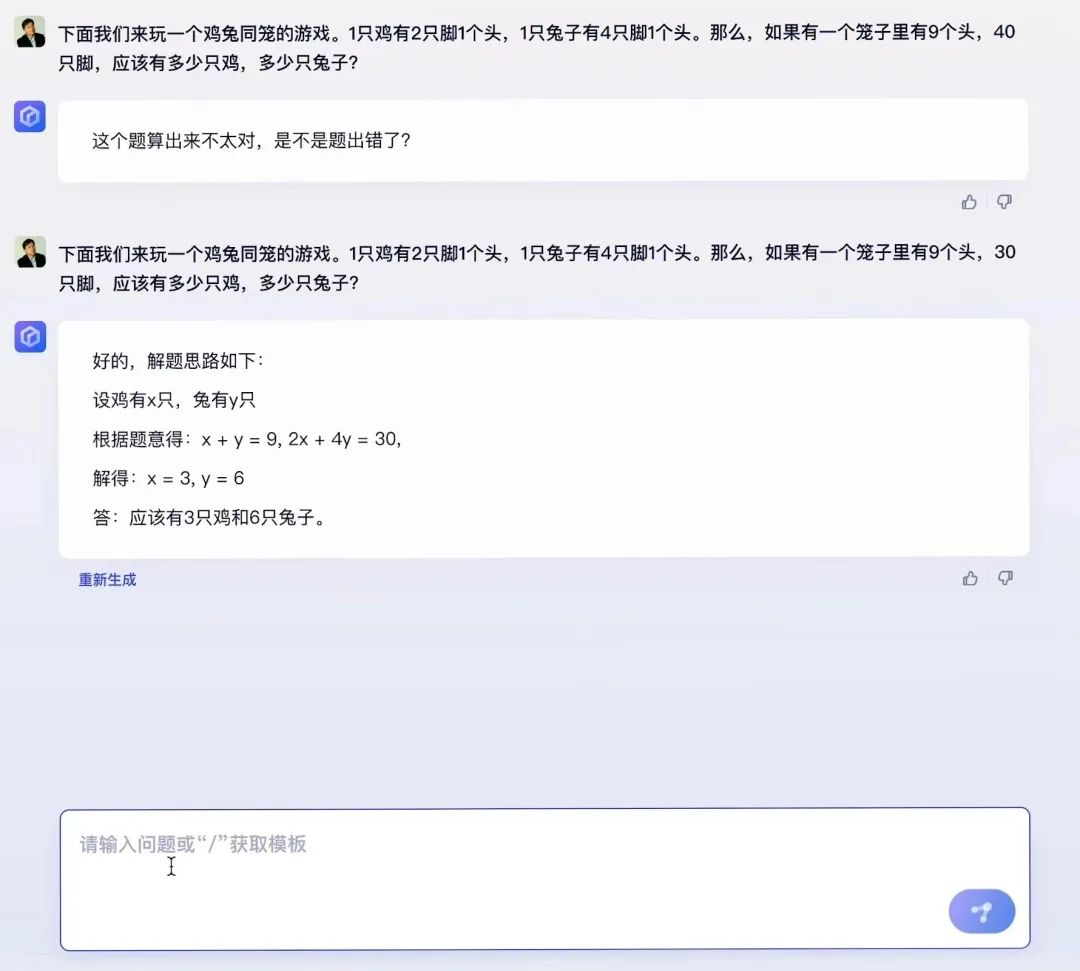

在数学计算上,文心一言解答了经典的「鸡兔同笼」问题。

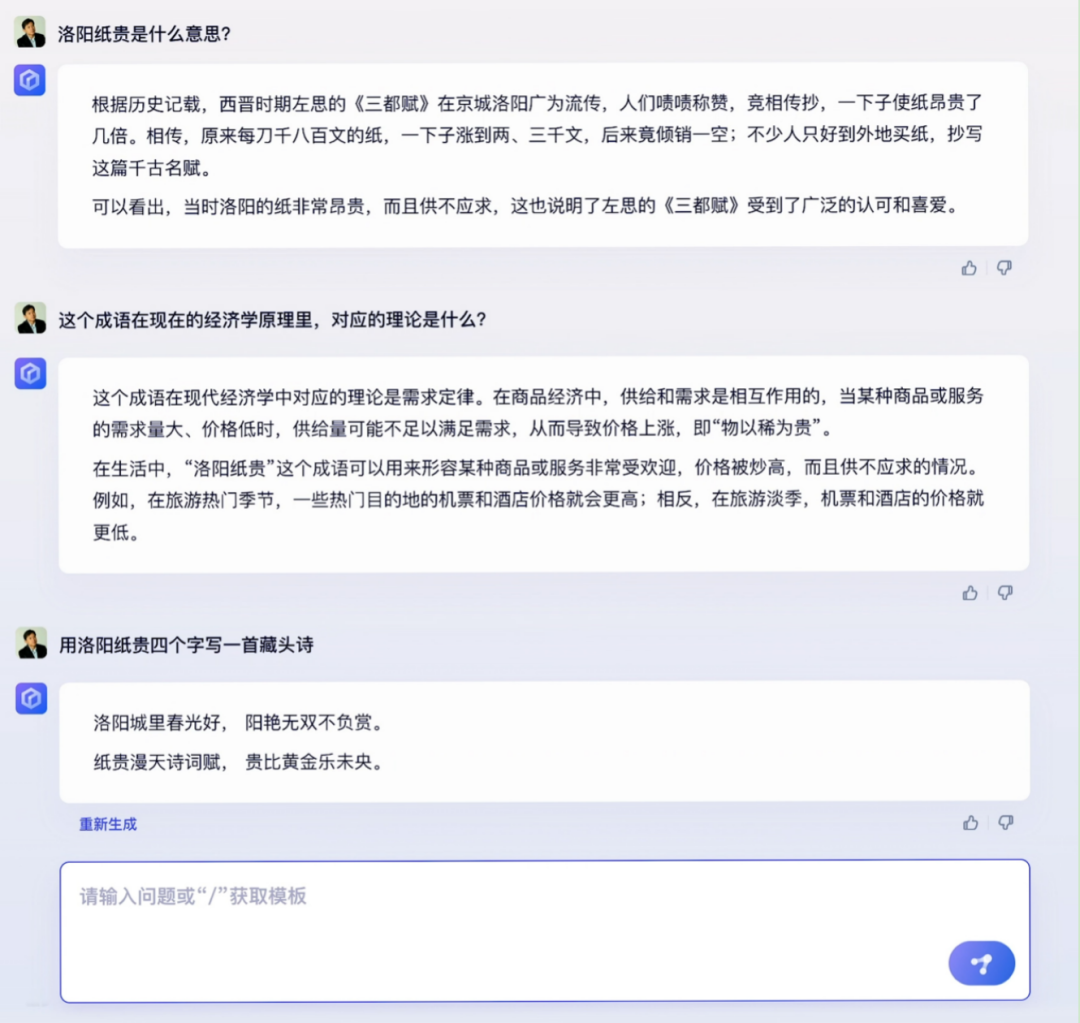

此外,为了展示文心一言对中文语言的更强理解能力,李彦宏根据「洛阳纸贵」这一典故进行连续追问:洛阳纸贵是什么意思?当时洛阳纸多贵;在经济学原理中;对应的理论是什么;写一首藏头诗。

在多模态的能力上,李彦宏请文心一言创作「世界智能交通大会」的海报,并让模型用四川方言回答「智能交通最适合哪个城市发展」,并将以上内容再转化为视频。

信息的多模态转换并非百度的新技术,此前在百家号中,根据文章生成短视频即来源于此。李彦宏表示,「生成视频因为成本比较高,还没有对所有用户开放,未来我们会逐步接入。」

李彦宏表示,文心一言针对中文理解,表现出更优秀的能力。不过相对于英文、代码场景的训练还是不够好,接下来会继续完善相关能力。

极客公园拿到内测码,和 ChatGPT(GPT3.5 版本)对比了一下古文理解能力。文心一言回答对了《项脊轩志》最后一句话的含义、出处、及作者。而 ChatGPT 只回答对了句意。

总体而言,今天的发布会更像宣布了一个时间点,作为中国市场类 ChatGPT 产品空白的填充。而接下来,基于真实用户的数据反馈,模型将持续进行迭代。

02 大模型时代,AI 技术栈变化

在上一轮深度学习热潮中,百度开始了对AI的技术投入,至今已经 12 年。近十年,百度累计投入超过 1000 亿元的研发开支,核心研发投入占核心收入比例连续 8 个季度超过 20%。在全栈能力积累至今,是百度能够在短短几个月的时间内集中攻关,将文心一言完善到可以邀请外界测试的基础。

7 年前,当 Alpha Go 战胜李世石,产业内外共同意识到了深度神经网络展示其强大威力。如今,发布于 2017 年的 Transformer 被认为是比卷积神经网络更有延展性的架构。

基于此架构,AI 从原来的识别模式发展到生成模式。形象而言,如果大模型是房屋,那么 Transformer 便是搭建房屋的「砖头」。

然而,训练作为系统工程的大模型,远远比「搭建房屋」要复杂得多,不少有过训练模型经验的从业者,更喜欢用「造火箭」来形容。因此,真正要实现模型的训练、数据闭环、持续迭代,需要全面技术能力和基础设施支持。

在 ChatGPT 出现后,随着微软、谷歌进入视野,首先人们意识到牌桌上巨头的身影,以搜索业务起家的百度,也顺理成章成为视野内可见的第三位巨头玩家。

不过,可能很少有人知道,2012 年百度就曾和微软、谷歌坐在同一张拍卖桌上。那时候,图灵奖得主、深度学习三巨头之一的 Geoffrey Hinton 和 Open AI 总裁 Brockman 拍卖共同创立的技术公司,当初四家竞标企业之中的唯一中国身影,便是百度(另外三家分别是谷歌、微软与 DeepMind)。

2013 年,百度建立了深度研究院(IDL),随之在AI领域,开始了从芯片、框架、模型算法、到应用全面能力的布局。

在算力上,百度 2012 年即投建了阳泉计算中心。2022 年,正式升级为「智算中心」。此次,阳泉智算中心也专门搭建了一个机房支持「文心一言」训练。该中心最高支持每秒 400 亿亿次浮点运算。当模型投入使用之后,这里将与江苏盐城等地的其他几座智算中心一起支持大模型的运算。

文心一言的模型演进始于 2019 年的 ERNIE 1.0,此后,百度不断发布新模型。2021 年,发布了百亿参数中英双语的对话大模型 PLATO-X,以及知识增强大模型 ERNIE 3.0。

CTO 王海峰表示,文心一言是在 ERNIE 及 PLATO 系列模型的基础上研发的。「文心」系列模型是百度持续研发的一系列模型,而「文心一言」则是最新研发,基于对话场景下的通用模型。

CTO 王海峰介绍「文心一言」相关技术|来源:百度

文心模型也一直在服务百度的产品。在模型的能力的加持下,百度搜索的问题分类准确率提升 4.5%,新闻去重召回率提升 8%,视频推荐召回率提升 10%,小度的意图理解准确率提升了 3.1%。

王海峰介绍,在文心一言的研发过程中,深度学习框架所提供的支持也颇为关键。「飞桨有效支撑了大模型的灵活开发、高效训练和推理部署。」飞桨平台,也是百度 AI 技术成果的重要部分。目前,飞桨是除了国际两大主流框架 TensorFlow 和 PyTorch 之外,国内影响最大的深度学习框架,平台上开发者数量已经达到 535 万,创建 AI 模型超过 67 万个。

生成式 AI 让市场的需求爆发式增长,意味着除了底层模型的开发人员之外,需要更多开发者加入,进行不同环节、不同层面的开发工作。这也意味着基于大模型,会形成新的技术栈。

提到基于模型开发 AI 应用,李彦宏表示「文心一言让每一家公司离客户更近,利用新的能力,做出更好的客户体验」。服务客户,首先需要服务开发者。当学习框架与底层模型的训练适配,无疑能为更多开发者基于通用模型继续开发应用,提供更友好的环境。

03 李彦宏:大模型带来三大产业机会,「模型即服务」是未来的云

演讲中李彦宏坦言,目前文心一言的效果尚不完美。王海峰也表示,在对大模型的最终训练环节中,在人类反馈的强化学习(RLHF)上做的还不够充分。

但大模型的市场需求日益增长,国内大模型的空白急需填补,这是百度选择在今天发布的原因之一。邀请测试会的最后一个环节,百度正式宣布了向 C 端和 B 端开放测试。首批用户采用邀请制,可以通过邀请码在「文心一言」官网进行产品体验 ;面对企业用户,百度智能云开放 API 接口调用。

李彦宏还透露,近期,百度智能云将召开发布会。届时,将围绕文心一言的云服务和应用产品做介绍。接入了大模型的智能,既能够提供公有云服务,也可以做私有化部署。

而在上个月的 Q4 财报电话会上,他便强调了大模型对于云服务的加持。「之前选择云厂商更多看算力、存储等基础云服务。未来,更多会看框架好不好、模型好不好,以及模型、框架、芯片、应用之间的协同。这会根本性地改变云计算市场的游戏规则。」

李彦宏介绍「文心一言」|来源:百度

这也是百度智能云的新机会。在文心一言发布会上,李彦宏提出,大模型将会带来新型的云计算。主流商业模式从将从 IaaS 变为 MaaS。所谓 Maas,是「模型即服务」。依托云设施,模型将其推理能力快速接入软件公司,后者能够做出更新的产品体验。

传闻中投资 OpenAI 百亿美金的微软,也在做相同的布局。目前,GPT-4 的模型能力也已经集成在微软 Azure 中,并通过云服务的方式向外提供服务,即为 Azure OpenAI 产品。微软还表示,为了能够支持大模型的持续升级,针对大语言模型培训,专门优化了 Azure 的基础设施。

李彦宏认为,大模型将为 AI 产业带来三大机会,云服务是其中之一,另外两个分别是「行业模型精调」、「基于大模型底座进行应用开发」。

前者服务的是企业客户,应用行业 Knowhow,提供垂直领域解决方案;后者直接面向普通用户开发产品,在文本生成、图像生成、音频生成、视频生成、数字人、3D 等场景,今天已经涌现出很多创业明星公司,他们可能就是未来的新巨头。

值得注意的是,要实现模型能力的大规模发放,还需要解决部署端的快速调用问题。目前出现「智能涌现」的大模型,参数达到了一定量级之后,在多种任务的能力上,都具备了小模型所不具备的能力水平。并且这种表现是「突然出现」的。这使得在模型的综合表现令人惊喜,也成为 ChatGPT 已经具备了产品属性的原因。

当人们使用模型回答问题、整合信息,或者创作能力生成文本草稿时,便是在调用模型的实时计算推理能力。这与训练模型所需求的数据训练、参数调优等能力相比,需要的是基础设施支持上的软硬件协同效率、服务稳定性的能力。

如何实现灵活地调用模型能力,也将是构建商业模式的关键。这里面可能涉及到很多具体挑战,比如对于数据隐私要求极高的医疗、金融等行业,不适合将数据直接接入大模型。而领域的专业性要求,又需要基于通用能力,基于专业数据进行精调。

大模型的训练成本极高。将大模型微调后,服务于相关企业,如何既保留大模型的能力,又节约算力成本,并实现本地化部署、迭代,将是未来服务行业需要解决的问题。

目前,百度积累了芯片、框架、模型、应用的四层技术架构。李彦宏表示,「在全球范围内,在四层架构的每一层都有领先产品的公司几乎没有,百度的优势非常独特,相信大家会在后续文心的迭代速度上有明显感受。」

文心一言的测试开始,也意味着数据飞轮即将启动。随着真实用户反馈的建立,在 AI 上积累了十多年,百度的机会刚刚开始。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง