在今年六月初,苹果发布了MR头显Apple Vision Pro,向我们展示了一种相对新颖的交互方式,实现了眼动追踪和手势追踪这两种交互方式的结合。那么,如何理解这种交互方式及背后的发展?这篇文章里,作者就对近十年的眼手协同交互研究进行了分析总结,一起来看。

一、visionOS 眼手协同交互

Apple Vision Pro 展示了一种「半全新」的交互方式:以眼睛注视点👀(Gzae)作为交互方位引导,通过简单的捏合🤏🏻(Pinch)、拖动✊🏻(Drag)手势触发交互指令。

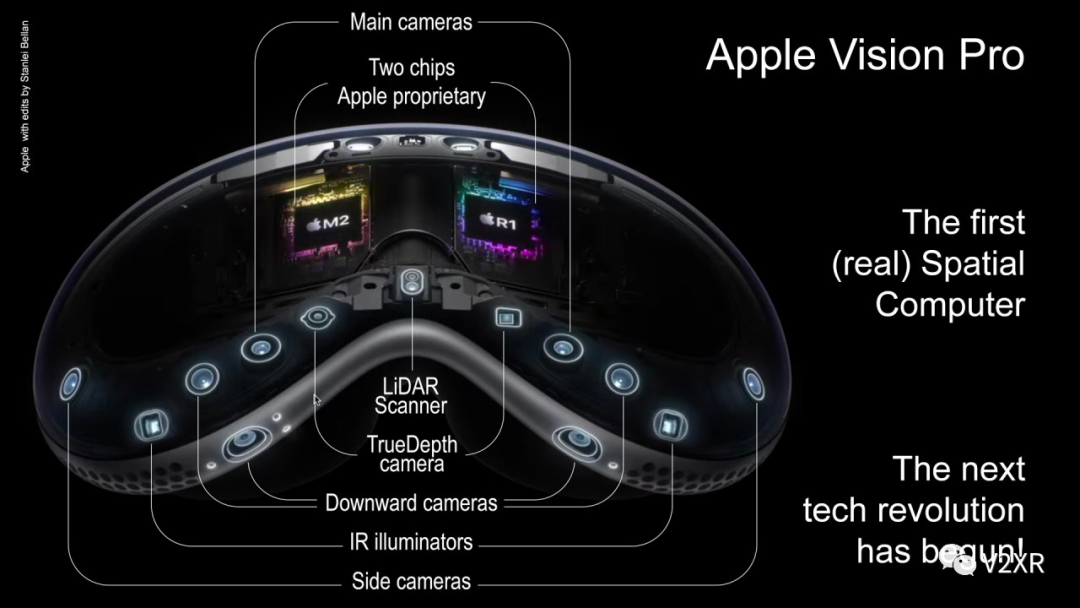

眼动追踪(Eye-Tracking)和手势追踪(Hand-Tracking)在很多其它消费级头戴显示设备上都有应用,例如 Hololens 2 、 PSVR 2 和 Meta Quest Pro 等,苹果的「微创新」在于将两种交互方式结合起来,并依靠其强大的运算能力实现更高的追踪精度和更大的识别范围。

微软 HoloLens 2 手势交互

Meta Quest 手势直接 & 间接交互

在 VR/AR 场景下的人机交互领域,也有大量关于眼动、语音、手势、触觉甚至是味觉嗅觉等交互方式的研究,丹麦Aarhus University 的 Ken Pfeuffer从 2014 年开始,持续开展了近十年的眼手协同(Eye-Hand Symbiosis)人机交互研究,从最开始的触屏平板眼手交互一直到后来 VR/AR 场景下的眼手协同,早在 2017 年开始就开展了一系列关于 Gaze + Pinch 的交互研究。

以下是对其近十年眼手协同交互研究的总结,共包含 10 篇学术论文和 1 篇博士毕业论文。

二、近十年眼手协同交互研究总结

不论是在现实世界中使用纸笔这样的工具,还是在电脑或手机平板上通过鼠标/触控屏进行交互,手和眼睛的协调可以完成大多数工作。

为了系统地分类这些交互方式,作者借鉴了人机交互领域中的一个理论和设计方法——工具式交互(Instrumental Interaction)。其核心思想是:交互设计应关注如何助力用户完成任务,而不仅仅追求改善用户体验;设计者首先应了解用户想完成的任务,然后设计出一系列相互衔接的交互步骤,从而使系统成为用户有效完成工作的工具。

这一理论从时间和空间维度上的间接性程度(degree of indirection)对不同的交互方式进行分类,这里的间接性程度可以定义为完成某项交互任务在时间或空间上所需的偏移/距离。

- 鼠标与电脑进行交互时,在空间上手和电脑窗口的交互是间接的(需要从真实桌面的 2D 空间转换到电脑屏幕的垂直 2D 空间),在时间上鼠标交互也是间接的,并不是说鼠标指针存在采样延迟(主流鼠标的系统性延迟基本在 10ms 量级),而是指通过鼠标完成交互时,在时间上多了一个先把鼠标指针拖动到目标物体上的步骤。

- 手机或平板的触摸屏交互,就是一种在时间和空间上的直接交互(direct interaction),不存在时间和空间上的中间步骤。

值得注意的是,直接交互并非总是优于间接交互,这取决于任务类型和具体的交互设计。例如有研究发现,在平板上完成简单的指向任务时,鼠标指针操作比直接触屏操作效率更高。这也体现在 iPad 的鼠标交互设计上:在有限的屏幕尺寸和图标大小情况下,配合扩大的不可见交互区域和自动吸附效果,鼠标可以实现比手指更精确的点选操作。

However, our results also indicate that mouse input may be more appropriate for a single user working on tabletop tasks requiring only single-point interaction. (Forlines 等,2020)

回到眼手协同的交互类型上来,作者依据空间、时间上交互的间接性将以下交互方式进行了系统性归类:

Apple Vision Pro 的眼手交互形式在时间上是直接的,这有别于常见的 VR 手势射线交互,用户无需把手移动到目标对象上,可以在任意位置直接点选;但是在空间上用户的手和目标物体在空间上仍然存在一定偏移。

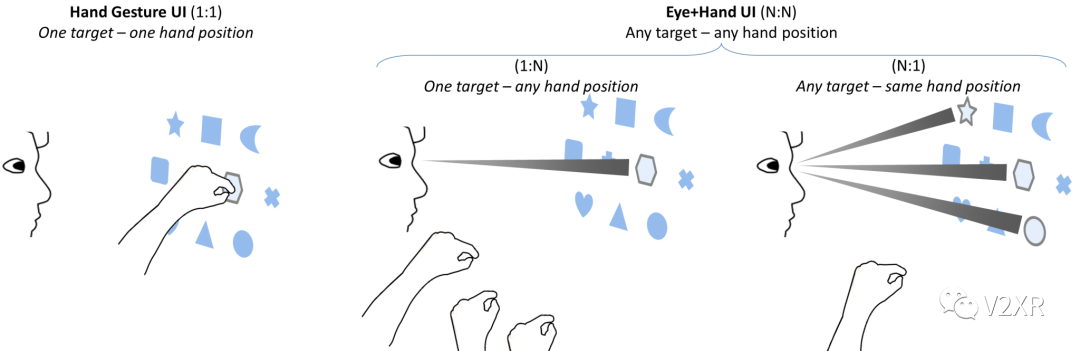

在直接交互中,目标与手眼是 1:1 的关系,而间接交互中,目标与手眼可能是 N:N 的关系。

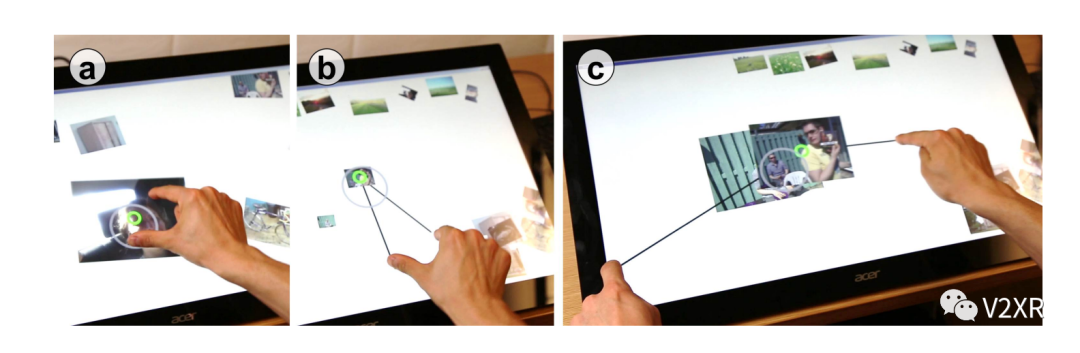

作者在 2014 年的研究中探索了基于平板触摸屏和眼动追踪的 Gaze + Touch 交互,这种交互设计已经非常接近 Apple Vision Pro 的设计,只是手的追踪是通过触屏而非头显。

a) 直接操作图片;b) 注视选择+任意区域触屏操作;c)更精细的双手操作

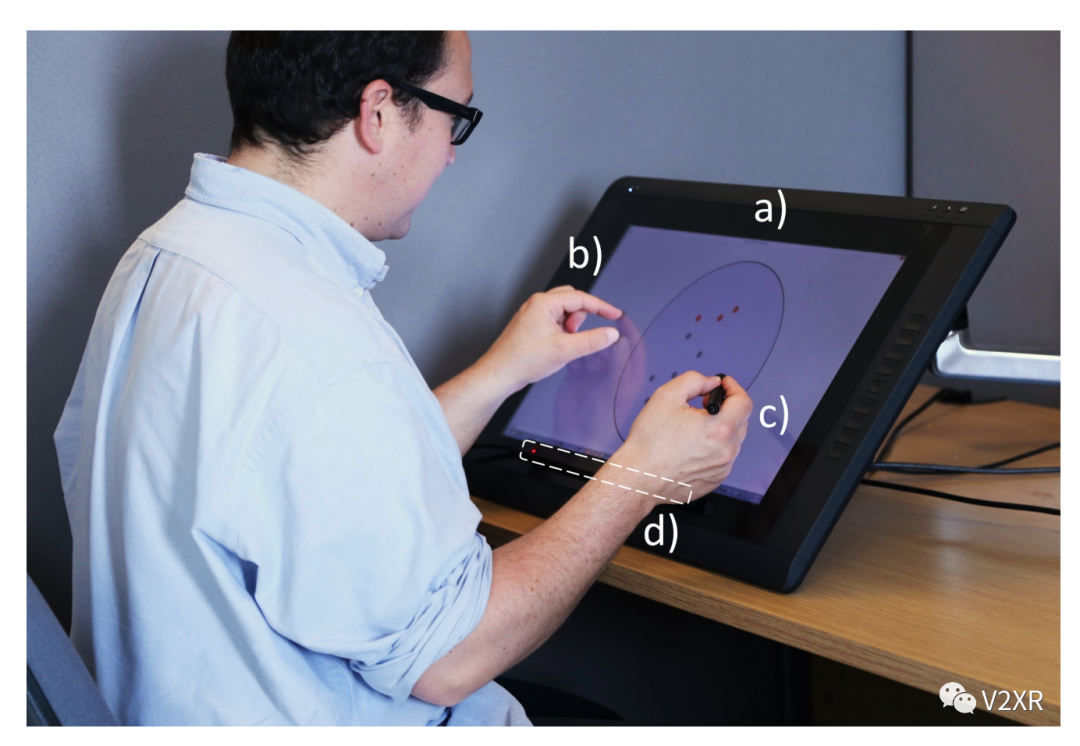

后续研究中,作者将手写笔与手势交互结合,通过手指实现内容缩放,手写笔进行更精细操作。这也是对于面向生产力场景非常重要的交互问题,首先用户需要在不同的交互对象之间高频切换,其次对整个操作空间的缩放、拖动等操作需要与目标对象进行有效区分。

实验设备演示:d)眼动追踪

Apple Vision Pro 简单演示了通过手势的捏和进行简单的绘画操作,看起来并不适合复杂操作。

Apple Vision Pro 绘画应用演示

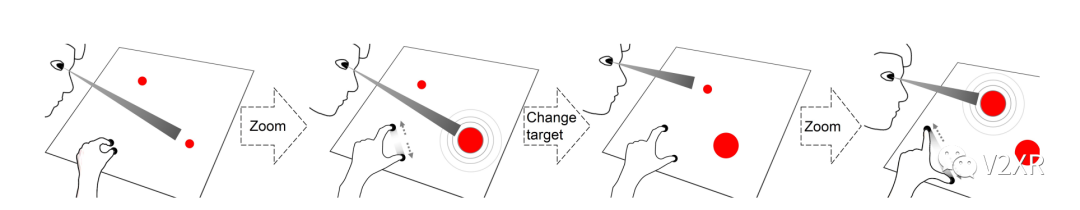

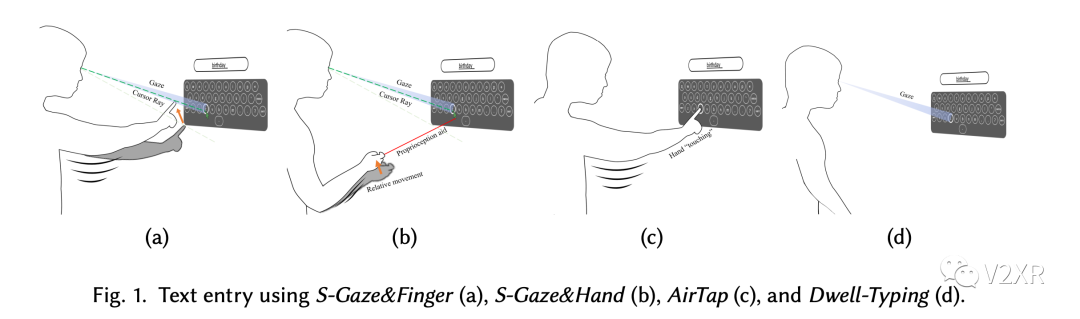

作者 2017 年之后的研究开始转向 VR/AR 领域,仍然关注手眼协同交互。在前期研究中,作者提出了各种不同的交互方案和应用场景(包括菜单选择、文本输入、 3D 物体操作等),都是通过 Gaze 完成选中再配合不同的手部动作实现确认操作。

但比较无奈的是,无论基于 HoloLens 还是 HTC Pro Eye + 外置 Leapmotion(手势追踪)作为实验设备,都无法覆盖足够的手势追踪范围。为了避免用户长时间手悬空导致的疲劳,Apple Vision Pro 专门设计了 4 颗朝下的摄像头用于捕捉用户手势。

用户手自然放在腿上确实可以减少手臂疲劳,但这并不适用于所有场景。比如发布会上演示的虚拟键盘输入,这种无支撑的悬空交互肯定不能满足长时间输入的需求,如果仔细看演示的效果图,有可能手指的识别精度只能支持食指☝️单指操作。

Apple Vision Pro 演示虚拟键盘输入

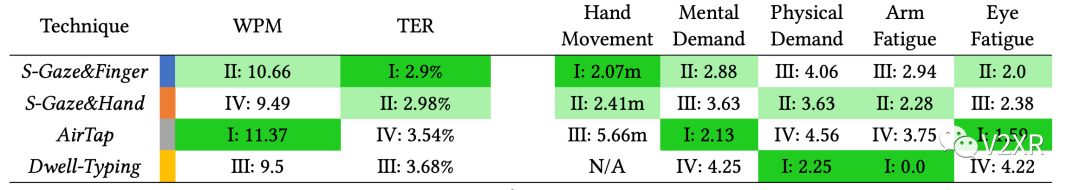

作者在 2022 年的研究中,基于 HoloLens 设计并对比了不同眼动追踪介入的输入方案,实验结果显示,通过视线与手指对齐的方式(瞄准)键盘输入,可以在保证输入效率的情况下,减少手臂的移动从而降低胳膊疲劳,当然,不可避免的也会引起一定的眼睛疲劳。

三、总结

本文总结了眼手协同一系列人机交互研究成果,Apple Vision Pro 所采用的并非完全创新但却有可能是在某些 VR/AR 任务场景下兼顾用户直觉效率和体验的最佳方案。苹果眼镜无疑极大扩展了用户直观获取信息的边界,让数字信息不再局限于一块 2D 的电脑/平板/手机屏幕,从 2D 升维到 3D。

这其实是来到了人类最熟悉、最自然的领域,只是受限于当前光学、显示、电池等技术的发展,人类无法在把数字世界拉高一个维度的同时提供如同物理世界一样的交互体验。

但是,找到现有技术极限和用户体验之间最佳的平衡点,正是苹果一直以来最擅长的。

所以从苹果的视角看,XR 是什么?

站在科技与人文的十字路口,不是把人类推向虚拟的「元宇宙」,而是把人类的心智连同沉迷其中的数字世界,一同拉回现实。

图文无关,只是很酷 : )

参考文献

- https://kenpfeuffer.com/eye-hand-symbiosis-what-guide/

- https://en.wikipedia.org/wiki/Eye_tracking

- Beaudouin-Lafon, M. (2000, April).Instrumental interaction: an interaction model for designing post-WIMP user interfaces.InProceedings of the SIGCHI conference on Human factors in computing systems(pp. 446-453).

- Forlines, C., Wigdor, D., Shen, C., & Balakrishnan, R. (2007, April).Direct-touch vs. mouse input for tabletop displays. InProceedings of the SIGCHI conference on Human factors in computing systems(pp. 647-656).

- Wagner, U., Lystbæk, M. N., Manakhov, P., Grønbæk, J. E. S., Pfeuffer, K., & Gellersen, H. (2023, April).A Fitts’ Law Study of Gaze-Hand Alignment for Selection in 3D User Interfaces. InProceedings of the 2023 CHI Conference on Human Factors in Computing Systems(pp. 1-15).

- Lystbæk, M. N., Rosenberg, P., Pfeuffer, K., Grønbæk, J. E., & Gellersen, H. (2022).Gaze-hand alignment: Combining eye gaze and mid-air pointing for interacting with menus in augmented reality.Proceedings of the ACM on Human-Computer Interaction,6(ETRA), 1-18.

- Lystbæk, M. N., Pfeuffer, K., Grønbæk, J. E. S., & Gellersen, H. (2022).Exploring gaze for assisting freehand selection-based text entry in ar.Proceedings of the ACM on Human-Computer Interaction,6(ETRA), 1-16.

- Pfeuffer, K., Mayer, B., Mardanbegi, D., & Gellersen, H. (2017, October).Gaze+pinch interaction in virtual reality.InProceedings of the 5th symposium on spatial user interaction(pp. 99-108).

- Pfeuffer, K. (2017).Extending touch with eye gaze input. Lancaster University (United Kingdom).

- Pfeuffer, K., Alexander, J., Chong, M. K., Zhang, Y., & Gellersen, H. (2015, November).Gaze-shifting: Direct-indirect input with pen and touch modulated by gaze. InProceedings of the 28th Annual ACM Symposium on User Interface Software & Technology(pp. 373-383).

- Pfeuffer, K., Alexander, J., Chong, M. K., & Gellersen, H. (2014, October).Gaze-touch: combining gaze with multi-touch for interaction on the same surface.InProceedings of the 27th annual ACM symposium on User interface software and technology(pp. 509-518).

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง