新智元报道

编辑:Lumina

【新智元导读】微软提出文本图像轨迹条件视频生成模型DragNUWA,支持手绘轨迹驱动图像动态化,实现复杂运动及场景控制。

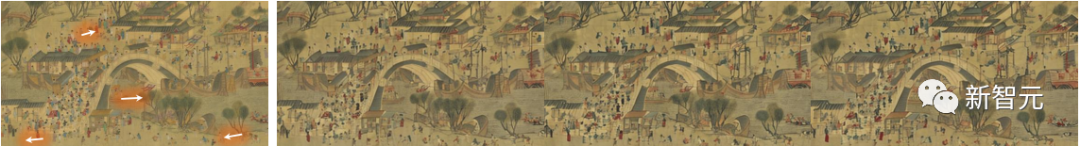

微软开发的视频生成模型DragNUWA让清明上河图动起来了!

只要用拖动的方式给出运动轨迹,DragNUWA就能让图像中的物体对象按照该轨迹移动位置并生成连贯的视频。

DragNUWA能同时控制摄像机和多个对象的移动以及复杂的轨迹,从而生成具有现实世界场景和艺术绘画特色的视频。

近年来,可控视频生成技术备受关注。但现有可控视频生成仍存在两大局限:

1. 现有的大多数工作都集中在文本、图像或基于轨迹的控制上,导致无法在视频中实现细粒度控制。

2. 轨迹控制的研究仍处于早期阶段,大多数实验都是在Human3.6M等简单数据集上进行的。这种局限性限制了模型处理开域图像和有效处理复杂曲线轨迹的能力。

来自微软的研究人员提出了基于开域扩散的视频生成模型: DragNUWA。

论文地址:https://arxiv.org/abs/2308.08089

DragNUWA针对现有研究中控制粒度不足的问题,同时引入了文本、图像和轨迹信息,从语义、空间和时间角度对视频内容进行精细控制。

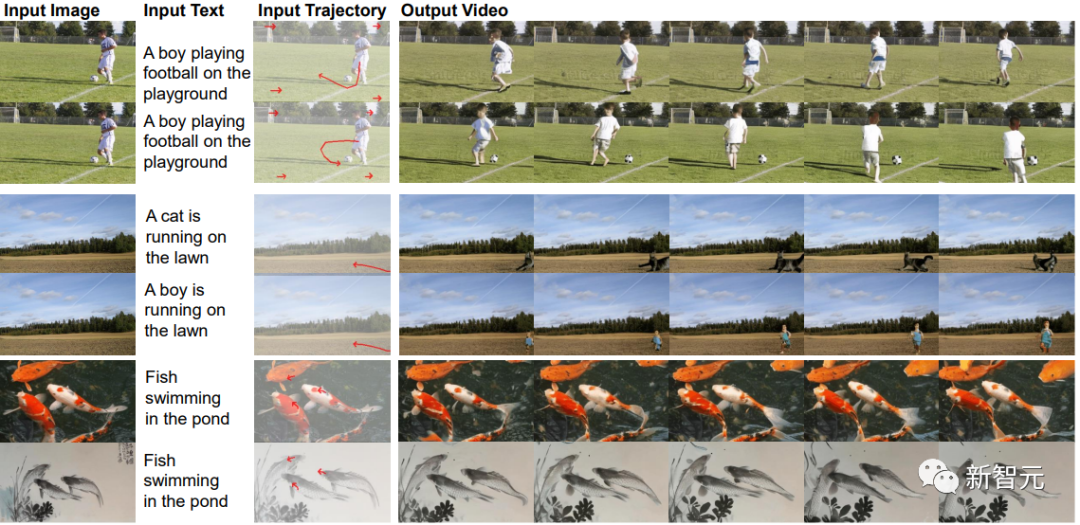

第一组展示了对复杂轨迹的控制,包括复杂运动(红色弯曲箭头和摄像机移动(红色向右箭头)。

第二组展示了语言控制的影响,将不同的文字与相同的图像和轨迹配对,以达到在图像中引入新对象的效果。

第三组展示了图像控制的影响,展示了真实世界和艺术视频的生成。

为了解决目前研究中开域轨迹控制有限的问题,研究人员从三个方面提出了轨迹建模:

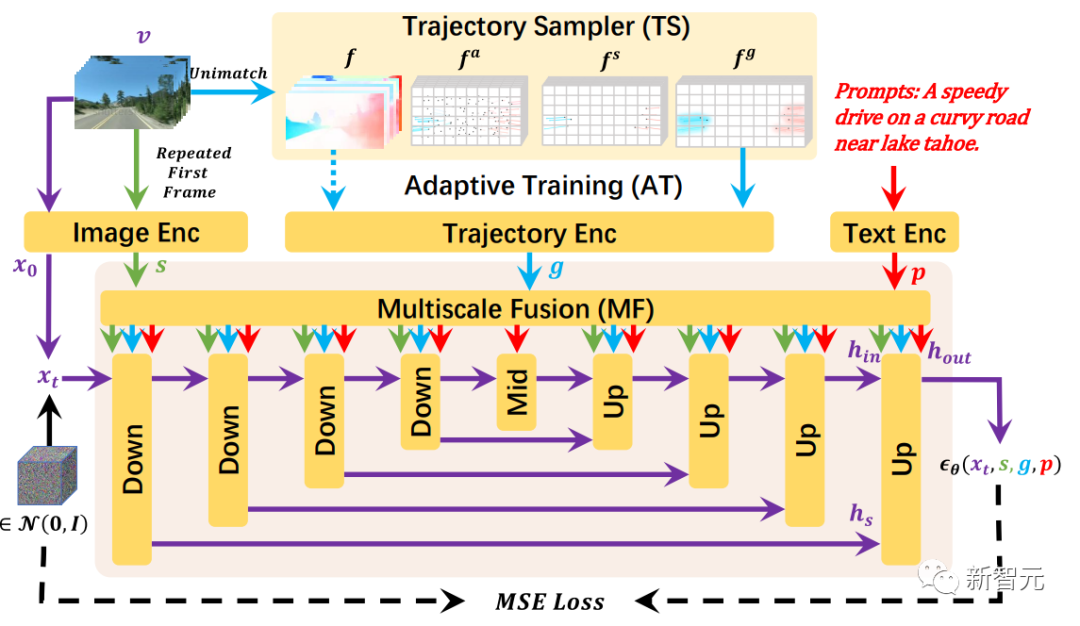

首先,通过轨迹采样器(TS)实现对任意轨迹的开域控制;其次,通过多尺度融合(MF)控制不同粒度的轨迹;最后,通过自适应训练(AT)策略以根据轨迹生成一致的视频。

工作原理DragNUWA支持三种可选输入:文本p、图像s和轨迹g,并侧重于从三个方面设计轨迹。

首先,轨迹采样器(TS)从开域视频流中动态采样轨迹。

其次,多尺度融合(MF)将轨迹与文本和图像深度融合到UNet 架构的每个区块中。

最后,自适应训练(AT)可根据光流条件调整模型,使轨迹更友好。

最终,DragNUWA 能够处理包含多个物体及其复杂轨迹的开域视频。

DragNUWA的训练过程概览

为了验证轨迹控制的有效性,研究人员从摄像机移动和复杂轨迹两个方面对DragNUWA进行了测试。

在视频制作中,摄像机移动在为观众创造动态和引人入胜的视觉效果方面发挥着重要作用。

不同类型的镜头移动有助于叙述故事或强调场景中的元素。常见的镜头移动不仅包括水平和垂直移动,还包括放大和缩小。

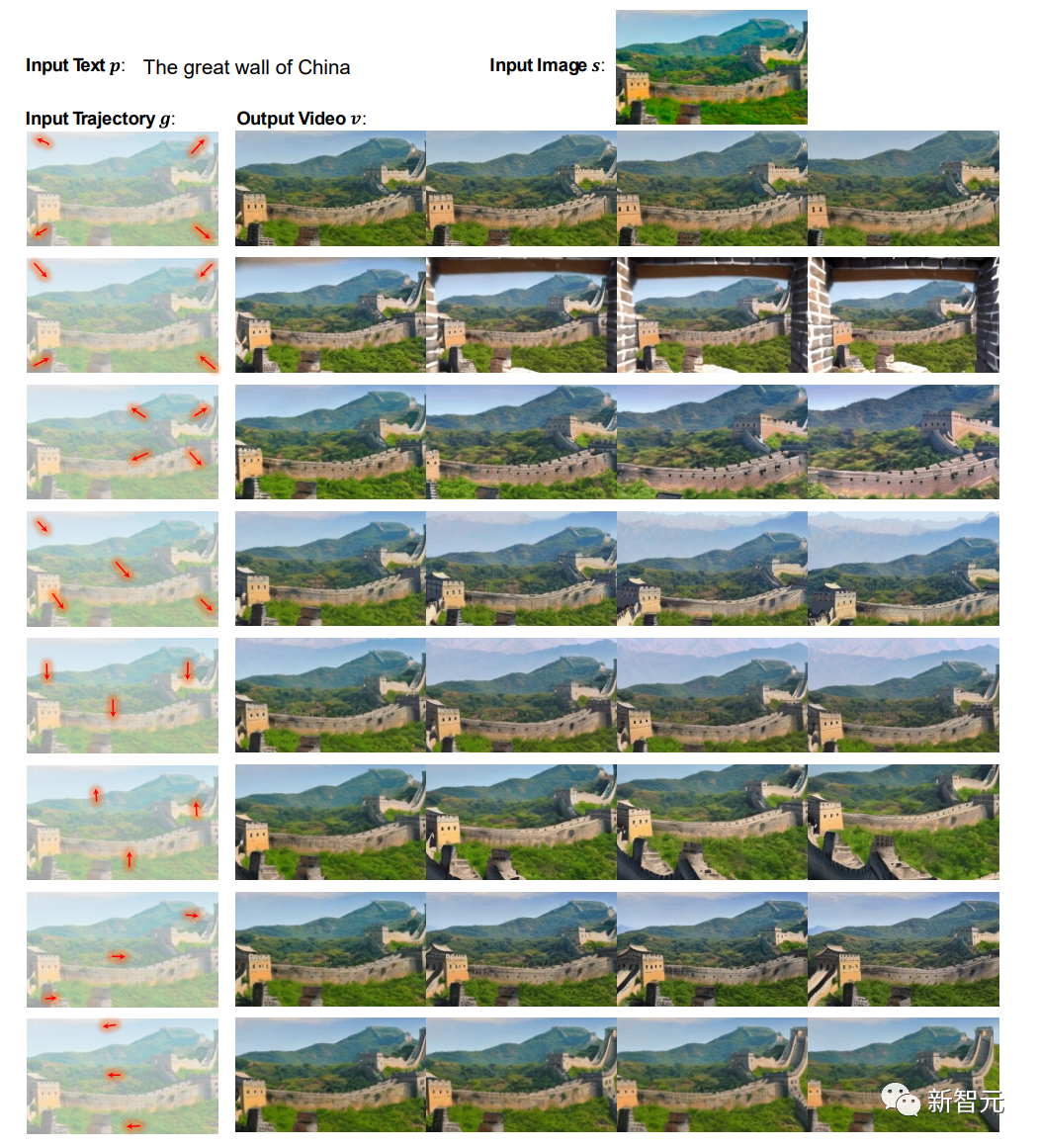

如下图所示,DragNUWA虽然没有明确对摄像机运动进行建模,但它可以从开放域轨迹建模中学习到各种摄像机运动:

利用相同的文字和图像,同时改变拖动轨迹,可以实现各种摄像机移动效果。例如,可通过在所需缩放位置绘制方向轨迹来表达放大和缩小效果。

视频中的物体往往具有复杂的运动轨迹。面对多个运动物体、复杂的运动轨迹以及不同物体之间不同的运动幅度,视频生成中的运动建模是一个巨大的挑战。

研究人员通过使用相同的文字和图片,同时改变拖动轨迹,实现了各种复杂的轨迹效果。

这证明了DragNUWA具有复杂运动进行精确建模的能力:支持复杂的曲线轨迹,允许轨迹长度可变,并支持同时控制多个对象的轨迹。

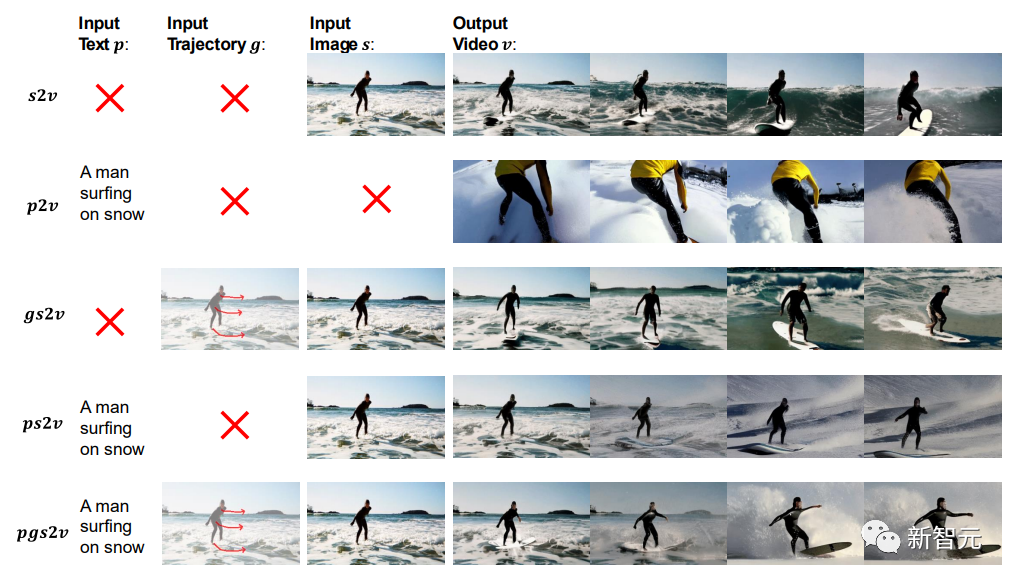

DragNUWA通过整合三个基本控制来实现精细视频生成:文本、图像和轨迹,分别对应语义、空间和时间方面。

这三个条件是不可或缺的:

s2v和p2v说明了图像和文本控制作为单独条件使用时的限制:

如s2v所示,虽然图像本身提供了一些潜在的语义和动力学信息,但它并不能实现对背景和角色运动的精确控制。

如p2v所示,当只提供文本时,模型能成功生成与文本相关的视频,但外观和动态仍完全无法控制。

gs2v和ps2v强调了文本(p)和轨迹(g)的重要性。在没有文本的情况下,无法确定模糊图像 (s) 代表的是海上冲浪还是雪地冲浪。在没有轨迹的情况下,模型会自动假定人物正在向左移动。

在三个基本条件都满足时,pgs2v中实现了在雪地上冲浪和向右移动的控制。

数据集

在训练过程中,研究团队利用WebVid和VideoHD数据集来优化 DragNU。

WAWebVid是一个庞大的数据集,由1000万个网络视频组成,涵盖了现实世界中的各种场景,并配有相应的标题。其涵盖了广泛的运动模式,适用于基于轨迹的开放域视频生成。

VideoHD是研究团队基于网络抓取的视频建立的数据集。研究人员首先从互联网上收集了75K高分辨率、高质量的视频片段。然后,使用BLIP2对这些片段进行标注。最后,手动过滤掉了生成结果中的一些错误。

作者简介

吴晨飞博士是微软亚洲研究院的高级研究员。他的研究重心是大规模预训练、多模态理解和生成。主要研究工作包括多模态生成模型NUWA(女娲)系列(NUWA, NUWA-LIP, NUWA-Infinity, NUWA-3D, NUWA-XL)、多模态理解模型Bridge Tower(桥塔)系列(KD-VLP, Bridge-Tower)以及多模态对话系统Visual ChatGPT。在CVPR, NeurIPS, ACL, ECCV, AAAI, MM等会发表多篇论文。

段楠博士,微软亚洲研究院资深首席研究员,自然语言计算团队研究经理,中国科学技术大学、西安交通大学兼职博导,天津大学兼职教授,主要从事自然语言处理、多模态基础模型、代码智能、机器推理等研究,多次担任NLP/AI学术会议程序主席和领域主席,发表学术论文100余篇,Google Scholar引用10000余次,持有专利20余项。他被评为中国计算机协会(CCF)杰出会员、CCF-NLPCC青年科学家(2019年)、DeepTech中国智能计算科技创新人物(2022年)。

参考资料:https://arxiv.org/abs/2308.08089

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง