模型蒸馏是一种新型的深度学习技术,旨在将复杂模型的知识迁移到小型模型中。这种技术被广泛应用于各种领域,如自然语言处理、计算机视觉和语音识别等。

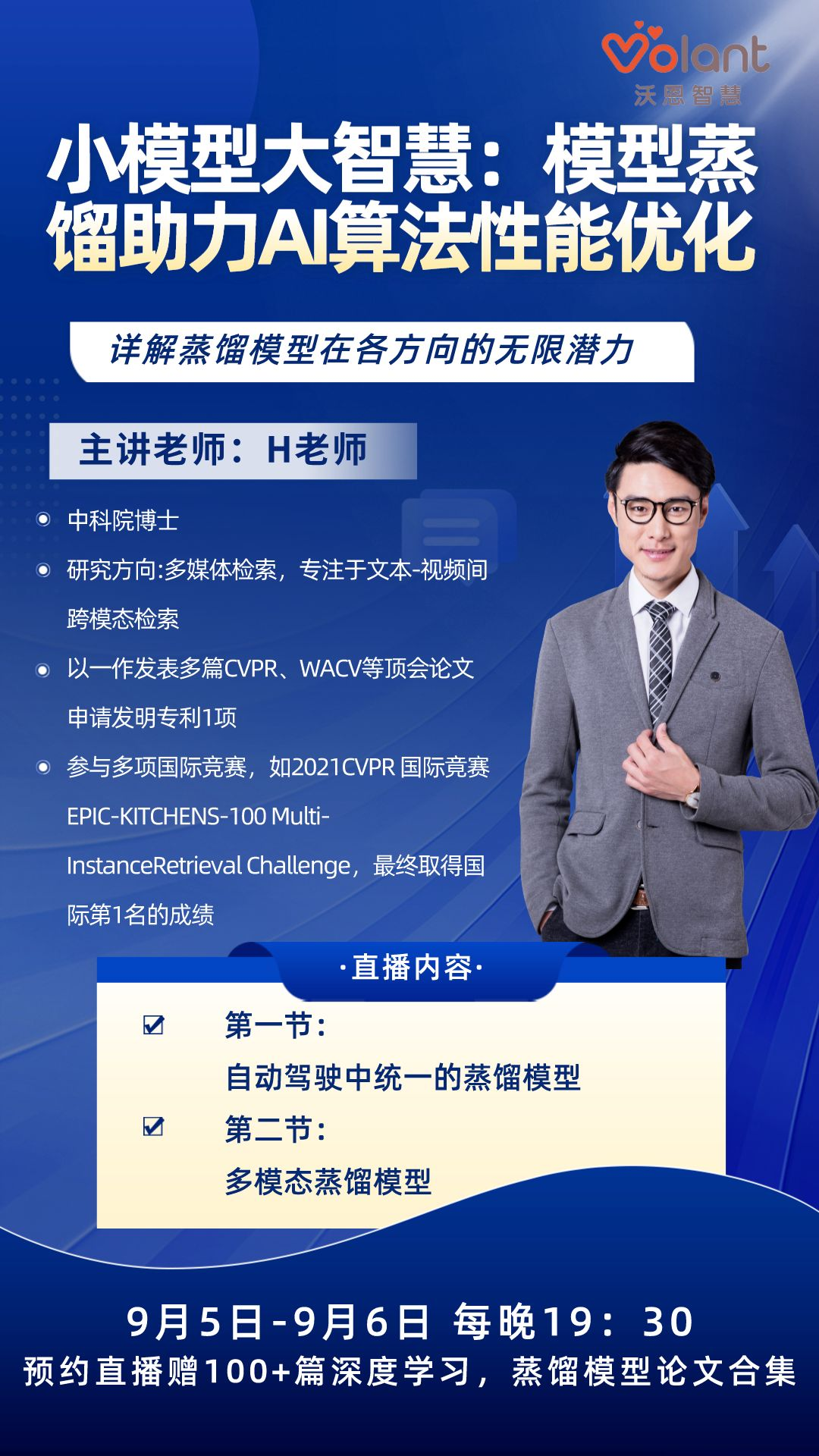

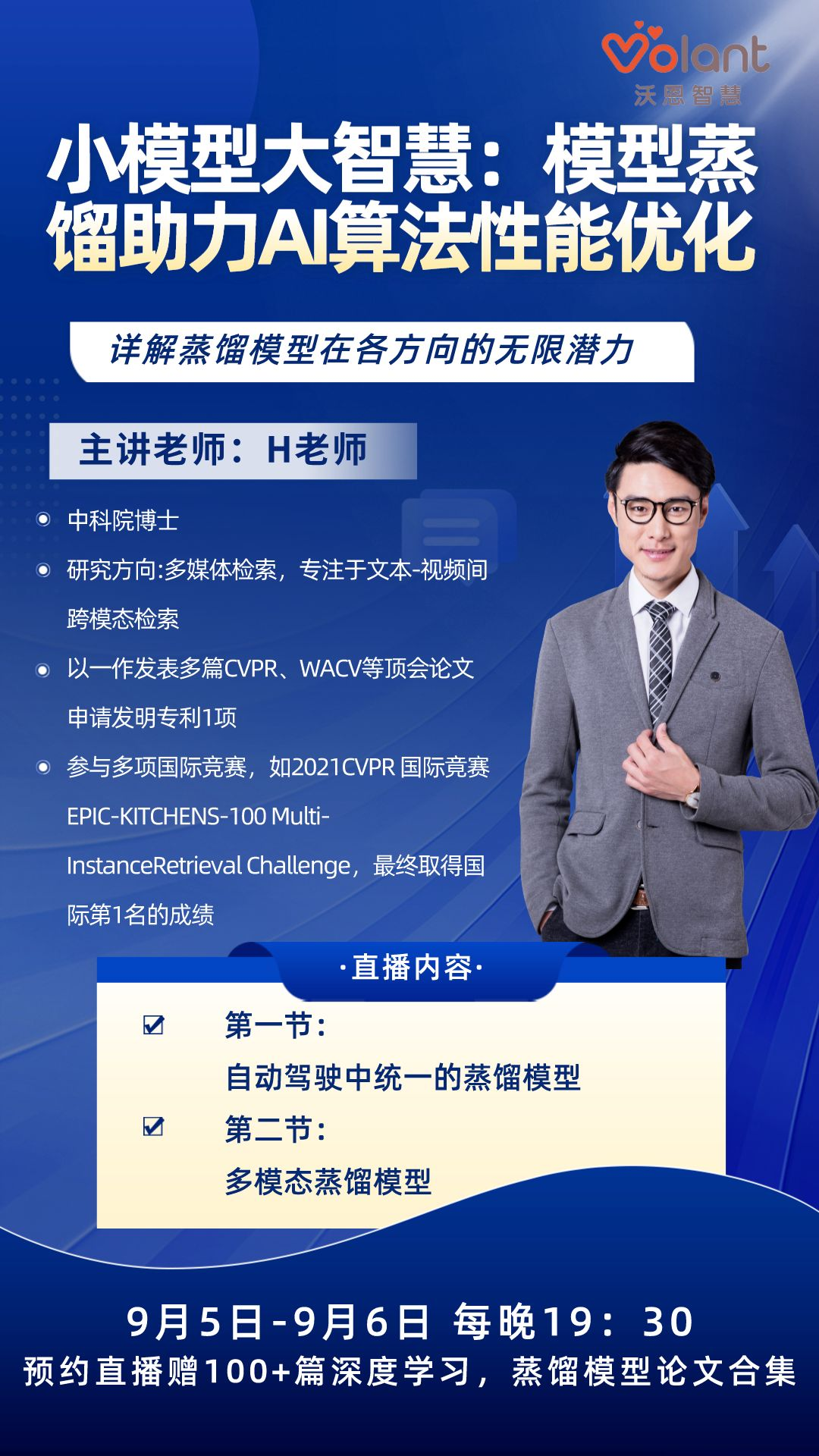

9月5日-9月6日,我们邀请到中科院博士,多个计算机国际竞赛获奖者H老师为我们带来——小模型大智慧:模型蒸馏助力AI算法性能优化,为我们详解蒸馏模型在各方向的无限潜力。

扫码预约直播(赠老师授课PPT)免费领100+篇深度学习,蒸馏模型论文合集 (文末有福利)

(文末有福利)

导师介绍:H老师

-毕业于中科院

-研究方向:多媒体检索,专注于文本-视频间跨模态检索

-以第一作者身份发表多篇顶会论文,包括CVPR,WACV等

-参与多项国际竞赛,以第一参赛人身份获得4项国际前三名和1项国际竞赛第四名,曾参加2021年CVPR 国际竞赛EPIC-KITCHENS-100 Multi-Instance Retrieval Challenge,最终取得国际第1名的成绩

直播大纲

一、自动驾驶中统一的蒸馏模型

1. 自动驾驶中的蒸馏技术2. BEV视角下的跨模态统一蒸馏框架3. 自动驾驶蒸馏模型的未来发展方向

二、多模态蒸馏模型1. 多模态蒸馏模型研究现状2. 一种先进多模态蒸馏模型框架3. 多模态蒸馏技术的未来发展方向

模型蒸馏在各个领域的应用在不断扩展。未来,我们期待看到更多的研究探索如何更好地利用蒸馏方法进行知识迁移,以提高模型的性能和效率。9月5日-9月6日,H老师将用3-4个小时为我们从两大方向详解蒸馏模型技术。

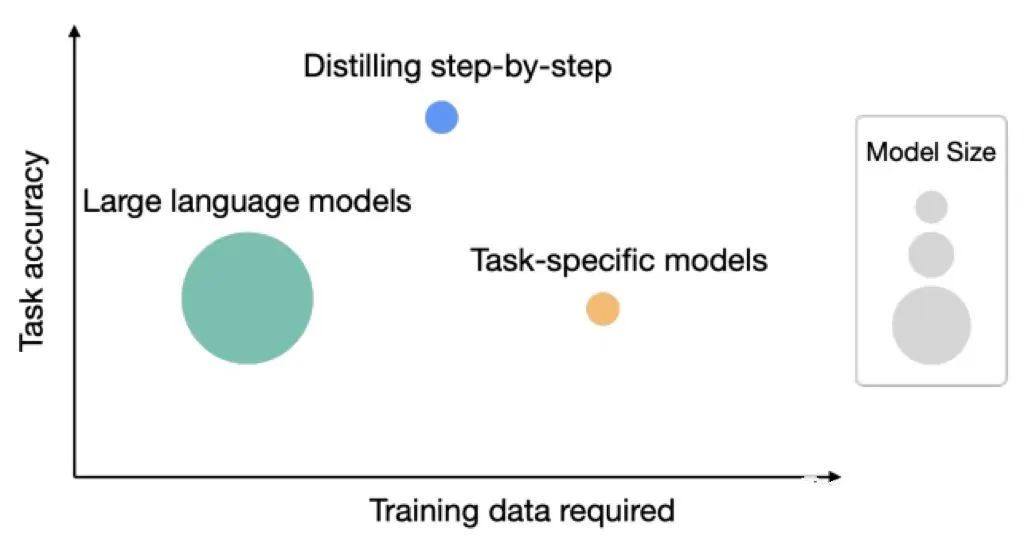

前段时间,Google研究人员与华盛顿大学研究人员提出新的模型蒸馏方法:逐步蒸馏法详解,即逐步蒸馏(Distilling step-by-step)法,它可以应用在所有类型的语言模型中,没有限制!这个方法非常有价值,对于未来做模型小型化有很大的帮助,在推特上吸引了很多的讨论。

扫码预约直播(赠老师授课PPT)免费领100+篇深度学习,蒸馏模型论文合集 (文末有福利)

(文末有福利)

1.在自然语言处理领域

蒸馏方法被广泛应用于语言模型的压缩和加速。例如,Distillation with Soft Targets和Knowledge Distillation with Gaussian Teachers等文献提出了新的蒸馏方法,以提高模型的知识迁移效果。此外,一些研究还探索了使用蒸馏方法进行跨语言和跨领域的模型迁移。

2.在计算机视觉领域

蒸馏方法也被广泛应用于模型压缩和加速。例如,一些研究将教师模型的知识迁移到小型网络模型中,以提高图像分类和物体检测的准确性。此外,一些研究还探索了使用蒸馏方法进行跨领域和跨模态的数据迁移。

3.在语音识别领域

蒸馏方法也被广泛应用于模型压缩和加速。例如,一些研究将教师模型的知识迁移到小型网络模型中,以提高语音识别和语音转换的准确性。此外,一些研究还探索了使用蒸馏方法进行跨领域和跨模态的数据迁移。

全民积极向(内)上(卷)的时代,江湖常有传言:SCI在手,升职加薪、前程无忧。

发论文的门槛,说高不高,说低不低。不管你是科研经验丰富的研二研三学生还是研0小白都可以发论文的。有时候限制你发论文的,不是写作技巧、不是实验,往往是最初但是最重要的idea。

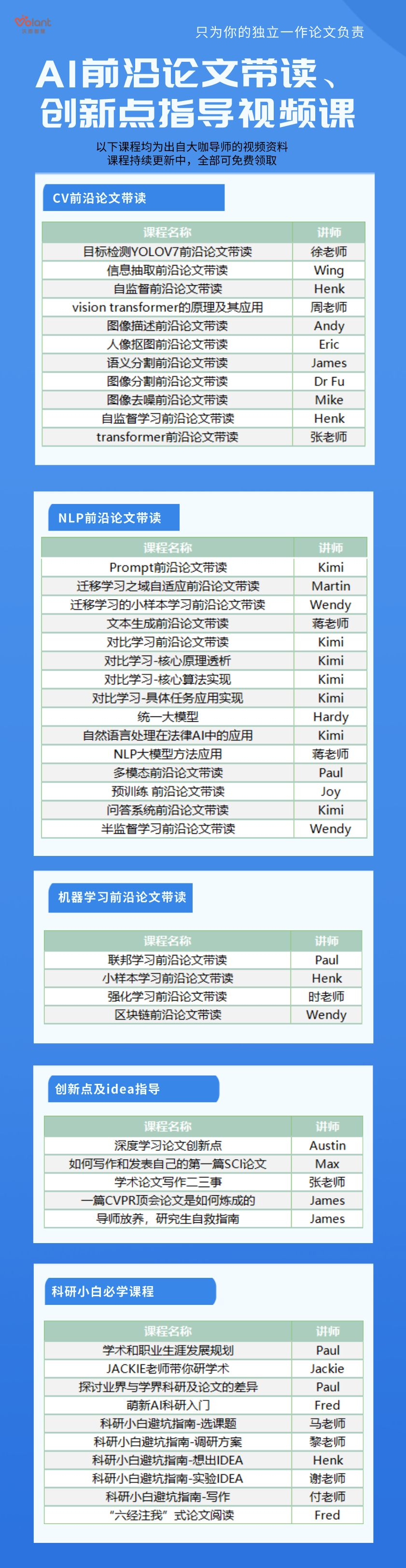

对于想要发表论文,对科研感兴趣或正在为科研做准备的同学,想要快速发论文有两点至关重要。1.紧跟风口。想发文章最容易的方法就是紧跟风口,顺着领域内的研究趋势确定自己的方向,毕竟在热门领域内,创新点和idea远比其他非热门领域多。

2.有一位有经验有能力的前辈指导。大家都在努力的设计新网络、新策略、新training算法,只要能够在某一问题上做到一个很好的performance,论文就水到渠成。而想要快速达到,来自前辈的指点不可或缺。

所以,要解决的问题就是:1.找到风口2.找到领域内的大神做导师

扫描二维码与大牛导师一对一meeting

扫码预约直播(赠老师授课PPT)免费领100+篇深度学习,蒸馏模型论文合集 (文末有福利)

(文末有福利)

文末福利

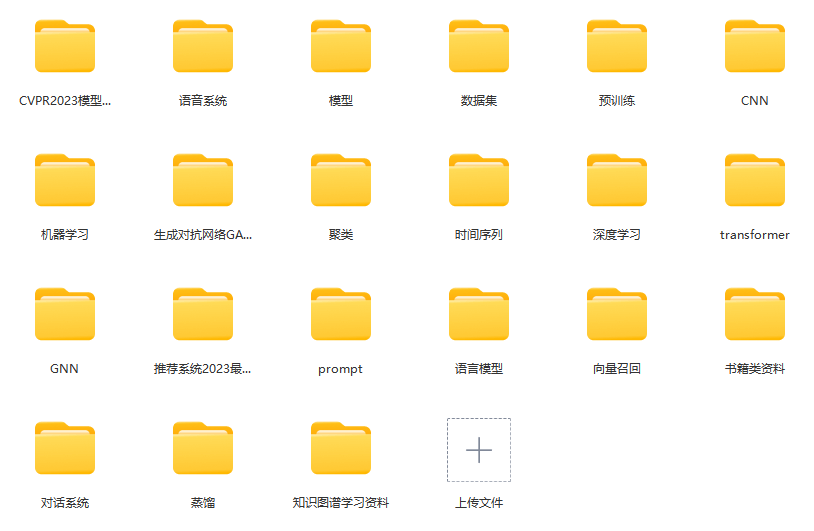

作为日常为了论文而忙碌的科研人,小编知道大家一定很需要一些资料。因此,小编精心整理了一份超过20G的AI顶会论文大礼包!包含最新顶会论文、书籍等资料,以及引文论文写作指导保姆级资料,从文献阅读到论文写作,全部帮你整理好~

扫码免费领课程资料↑

-End-

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง