Efficient RLHF: Reducing the Memory Usage of PPO

M Santacroce, Y Lu, H Yu, Y Li, Y Shen

[Microsoft]

高性能RLHF:减少PPO的内存使用

要点:

- 研究了减少强化学习人工反馈(RLHF)中Proximal Policy Optimization(PPO)的内存使用技术。

- 发现与监督微调(SFT)相比,PPO使用了3倍以上的内存,使其对许多用户不可行。

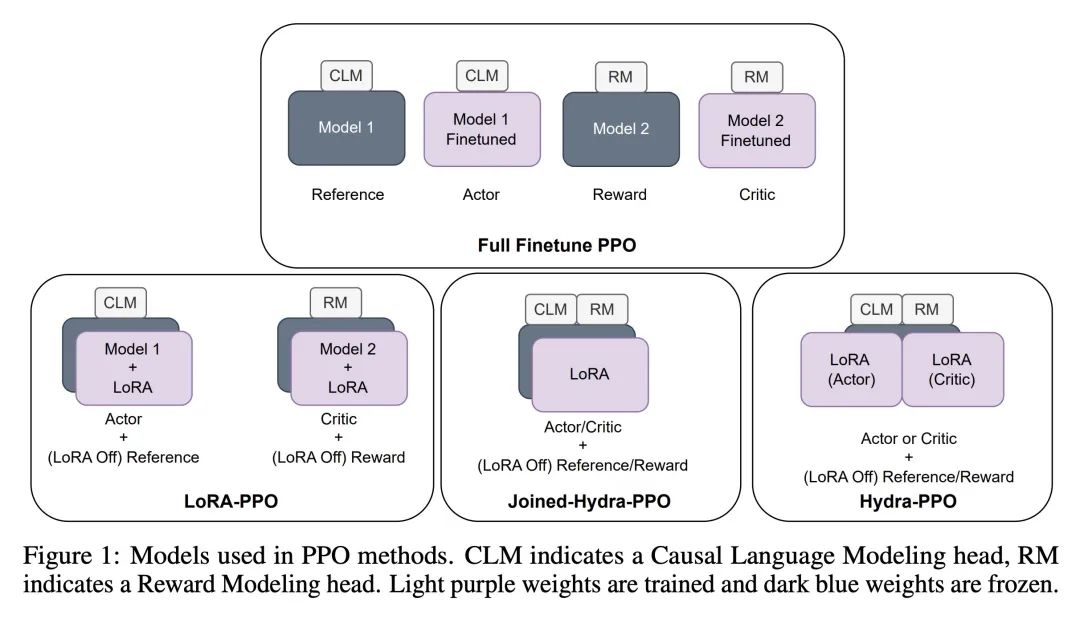

- 提出Hydra-RLHF,将参考和奖励模型合并为一体,并在PPO过程中动态关闭LoRA以重用模型。

- 实验表明,与SFT相比,Hydra-PPO的内存使用类似,而在4个数据集上改进了对齐。

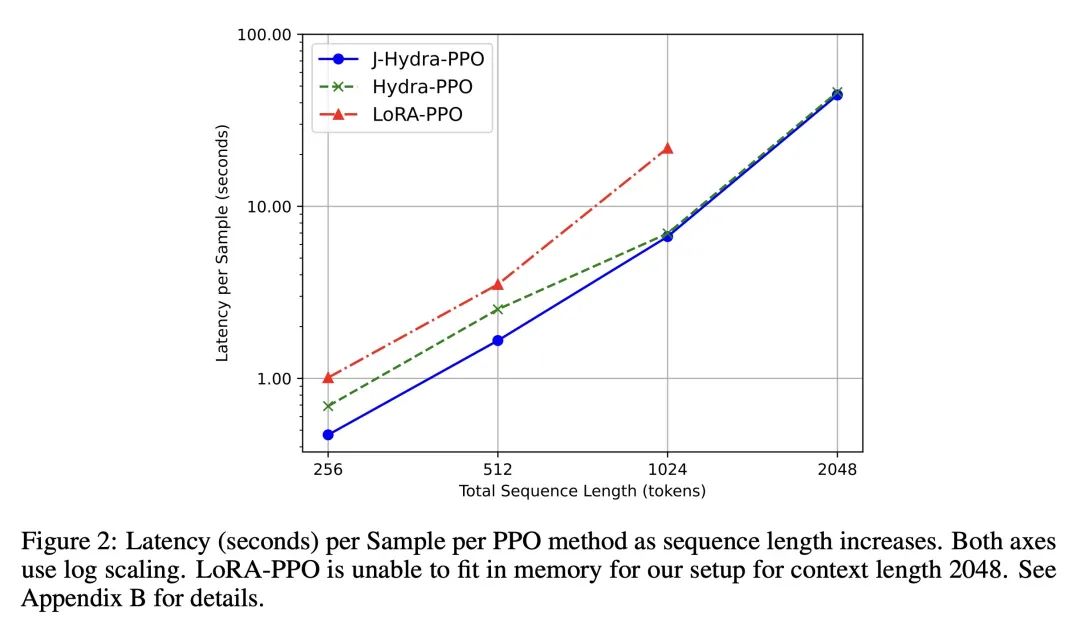

- 增加批量大小以利用节省的内存,将Hydra-PPO每样本延迟降低了高达65%,比标准PPO快。

- 得出结论Hydra-PPO通过减少内存需求同时保持准确性,使更广泛使用RLHF成为可能。

- 确定在更多层面共享和改进Joined Hydra-PPO是未来工作的领域。

动机:解决强化学习中使用人工反馈的方法在内存使用方面的问题,以促进其更广泛的应用。

方法:提出一种名为Hydra-PPO的方法,通过整合监督微调(SFT)和奖励模型,并在训练过程中动态关闭LoRA模块,从而减少Proximal Policy Optimization(PPO)的内存使用。

优势:Hydra-PPO方法在减少内存使用的同时,保持了性能,并且能提高PPO的训练速度和批处理大小,从而更广泛地应用于强化学习中。

一句话总结: 提出Hydra-PPO方法,通过整合监督微调(SFT)和奖励模型并动态关闭LoRA模块,既减少了内存使用,又提高了PPO的性能和训练速度。

https://arxiv.org/abs/2309.00754

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง