大语言模型技术正在飞速发展,从机器学习平台角度,如何管理好大模型研发应用整个生命周期至关重要,包括数据管理、资源管理、模型开发、训练评估、推理部署等方面。

在9月15日9:00-17:00举办的DataFunSummit2023大模型与AI基础软件峰会主论坛上,腾讯 TEG 机器学习平台部总监陶阳宇将分享腾讯太极LLMOps大模型平台实践,探讨大模型场景,以及平台如何提高模型研发效率、降低30%资源成本。

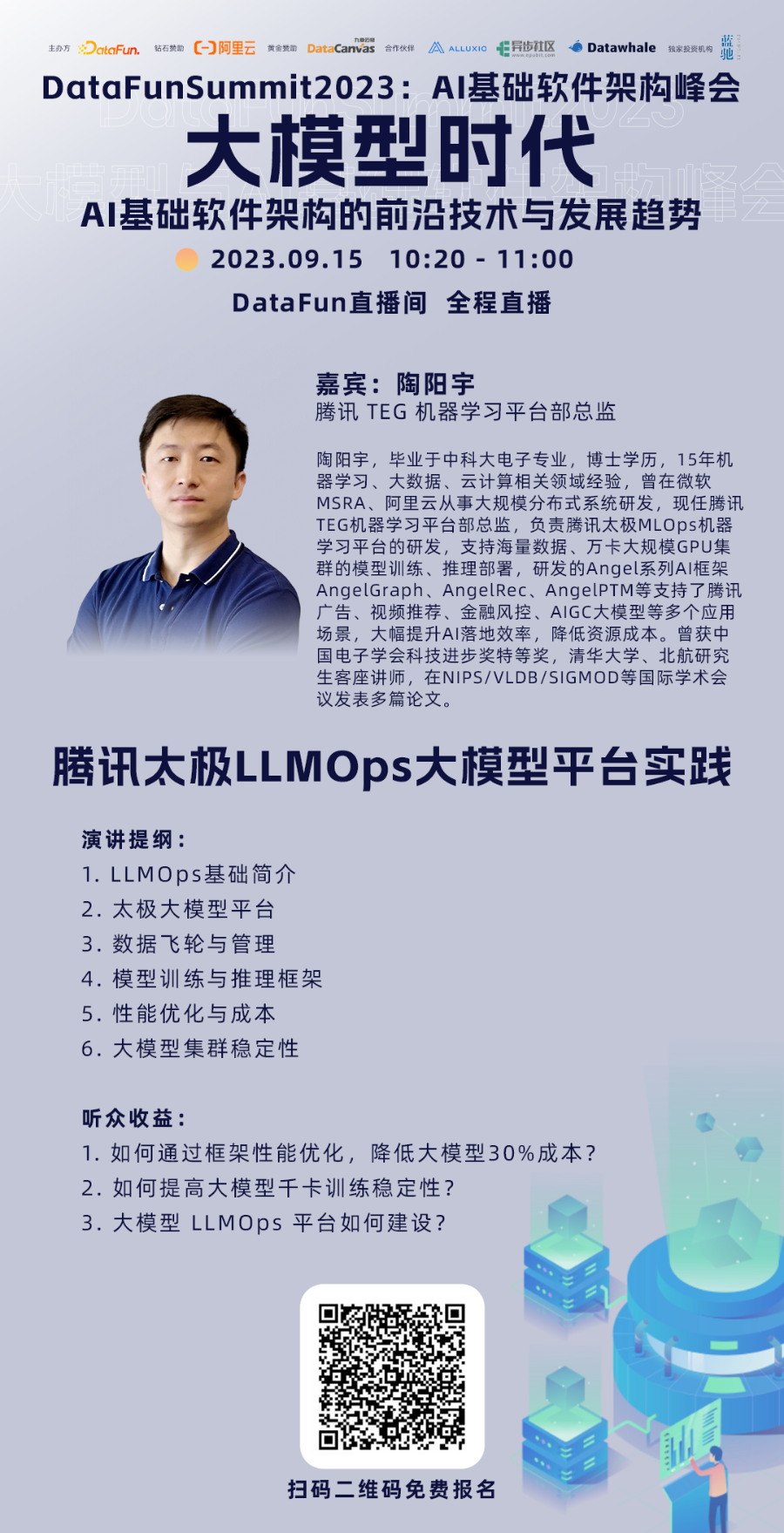

陶阳宇 腾讯 TEG 机器学习平台部总监

个人介绍:陶阳宇,毕业于中科大电子专业,博士学历,15年机器学习、大数据、云计算相关领域经验,曾在微软MSRA、阿里云从事大规模分布式系统研发,现任腾讯TEG机器学习平台部总监,负责腾讯太极MLOps机器学习平台的研发,支持海量数据、万卡大规模GPU集群的模型训练、推理部署,研发的Angel系列AI框架AngelGraph、AngelRec、AngelPTM等支持了腾讯广告、视频推荐、金融风控、AIGC大模型等多个应用场景,大幅提升AI落地效率,降低资源成本。曾获中国电子学会科技进步奖特等奖,清华大学、北航研究生客座讲师,在NIPS/VLDB/SIGMOD等国际学术会议发表多篇论文。

🔥演讲题目:腾讯太极 LLMOps 大模型平台实践

演讲提纲:大语言模型技术正在飞速发展,从机器学习平台角度,如何管理好大模型研发应用整个生命周期至关重要,包括数据管理、资源管理、模型开发、训练评估、推理部署等方面,本次分享以腾讯太极LLMOps大模型平台实践为基础,探讨大模型场景,平台如何提高模型研发效率、降低资源成本。具体包括:

1. LLMOps基础简介

2. 太极大模型平台

3. 数据飞轮与管理

4. 模型训练与推理框架

5. 性能优化与成本

6. 大模型集群稳定性

🎁听众收益:

1. 如何通过框架性能优化,降低大模型30%成本?

2. 如何提高大模型千卡训练稳定性?

3. 大模型 LLMOps 平台如何建设?

扫码免费报名观看

扫码免费报名观看

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง