Mobile V-MoEs: Scaling Down Vision Transformers via Sparse Mixture-of-Experts

E Daxberger, F Weers, B Zhang, T Gunter, R Pang, M Eichner, M Emmersberger, Y Yang, A Toshev, X Du

[Apple]

Mobile V-MoEs: 缩减Vision Transformer规模

- 最近的稀疏Mixture-of-Experts模型(MoE)通过解耦模型大小与推理效率,实现了前所未有的可扩展性,但还没有被探索过用于资源受限的设置。

- 本文提出一种简化的、移动友好的MoE设计,其中单个路由器将整张图像(而不是图块)分配给专家。

- 提出一种简单但鲁棒的训练程序,其中超类信息指导路由器训练以避免专家不平衡。

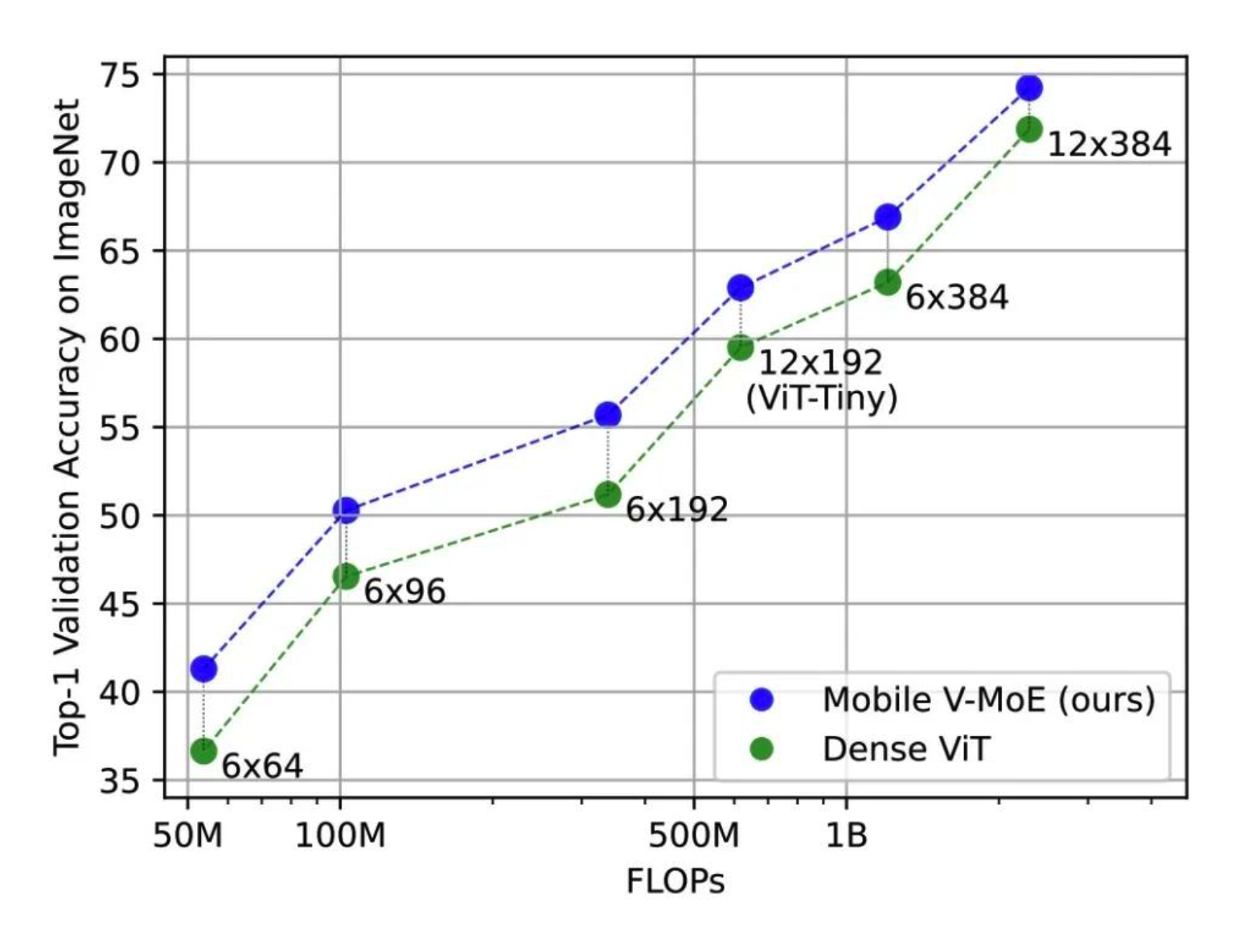

- 从经验上看,所提出的稀疏Mobile V-MoEs与稠密的Vision Transformers (ViTs)相比,在性能与效率之间实现了更好的权衡。

- 例如,在相似的FLOPs下,Mobile V-MoE的ImageNet top-1准确率比ViT-Tiny高出3.39%。

- Ablation研究显示了每图像路由、超类引导训练以及每个图像只激活1-2个专家的好处。

- 结论是,稀疏MoEs可以通过缩小ViT的规模来改进性能与效率的权衡,以用于资源受限的应用。

动机:探索使用稀疏专家混合(MoE)模型来 缩减Vision Transformer(ViT)的规模,以使其在资源受限的视觉应用中更具吸引力。

方法:提出一种简化的、适用于移动设备的稀疏MoE设计,其中整个图像而不是单个图块被路由到专家。提出一种鲁棒的MoE训练过程,使用超类信息来指导路由器。

优势:实验证明,稀疏Mobile Vision MoEs(V-MoEs)在性能和效率之间取得了更好的平衡,比相应的密集ViTs模型表现更好。

通过稀疏的专家混合(MoE)模型设计和训练方法,本文探索了使用稀疏MoE来缩减Vision Transformer的规模,提高了性能和效率的平衡。

https://arxiv.org/abs/2309.04354

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง