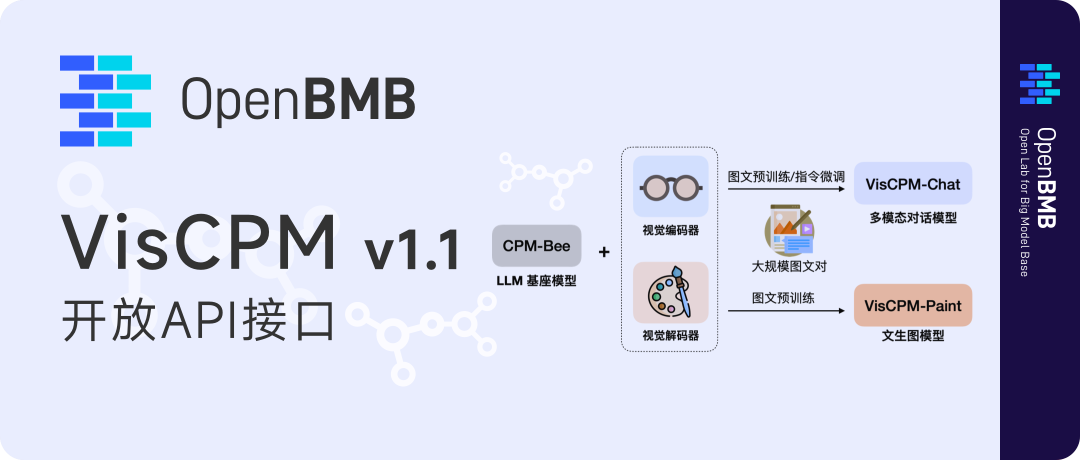

今年6月底,OpenBMB开源了面壁智能、清华NLP实验室和知乎联合研发的SOTA 开源中文多模态大模型VisCPM。两个多月以来研发同学不断突破,VisCPM得到全新升级。

-

易用性升级:提供API调用,提供在线Demo,支持用户本地图形化界面部署,支持低资源推理(最低5G显存运行);

-

能力更强:对话能力升级至v1.1版本,在多模态对话、细节描述、复杂推理三个专项性能均超过其它中文模型;

-

论文发布:论文对VisCPM的多语言多模态技术进行了详细介绍,并进一步推广至更多语言。目前基于LLaMA的多模态对话模型在德语、法语、西班牙语等6种语言上表现出色。

易用性升级VisCPM开放API接口

—

在易用性方面,VisCPM自发布以来持续升级:

值得一提的是,近期VisCPM-Chat 开放API ,可以使开发者更便捷地接入大模型能力,提高应用程序的开发效率,促进数据共享和生态共建。开发者仅通过如下代码,就可轻松体验中文领域图文理解最强的VisCPM-Chat,API接口支持的输入格式和使用方式如下:

import requestsimport base64

url = "http://34.143.180.202:3389/viscpm"resp = requests.post(url, json={ # need to modify "image": base64.b64encode(open("path/to/image", "rb").read()).decode(), "question": "描述一下这张图片",})resp = resp.json()print(resp)

能力更强:VisCPM v1.1测评遥遥领先

—

8月18日,VisCPM-Chat-v1.1版本发布,带来更强的细节理解和复杂推理能力!在LLaVA标准评测基准上的结果显示 VisCPM在中文多模态模型中综合能力最强。

可以看到,VisCPM在与其它中英双语的多模态大模型的横向比较中,中文能力整体得分最高(其中细节描述和复杂推理能力尤为突出),英文能力也媲美LLaVA。而在和v1.0版本的纵向比较中,VisCPMv1.1版本在细节描述方面的得分大幅提升。

* LLaVA评测基准基于COCO数据集(Common Objects in Context,由微软发布的标准多模态数据集)构建,从多模态对话、细节描述和复杂推理三方面全面考察多模态交互能力。

* 评测基准使用GPT-4作为打分模型,从帮助度、相关度、准确度和详细程度4个维度,给标准答案和参评模型答案打分,得到对应分数(从1至10),分数越高表明整体表现越好。

* VisCPM-Chat(v1.0):VisCPM-Chat有两个模型版本,分别为 VisCPM-Chat-balance 和 VisCPM-Chat-zhplus,前者在英文和中文两种语言上的能力较为平衡,后者在中文能力上更加突出。本文提到的VisCPM v1.1是VisCPM-Chat的升级版。

最后,再次欢迎大家调用API接口。相信无论您是开发者、研究人员还是企业家,都可以利用VisCPM出色的图片细节描述和复杂推理能力找到无限的可能性。VisCPM能为您提供了前所未有的创造力,让您能够重新定义您的项目,为用户带来卓越的价值。另一方面,VisCPM的成长需要您的贡献,让我们一起转动数据飞轮,共建持续进化的大模型生态。

➤ VisCPM开源地址

🔗 https://github.com/OpenBMB/VisCPM

➤ VisCPM论文链接

🔗https://arxiv.org/pdf/2308.12038.pdf

➤ 加社群/ 提建议/ 有疑问

请找 OpenBMB 万能小助手:

官方网站

https://www.openbmb.org

GitHub

https://github.com/OpenBMB

https://github.com/thunlp

长期开放招聘|含实习

交流QQ群

735930538

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง