Uncovering mesa-optimization algorithms in Transformers

J v Oswald, E Niklasson, M Schlegel, S Kobayashi, N Zucchet, N Scherrer, N Miller, M Sandler, B A y Arcas, M Vladymyrov, R Pascanu, J Sacramento

[Google Research & ETH Zürich]

Transformer的Mesa优化算法

-

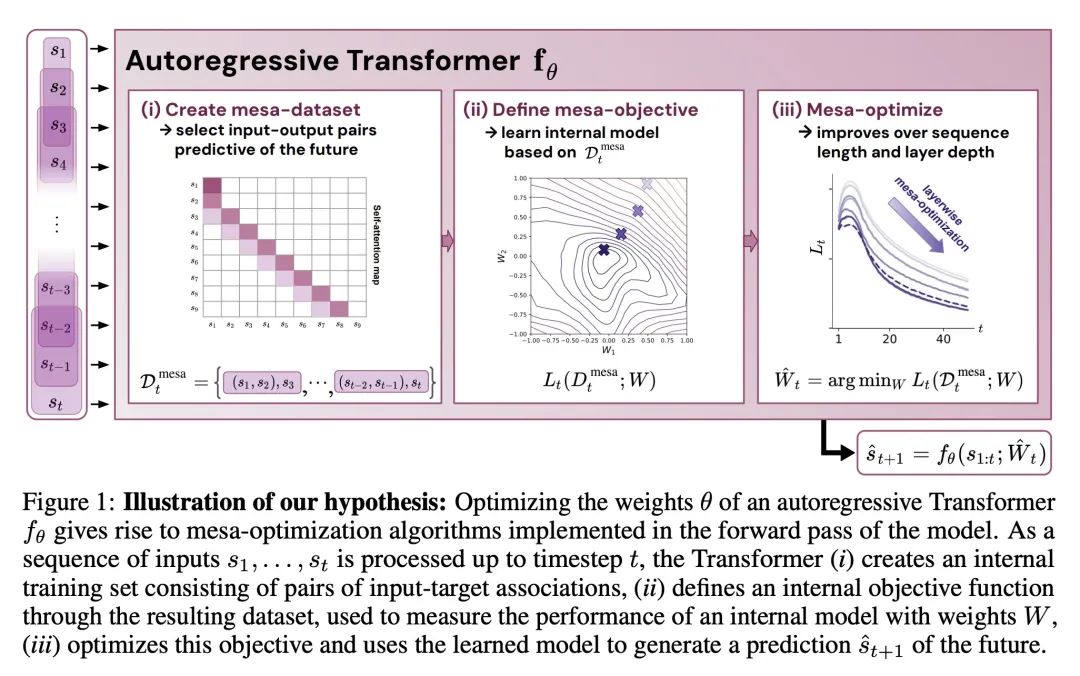

Transformer模型在深度学习中占据统治地位,但性能优秀的原因尚不清楚。本文假设它们强大的性能源自于架构偏差,即模型内mesa优化:在推理过程中,模型构建内部目标并通过梯度下降对其进行优化。

-

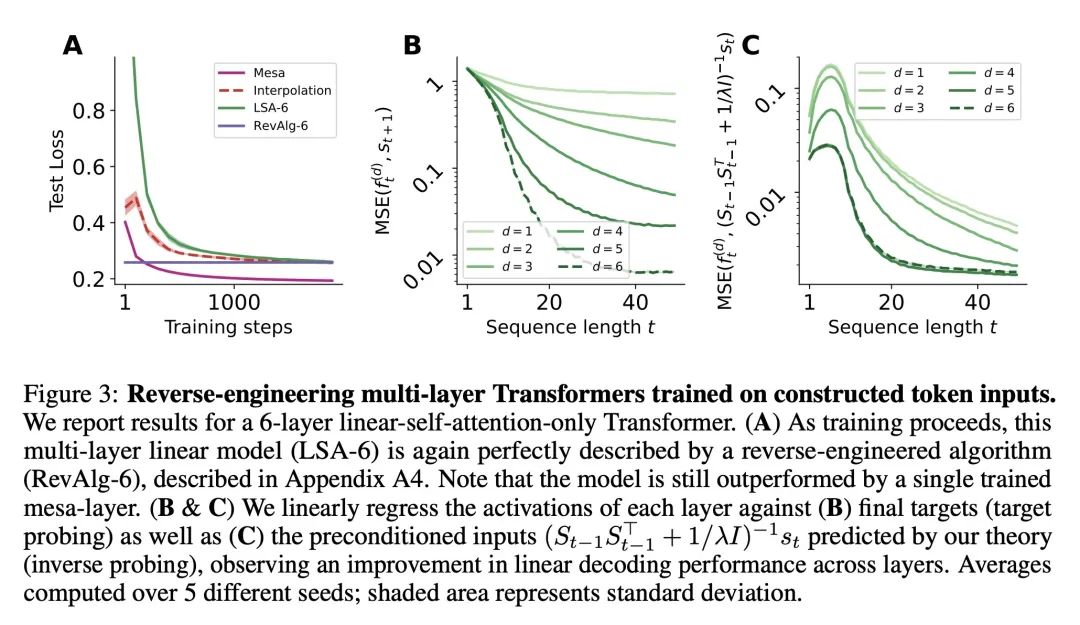

推广了之前的理论,展示了线性自注意力层如何实现梯度下降,将这一理论扩展到自回归设置,为多层Transformer提出新的构造来实现加速优化算法。

-

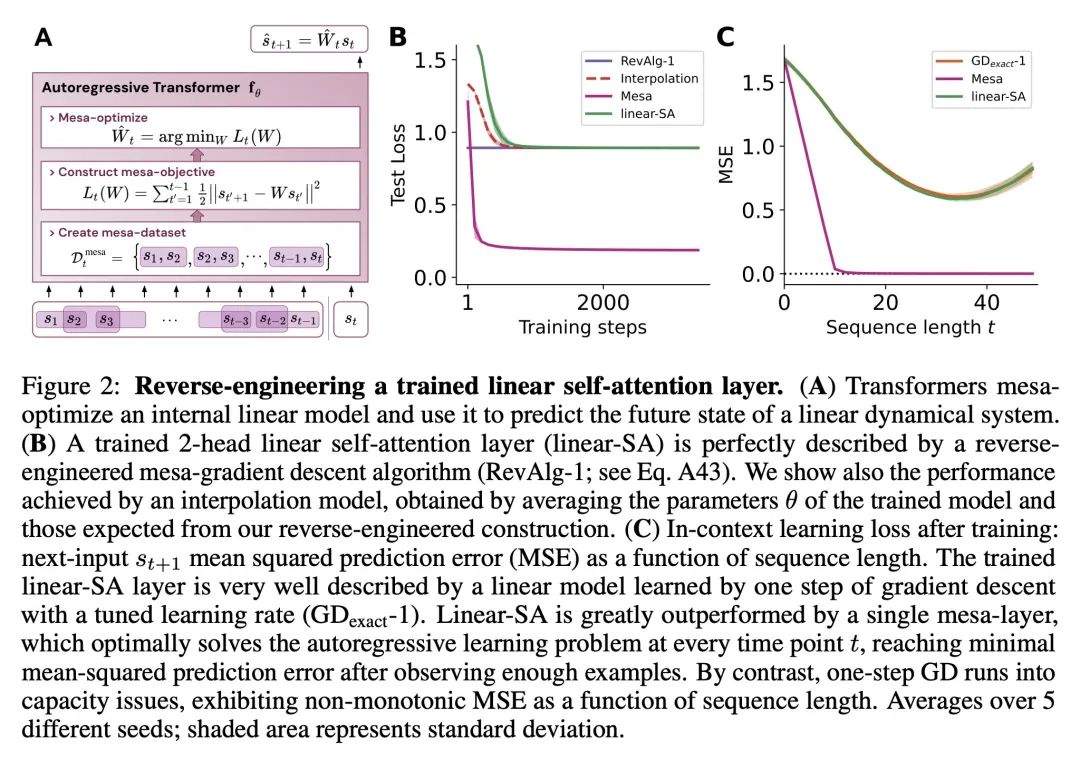

通过逆向工程,在训练于合成序列建模任务的Transformer中发现了基于梯度的mesa优化算法的经验证据。前期层通过组合标记来构建目标,而后期层则优化这些目标以进行预测。

-

发现的mesa优化算法使简单的Transformer能实现上下文少样本学习,这表明mesa优化也可能是大语言模型的这种能力的基础。提示微调被证明可以改进上下文学习。

-

在这些发现的启发下,提出一个新的mesa层,可以有效地求解指定的最小二乘问题,用该层替换标准注意力可以提高合成任务和语言建模的性能,这为mesa优化的重要性提供了进一步证据。

动机:理解Transformer模型在深度学习中的优越性能的原因。

方法:通过逆向工程一系列在简单序列建模任务上训练的自回归Transformer,揭示了驱动预测生成的基于梯度的mesa-optimization算法。

优势:发现了mesa-optimization算法在大语言模型的上下文学习能力中的重要作用,并提出一种新的自注意力层——mesa-layer,可以有效地解决上下文中指定的优化问题,并在合成和初步语言建模实验中提高性能。

通过逆向工程揭示了Transformer模型中潜在的mesa-optimization算法,并提出一种新的自注意力层——mesa-layer,用于解决优化问题。

https://arxiv.org/abs/2309.05858

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง