今天是2023年9月17日,星期日,北京,天气阴。

这个周末,我们来看看一些关于综述性的工作。

包括大模型微调遗忘问题、RAG检索式生成综述、三、Agent智能体综述以及关于大模型幻觉的综述,这些工作都是当前大模型研究何落地的热点。

感兴趣的可以关注,具有一定的参考意义。

一、大模型微调遗忘问题

《Speciality vs Generality: An Empirical Study on Catastrophic Forgetting in Fine-tuning Foundation Models》

地址:https://arxiv.org/pdf/2309.06256.pdf

将大模型用于下游任务通常的做法是在特定任务中对基础模型进行微调,以提高任务性能或使模型行为符合期望。

该工作旨在回答在对基础模型进行微调以获得特定任务的专业性时,它是否会忘记通用性?以及有什么方法可以减轻专业性与通用性之间的权衡?

为了全面解决上述问题,该工作针对语言模型,在医疗问题解答(QA)任务的特定数据集上对其进行了微调。然后测量它在其他医学问答数据集上的分布通用性,并评估在常识性问答以及指令性任务中的任务通用性。

1、现有的一些微调遗忘缓解策略

首先是预训练、微调和分布偏移

当把预训练模型部署到真实世界的应用中并对其进行微调时,遇到来自目标分布的新样本,而目标分布与微调分布不同。为了解决这个问题,有几种方法:

利用预训练模型和微调模型的权重集合来提高分布外(OOD)性能。

LP-FT,利用用一个相当好的分类器初始化预训练的特征提取,因为在微调过程中,预训练的特征很容易被扭曲,以适应随机分类器,从而加剧灾难性遗忘问题。

其次是灾难性遗忘和持续学习

DNN在开始学习新任务(如微调任务)时,往往会丢失以前学习过的任务(如预训练任务)知识。为了减轻灾难性遗忘,可以有以下几种方法:

对新任务中参数的变化施加惩罚。

基于回复,近似并恢复旧数据分布。

知识蒸馏(KD),使微调模型的预测结果接近旧模型的预测结果。

2、实验结论

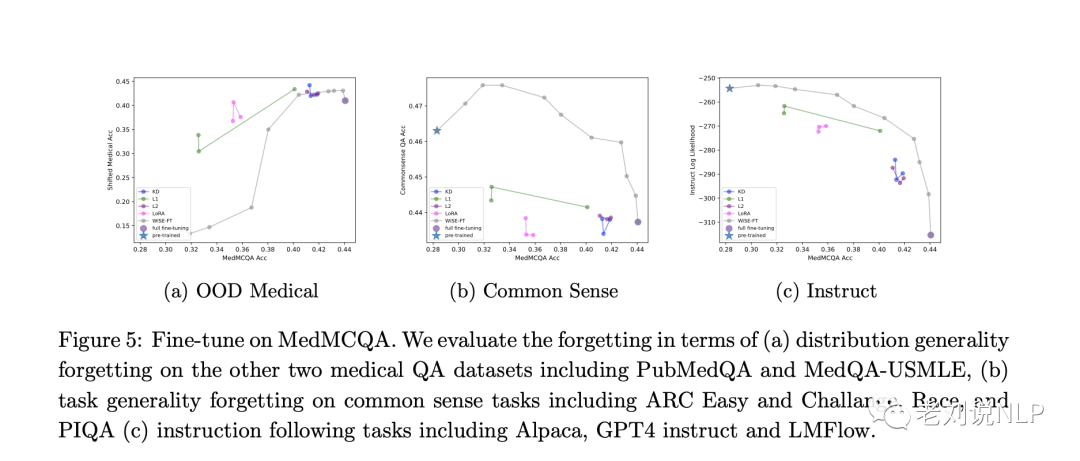

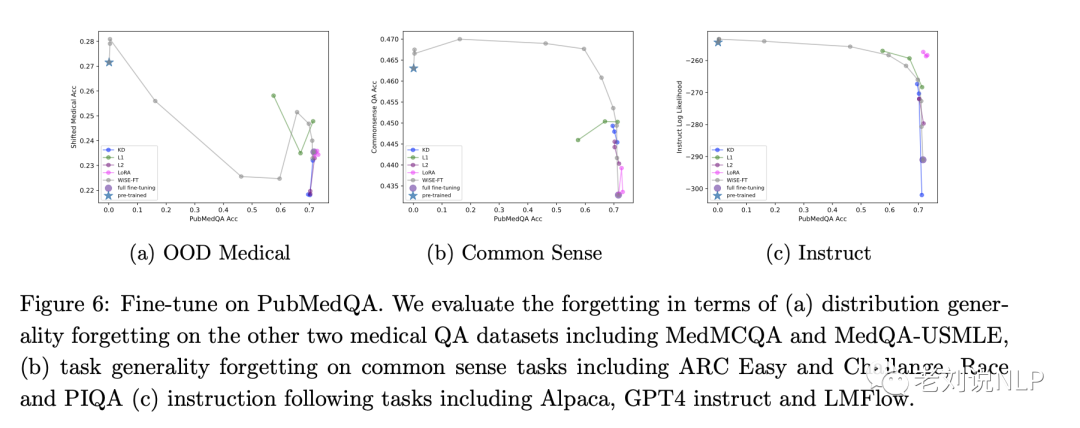

图5和图6分别显示了在MedMcQA和PubMedQA上微调Galactica的结果。

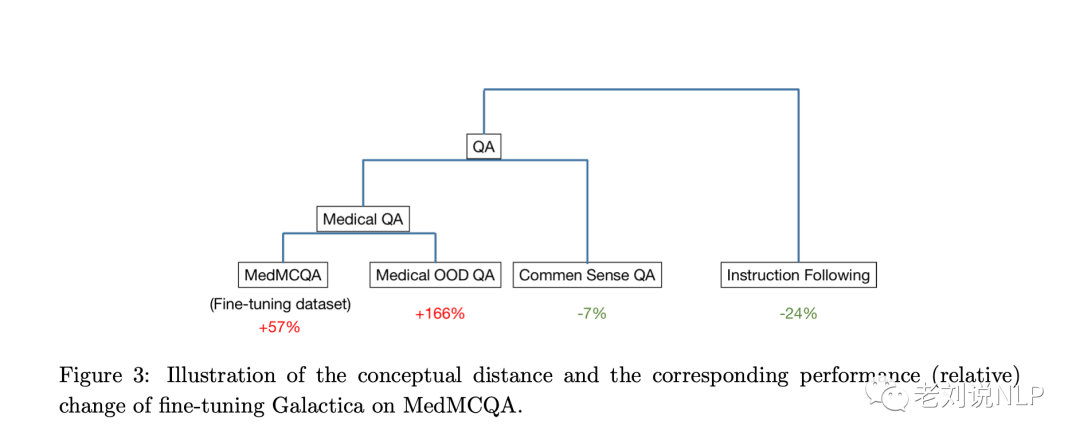

1)概念距离越大,遗忘越严重。

图5(a)-(c)中的结果表明,概念距离越大,LLM的遗忘越严重。

在图5(a)中,概念距离最小的任务(OOD医学测试)没有出现遗忘,这表明LLM在概念相似的任务中保持了其性能。

图5(c)显示,在概念距离最大的任务(指令遵循)中出现了明显的遗忘(降幅超过20%)。这表明,LLM在与微调任务概念距离较远的任务上表现得更为吃力。

在常识QA任务上,在遗忘方面,常识质量保证任务介于OOD医疗任务和指令跟随任务之间,这表明,LLM的遗忘行为受到微调任务(MedMCQA)与其他任务之间概念距离的影响。与MedMCQA概念较近的任务遗忘较少,而概念距离较大的任务则更容易遗忘。

2)模型平均法可以取得很好的效果

例如,图5(c)显示,使用α=0.3的Wise-ft可以有效提高对数似然(LL)得分,将其提高到-270分以上,即使微调数据集上的性能保持相对不变。

同样,在图6(c)中,α=0.3的Wise-ft将LL得分从大约-290提高到大约-270。

3)LoRA的有效性取决于任务的低秩结构

LoRA的性能因在MedMCQA或PubMedQA上进行微调而有显著差异。

在PubMedQA上进行微调时,LoRA在指令跟随遗忘方面表现出明显的缓解,甚至超过Wise-ft的表现(如图6(C))。

然而,与Wise-ft和其他方法相比,LoRA在MedMCQA上的表现较差(如图5(C))。

LoRA在PubMedQA和MedMCQA上的表现有一个明显的区别,那就是LoRA在PubMedQA的微调数据集上很容易就能达到相当的表现。然而,在MedMCQA上进行微调时,LoRA在微调数据集上的性能明显低于完全微调。

PubMedQA上的微调可能具有更好的低秩结构,使得LoRA更容易适应微调任务。另一方面,MedMCQA对LoRA的适应性来说更具挑战性,这导致低秩矩阵的幅度更大,从而导致更显著的遗忘。

3)与vanilla完全微调相比,L1、L2和KD惩罚显示出可以缓解遗忘的能力

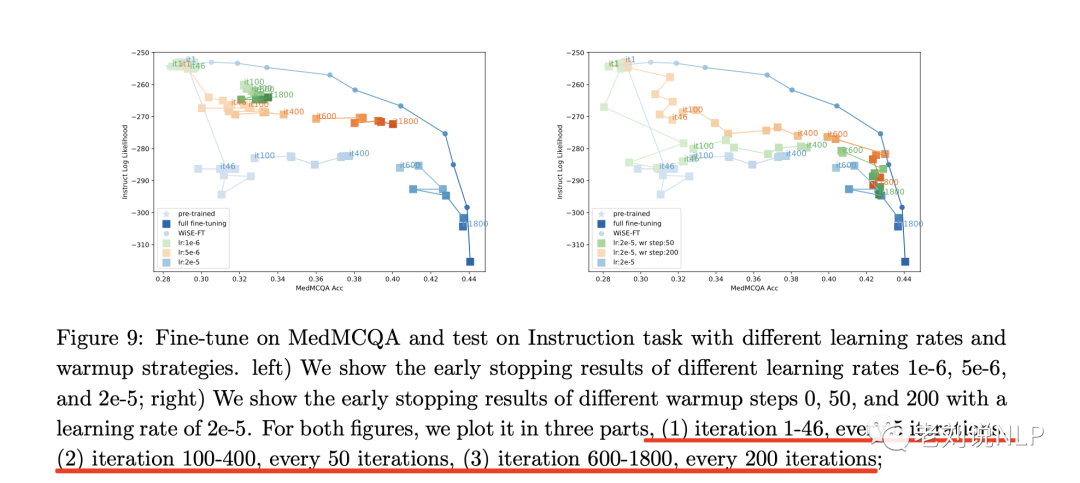

4)早期停止遗忘的性能对学习率很敏感

在大多数深度学习任务中,早期停止是防止训练过拟合的有效方法。

为了分析早期停止如何影响大型语言模型中的遗忘,该工作进行了不同学习率和不同热身步骤的实验。

对于每种设置分三部分绘制:(1)迭代1-46,每5次迭代;(2)迭代100-400,每50次迭代;(3)迭代600-1800,每200次迭代。

如图上图所示,早期停止遗忘的性能对学习率很敏感。

当使用较大的学习率2e-5进行训练时,模型在MedMCQA数据集上的准确率较高,而在指令任务上的准确率则迅速下降,这表明存在明显的遗忘。

当使用较低的学习率(如1e-6和5e-6)时,遗忘现象会明显缓解,但域内准确率也会降低。

5)热身可以帮助解决一开始的灾难性遗忘

在MedMCQA数据集上也能达到很高的准确率。随着热身步骤的变化,热身只影响微调开始时的性能,而不影响最终结果。

二、RAG检索式生成综述

《A Survey on Retrieval-Augmented Text Generation》

地址:https://arxiv.org/abs/2202.01110

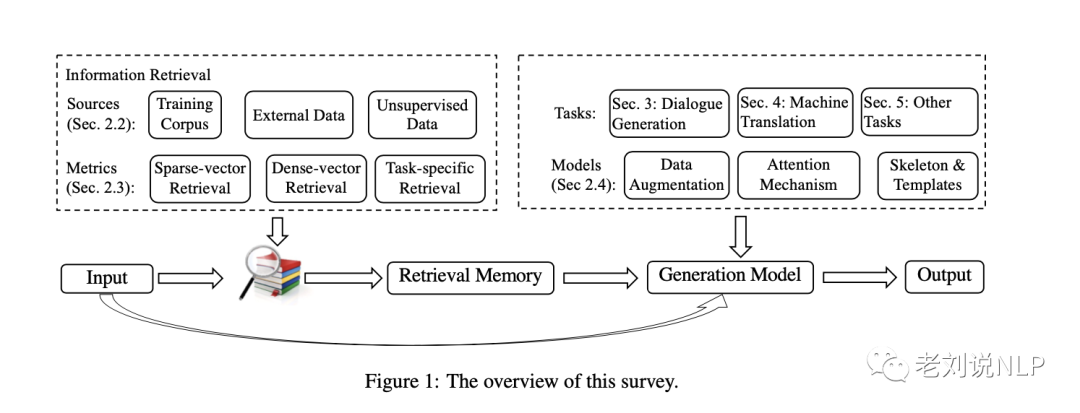

该工作旨在对检索增强文本生成进行研究。主要核心的点如下:

1、Retrieval Source知识来源源

训练语料:有标注的训练数据直接作为外部知识;

外部数据:支持提供训练数据之外的外部知识作为检索来源,比如于任务相关的领域数据,实现模型的快速适应;

无监督数据:前两种知识源都需要一定的人工标注来完善“检索依据-输出”的对齐工作,无监督知识源可以直接支持无标注/对齐的知识作为检索来源;

2、Retrieval Metrics召回的度量标准

浅层语义检索:针对稀疏向量场景的度量方法,比如TF-IDF, BM25等;

深层语义检索: 针对稠密向量的度量方法,比如文本相似度;

特定任务检索:在通用的度量场景下,度量得分高并不能代表召回知识准确,因此有学者提出基于特定任务优化的召回度量方法,提高度量的准确率;

3、Integration集成的方法

数据增强:直接拼接用户输入文本和知识文本,然后输入文本生成模型;

注意力机制:引入额外的Encoder,对用户输入文本和知识文本进行注意力编码后输入文本生成模型;

架抽取:前两种方法都是通过文本向量化的隐式方法完成知识重点片段的抽取,skeleton extraction方法可以显式地完成类似工作;

该工作针对后续优化方向提出了一些观点,认为:

RATG效果强依赖于召回知识的准确率,这个问题在query和目标知识片段的文本相似度较低的情况尤为突出;

需要做好存储的容量和召回效率之间的平衡;

逻辑上,召回度量模块和文本生成模块的联合训练会有更好的效果;但是在这样的框架下,其训练和预测之间会存在较大的Gap:训练时,模型只针对少量标注的知识源完成优化(Local);而预测时,模型是针对大量的知识源完成度量(Global);

此外,针对目前都基于通用的文本语义完成知识召回,后续可以考虑关注基于任务层级的召回方法的多样化研究,以及不同召回方法的调用的灵活性和可控制性,针对多模态知识源召回方法的优化;

三、Agent智能体综述

《the Rise and Potential of Large Language Model Based Agents: A Survey》

地址:https://arxiv.org/pdf/2309.07864

该工作梳理了基于LLM智体的概念框架,包括三个主要组成部分:大脑,感知和动作,并从单智体场景、多智体场景和人-智体相互协作等三个方面探讨了基于LLM智体的广泛应用。

对应的agent的一些工作汇总列表如下:https://github.com/WooooDyy/LLM-Agent-Paper-List。

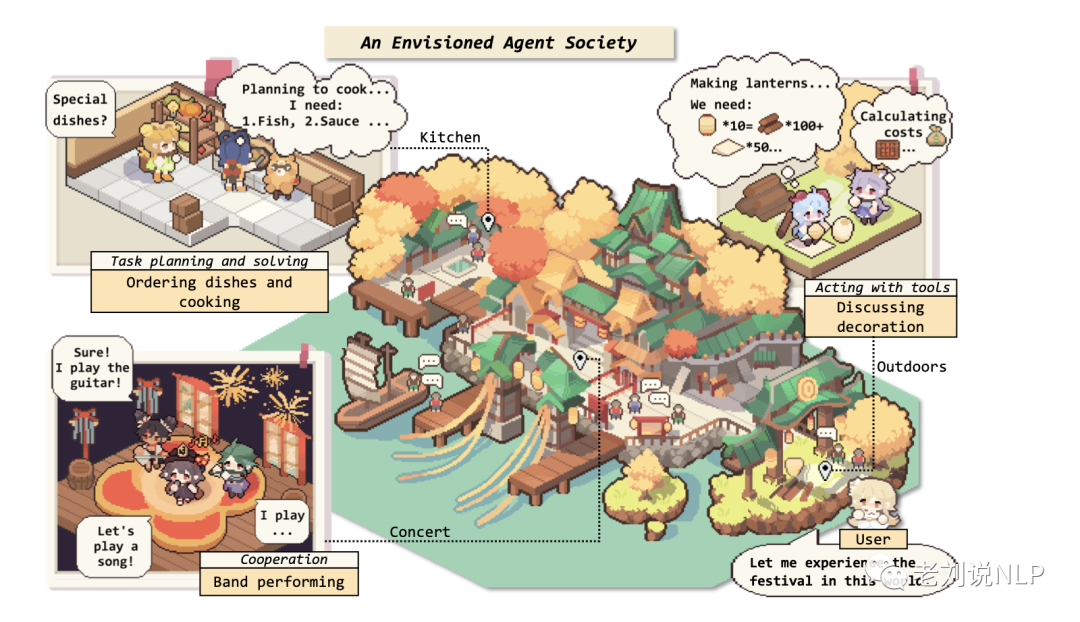

1、什么是智能体

如上图所示,在厨房里,一个智能体正在订购菜肴,另一个智体是负责规划和解决烹饪任务。在音乐会上,三位智体正在合作组成乐队表演。在户外,两个智体正在讨论灯笼制作,通过选择和使用工具来规划所需的材料和资金。用户可以参与此社交活动的任何阶段。

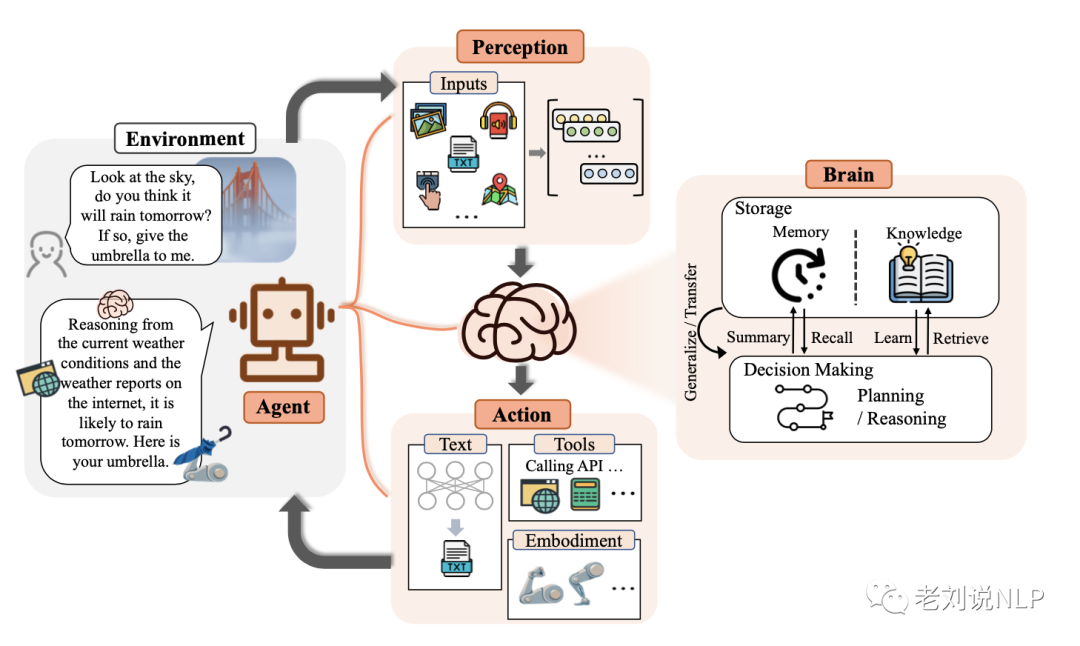

2、智能体的构成

如图是基于LLM智体的概念框架,具有三个组成部分:大脑,感知和动作。

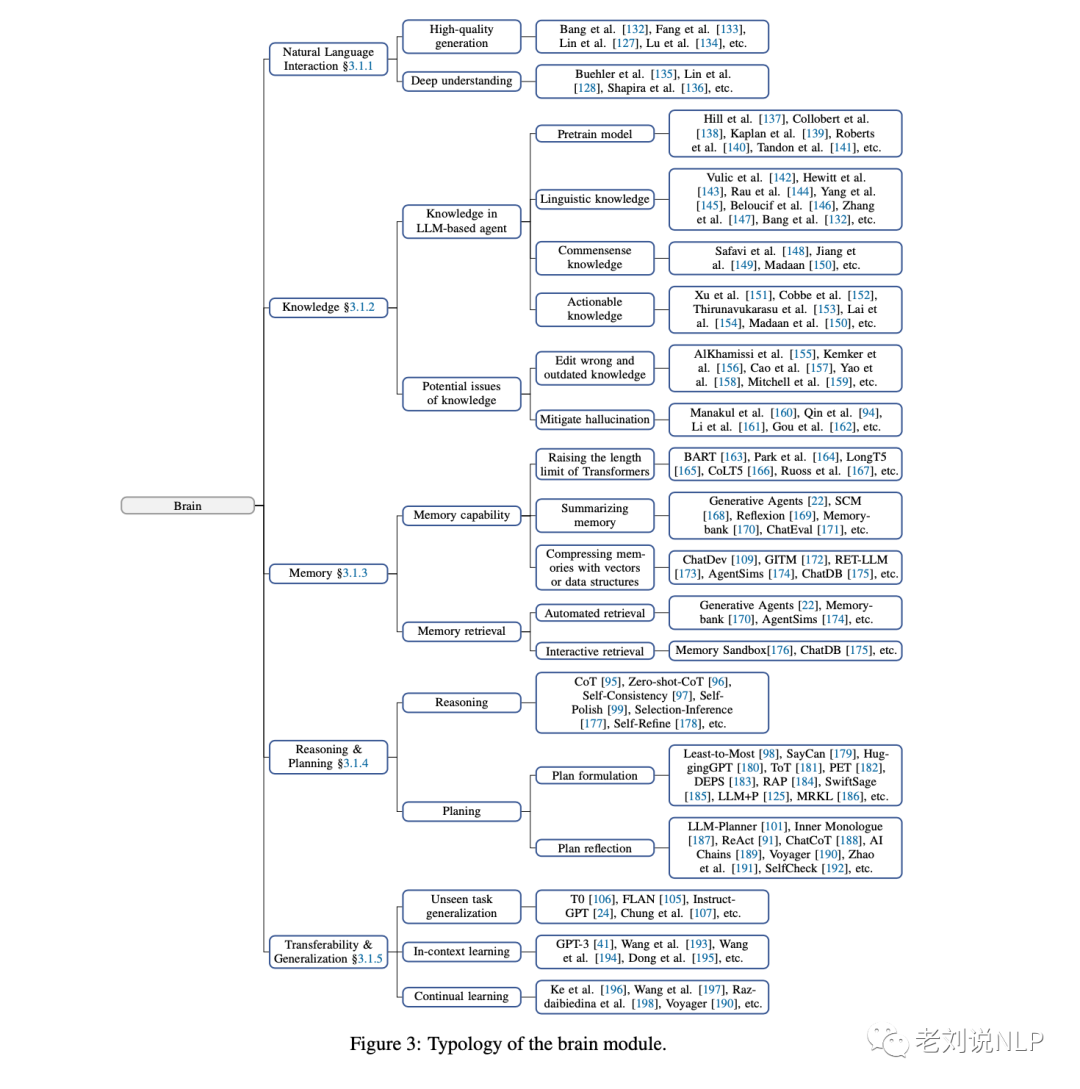

作为控制器,大脑模块承担基本任务,如记忆、思考和决策,对应的类别以及分类做了整理,如下所示:

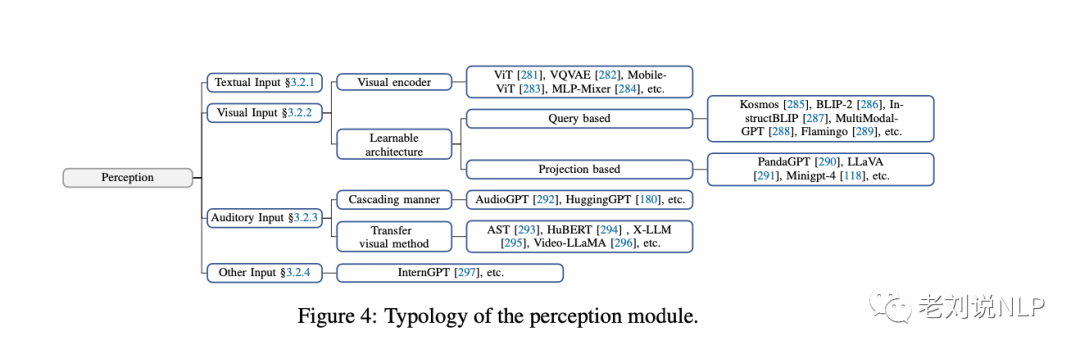

感知模块感知和处理来自外部环境的多模态信息,动作模块用工具执行并影响周围环境。

例如,这当一个人问是否会下雨时,感知模块将指令转换为LLM的可理解表示;然后大脑模块开始根据当前的天气和互联网上的天气报告进行推理其输入的类别整理如下:

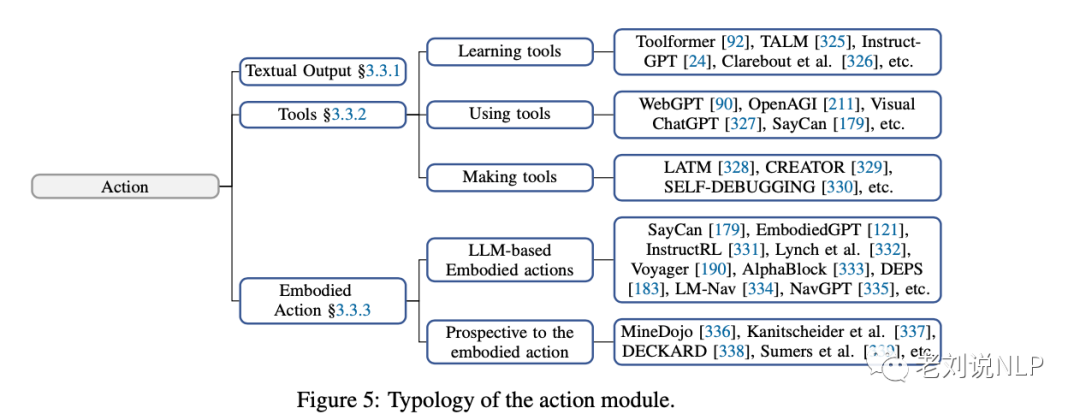

最后,动作模块做出回复,具体的动作可以分为多种类型,包括文本输出,使用工具以及具身操作,对应的工作如下:

重复上述过程,智体可以不断获得反馈并与环境进行交互。

四、关于大模型幻觉的综述

实际上,这已经是我们看到的第三篇关于大模型幻觉的综述文章,前几篇可以看到之前的记录。

《A Survey of Hallucination in “Large” Foundation Models》

地址:https://arxiv.org/pdf/2309.05922

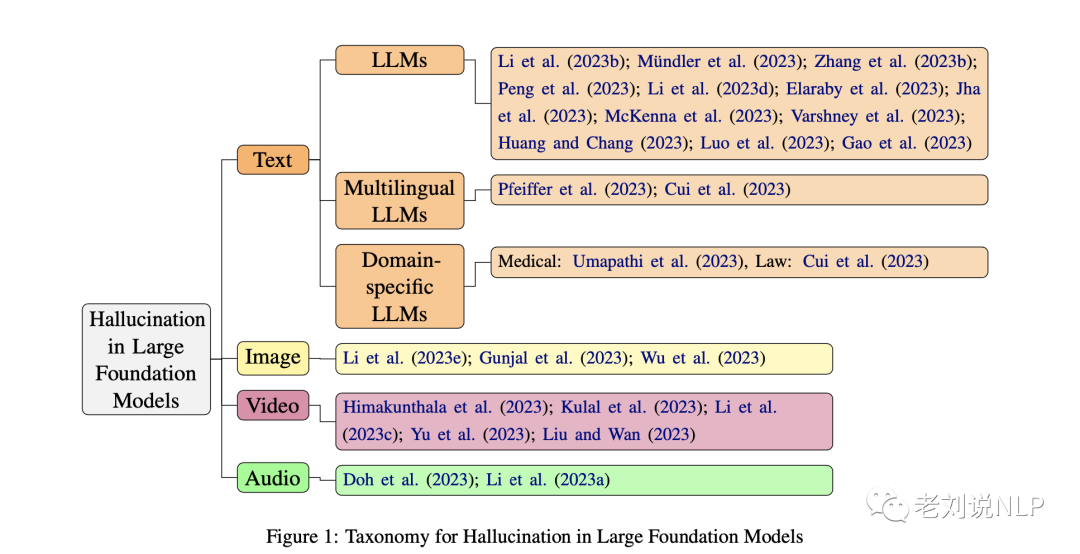

这篇论文主要对大模型中的幻觉现象进行了研究,对大模型中常见的幻觉现象进行了分类,并建立了评估标准。同时,论文还探讨了现有缓解幻觉的方法,并指出了未来研究的方向。

其对于文本幻觉探索的相关工作进行归类:

该利用策划的知识源改进检测和缓解策略,包括:

知识图谱集成:将知识图谱和精心策划的知识库纳入人工智能模型,可以增强它们对事实信息和概念之间关系的理解。这有助于内容生成和事实检查。

事实检查和验证模型:开发专注于事实检查和内容验证的专门模型。这些模型可以使用经过整理的知识源来交叉参考生成的内容,并识别不准确或不一致之处。

偏见检测与缓解:经过整理的知识源可用于训练人工智能模型,以识别和减少生成内容中的偏差。可对人工智能系统进行编程,以检查内容是否存在潜在偏见,并提出更平衡的替代方案。

主动学习:通过主动学习,不断更新和重新完善策划的知识源。可以设计人工智能系统,以寻求人类对模棱两可或新信息的输入和验证,从而提高策划知识的质量。

伦理准则与监管:未来的行动还可能涉及为人工智能开发中使用策划的知识源制定伦理准则和监管框架。这可以确保以负责任和透明的方式使用经过整理的知识,从而降低潜在风险。

总结

本文主要介绍了最近的几个工作,包括大模型微调遗忘问题、RAG检索式生成综述、三、Agent智能体综述以及关于大模型幻觉的综述,这些工作都是当前大模型研究何落地的热点。

感兴趣的可以看看原文,做更多的思考。

参考文献

1、https://arxiv.org/pdf/2309.06256.pdf

2、https://arxiv.org/abs/2202.01110

3、https://arxiv.org/pdf/2309.07864

4、https://arxiv.org/pdf/2309.05922

关于我们

老刘,刘焕勇,NLP开源爱好者与践行者,主页:https://liuhuanyong.github.io。

老刘说NLP,将定期发布语言资源、工程实践、技术总结等内容,欢迎关注。

对于想加入更优质的知识图谱、事件图谱、大模型AIGC实践、相关分享的,可关注公众号,在后台菜单栏中点击会员社区->会员入群加入。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง