《Optimizing LLMs from a Dataset Perspective – Lightning AI》

聚焦通过精心准备的数据集来提高大模型的性能,而不是改变模型架构或训练算法。

教学微调使用包含指令-响应对的数据集来提高大模型遵循指令的能力。数据集可以由人工创建或大模型生成。高质量的数据集如LIMA显示出质量大于数量,只使用1K条指令对就能优化Llama性能。

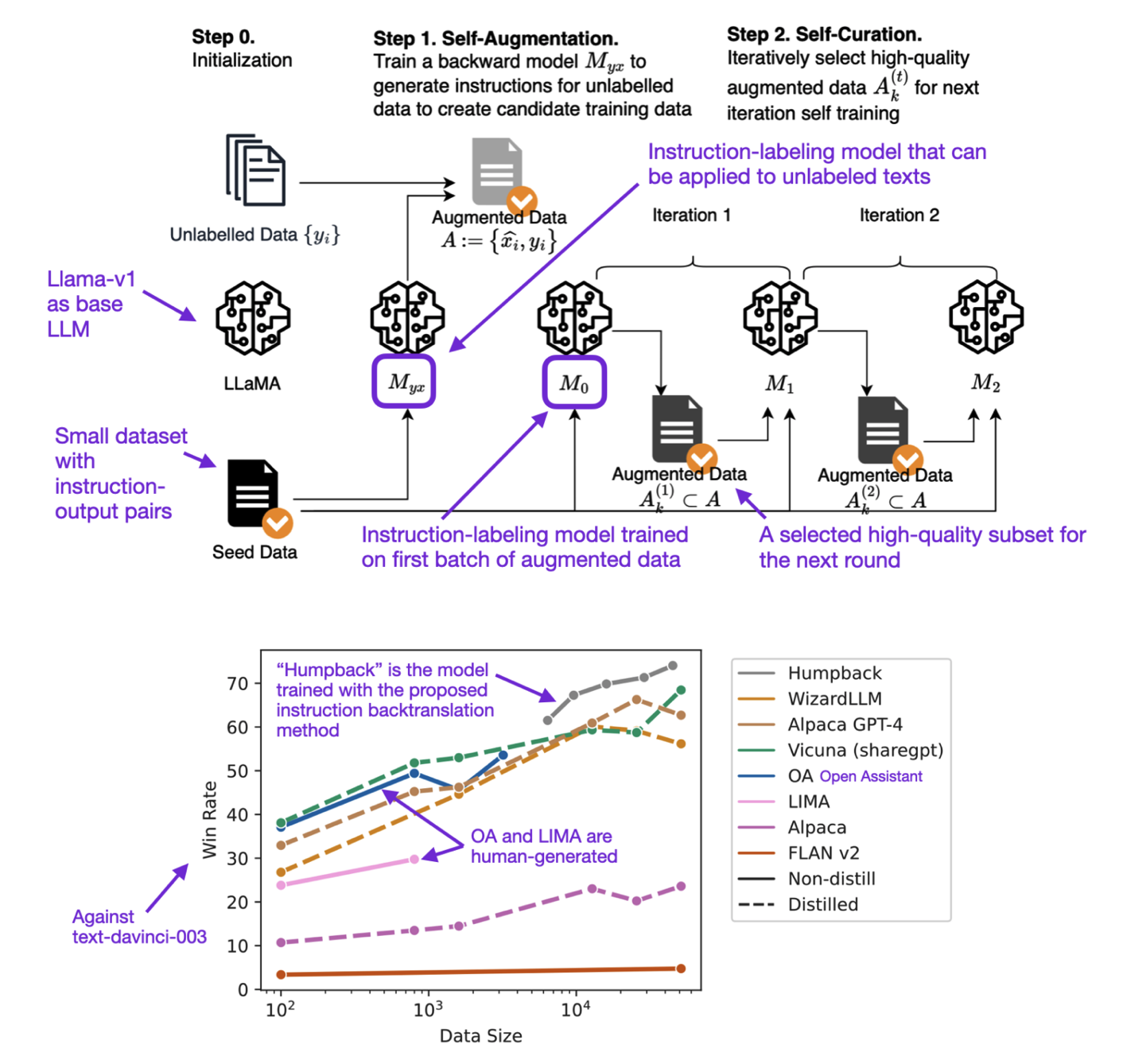

除人工创建,还可以使用反向翻译的技术,从响应反向生成对应的指令。

准备自定义数据集的两种主要方法是从CSV文件读取以及编写类似LIMA的prepare脚本。

一些可考虑的研究方向包括:数据集合并、数据集顺序、多轮训练、自动质量过滤等。

详细介绍了如何使用Lit-GPT库微调开源LLM模型,以及一些可用的模型和数据集。

精心准备小规模高质量数据集可能会比大规模数据集带来更好的微调效果。

https://lightning.ai/pages/community/tutorial/optimizing-llms-from-a-dataset-perspective/

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง