Language Modeling Is Compression

G Delétang, A Ruoss, P Duquenne, E Catt, T Genewein, C Mattern, J Grau-Moya, L K Wenliang, M Aitchison, L Orseau, M Hutter, J Veness

[Google DeepMind]

语言建模即压缩

要点:

-

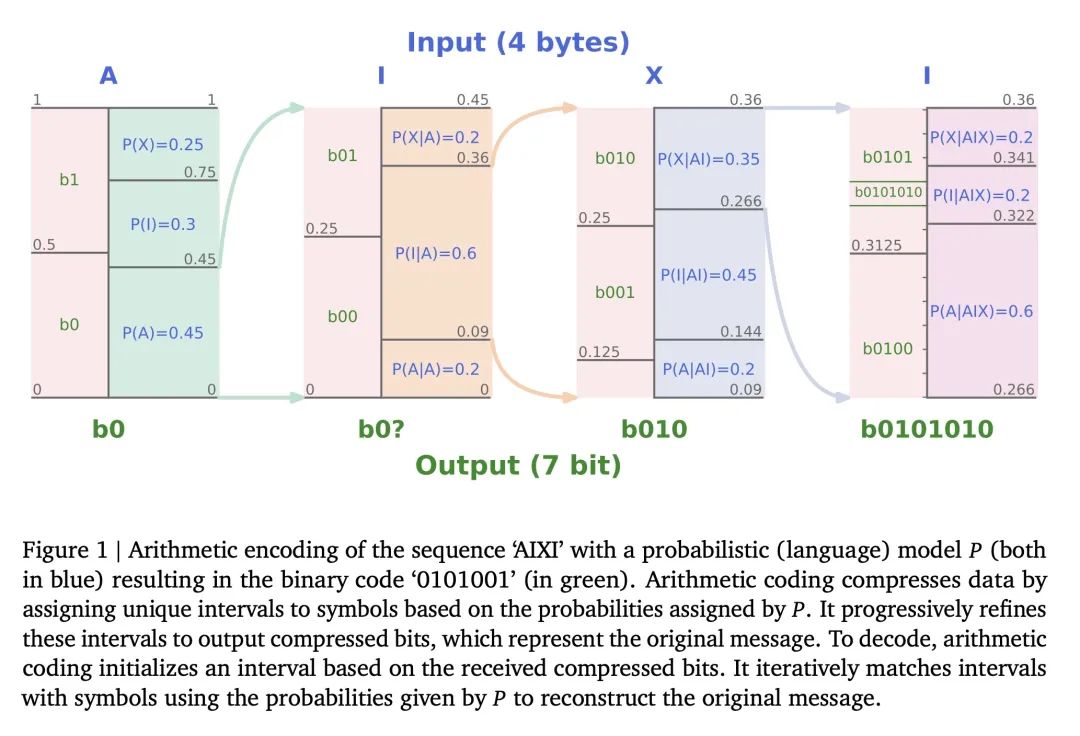

预测概率模型和无损压缩算法(如算术编码)之间存在等价关系,最大化模型对数似然等价于利用该模型进行数据压缩时最小化所需比特数。

-

巨大的预训练语言模型如GPT-3展现了强大的预测能力,与算术编码组合可以成为强大的通用压缩器。

-

通过实验证明了Chinchilla等模型的压缩性能。尽管主要在文本上训练,Chinchilla却能比专门的压缩算法PNG和FLAC更好地压缩图像和音频,展现了大模型的上下文学习能力。

-

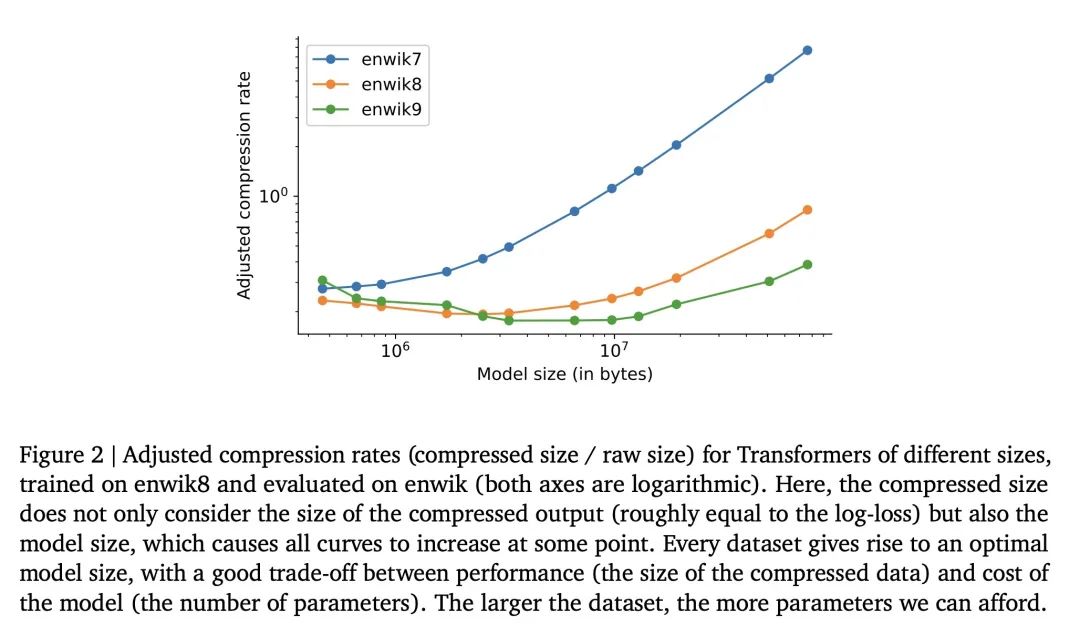

压缩性能为模型扩展律提供了新视角,与对数损失不同,压缩考虑了模型大小,所以更大的模型不一定压缩得更好,模型大小与数据集大小之间存在权衡。

-

标记化是一种压缩形式,允许在上下文中打包更多信息,但不会提高最终压缩率。

-

通过对代码长度采样,任何压缩算法都可以作为条件生成模型,文中通过文本、图像和音频数据可视化了这一点。

动机:探讨语言模型与压缩之间的关系,评估大型语言模型的压缩能力。

方法:使用大型自监督(语言)模型来进行压缩,并通过评估其在不同数据模态上的压缩率来展示其压缩能力。

优势:大型语言模型展现了强大的通用预测能力,并且能在压缩任务中取得出色的结果。

通过将预测问题视为压缩问题,评估大型语言模型的压缩能力,提供了对于缩放律、分词和上下文学习的新见解,同时突出了大型语言模型在压缩任务中的优越性能。

https://arxiv.org/abs/2309.10668

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง