导读 本文主题为打造适合用户增长场景的 AB 实验体系。文章将介绍新用户场景下实验面临的问题,以及一种新的实验体系,并结合实际案例介绍新实验体系的应用。全文目录:1. 新用户场景下实验面临的问题

2. 新实验体系及其科学性验证

3. 新实验体系应用案例分享4. 总结分享嘉宾|田间 Colin 字节跳动 Data Scientist

编辑整理|river

内容校对|李瑶

出品社区|DataFun01新用户场景下实验面临的问题

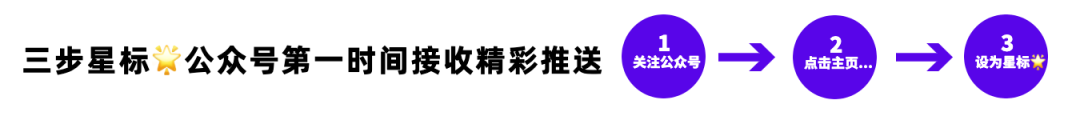

1. UG全景图

这是 UG 的全景图。 UG 通过渠道,比如 Paid Ads、 ASO、SEO 等渠道,获客引流到 APP。接下来,会做一些新手的运营和引导,来促活用户,使其进入成熟期。后续用户可能会慢慢地失活,进入衰退期,甚至进入流失期。在这期间会做一些流失的预警,促活的召回,后面还有一些对流失用户的召回。

UG 通过渠道,比如 Paid Ads、 ASO、SEO 等渠道,获客引流到 APP。接下来,会做一些新手的运营和引导,来促活用户,使其进入成熟期。后续用户可能会慢慢地失活,进入衰退期,甚至进入流失期。在这期间会做一些流失的预警,促活的召回,后面还有一些对流失用户的召回。

可以概括为上图中的公式, 即 DAU 等于 DNU 乘上 LT。UG 场景下的所有工作都可以基于这一公式来拆解。

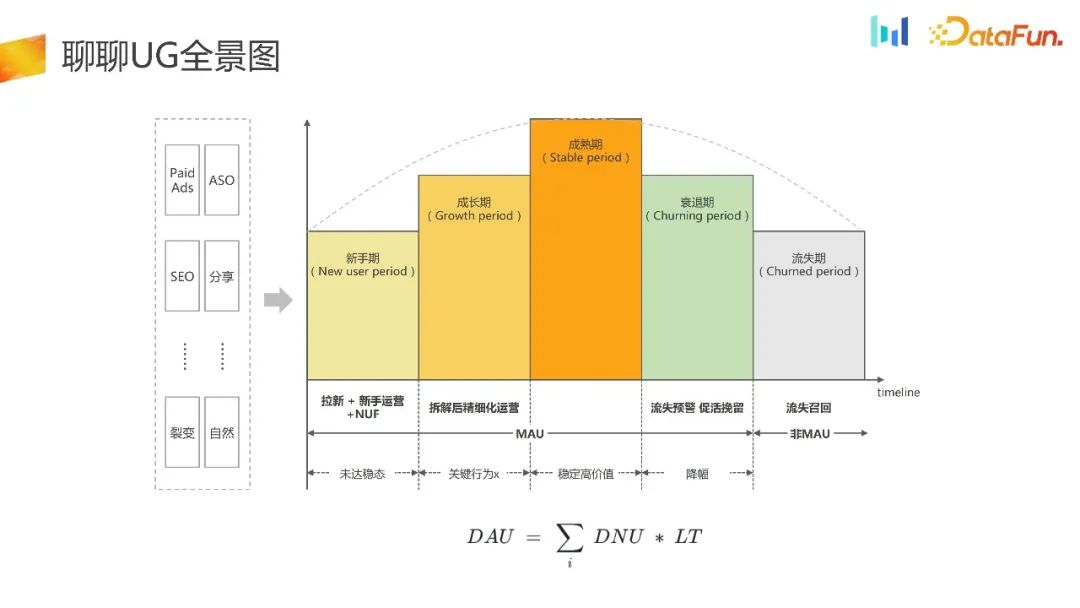

2. AB实验原理

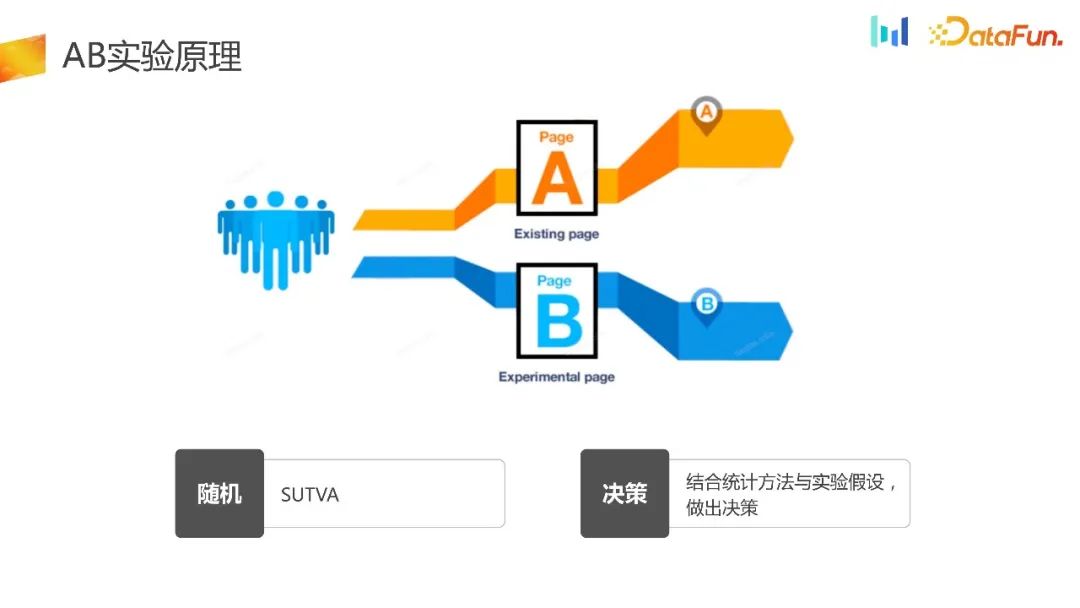

AB 实验是要对流量进行完全的随机,对于实验组和不同和对照组,给予不同的策略。最后结合统计的方法和实验的假设做出科学的决策,这就是整个实验的架构。现有市面上的实验分流的类型,大概分为两种:实验平台分流和客户端本地分流。

AB 实验是要对流量进行完全的随机,对于实验组和不同和对照组,给予不同的策略。最后结合统计的方法和实验的假设做出科学的决策,这就是整个实验的架构。现有市面上的实验分流的类型,大概分为两种:实验平台分流和客户端本地分流。 实验平台分流是有前提的,需要设备完成初始化以后能获取到稳定的 ID,基于这个 ID 向实验平台请求实验平台完成分流相关的逻辑,把分流 ID 返回给端上,然后端上基于收到的 ID 做相应的策略。它的优点是有一个实验平台,能够保证分流的均匀性和稳定性。它的缺点是设备必须完成初始化以后才能进行实验分流。

实验平台分流是有前提的,需要设备完成初始化以后能获取到稳定的 ID,基于这个 ID 向实验平台请求实验平台完成分流相关的逻辑,把分流 ID 返回给端上,然后端上基于收到的 ID 做相应的策略。它的优点是有一个实验平台,能够保证分流的均匀性和稳定性。它的缺点是设备必须完成初始化以后才能进行实验分流。

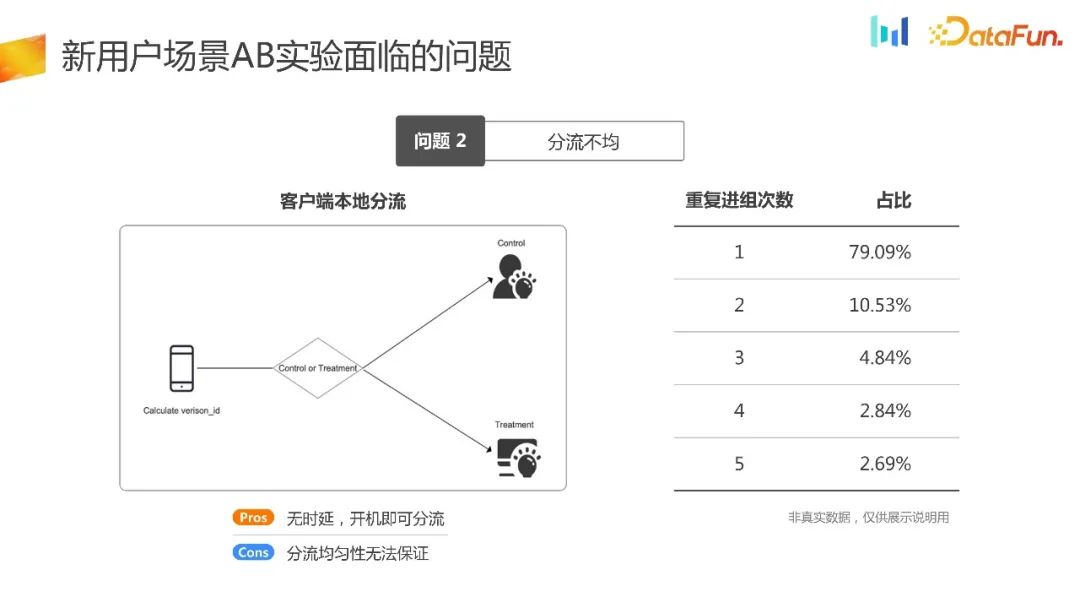

另外一种分流是客户端本地分流,这种场景相对来说会比较小众一点,主要是在一些 UG 的场景,广告开屏的场景,以及一些性能的初始化场景。这里所有的分流逻辑都是在端初始化时完成的,其优点很明显,就是无时延,开机即可分流。从逻辑上来讲,其分流均匀性也是能够得到保证的。但是在实际的业务场景上,它的分流均匀性常常存在问题。后面会介绍其原因。

3. 新用户场景AB实验面临的问题

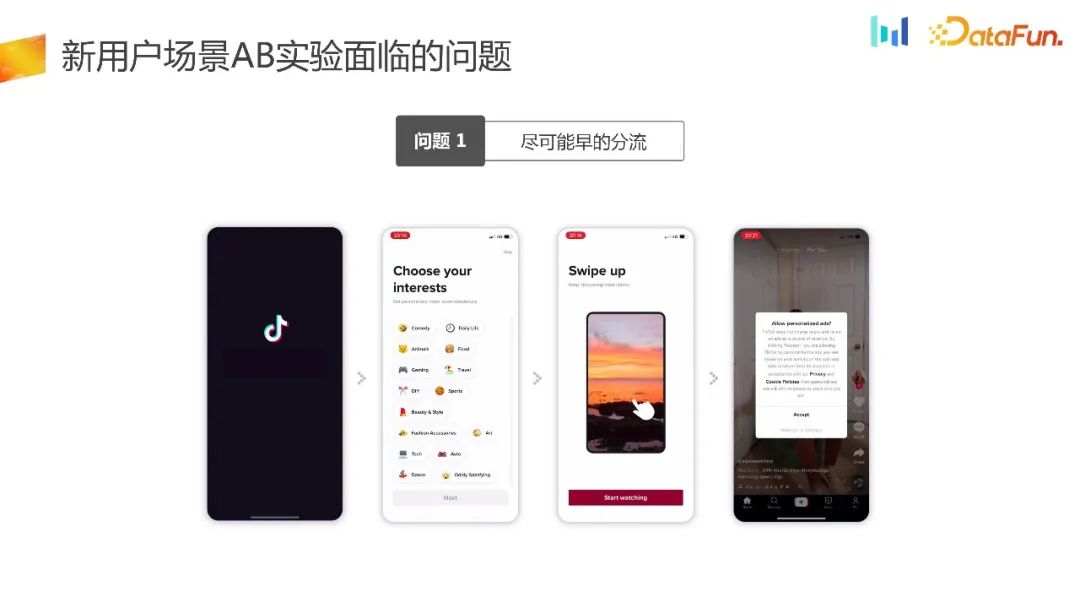

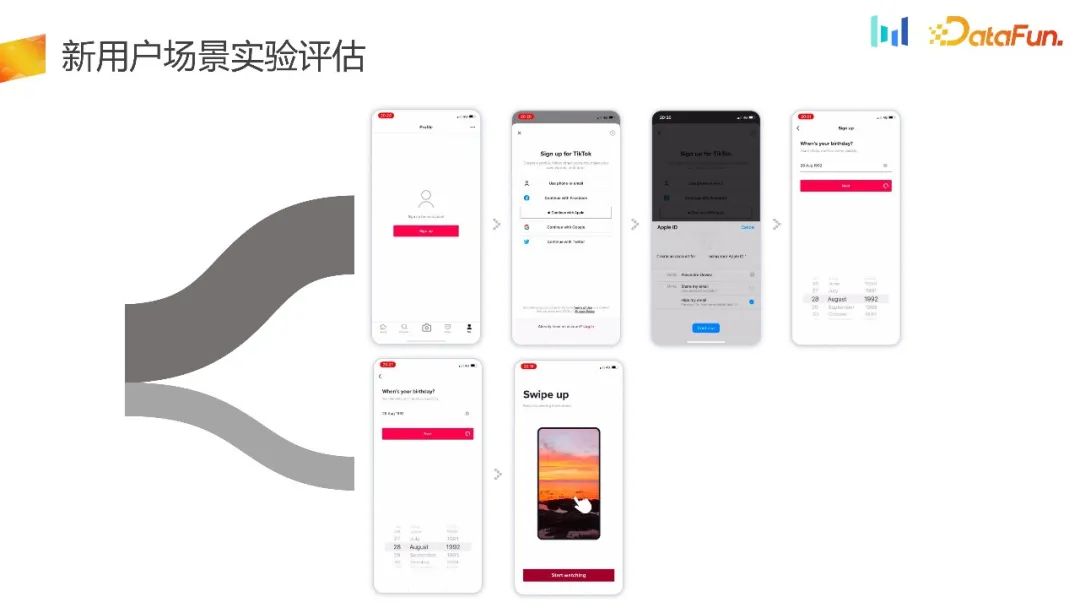

UG 场景实际面临的第一个问题是尽可能早的分流。  这里举个例子,比如这里的流量承接页面,产品经理觉得 UI 可以再优化一下,进而提升核心指标。在这样的场景下,我们希望实验尽早地进行分流。

这里举个例子,比如这里的流量承接页面,产品经理觉得 UI 可以再优化一下,进而提升核心指标。在这样的场景下,我们希望实验尽早地进行分流。  在页面 1 的分流,是在分流时设备完成初始化并获取 ID,有 18.62% 的用户是没有产生 ID 的。如果用传统的实验平台的分流方式,会有 18. 62% 的用户是不能被分组的,先天性会出现选择偏差的问题。

在页面 1 的分流,是在分流时设备完成初始化并获取 ID,有 18.62% 的用户是没有产生 ID 的。如果用传统的实验平台的分流方式,会有 18. 62% 的用户是不能被分组的,先天性会出现选择偏差的问题。

另外,新用户的流量是非常宝贵的,有 18. 62% 的新用户不能被用于实验,对于实验的时长和流量利用效率也是有很大损失的。 未来解决实验尽可能早的分流的问题,我们就会用客户端本地分流实验。其优点是在设备初始化的时候,就完成了分流。其原理为,首先是在端上面初始化的时候,它本身就可以生成随机数,对随机数进行哈希以后进行同样的分组,进而产生了实验组和对照组。从原理上看,应该能够保证分流是均匀的,但通过上图中的一组数据会发现,有超过 21% 的用户是重复进到不同的组的。

未来解决实验尽可能早的分流的问题,我们就会用客户端本地分流实验。其优点是在设备初始化的时候,就完成了分流。其原理为,首先是在端上面初始化的时候,它本身就可以生成随机数,对随机数进行哈希以后进行同样的分组,进而产生了实验组和对照组。从原理上看,应该能够保证分流是均匀的,但通过上图中的一组数据会发现,有超过 21% 的用户是重复进到不同的组的。 有一种场景是,一些很受欢迎的产品,比如王者荣耀或者抖音,用户很容易上瘾。新用户在实验周期里面会有多次的卸载重装。按照刚刚讲的本地分流的逻辑,随机数的产生和分流以后会让用户进入不同的组,这样就会出现分流的 ID 和统计 ID 不能一对一匹配。造成了分流不均匀的问题。

有一种场景是,一些很受欢迎的产品,比如王者荣耀或者抖音,用户很容易上瘾。新用户在实验周期里面会有多次的卸载重装。按照刚刚讲的本地分流的逻辑,随机数的产生和分流以后会让用户进入不同的组,这样就会出现分流的 ID 和统计 ID 不能一对一匹配。造成了分流不均匀的问题。  在新用户场景下,我们还面临着实验评估标准的问题。

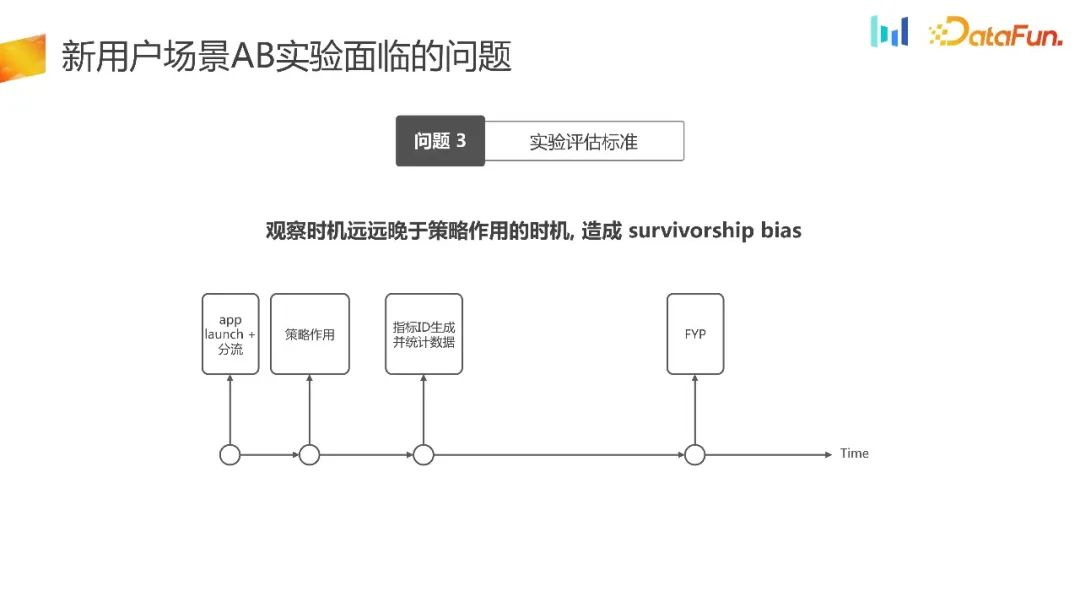

在新用户场景下,我们还面临着实验评估标准的问题。

我们梳理了新用户流量承接这一场景的时间图。APP launch 的时候,选择了分流。假设分流时机能够做到这个,而且是均匀的,同时就有相应的策略产生作用。接下来指标统计 ID 的生成是晚于策略作用的时机的,在这时才能观测到数据。数据观测的时机远远落后于策略作用的时机,就会造成幸存者偏差。

02新实验体系及其科学性验证为了解决上述问题,我们提出了新的实验体系,并对其科学性进行了验证。

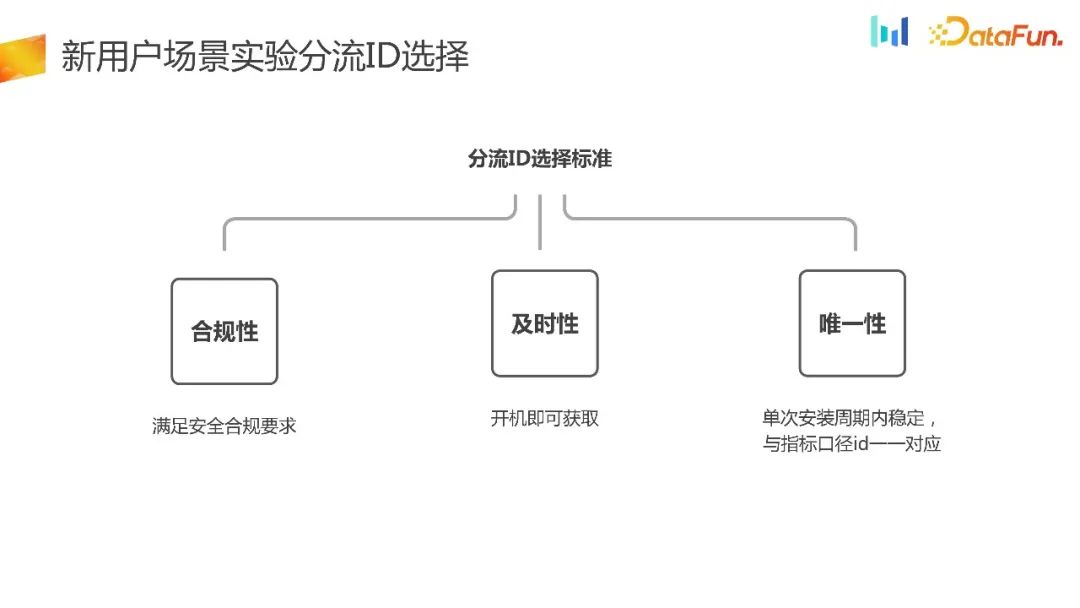

1. 新用户场景实验分流ID选择  前面已经讲到了新用户实验对于新用户的分流选择要求会比较高,如何选择新用户实验分流 ID 呢?有以下几个原则:

前面已经讲到了新用户实验对于新用户的分流选择要求会比较高,如何选择新用户实验分流 ID 呢?有以下几个原则:

- 合规性,不管是海外业务还是国内业务,安全合规首先是生命线,一定要满足安全合规,否则一旦被下架影响会特别大。

- 及时性,对于新用户场景,一定是要及时,开机即可获取分流。

- 唯一性,在单次安装周期内,分流的 ID 是稳定的,同时跟指标口径 ID 能形成一一对应的关系。通过下图中的数据可以看到,分流 ID 和指标计算口径 ID 一对一的匹配比例达到了 99.79%,指标计算 ID 和分流 ID 的一对一比例也达到了 99. 59%。基本上可以验证,按照标准选择的分流 ID 和指标 ID 是能够做到一对应匹配的。

2. 分流能力科学性验证

2. 分流能力科学性验证

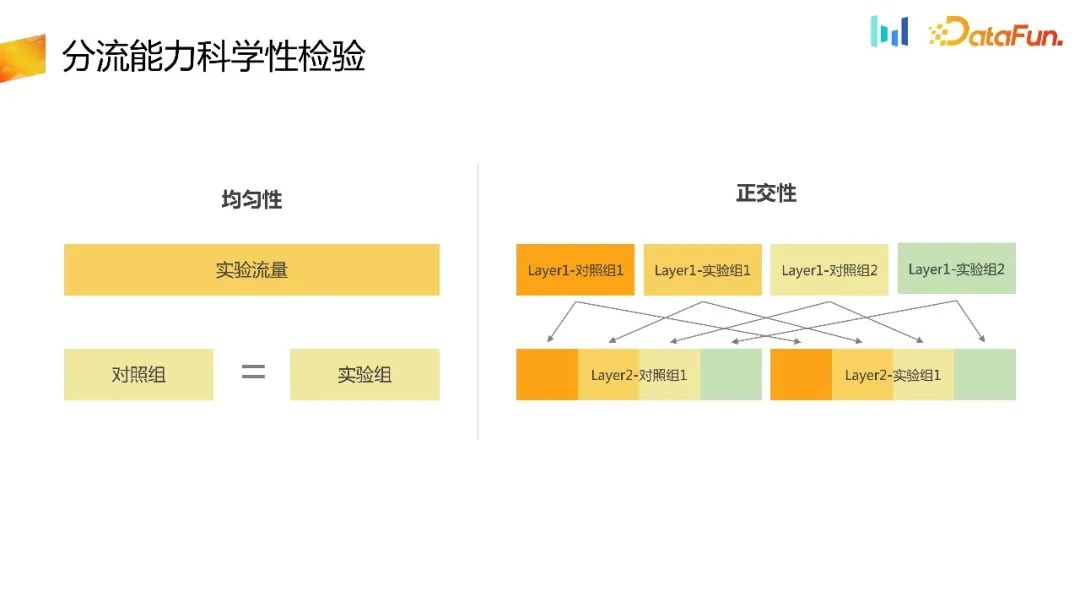

选择好分流 ID 以后,分流能力往往是通过两种方式,第一种是通过实验平台,第二种是通过端上完成。  有了分流的 ID 以后,把分流 ID 提供给实验平台,在实验平台里完成分流的能力。作为分流平台,最基本的是需要验证它的随机性。首先就是均匀性。在同一层实验里面,把流量均匀地分到了很多个分桶,每个分桶进组的数量应该是均匀的。在这里可以简化一下,假如一层只有一个实验,分成 a、 b 两组,进组的对照组和实验组的用户数应该是近似相等的,进而验证分流能力的均匀性。其次,对于多层实验,多层实验之间应该是相互正交,不受影响的,同理这里也需要去验证不同层实验之间的正交性。可以通过统计学上的 category test 去验证均匀性和正交性。 介绍完分流选择的 ID 和分流的能力,最后要从指标结果层面去验证新提出来的分流结果,是否符合 AB 实验的要求。

有了分流的 ID 以后,把分流 ID 提供给实验平台,在实验平台里完成分流的能力。作为分流平台,最基本的是需要验证它的随机性。首先就是均匀性。在同一层实验里面,把流量均匀地分到了很多个分桶,每个分桶进组的数量应该是均匀的。在这里可以简化一下,假如一层只有一个实验,分成 a、 b 两组,进组的对照组和实验组的用户数应该是近似相等的,进而验证分流能力的均匀性。其次,对于多层实验,多层实验之间应该是相互正交,不受影响的,同理这里也需要去验证不同层实验之间的正交性。可以通过统计学上的 category test 去验证均匀性和正交性。 介绍完分流选择的 ID 和分流的能力,最后要从指标结果层面去验证新提出来的分流结果,是否符合 AB 实验的要求。

3. 分流结果科学性验证

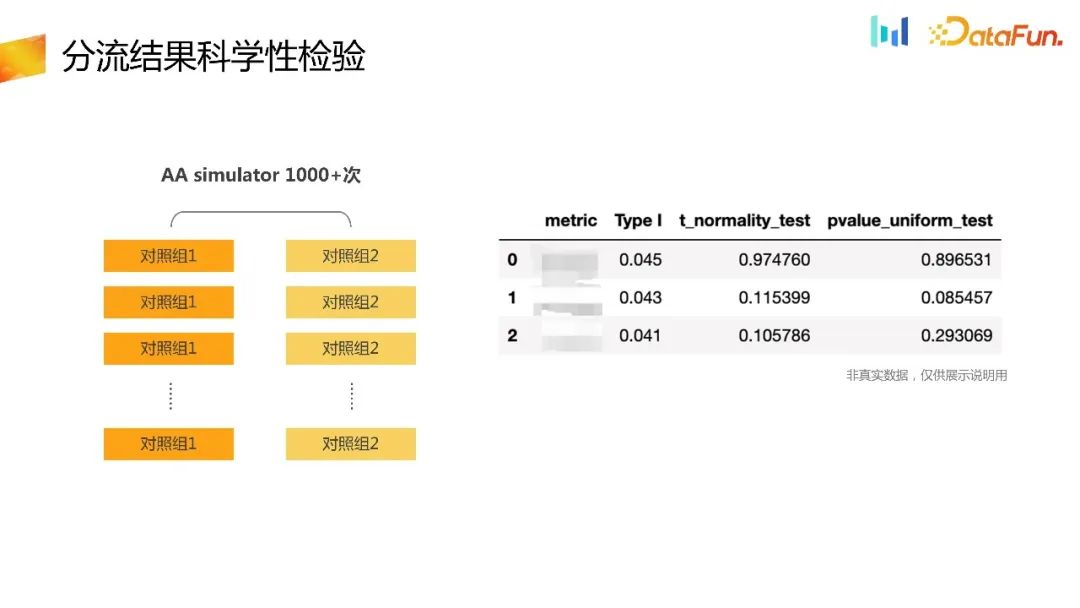

结合内部的平台,做了很多次 AA 的simulation。

比较对照组和实验组在对应的指标上面是否满足实验的要求。接下来看一下这一组数据。  抽样了一部分 t 检验的一些指标组,可以理解为对于做的这么多次试验,放 type one error rate 应该是在很小的概率,假设 type one error rate 预定是在 0. 055% 左右,它的置信区间其实应该在 1000 次左右,应该是在 0. 0365- 0. 0635 之间。可以看到第一列抽样出来的一些指标,都在这个执行区间之内,所以从 type one error rate 视角来看现有的这个实验体系是 OK 的。

抽样了一部分 t 检验的一些指标组,可以理解为对于做的这么多次试验,放 type one error rate 应该是在很小的概率,假设 type one error rate 预定是在 0. 055% 左右,它的置信区间其实应该在 1000 次左右,应该是在 0. 0365- 0. 0635 之间。可以看到第一列抽样出来的一些指标,都在这个执行区间之内,所以从 type one error rate 视角来看现有的这个实验体系是 OK 的。

同时考虑到检验是对于 t 统计量的检验,相应的 t 统计量在大流量的分布下面,应该是近似地服从正态分布的。也可以对 t 检验的统计量做正态分布的检验。这里用了正态分布的检验,可以看到检验出来的结果也是远远大于 0.05 的,即原假设成立,也就是 t 统计量是近似服从正态分布的。

对于每次检验 t 统计量检验出来的结果的 pvalue,在这么多次实验里面来看,也是近似地服从均匀分布的,同时也可以对pvalue 做均匀分布的检验,pvalue_uniform_test,也可以看到类似的结果,它也是远远大于 0.05 的。所以原假设 pvalue 近似服从均匀分布也是 OK 的。

以上从分流 ID 和指标计算口径的一一对应关系,从分流的能力和分流的结果指标结果上面都去验证了新提出来的这种实验分流体系的科学性。

03应用案例分析接下来结合 UG 场景下的实际应用案例,讲解如何做实验评估,解决前面提到的问题三。

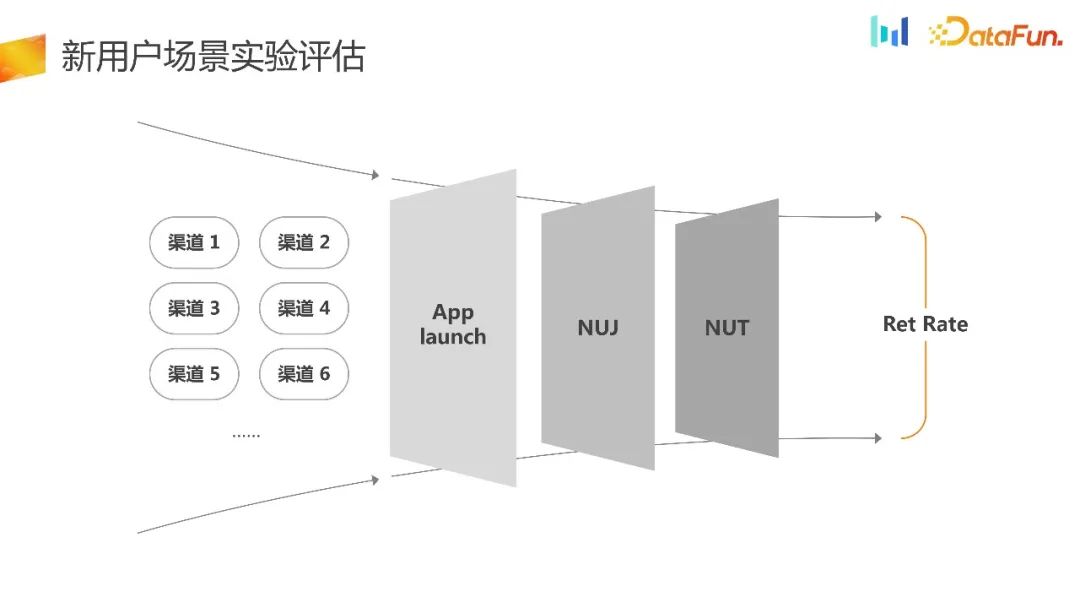

1. 新用户场景实验评估 这里是典型的 UG 流量承接场景,在 NUJ 新用户引导或者新用户任务的时候会做很多的优化,从而提升流量利用率。这个时候的评估标准往往都会是 retention rate,这是业界现有的常规理解。

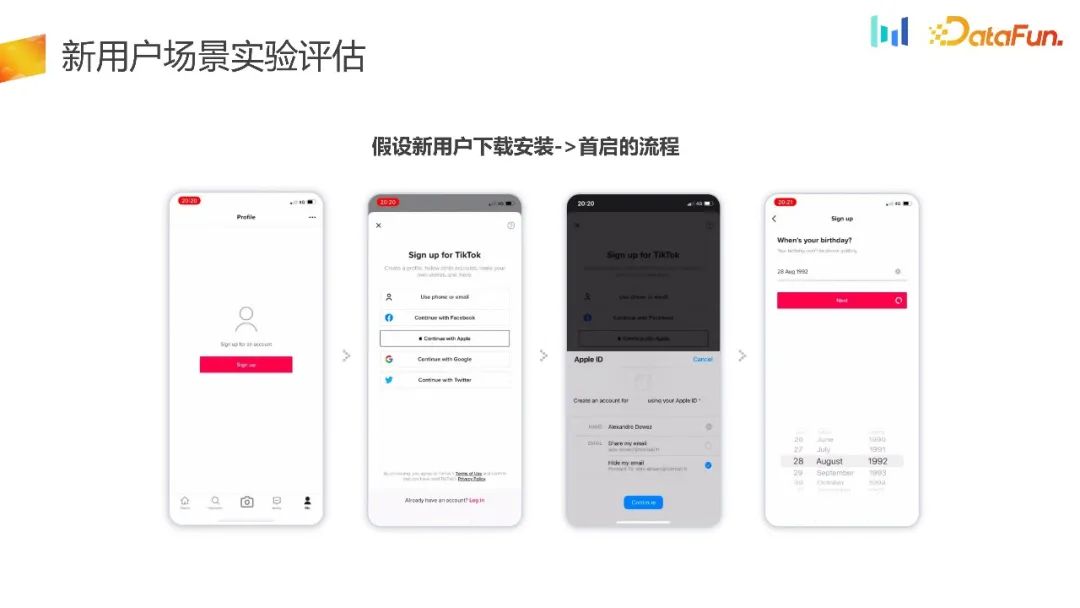

这里是典型的 UG 流量承接场景,在 NUJ 新用户引导或者新用户任务的时候会做很多的优化,从而提升流量利用率。这个时候的评估标准往往都会是 retention rate,这是业界现有的常规理解。 假设从新用户下载到安装再到首启的这个流程, PM 觉得这样的流程对于用户使用,特别是从未体验过产品使用的这一部分用户来说门槛太高了,是不是应该先让用户熟悉产品,体验到产品的嘻哈 moment 以后,再引导登录。

假设从新用户下载到安装再到首启的这个流程, PM 觉得这样的流程对于用户使用,特别是从未体验过产品使用的这一部分用户来说门槛太高了,是不是应该先让用户熟悉产品,体验到产品的嘻哈 moment 以后,再引导登录。  进而 PM 提出了另外的假设,对于从来没有体验过产品的用户,在新用户登录或者新用户 NUJ 的场景里面,降低阻力。对于体验过产品的用户,换机用户,还是走线上的流程。

进而 PM 提出了另外的假设,对于从来没有体验过产品的用户,在新用户登录或者新用户 NUJ 的场景里面,降低阻力。对于体验过产品的用户,换机用户,还是走线上的流程。  基于指标 ID 进行分流,首先获取的指标的 ID,然后进行分流,这样的分流往往是均匀的,从实验的结果也可以看到,同时从 retention rate 上面也可以看到没有太大的区别。从这样的结果上,很难去做出推全的决策。这样的实验其实浪费了一部分流量,同时存在选择偏差的问题,所以进而会做本地分流的实验,下图可以看到本地分流的实验结果。

基于指标 ID 进行分流,首先获取的指标的 ID,然后进行分流,这样的分流往往是均匀的,从实验的结果也可以看到,同时从 retention rate 上面也可以看到没有太大的区别。从这样的结果上,很难去做出推全的决策。这样的实验其实浪费了一部分流量,同时存在选择偏差的问题,所以进而会做本地分流的实验,下图可以看到本地分流的实验结果。 进组的新设备数上面会有显著性的差异,而且是置信的。同时在 retention rate 上面有提升,但在其它核心指标上其实是有负向的,而且这个负向很难被理解,因为它跟留存其实是强相关的。所以基于这样的数据,也很难去解释或者去归因,也很难去做出推全的决策。

进组的新设备数上面会有显著性的差异,而且是置信的。同时在 retention rate 上面有提升,但在其它核心指标上其实是有负向的,而且这个负向很难被理解,因为它跟留存其实是强相关的。所以基于这样的数据,也很难去解释或者去归因,也很难去做出推全的决策。

可以去看一下重复进组的用户的情况,就会发现超过 20% 的用户是被重复进到不同的组的。AB 实验的分流的随机性就已经被破坏了,这样的结果就很难支持我们做出比较科学的决策。

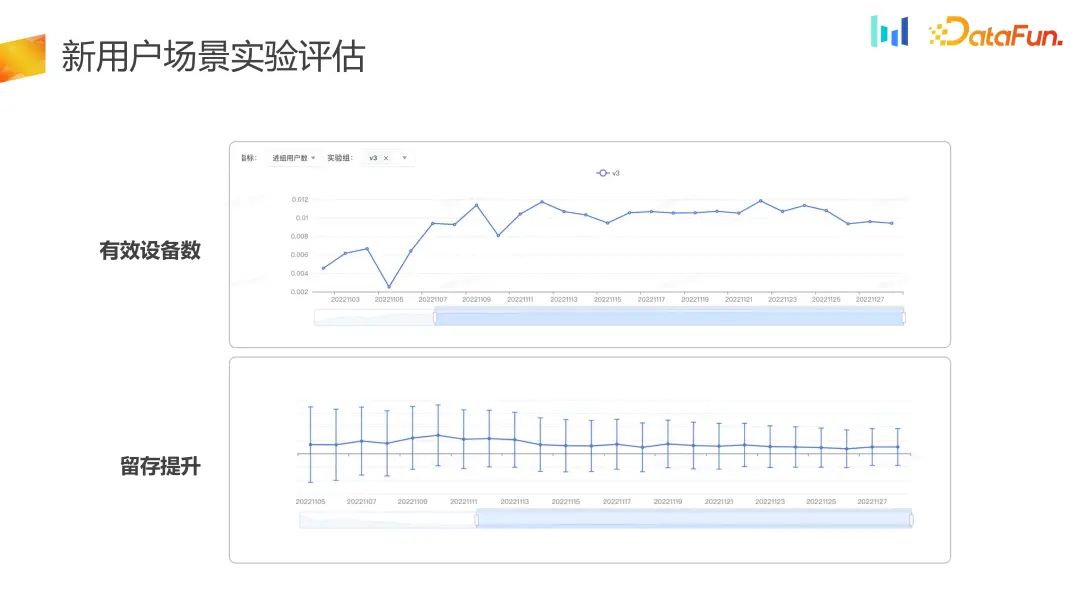

最后,看一下用提出的新的分流的实验的结果。  开机即可分流,分流能力是由内部平台来保证的,它能够极大程度地保证分流的均匀性和稳定性。从实验的数据来看,几乎是接近的,在做开方检验的时候也能够看到它是完全满足需求的。同时看到有效的新设备数是有极大的增加的,增加了1%,同时在 retention rate 上面也有所提升。同时从对照组或者单看实验组,能够看到基于分流 ID 到最终产生的新设备的流量转化率,实验组比对照组提升了 1% 。之所以出现这样的结果,实验组其实是放大了用户在 NUJ 和 NUT 的这个入水口,有更多的用户更容易进来体验到产品,进而留下来。

开机即可分流,分流能力是由内部平台来保证的,它能够极大程度地保证分流的均匀性和稳定性。从实验的数据来看,几乎是接近的,在做开方检验的时候也能够看到它是完全满足需求的。同时看到有效的新设备数是有极大的增加的,增加了1%,同时在 retention rate 上面也有所提升。同时从对照组或者单看实验组,能够看到基于分流 ID 到最终产生的新设备的流量转化率,实验组比对照组提升了 1% 。之所以出现这样的结果,实验组其实是放大了用户在 NUJ 和 NUT 的这个入水口,有更多的用户更容易进来体验到产品,进而留下来。 把实验数据拆成 login 和 not login 两部分,可以看到对于实验组的用户,有更多的用户选择了非登录的模式,去体验产品,同时留存也得到了提升,这样的结果也是符合预期的。

把实验数据拆成 login 和 not login 两部分,可以看到对于实验组的用户,有更多的用户选择了非登录的模式,去体验产品,同时留存也得到了提升,这样的结果也是符合预期的。 可以看到 by daily 的指标,进组的用户数,其实是有长期写,by daily 来看是稳定增加的,同时留存指标也有提升。实验组相比对照组在有效设备数和留存上都是有提升的。

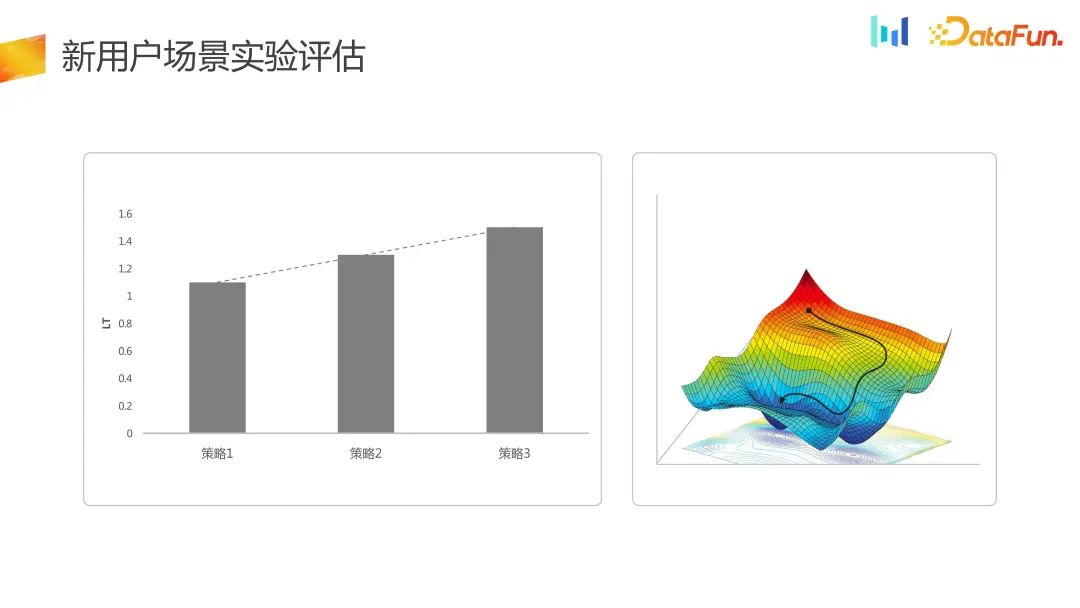

可以看到 by daily 的指标,进组的用户数,其实是有长期写,by daily 来看是稳定增加的,同时留存指标也有提升。实验组相比对照组在有效设备数和留存上都是有提升的。 对于新用户流量承接的场景,更多的评估指标是从留存或者短期的 LT 的维度来做的评估,这里的优化其实只是在 LT 层级的一维空间上面的优化。

对于新用户流量承接的场景,更多的评估指标是从留存或者短期的 LT 的维度来做的评估,这里的优化其实只是在 LT 层级的一维空间上面的优化。

而在新的实验体系里面,把一维优化变成了二维优化, DNU 神尚 LT 整体得到了提升,这样策略空间从以前的一维变成了二维,同时在有些场景下是能接受一部分 LT 的损失的。 04总结最后,对新用户场景下实验能力建设和实验评估标准进行一下总结。

- UG 新用户场景下现有的实验体系无法完全解决新用户流量承接策略评估所面临的问题,需要新的实验体系。

- 分流 ID 的选择有几个标准,首先是安全合规,然后是首次启动即可获取,再者是在单次安装周期内是稳定的,并且跟指标 ID 是单射的关系。

- 针对新用户场景的实验评估是一个多维优化,收益来源于有效的新设备数和设备的留存,而不像以前只评估设备的留存。

- 针对“新”用户的承接,往往会有着巨大的业务收益。这里的“新”,不光指新的用户,还包括卸载重装的用户。

以上就是本次分享的内容,谢谢大家。

分享嘉宾

INTRODUCTION

田间 Colin

字节跳动

Data Scientist

负责字节旗下某海外 app 用户增长数据科学相关工作

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง