编译 | 曾全晨

审稿 | 王建民

今天为大家介绍的是来自Kadija Ferryman的一篇论文。在医学领域使用的人工智能(AI)工具,就像在其他领域使用的AI一样,通过检测大量数据中的模式来运作。AI工具能够检测这些模式,因为它们可以“学习”,或者被训练以识别数据中的特定特征。然而,使用以某种方式偏斜的数据进行训练的医学AI工具可能会表现出偏见,而当这种偏见与不公正的模式相符时,使用这些工具可能会导致不平等和歧视。虽然试图修复用于AI训练的有偏临床数据的技术解决方案是出于善意的,但支撑所有这些倡议的基本概念是,有偏的临床数据就像“垃圾”,就像计算机科学的格言“垃圾进,垃圾出”所指的意思。相反,作者提出将临床数据视为信息产物,当审视这些产物时,它们可以为所在的社会和机构提供信息。将有偏的临床数据视为信息产物可以识别医学和卫生保健领域中的价值观和不平等模式。将临床数据视为信息产物进行审视还可以为当前的医学AI开发方法提供替代方案。此外,将数据视为产物的这种框架将修复有偏AI的方法从狭义的技术观点扩展到了社会技术的视角,考虑历史和当前的社会背景作为解决偏见的关键因素。这种更宽泛的方法有助于实现公共卫生目标,理解人口不平等问题,还为将AI用作检测与健康平等相关的种族和民族纠正、缺失数据和人口不平等模式的新方法提供了可能。

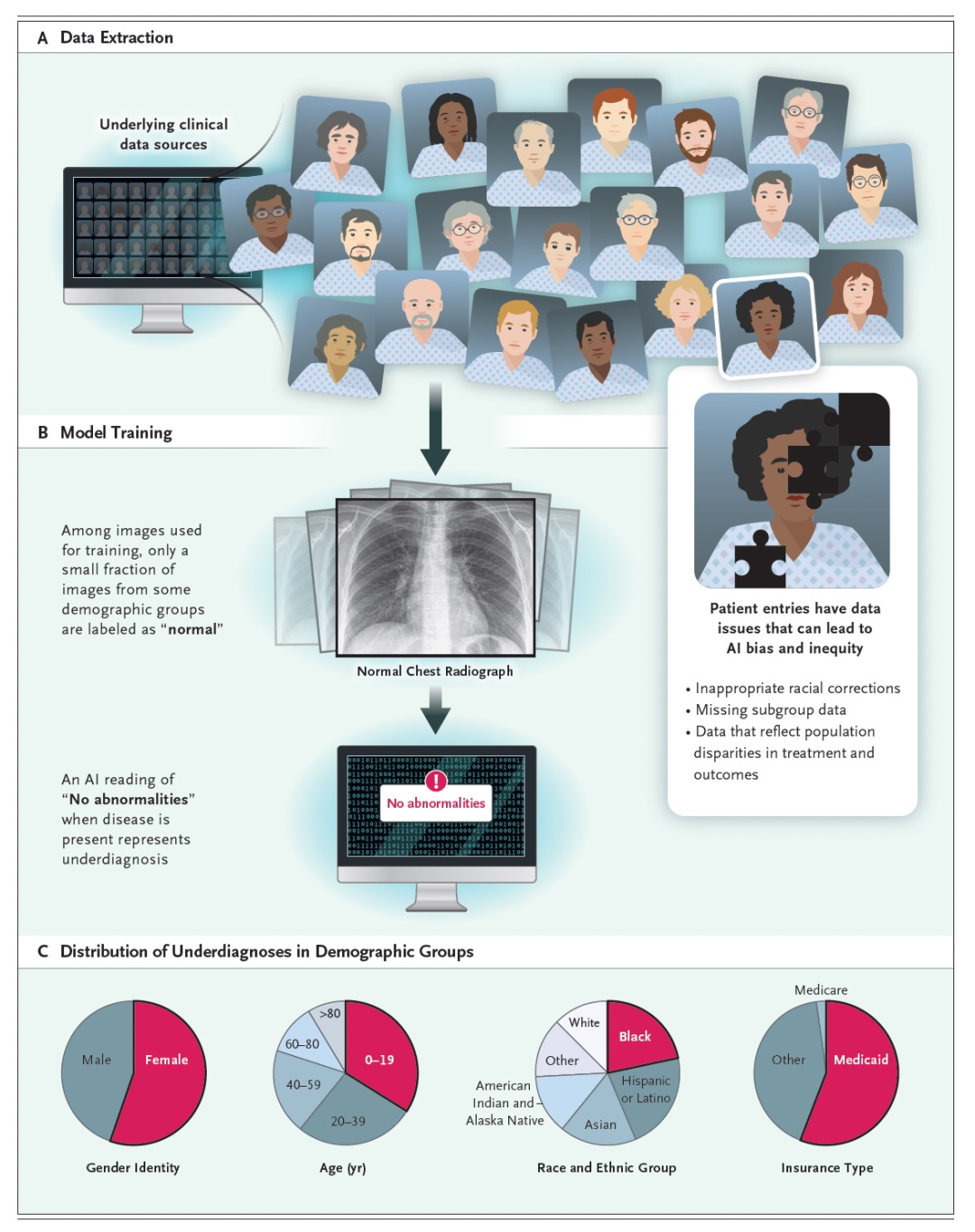

我们正目睹人工智能(AI)的崛起。像ChatGPT和DALL-E这样的AI工具似乎能够模仿人类智能,但它们实际上是计算机程序,用于对数据进行分类、归类、学习和过滤,以解决问题、做出预测和执行其他看似智能的任务。在医学领域使用的AI工具,就像在其他领域使用的AI一样,通过在大量数据中检测模式来工作。例如,AI可以在经过大量异常图像的训练后,学会检测医学图像中的异常情况。医学AI展示了令人印象深刻的能力,尤其是在放射学领域。一些AI工具在识别医学图像中的疾病方面,至少与经验丰富的放射科医师一样准确。然而,如果医学AI工具是通过某种方式偏倚的数据进行训练的,这些工具可能会表现出偏见。例如,可以开发一个AI工具来检测胸部X射线片中的疾病。该工具将通过使用由成千上万张有病或无病的胸部X射线片组成的数据集进行训练。AI将从这些图像中学会识别疾病。然后,当展示一张新图像时,AI工具将能够确定胸部X射线片上是否存在疾病的证据。理想情况下,该工具在识别疾病方面应该非常准确,对所有人也应该准确无误。然而,如果训练数据中包含具有特定特征的图像过多,比如特定大小或形状的胸部,或者标记图像是否显示疾病的方式存在差异,那么该工具将出现偏见。

图 1

医学AI工具,就像其他AI应用一样,可能会因为训练数据中的偏见而变得有偏。这种偏见可能反映了社会不平等。最近一篇探讨基于胸部图像进行疾病诊断的AI使用的文章指出,即使使用数千张图像的数据集进行训练,AI模型在为弱势群体和种族和族裔少数群体进行诊断时表现出一种低诊断率的模式。这种模式在交叉群体(如黑人和西班牙裔女性)中尤为明显。像这样的医学AI工具不仅存在偏见,还是健康不平等的根源,因为在弱势群体和种族和族裔少数群体中已经存在不公正的健康差距(图1)。例如,在美国,黑人比白人更不太可能得到肺癌早期诊断。在这个例子中,AI偏见,也被称为算法偏见,具有重要影响,因为它可能导致算法歧视。美国总统府科学技术政策办公室最近在其《AI权利法案蓝图》中将算法歧视确定为一个关键问题。研究和学术界也认识到AI偏见可能演变为算法歧视的潜在可能性。一些人提出了技术解决方案,例如试图修复用于AI训练的有偏临床数据。修复训练数据的一种方法是通过将来自不同临床机构的数据进行汇集,从而包含人口统计学上代表性的数据集。其他解决方案包括通过为某些人口统计类别缺失的数据进行填充,或者在不存在数据的地方创建新的合成数据,从而人为地创造人口统计多样性。美国国立卫生研究院最近推出了“Bridge2AI”计划,这是一项耗资1.3亿美元的努力,旨在从零开始构建多样化的数据集,以用于培训和构建新的医学AI工具。

不仅仅是偏见

尽管所有这些努力都是出于善意的,并且可以在减少人工智能偏见和相关歧视方面取得一些进展,但支撑所有这些倡议的核心概念是,倾斜的临床数据就像计算机科学中的“垃圾进,垃圾出”一样,意味着糟糕或有缺陷的数据会导致不良的分析结果。尽管认识到倾斜或缺失的数据可能导致算法性偏见和歧视,但作者提出了一种人工智能偏见的替代方法。作者将这些数据视为历史信息产物,从考古学和历史的角度看,历史产物是可以提供关于社会、包括制度、活动和价值观的信息的物体。工具之所以重要,是因为它们可以揭示早期社会的情况,即使它们揭示的信仰和实践可能与当代社会的信仰和实践不一致。以类似的方式,我们可以将用于AI的临床数据视为产物,这些产物可以揭示可能令人不悦的事实。例如黑人患者的医疗支出低于白人患者,导致分配医疗资源不平等的算法。当将倾斜的临床数据视为信息产物而非垃圾时,我们可以利用AI中的模式识别能力来帮助我们理解这些模式在历史和当代社会背景下的含义。

健康数据产物与价值观

近年来,人们越来越关注在临床数据中应用种族和民族矫正方法。例如,2021年,慢性肾脏病流行病学合作组织报道了一种新的方程,用于估算肾功能的一种指标(肾小球滤过率),而无需使用种族矫正。该方程以前会“矫正”黑人的肌肉质量明显较高的假设。研究已经表明,在医学中的种族矫正实践可以追溯到将白人男性的身体作为参照标准或规范,用以衡量其他身体和生理功能。尽管遗传祖源可能提供一些临床相关信息,比如具有对抗疾病的遗传变异, 但越来越多的人认识到,医学中一些关于种族和民族的矫正需要重新评估,因为支持这些矫正的证据可能已经过时,使用这些矫正可能会加深健康不平等。了解医学临床数据中种族矫正的历史很重要,因为临床预测模型可能基于一种逻辑,即种族与生理学的某些方面(如肺功能)之间存在生物学决定性的关系。这些数据和假设然后可以纳入医学AI工具的开发中。看似看不见的偏见,比如在临床数据中进行种族“矫正”,如果不认识到种族矫正的历史,往往很难通过纯粹的技术手段来修复。虽然在当代医学中否认了白人正常或至上主义等种族主义价值观,但如果将这些数据用作训练集,这些价值观可以影响当前实践以及未来医学AI工具的开发。跨学科团队对临床数据进行上游分析,可以揭示重要但隐含的历史和其他因素塑造了这些数据。这种干预可以帮助识别将导致下游歧视性AI工具的数据,并提出解决这些偏斜数据深层原因的干预措施,比如重新评估临床实践中的种族矫正。

健康数据的产物和实践

将有偏差的健康数据视为值得仔细研究的历史信息产物,还可以识别出医疗保健实践问题,从而指引解决与数据和数据中心工具(如AI)相关问题的社会技术解决方案。例如,性别认同在临床数据中经常缺失。我们不仅可以考虑修复这些数据或放弃我们已经拥有的海量数据,还可以检查这些数据所呈现的丰富信息,并思考数据缺失暗示了关于临床和社会实践的内容,比如在临床用语中涉及性别和性别的术语不一致以及在医疗接诊表格中继续使用过时的性别认同术语,这些术语可能不适用于每个人。缺失的数据还可能表明,一些人可能不愿意或不支持披露这些信息,并且医护人员可能缺乏收集这些信息的培训或权威。健康数据的产物方法还有助于发挥AI的能力,提出新的应用。因为AI可以快速识别模式,它可以发现临床数据中的缺失,比如某些种族群体的缺失,这可以作为一种假设生成工具,可以催生关于临床护理和健康不平等的新的跨学科研究。

健康数据的产物和不平等模式

将健康数据视为产物而不是垃圾,还可以帮助揭示在医疗保健领域不同人群之间的不平等模式。不幸的是,在美国的少数族裔群体中存在许多不公平的健康差距,或称为健康不平等。健康数据反映了这些差距。如上所述,黑人患者的肺癌更有可能在晚期诊断,而不是在白人患者中。如果用于训练癌症预测算法,数据中的这种偏差可能会预测黑人患者的存活率较低。进一步,这种较低的预测存活率可能会影响提供给这些患者的治疗选择,特别是在倾向于预计有更好疗效的患者的治疗分流或配给系统的情况下。然而,将这些数据视为信息产物可以帮助揭示不平等模式,将这些诊断差异凸显出来。这些数据的历史表明,仅在2年前,肺癌筛查指南发生了问题,因为它们过分地将黑人列为不适合进行早期癌症筛查的人群。

结论

作者建议将注意力从健康数据的不足转向将这些数据视为人类活动和价值观的历史信息产物。考古学等领域的产物分析与殖民主义剥削的历史有关,这带有一定的讽刺意味。将医疗保健数据视为信息产物,提供了一种考虑历史和当前社会背景的社会技术方法。这种扩展方法有助于实现公共卫生的目标,即了解人口不平等,并提出了利用AI检测与卫生平等相关的数据模式的新方法。作者提出这种重新构思,以便医疗保健领域的AI开发可以反映我们对确保现在和未来的平等医疗保健的承诺和责任。

参考资料

Ferryman, K., Mackintosh, M., & Ghassemi, M. (2023). Considering Biased Data as Informative Artifacts in AI-Assisted Health Care. New England Journal of Medicine, 389(9), 833-838.

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง