Take a Step Back: Evoking Reasoning via Abstraction in Large Language Models

H S Zheng, S Mishra, X Chen, H Cheng, E H. Chi, Q V Le, D Zhou

[Google DeepMind]

后退一步:在大型语言模型中通过抽象唤起推理

- 本文提出一种简单的提示技术“STEP-BACK PROMPTING”,可以改进大型语言模型的推理能力。

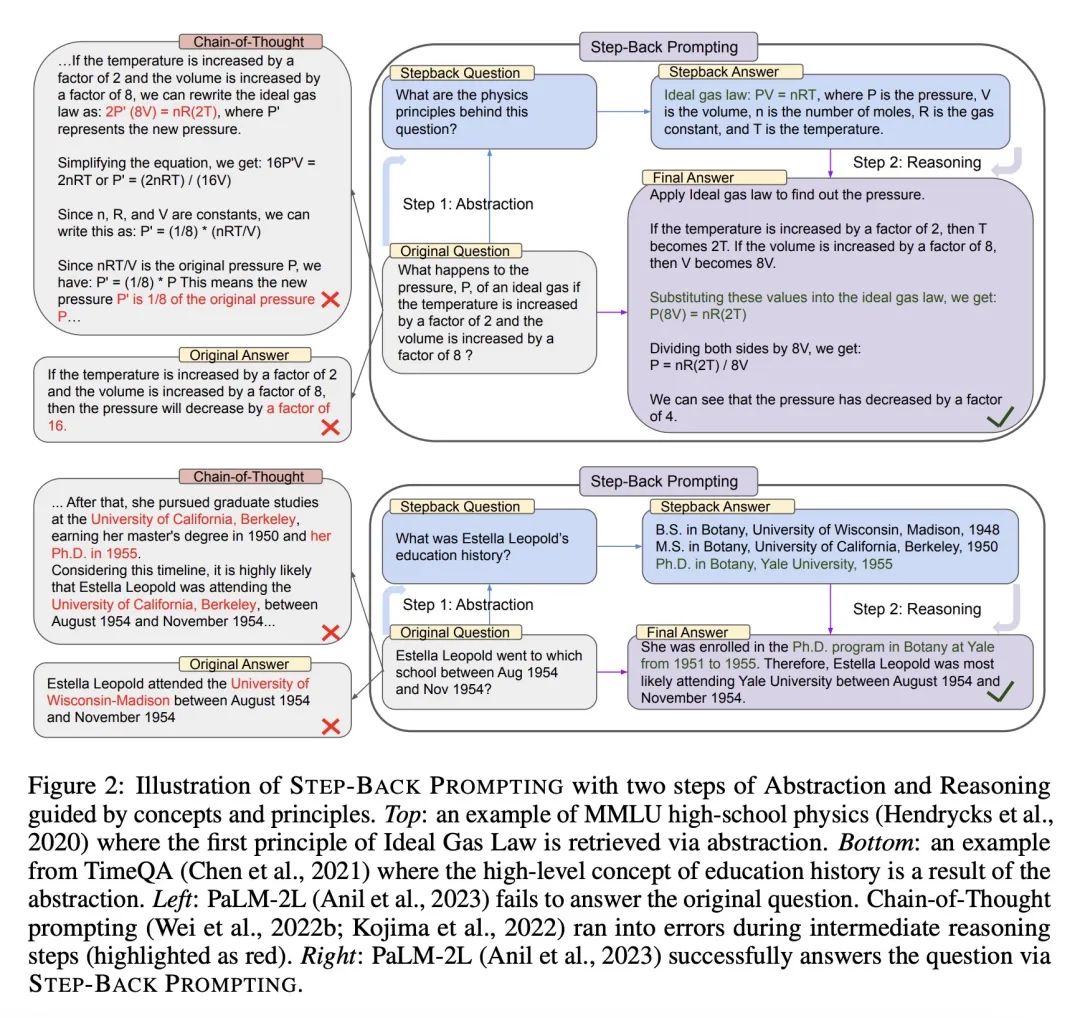

- 该技术包含两步:1)抽象——提示模型“后退”一步,推导出与问题相关的高层概念/原理,2)推理——用高层概念来指导推理过程以得到解决方案。

- 在使用STEP-BACK PROMPTING的PaLM-2L模型上做实验显示,在许多困难的推理任务上得到了显著提升,包括MMLU物理/化学7-11%的提升,TimeQA 27%的提升,MuSiQue 7%的提升。

- 抽象这一步很高效,只需要几个示范就够了,分析显示,推理仍是瓶颈,而抽象技能对语言模型来说相对较容易获取。

- 该技术的灵感来自人类通过抽象简化问题以进行推理的方式,减少了中间推理步骤中的错误。

动机:通过引入抽象的思维方式,让大型语言模型能从具体细节中提取高层概念和基本原理,以指导其推理过程,从而显著提高模型在复杂推理任务中的性能。

方法:提出一种名为“STEP-BACK PROMPTING”的简单提示技术,使得语言模型能通过抽象来推导高层概念和基本原理,从而指导其推理过程。具体包括两个步骤:第一步是让语言模型“退后一步”,从具体实例中提取高层抽象;第二步是利用推理能力来基于这些高层概念和基本原理进行解决,用PaLM-2L模型进行实验验证。

优势:通过引入抽象的思维方式,使得语言模型能更好地处理复杂的推理任务,包括STEM、知识问答和多跳推理等。实验证明,STEP-BACK PROMPTING可以显著提高PaLM-2L模型在这些任务上的性能,例如在MMLU物理和化学任务上提升了7%和11%,在TimeQA任务上提升了27%,在MuSiQue任务上提升了7%。

通过引入抽象的思维方式,STEP-BACK PROMPTING技术能显著提高语言模型在复杂推理任务上的性能,为模型提供高层概念和基本原理的指导。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง