点击下方卡片,关注「集智书童」公众号

本文首发于 【集智书童】,白名单账号转载请自觉植入本公众号名片并注明来源,非白名单账号请先申请权限,违者必究。

作者提出了DFormer,一个新颖的RGB-D预训练框架,用于学习可迁移的RGB-D表征。DFormer具有两个关键的新创新点:

-

与以往的工作不同,他们没有采用RGB预训练骨干网络来编码RGB-D信息,而是使用了来自ImageNet-1K的图像-深度配对数据来预训练骨干网络,从而使DFormer具备了更好编码RGB-D表征的能力。

-

DFormer包括一系列RGB-D块,这些块经过新颖的构建块设计,专门用于通过新的建筑块设计来编码RGB和深度信息。DFormer避免了使用RGB预训练骨干网络在深度图中不匹配地编码3D几何关系,这是现有方法中普遍存在但尚未解决的问题。

作者在预训练的DFormer的尾部加上轻量级解码器后进行微调,用于两个流行的RGB-D任务,即RGB-D语义分割和RGB-D显著性检测。实验结果表明,DFormer在两个RGB-D语义分割和五个RGB-D显著对象检测数据集上取得了新的最先进性能,且计算成本不到当前最佳方法的一半。

论文链接:2309.09668.pdf (arxiv.org)

代码链接:https://github.com/VCIP-RGBD/DFormer

1、简介

随着3D传感器的广泛使用,RGB-D数据越来越容易访问。通过结合3D几何信息,可以更容易地区分实例和上下文,从而促进RGB-D研究以实现高级场景理解。同时,RGB-D数据在大量应用中也表现出相当大的潜力,例如SLAM、自动驾驶和机器人。因此,RGB-D的研究在过去几年中引起了极大的关注。

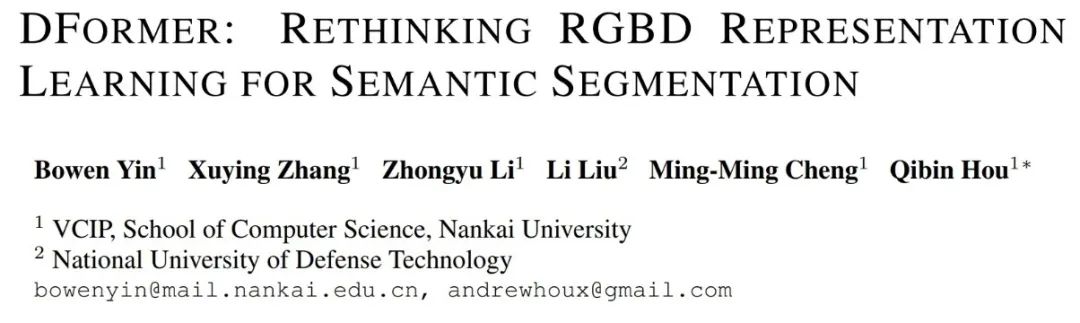

图1(顶部)中显示了当前主流RGB-D方法的结构。可以观察到,RGB图像和深度图的特征分别由两个单独的RGB预训练骨干网络中提取。这两种模式的信息之间的相互作用是在这个过程中进行的。尽管现有的方法在几个基准数据集上取得了优异的性能,但有三个问题不容忽视:

- RGB-D任务中的两个RGB骨干网络以RGB-D数据为输入,这与RGB预训练中图像的输入不一致,造成了巨大的表征分布偏移;

- 在finetuning期间,在RGB分支和深度分支之间密集地执行交互,这可能破坏预先训练的RGB主干内的表征分布。

- 与标准RGB方法相比,RGB-D网络中的双主干带来了更多的计算成本,存在大量的冗余计算。作者认为,导致这些问题的一个重要原因是预训练时没有考虑深度信息。

考虑到上述问题,作者提出了一个直截了当的问题:是否有可能专门设计一个RGB-D预训练框架来消除这一差距?受此启发,作者提出了一种新的RGB-D预训练框架,称为DFormer。

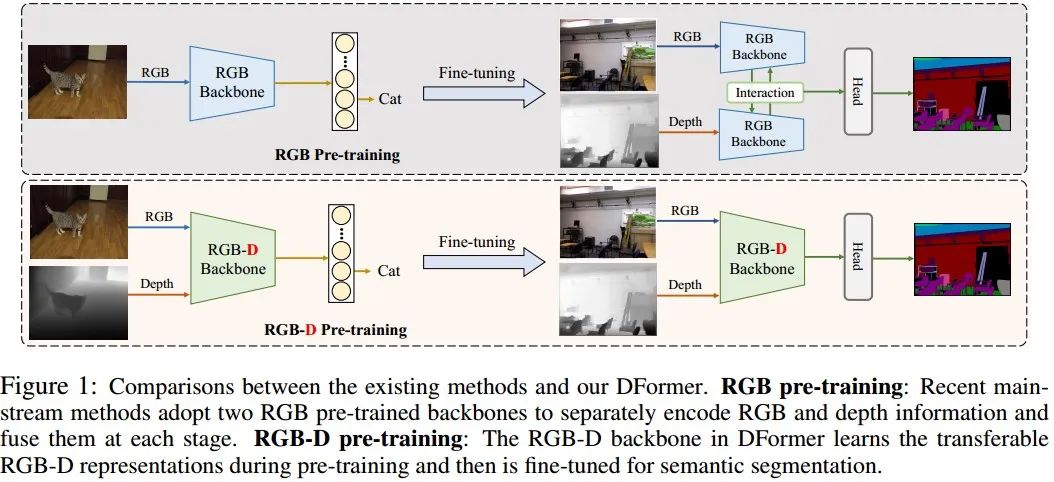

如图1(底部)所示,在预训练期间,作者考虑将图像深度对作为输入,并在编码器的block内构建RGB和深度特征之间的交互。因此,可以自然地避免预训练和微调的输入之间不一致的问题。此外,在预训练过程中,RGB特征和深度特征可以在每个构建块中有效地相互交互,避免了目前多数方法采用的骨干网络外的繁重交互模块。与以前的工作相比,DFormer将交互过程放在了building block内,交互效率大大提高。图2中反映出,作者的DFormer具有更低的计算成本,可以实现更好的性能。作者还在实验部分展示了预训练策略的更多优势。与最近的其他模型相比,作者的方法在分割性能和计算之间实现了最佳的折中。

作者的主要贡献可以总结如下:

- 作者提出了一种新的RGB-D预训练框架,称为DFormer,它可以为RGB-D下游任务提供可迁移的表征。

- 作者设计了一种有效且高效的交互方法来融合RGB和深度特征。它被用于基本的building block中,以形成RGB-D编码器。

- 作者的DFormer在两个RGB-D分割数据集和五个RGB-D显著性数据集上实现了最先进的性能,计算成本不到当前最佳方法的一半。

2、本文方法

为了提高预训练过程中的融合效率,作者的DFormer将RGB图像和深度图像作为分类的输入,在构建块内构建它们之间的信息交互。此外,作者的DFormer只需要一个轻量级的解码器,就能够在语义分割和显著对象检测方面取得了很好的结果。

2.1、总体架构

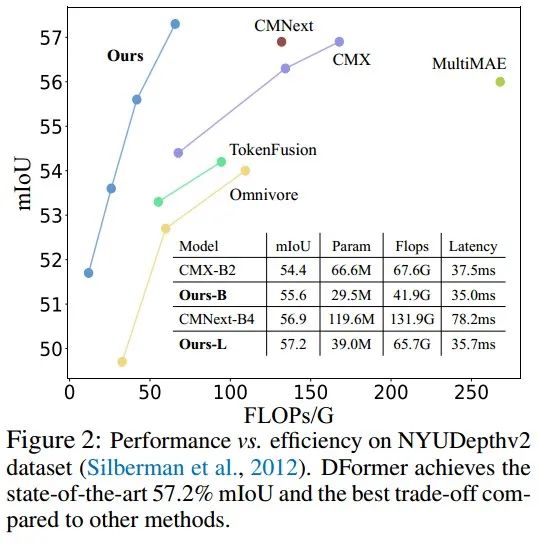

图3说明了作者的DFormer的整体架构,它遵循流行的编码器-解码器框架。特别地,分层编码器被设计为生成高分辨率粗略特征和低分辨率精细特征,并且使用轻量级解码器将这些视觉特征转换为特定任务的预测。

2.2、层次化编码器

如图3所示,作者的分层编码器由四个阶段组成,用于生成多尺度RGB-D特征。每个阶段都包含一组RGB-D块。核大小为3×3和步长为2的两个卷积用于在两个连续阶段之间分别对RGB和深度特征进行下采样。

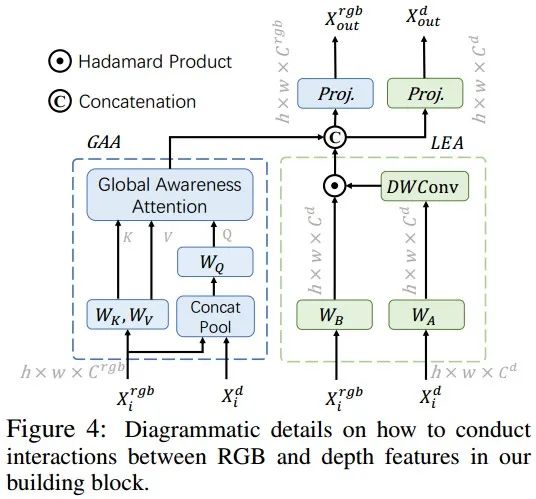

DFormer的基本构成block主要由全局感知注意力(GAA)模块和局部增强注意力(LEA)模块组成,用于构建RGB和深度模态之间的交互。GAA融合了深度信息,旨在从全局角度增强对象定位能力,而LEA采用大核卷积从深度特征中捕获局部线索,可以细化RGB表示的细节。交互模块的细节如图4所示。

作者的GAA融合了深度和RGB特征,在整个场景中建立关系,增强了3D感知能力,并进一步帮助捕捉语义物体。与自注意机制不同,自注意力机制的计算量随着pixel或token的增加而呈现二次幂增长,GAA中的Query(Q)被下采样到固定大小,因此可以降低计算复杂度。Q来自RGB特征和深度特征的融合,而Key(K)和Value (V)是从RGB特征中提取的。给定RGB特征和深度特征,上述过程可以公式化为:

作者定义GAA公式化如下:

作者还设计了LEA模块来捕捉更多的局部细节,这可以被视为对GAA模块的补充。与以前大多数使用加法和串联来融合RGB特征和深度特征的工作不同。作者在深度特征上用大核的depth-wise卷积,并使用所得特征作为注意力权重,通过简单的Hadamard乘法加权RGB特征。

具体来说,LEA的计算过程可以定义如下:

为了保留不同的外观信息,作者还构建了一个基本模块来将RGB特征,转换为, 计算过程可以定义如下:

最后,通过并联和线性映射将三个模块的特征融合在一起,更新RGB特征和深度特征。

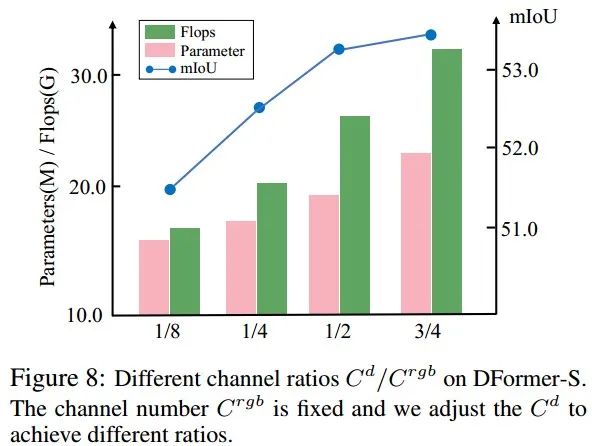

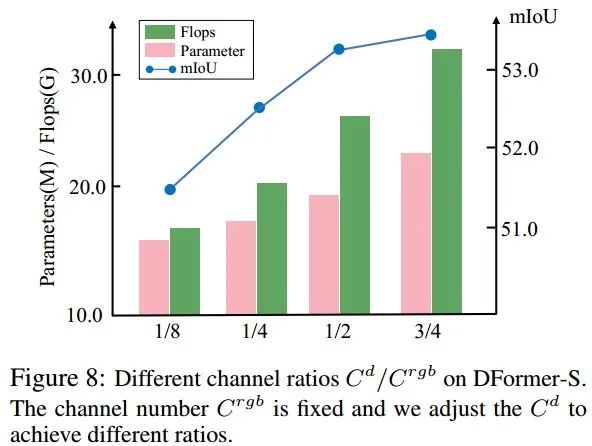

作者经验地观察到,与RGB特征相比,编码深度特征需要更少的参数,因为它们的语义信息更少,这在图8中得到了验证,实验部分进行了详细说明。为了降低RGB-D块中的模型复杂性,作者使用一小部分通道对深度信息进行编码。

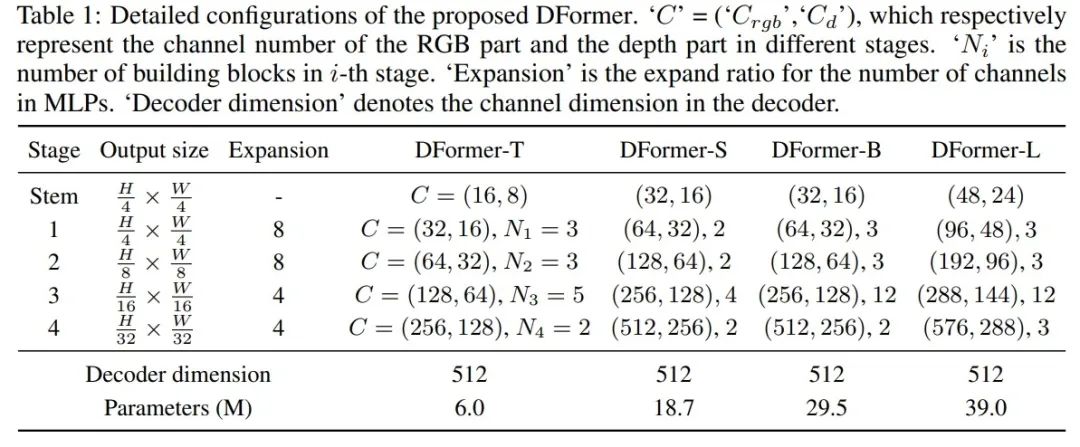

基于每个阶段中RGB-D块的配置,作者进一步设计了一系列DFormer编码器变体,称为分别具有相同架构但不同模型大小的DFormer-T、DFormer-S、DFormr-B和DFormer-L。DFormer-T是用于快速推理的轻量级编码器,而DFormer-L是用于获得更好性能的最大编码器。有关作者配置的更多信息,可以参考作者论文中的参考表1。

2.3、RGB-D预训练

RGB-D预训练的目的是赋予编码器实现RGB和深度模态之间交互的能力,并生成具有丰富语义和空间信息的可迁移的表征。为此,作者首先在ImageNet-1K数据集上应用深度估计器Adabin生成图像深度对。然后,作者在RGB-D编码器的顶部添加一个分类器头来构建预训练网络。

2.4、特定任务的解码器

对于作者的DFormer在下游任务中的应用,作者只需要在预先训练的RGB-D编码器上添加一个轻量级解码器,就可以构建特定于任务的网络。在对相应的基准数据集进行微调后,特定任务网络能够生成出色的预测,而无需使用融合模块等额外设计。

此外,作者的解码器只需要使用RGB特征,而其他方法主要设计融合模态特征的模块用于融合RGB和深度信息,用于最终预测。作者将在实验中表明,由于作者强大的RGB-D预训练编码器,RGB特征可以有效地从深度模态中提取3D几何线索,而无须将深度特征传送到解码器。

3、实验

3.1、RGB-D语义分割

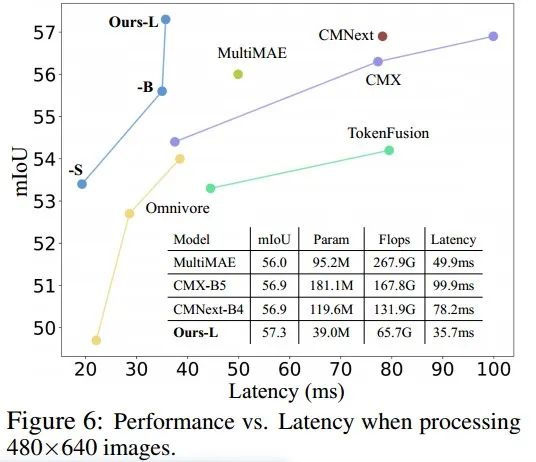

作者在NYUDepthv2和SUN-RGBD数据集上将作者的DFormer与13种最新的RGB-D语义分割方法进行了比较。与其他方法相比,DFormer实现了更好的性能和计算权衡。特别地,DFormer-L在39.0M参数和65.7G Flops的情况下产生57.2%的mIoU,而最近最好的RGB-D语义分割方法,即CMX(MiT-B2),在66.6M参数和67.6G Flops情况下仅实现54.4%的mIoU。

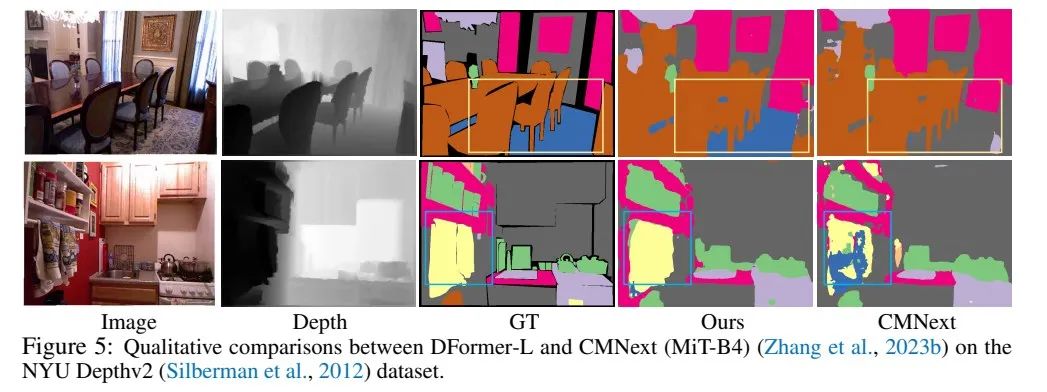

值得注意的是,作者的DFormer-B在一半参数(29.5M,41.9G vs 66.6M,67.6G)下可以比CMX(MiT-B2)高出1.2%mIoU。此外,图5中作者的DFormer和CMNext的语义分割结果之间的定性比较进一步证明了作者方法的优势。

此外,在SUN-RGBD上的实验也显示了作者的DFormer与其他方法相比的类似优势。这些一致的改进表明,作者预训练的RGB-D编码器可以更有效地构建RGB和深度特征之间的交互,从而以更低的计算成本获得更好的性能。

图5给出了DFormer与目前最佳方法的可视化比较。

图6给出了不同方法的延迟比较,可以看出,作者的方法可以在更小的延迟下实现最佳性能,充分展现了DFormer在硬件设备上的应用前景。

3.2、RGB-D显著性检测

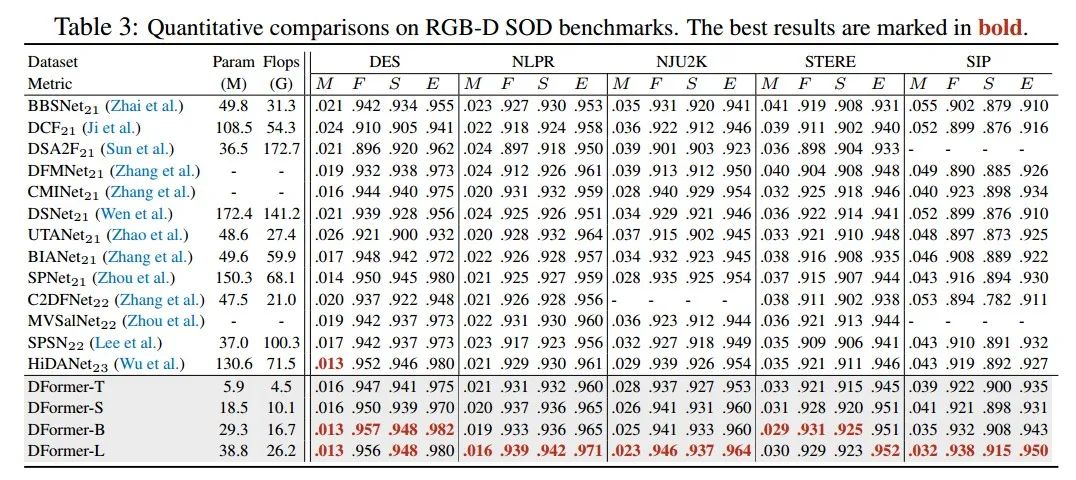

在表3作者给出了DFormer在5个常用的RGB-D显著性检测数据集上的性能比较,可以看出DFormer以目前最佳方法一半以下的计算量实现了最佳性能。

3.3、消融研究和分析

在本节中作者进行消融研究,以调查每个组件的有效性和作者的设计选择。如果没有另行说明,这里的所有实验都是在NYU DepthV2数据集上的RGB-D语义分割设置下进行的。

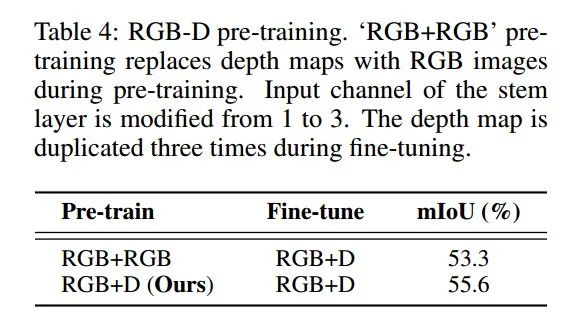

RGB-D与RGB预训练

为了解释RGB-D预训练的必要性,作者在预训练期间用RGB图像替换深度图,称为RGB预训练。具体而言,RGB预训练将深度主干层的输入通道从1修改为3,并在微调期间复制深度图三次。注意,对于微调设置,输入数据的模态和模型结构是相同的。

如表4所示,在NYU DepthV2上,与RGB预训练相比,作者的RGB-D预训练为DFormer-B带来了2.3%的mIoU改进。作者认为这是因为作者的RGB-D预训练避免了由于使用预训练的RGB主干而导致的深度图的3D几何特征的不匹配编码,并提高了两种模态之间的交互效率。附录中的表10和图9也证明了这一点。这些实验结果表明,在RGB-D预训练期间学习的RGB-D表征能力对分割精度至关重要。

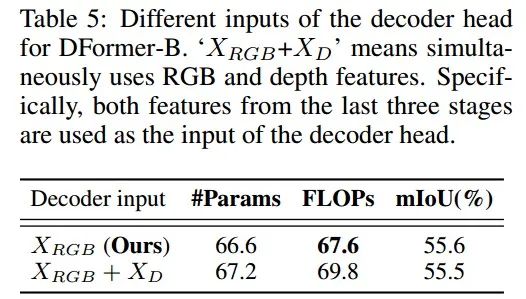

解码器的输入特征

得益于强大的RGB-D预训练,RGB分支的特征可以有效地融合两种模态的信息。因此,作者的解码器仅使用包含表达线索的RGB特征,而不是同时使用RGB和深度特征。

如表5所示,仅使用RGB特征可以在不降低性能的情况下节省计算成本,而其他方法通常需要同时使用RGB和深度特征。这种差异也证明了作者提出的RGB-D预训练和building block更适合RGB-D分割。

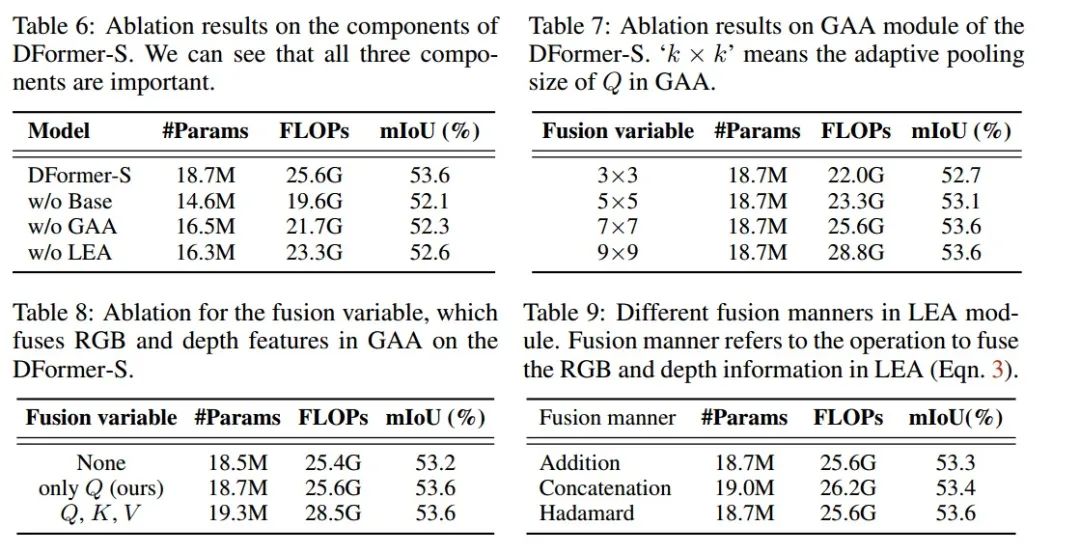

RGB-D模块中的组件

作者的RGB-D模块由基础模块、跨模态注意力模块(GAA)和局部形状增强模块(LEA)组成。作者分别从DFormer中取出这三个组件,结果如表6所示。很明显,所有这些对作者的DFormer来说都是必不可少的。

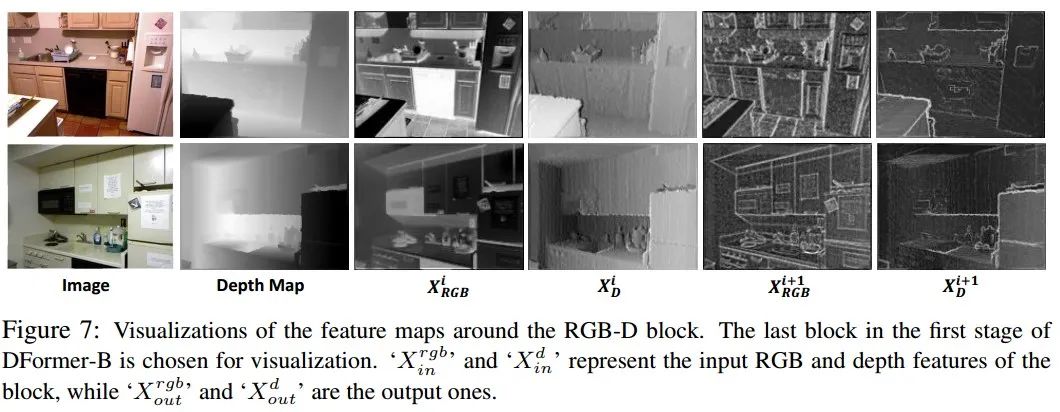

此外,作者在图7中可视化了RGB-D块周围的特征。可以看出,输出特性可以捕捉到更全面的细节。如表8所示,在GAA模块中,作者发现只有将深度特征融合到Q中是足够的,并且将深度特征进一步融合到K和V中会带来微不足道的改进,但会带来额外的计算负担。

此外,作者发现,DFormer的性能最初随着GAA中深度卷积的固定池大小的增加而提高,并且当固定池大小设置为7×7时,它达到了最佳效果,如表7所示。作者还尝试在LEA中使用不同的融合方式,即级联、加法和hadamard乘积。如表9所示,当使用hadamard时,作者的方法实现了最佳性能。

RGB-D通道比率

RGB图像包含与对象颜色、纹理、形状及其周围环境有关的信息。深度图则是记录每个像素的距离信息。与RGB图像相比,作者认为编码深度信息仅需要少量参数。在这里,作者研究用于对深度信息进行编码的信道比率。

在图8中,作者展示了具有不同信道比的DFormer-S的性能。可以看到,当信道比超过1/2时,性能提升微小,而计算负担显著增加。因此,默认情况下,作者将比率设置为1/2。

4、结论与讨论

在本文中,作者提出了一种新的RGB-D预训练框架来学习RGB-D下游任务的可迁移表征。得益于专门设计的RGB-D块,作者的方法能够在预训练期间实现RGB和深度模态之间更好的交互。

作者的实验表明,与现有方法相比,DFormer可以在RGB-D下游任务中实现新的最先进的性能,例如语义分割和显著对象检测,计算成本要低得多。

作者认为,除本文内容外还有很多未来的探索方向:

- 在更广泛的RGB-D下游任务上的应用。考虑到作者预先训练的DFormer编码器具有更好的RGB-D表征能力,将其应用于更多的RGB-D任务是有希望的,例如,RGB-D人脸反欺骗、3D视觉基础,RGB-D跟踪和人体动作捕捉。

- 扩展到其他模态。基于本文精心设计的框架,可通过用其他模态数据(如热数据和激光雷达数据)代替深度来生成对应的多模态表示。新模态的结合可以促进专门和强大的编码器的开发,以满足各种任务的需求。

- 轻量化。当前的RGB-D方法通常计算开销巨大,无法部署到移动设备。尽管DFormer是高效的,但在实际应用中仍然存在差距和发展空间。

扫码加入👉「集智书童」交流群

(备注:方向+学校/公司+昵称)

想要了解更多:

想要了解更多:

前沿AI视觉感知全栈知识👉「分类、检测、分割、关键点、车道线检测、3D视觉(分割、检测)、多模态、目标跟踪、NerF」

行业技术方案👉「AI安防、AI医疗、AI自动驾驶」AI模型部署落地实战👉「CUDA、TensorRT、NCNN、OpenVINO、MNN、ONNXRuntime以及地平线框架」

欢迎扫描上方二维码,加入「集智书童-知识星球」,日常分享论文、学习笔记、问题解决方案、部署方案以及全栈式答疑,期待交流!

免责声明凡本公众号注明“来源:XXX(非集智书童)”的作品,均转载自其它媒体,版权归原作者所有,如有侵权请联系我们删除,谢谢。

点击下方“阅读原文”,了解更多AI学习路上的「武功秘籍」

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง