图神经网络(GNN)在处理非欧几里得数据方面具有显着优势,已广泛应用于各个领域。然而,大多数现有的 GNN 模型面临两个主要挑战:

(1)大多数基于消息传递框架构建的 GNN 模型表现出浅层结构,这阻碍了它们在远程节点之间有效传输信息的能力。当网络太深时,会出现过度平滑或过度挤压,导致所有节点的特征趋于一致,节点变得难以区分。为了解决这个问题,我们的目标是提出一种新颖的消息传递框架,能够构建具有类似于卷积神经网络 (CNN) 的深层GNN 模型,可能包含数十甚至数百层。

(2) 现有模型通常将边和节点特征的学习作为单独的任务。为了克服这个限制,我们渴望开发一种能够同时获取边嵌入和节点嵌入的深度图卷积神经网络学习框架。通过利用学习到的多维边特征矩阵,我们构造多通道滤波器以更有效地捕获准确的节点特征。

为了应对这些挑战,我们提出了边和节点与深度图卷积神经网络(CEN-DGCNN)的共同嵌入。在我们的方法中,我们提出了一种新颖的消息传递框架,可以充分集成和利用节点特征和多维边特征。基于该框架,我们开发了一种深度图卷积神经网络模型,通过提取节点之间的长距离依赖关系并利用多维边缘特征来防止过度平滑并获得节点非局部结构特征和细化的高阶节点特征。此外,我们提出了一种新颖的图卷积层,可以同时学习节点嵌入和多维边嵌入。该层基于节点特征和注意力机制跨层更新多维边嵌入,从而实现节点和边特征的高效利用和融合。此外,我们提出了一种基于有向边的多维边特征编码方法,并使用得到的多维边特征矩阵构造多通道滤波器来过滤节点信息。最后,大量实验表明 CEN-DGCNN 优于大量图神经网络基线方法,证明了我们提出的方法的有效性。

https://www.nature.com/articles/s41598-023-44224-1.pdf?pdf=button%20sticky

背景

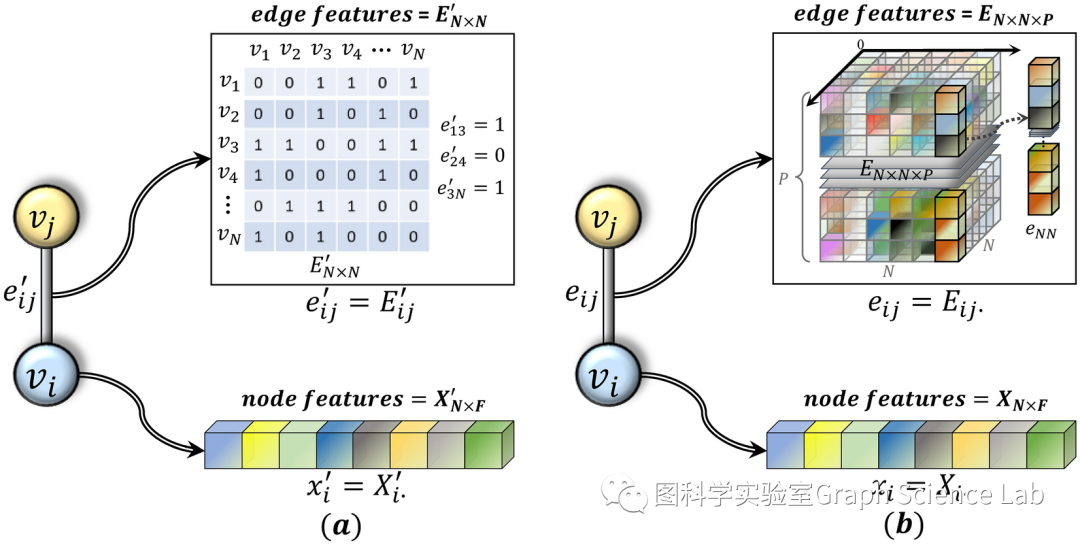

图通常包含丰富的节点特征和边特征。然而,近年来,大多数先进的GNN模型主要侧重于增强节点特征的学习,而忽略了边特征的同步学习。虽然基于消息传递神经网络框架(MPNN)设计的聚合函数可以聚合节点特征和边特征,并且在特定应用场景中取得了不错的效果。但使用预定义的聚合函数更像是手动特征工程,并且不能应用于所有情况。因此,希望实现一种能够迭代学习多维边特征的方法,并将多维边特征的更新同步到节点信息聚合的过程中,充分发挥节点特征和边特征的作用。图1a所示的传统图卷积神经网络(GCN)中的边特征由邻接矩阵表示,只能用二元指示变量或一维实值表示,无法表达丰富的边信息。图1b显示了多维边特征表示。边特征不再用简单的邻接矩阵中的一维实值表示,而是用可学习的特征向量表示,可以表达丰富的边信息,并且可以跨层更新。

(a) 普通GCN中的边特征表示和节点特征表示;(b) CEN-DGCNN 中使用的边特征表示和节点特征表示。

现有的GNN方法主要关注如何有效地获得准确的节点特征,而忽略了边信息的利用。尽管Gilmer等人提出的消息传递神经网络(MPNN)框架允许边信息和节点信息都参与消息传递过程,但大多数先进模型仍然关注节点特征而忽略边特征。Kipf等人通过逼近图拉普拉斯算子的切比雪夫多项式简化了谱卷积,并提出了基于非谱方法的图卷积网络(GCN)。GCN通过将感受野限制为每个节点的1跳邻居来简化卷积滤波器,但信息聚合的过程没有考虑节点的1跳邻居与节点本身之间的不同关系,也没有考虑边特征。在许多场景中,边可以有不同的类别标签。例如,在社交网络中,边可以被标记为朋友关系、家庭关系、工作关系等。因此,Schlichtkrull等人提出了关系图卷积网络(R-GCNs),将GCN推广到具有多种关系的图数据,可以根据边的类型聚合信息。大多数GCN方法使用拉普拉斯算子或邻接矩阵来聚合节点信息,没有考虑不同节点对之间的不同连接权值。Veličković 等人提出了图注意力网络(GAT),根据不同节点对的特征赋予权重,为每个节点训练与其邻居相关的权重系数。本质上,GAT中的权重是节点特征的函数,两个边相连的节点之间的注意力权重系数是根据两个节点的特征向量计算出来的,因此GAT对节点特征和结构特征的融合有更强的适应性,并取得更好的成绩。然而,边缘也包含着丰富的信息。因此,开发一种能够同时学习节点特征和边特征的 GNN 模型。该模型将有助于基于从边特征获取的知识来学习节点特征。这种方法将使节点能够获取更精确和更全面的信息,同时还可以学习边嵌入以增强边特征的表示。

大多数现有浅层GCN模型成功的主要原因是在某些应用场景中,节点特征主要依赖于其局部邻域的短程信息。例如,在社交网络中,友谊仅限于“小世界”,仅通过堆叠几层GCN就可以将感受野扩展到几跳的本地邻居节点。堆叠更多层甚至可能导致过度平滑和过度挤压,这反而使网络性能急剧下降,过度平滑问题在连续时间GNN领域也存在。GNN 的缺点之一是固定的聚合距离,它决定了被认为与每个节点相关的其他节点的数量,并由 GNN 模型中的层数决定。当网络规模变大,或者特殊应用背景下的节点特征需要考虑远程节点依赖时,就需要更深的GCN来扩大感受野。例如,分子化学性质的预测可能需要相对侧的原子组合。Li等人使用他们构建的56层图卷积神经网络对点云数据进行语义分割,并取得了比浅层网络更好的性能。更大的图和网格还需要深度 GCN 来捕获节点之间的远程依赖关系。但训练深度GCN仍然存在两个问题。一是过度平滑的现象:由于模型的递归邻域聚合,每个节点将几乎全局的节点信息聚合到自己身上,这会导致所有节点的特征变得无法区分。二是过度挤压现象:由于网络太深,多次迭代会将大量邻域节点的信息聚合到自身中,并被过度压缩为固定大小的向量,这可能会导致信息失真,使得 深层GNN网络模型的性能劣于浅层模型。Rusch等人提出,缓解过度平滑是构建深度GNN的必要条件。为了使节点能够有效地聚合来自远程节点的信息,从而获得非局部结构特征和更复杂的节点特征,目标是建立一个满足这些标准的深度图神经网络框架,同时减轻过度平滑和过度平滑的问题。过度挤压。

提出使用深度图卷积神经网络(CEN-DGCNN)来共同嵌入边和节点来解决上述问题。放弃了传统GCN中使用二元指示变量或一维实值来表示边特征的方法,并引入多维边嵌入表示以充分利用边信息。并且正在提出一种新的消息传递框架来集成多维边特征和节点特征,从而充分利用节点信息和边信息。同时,为了满足需要捕获节点远程依赖关系的应用场景,我们还构建了消息传递框架,引入了残差连接和密集连接的思想。基于该框架,可以设计深度图卷积神经网络来挖掘节点之间的远程依赖关系。此外,我们还构造了一个新的图卷积层,每一层都可以同时学习节点特征和边特征,并且可以跨层迭代更新。将边学习和节点学习集成到同一个卷积层中,大大提高了模型的效率,降低了模型的复杂度。实验结果表明,我们提出的方法在节点分类和链路预测任务中都达到了最先进的性能,特别是对于具有有向边的数据集。

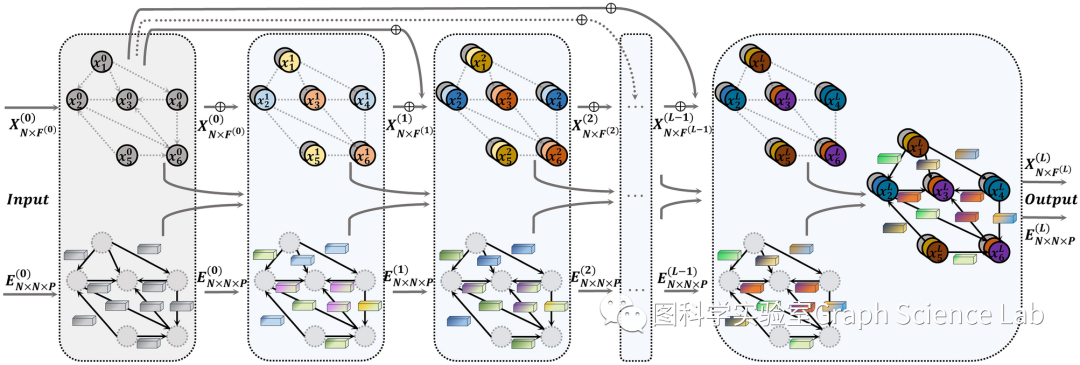

CEN-DGCNN的架构

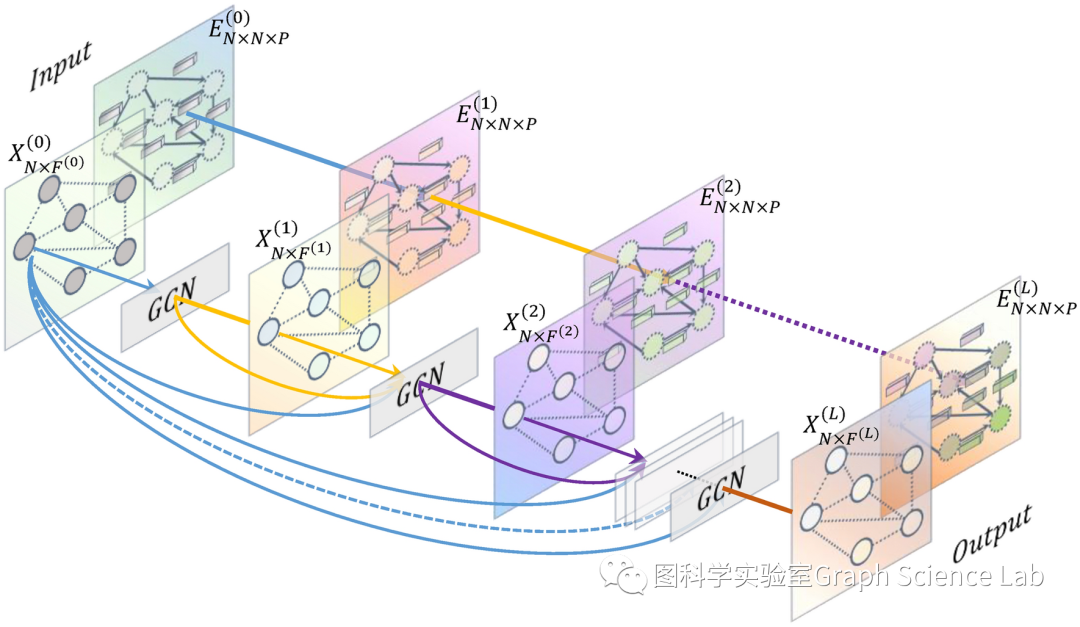

深度图卷积神经网络(CEN-DGCNN)边和节点共嵌入的总体架构。

CEN-DGCNN 与传统的 GCN 有几个结构上的差异。具体来说:(1)CEN-DGCNN充分利用了边特征信息,将边属性与边特征向量相关联,并使用多维特征向量来表示边缘,而不是普通GCN中使用的一维边特征或二值边指示符。(2)CEN-DGCNN采用多维边特征矩阵(如图1b所示)作为多通道滤波器,而不是像普通GCN那样使用二元邻接矩阵或一维正矩阵作为单通道滤波器。(3) CEN-DGCNN 将边特征学习为可学习参数,可以跨层调整,而不是像普通 GCN 在每一层使用相同的邻接矩阵。(4) CEN-DGCNN 与浅层 GCN 结构的区别在于它采用了深层架构,同时有效地缓解了过度平滑和过度挤压问题。(5) CEN-DGCNN 在每一层并行执行节点嵌入和边嵌入,有效融合节点和边特征进行图卷积。

消息传递框架

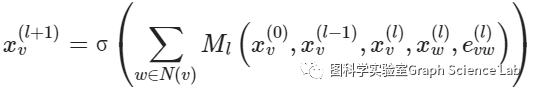

目前,图神经网络主要有三种通用框架:消息传递神经网络(MPNN)、非局部神经网络(NLNN)和图网络(GN)。在 MPNN 框架中,节点表示是通过消息和更新函数迭代传播消息 K 轮而获得的。虽然MPNN提出的消息函数旨在聚合节点信息、邻居节点和边,但大多数基于MPNN框架的GNN模型由于缺乏边特征而没有聚合边信息。NLNN框架是基于注意力机制的图神经网络模型的概括,而图注意力网络(GAT)可以认为是一个特例。GN 提出了一个更全面的模型。因为CEN-DGCNN模型需要满足大规模图的应用场景,需要捕获节点的非局部结构特征,还需要聚合多维边特征。因此,CEN-DGCNN采用的消息传递框架需要满足以下三个要求:(1)提取非局部结构特征的能力;(2)防止过度平滑的能力;(3)聚合多维边特征的能力。为了满足这些要求,提出了一种新的图神经网络消息传递框架,如下:

新颖的图神经网络消息传递框架。

新框架可以同时聚合邻居节点信息和多维边特征到中心节点,适合深度图卷积神经网络模型的构建。该框架借鉴了残差连接和密集连接的思想,每层节点特征聚合了部分初始节点特征和上一层节点特征,有效避免了过度平滑的问题。该框架具有以下三个特点:(1)可以获得节点非局部结构特征和更精细的高阶特征;(2)可以有效避免过度平滑问题;(3)多维边特征可以聚合到中心节点。

图卷积层

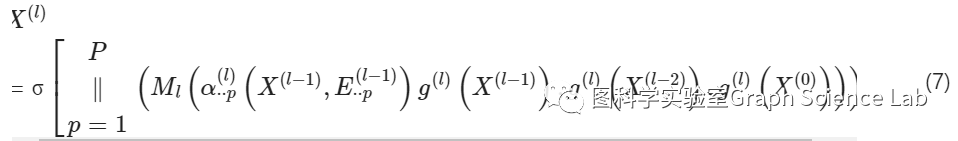

传统的GCN模型仅将边视为二元指示变量或一维实值,完全忽略了边所包含的丰富信息。在大量应用场景中,边包含属性、类型、连接强度等信息。传统的图神经网络无法表达丰富的边信息,也无法将边信息融入到模型中。并且传统GCN模型的每一层都使用原始的邻接矩阵作为单通道滤波器进行节点特征过滤。这会带来两个问题:首先,原始邻接矩阵可能包含噪声,对于滤波来说不是最优的;其次,边特征没有完全融入模型中。虽然复杂的图卷积模型可以提取精细的节点特征,但重复使用可能包含噪声的简单邻接矩阵来过滤每一层节点特征将限制过滤操作的有效性。为了解决这些问题,基于上一节提出的新消息传递框架引入以下信息聚合操作:

随层数参数变化的权重矩阵衰减。

聚合函数

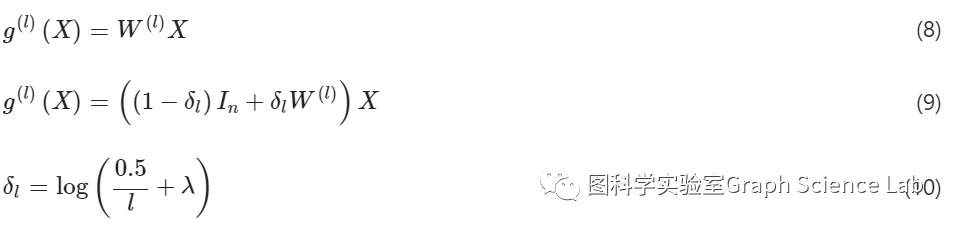

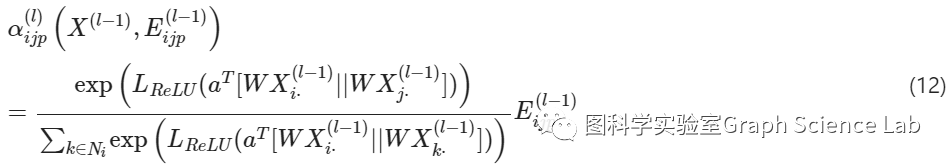

基于注意力机制的边特征更新

如图所示,边特征根据其连接的两个节点的特征进行更新。同时,节点会聚合其邻居节点特征和边特征来更新自己的特征。上述边特征更新和节点特征更新在同一个图卷积层中同时进行。

CEN-DGCNN的边特征更新和节点特征更新。

基于注意力机制的过滤器

边特征矩阵的更新方程

由于边特征在学习过程中会产生随机噪声,而各种应用场景下的图数据本身也可能存在噪声,因此需要对每一层学习到的边特征矩阵进行去噪。Wang等人提出使用双随机矩阵进行网络增强,并证实了双随机矩阵的网络去噪性能。实验证明,他们提出的网络增强方法去除了弱边,增强了真实连接,使下游任务表现更好。为了提高CEN-DGCNN的性能,对每一层的边特征矩阵进行双随机归一化,归一化后得到的最终边特征矩阵E如下:

结果

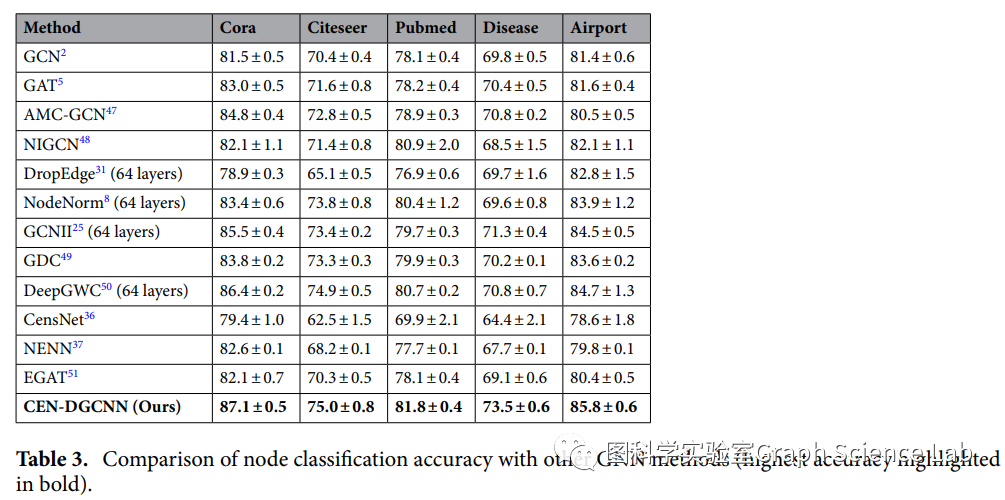

有向图的节点分类

从 CEN-DGCNN 优于所有 12 种基线方法的结果,新的非局部消息传递框架在学习节点特征表示方面非常有效。

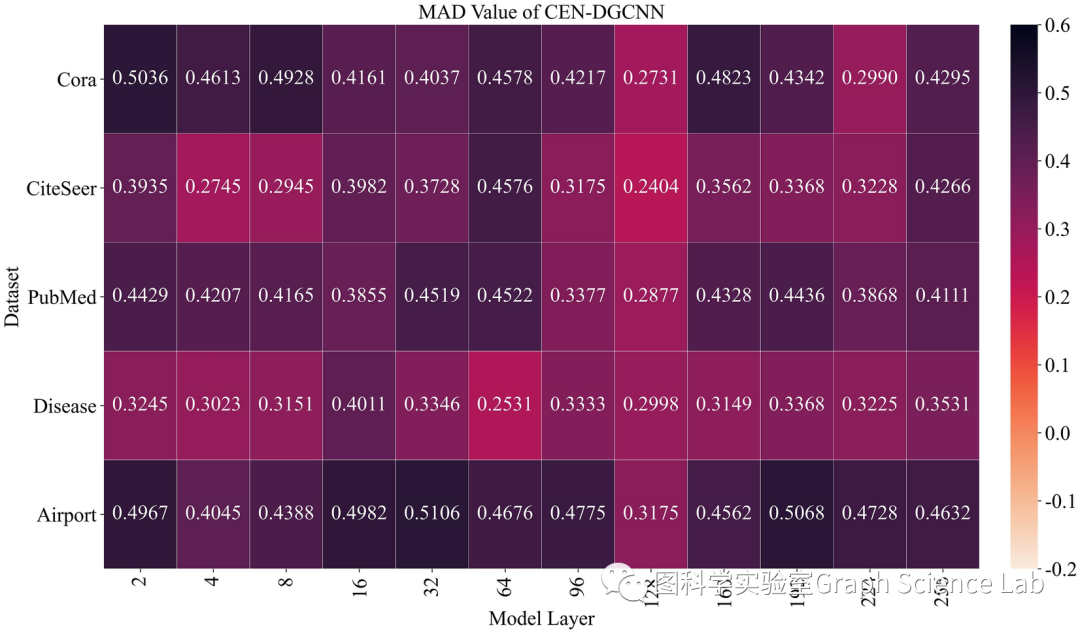

CEN-DGCNN 不同层在 5 个数据集上的 MAD 值。

CEN-DGCNN中节点的平滑度随着图卷积层数的增加而缓慢下降。事实上,MAD值甚至随着层数的加深而增加,表明模型可以避免过度平滑。

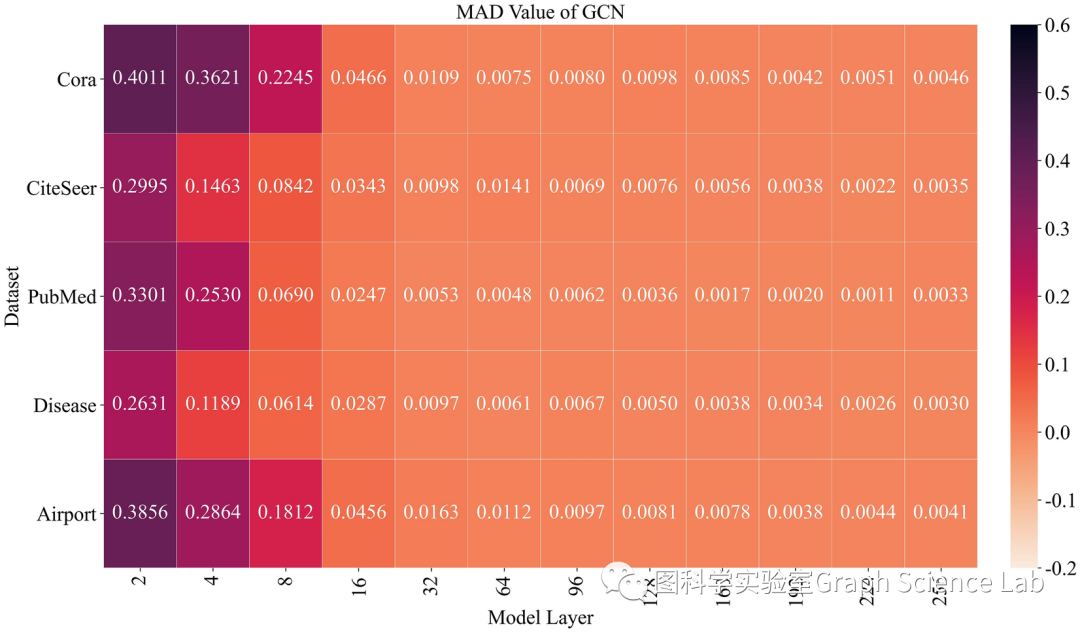

常规 GCN 不同层在 5 个数据集上的 MAD 值。

当深度达到8层时,传统的GCN模型表现出严重的过度平滑。随着层数的增加,节点特征变得难以区分,这使得模型捕获高阶节点特征和全局结构信息变得具有挑战性。

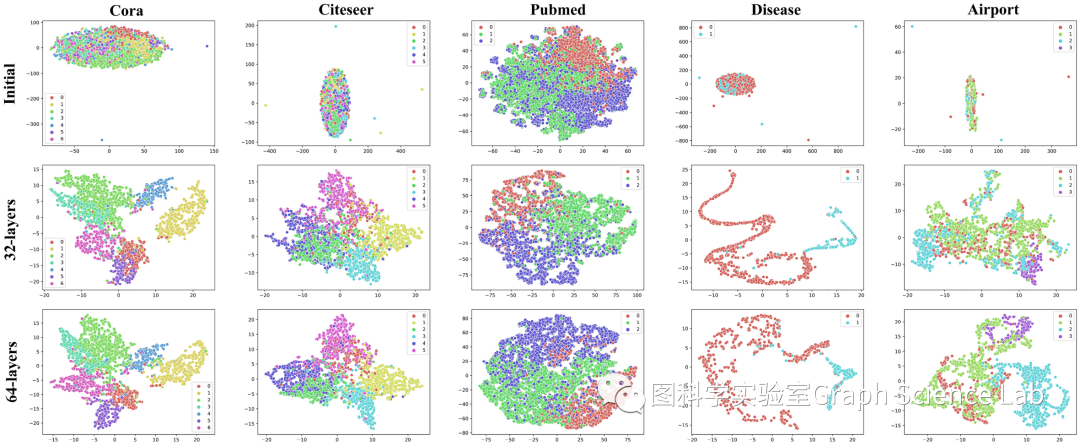

CEN-DGCNN 学习的节点表示的 t-SNE 可视化。

节点分类任务的目标是使用 GNN 模型学习不同的节点特征。每种类型的节点应该具有相似的特征,同时又不同于其他类型的节点。如果分类性能好,同类节点在空间上会聚集在一起,而不同类节点在空间上会高度分化。CEN-DGCNN 的深层结构有效地缓解了节点过度平滑问题,并实现了显着的节点分类性能。

结论

多维边特征表示方法,克服了传统GNN只能使用二值边表示和一维边特征表示的局限性。

在CEN-DGCNN中跨层更新和学习多维边特征,为下游任务提供基础。在每个图卷积层中,多维边特征矩阵还可以作为多通道滤波器来过滤节点特征。通过同步更新多维边特征和节点特征,模型降低了复杂度并提高了计算效率。

新颖的消息传递框架获取更精细的节点高阶特征,捕获节点之间的远程依赖关系和全局结构特征。

CEN-DGCNN基于该框架实现了非常深的网络结构,并消除了节点过平滑问题,从而比浅层结构表现更好。

微信群 公众号

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง