MatFormer: Nested Transformer for Elastic Inference

Devvrit, S Kudugunta, A Kusupati, T Dettmers, K Chen, I Dhillon, Y Tsvetkov, H Hajishirzi, S Kakade, A Farhadi, P Jain

[Google Research & University of Texas at Austin & University of Washington]

MatFormer:用于弹性推理的嵌套Transformer

-

MatFormer是一个新的Transformer架构,可以训练一个通用模型,然后从中提取成百上千个准确的小型子模型,实现弹性推理以适应各种约束。

-

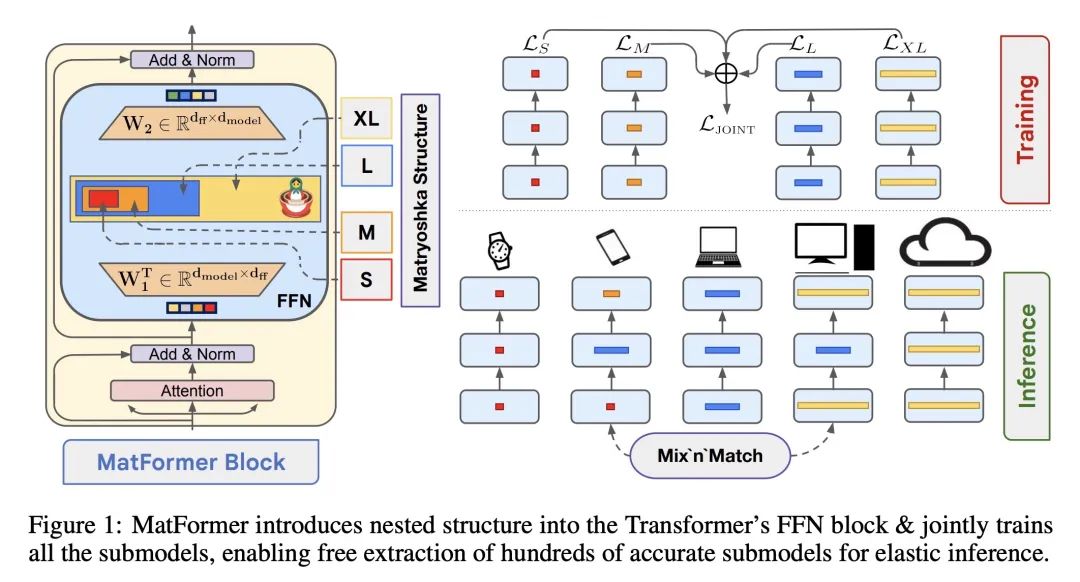

MatFormer在标准Transformer块内部引入了嵌套的子结构,通过具有不同大小的多个前馈网络(FFN)块来共享参数。

-

MatFormer联合训练每层中的显式定义的几个(例如4个)嵌套的FFN块,导致4个共享参数的嵌套子模型。

-

在推理时,可以通过跨层的“混合匹配”来生成更多无需额外训练的子模型。

-

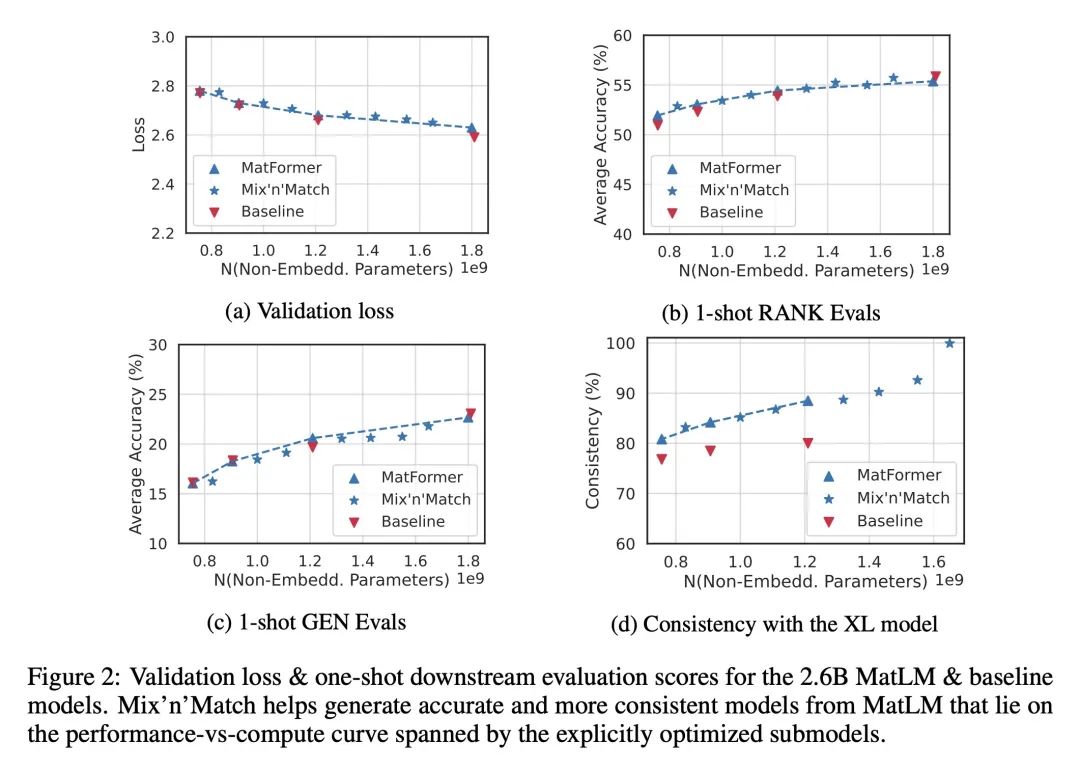

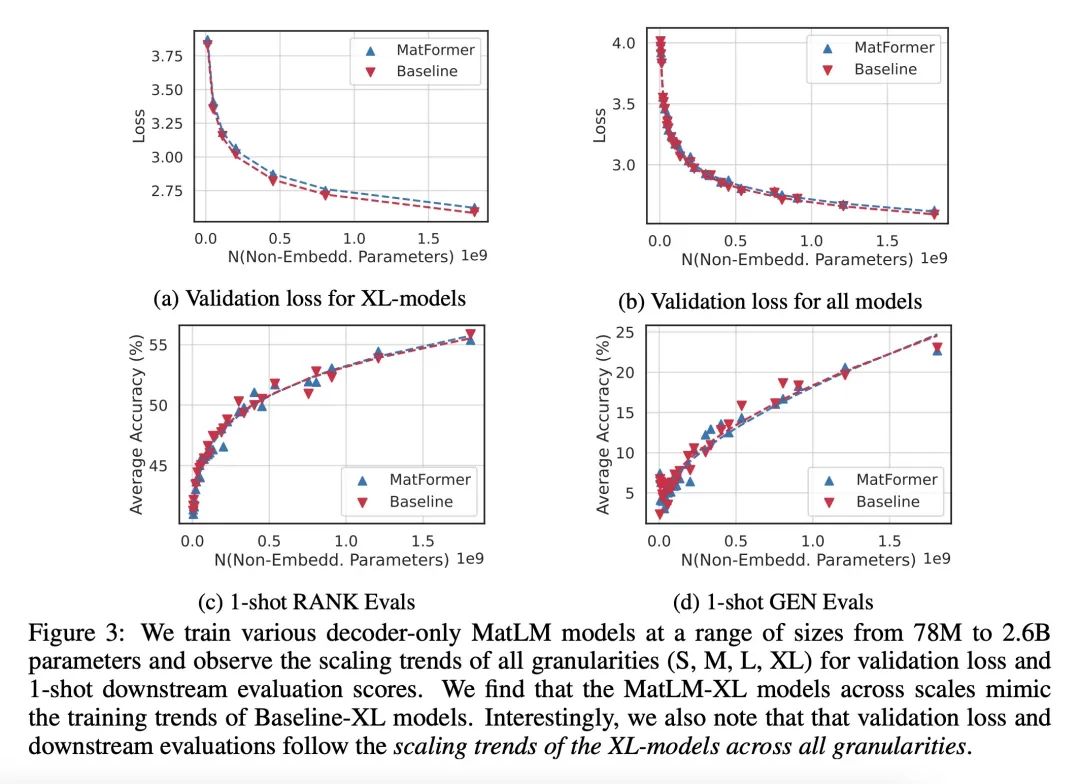

MatFormer可应用于编码器(MatViT)和解码器(MatLM)。实验表明,MatLM与独立训练的等大小的基线Transformer语言模型的困惑度和下游性能相当。

-

与对应基线模型相比,MatFormer子模型在MatLM中用于投机解码时可以实现更快的解码,在MatViT中,可以实现弹性编码器进行图像检索。

-

MatFormer展示了与基线Transformer模型相似的可靠缩放行为,同时产生准确一致的子模型,跨越计算与准确率的权衡。

动机:当前的Transformer模型在推断过程中存在多样的限制,需要训练不同大小的模型来满足不同的需求,但由于训练成本和性能限制,只能训练少数模型,限制了对相关权衡的精细控制。

方法:提出一种名为MatFormer的嵌套Transformer架构,通过联合优化每个前馈网络(FFN)块及其嵌套的较小FFN块,实现模型在不同层之间的粒度混合。可以从一个通用的MatFormer模型中提取数百个精确的较小模型,而这些模型从未经过显式优化。通过这种方式,MatFormer提供了在各种部署约束下的弹性。

优势:MatFormer的优势在于可以提供弹性推断,满足各种部署需求,实验证明其在不同模型类别、模态和规模上的有效性。

提出一种嵌套Transformer架构MatFormer,通过联合优化不同粒度的模型,实现弹性推断,从而满足不同的部署需求。

https://arxiv.org/abs/2310.07707

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง