标题:MemGPT: Towards LLMs as Operating Systems

链接:https://arxiv.org/abs/2310.08560

作者:Charles Packer, Vivian Fang, Shishir G. Patil, Kevin Lin, Sarah Wooders, Joseph E. Gonzalez

单位:加州大学伯克利分校

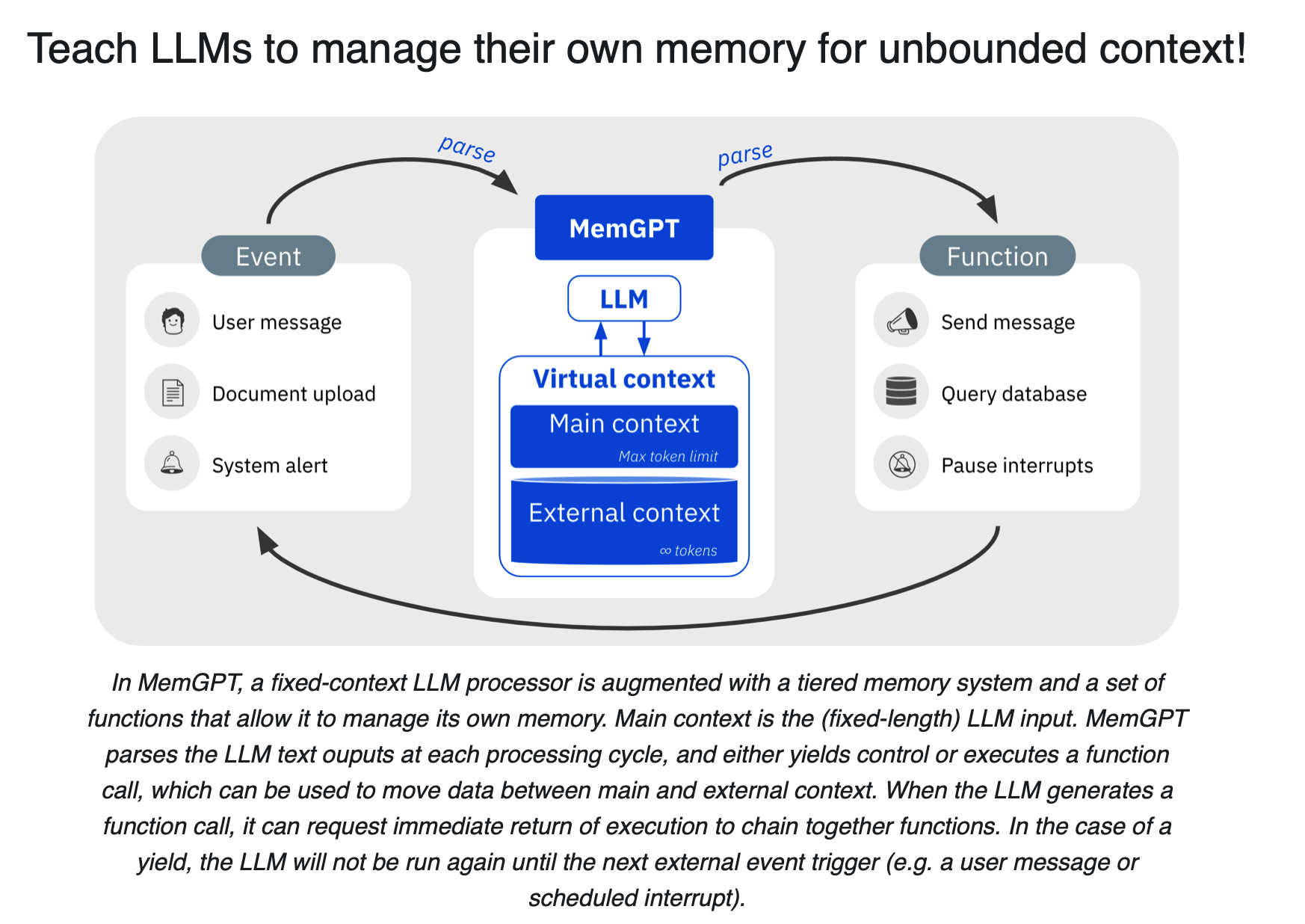

大型语言模型 (LLM) 彻底改变了人工智能,但 LLM 受到有限的上下文窗口的限制,阻碍了它们在扩展对话和文档分析等任务中的实用性。为了能够在有限的上下文窗口之外使用上下文,本文作者提出了虚拟上下文管理(virtual context management),该技术灵感来源于传统操作系统中的分层内存系统,通过快速内存和慢速内存之间的数据移动提供较大内存资源的可能。

使用这种技术,作者引入了 MemGPT(Memory-GPT),这是一个智能管理不同内存层次的系统,以便在 LLM 有限的上下文窗口内有效地提供扩展上下文,并利用中断(interrupts)来管理其自身和用户之间的控制流程。研究者在文档分析(document analysis)和对话代理(conversational agents)两个领域上检验了 MemGPT 的效果,结果表明 MemGPT 可以分析远超底层 LLM 上下文窗口的大型文档,并且 MemGPT 可以创建会话代理,通过与用户的长期交互来记忆、反映和动态发展。

项目地址:https://memgpt.ai/

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง