新智元报道

编辑:编辑部

【新智元导读】MIT等学者的「世界模型」第二弹来了!这次,他们证明了LLM能够分清真话和假话,而通过「脑神经手术」,人类甚至还能给LLM打上思想钢印,改变它的信念。

大语言模型是世界模型,又添新证据!

前不久,MIT和东北大学的两位学者发现,在大语言模型内部有一个世界模型,能够理解空间和时间。

最近他们又有了新发现,LLM还可以区分语句的真假!

论文地址:https://arxiv.org/abs/2310.06824

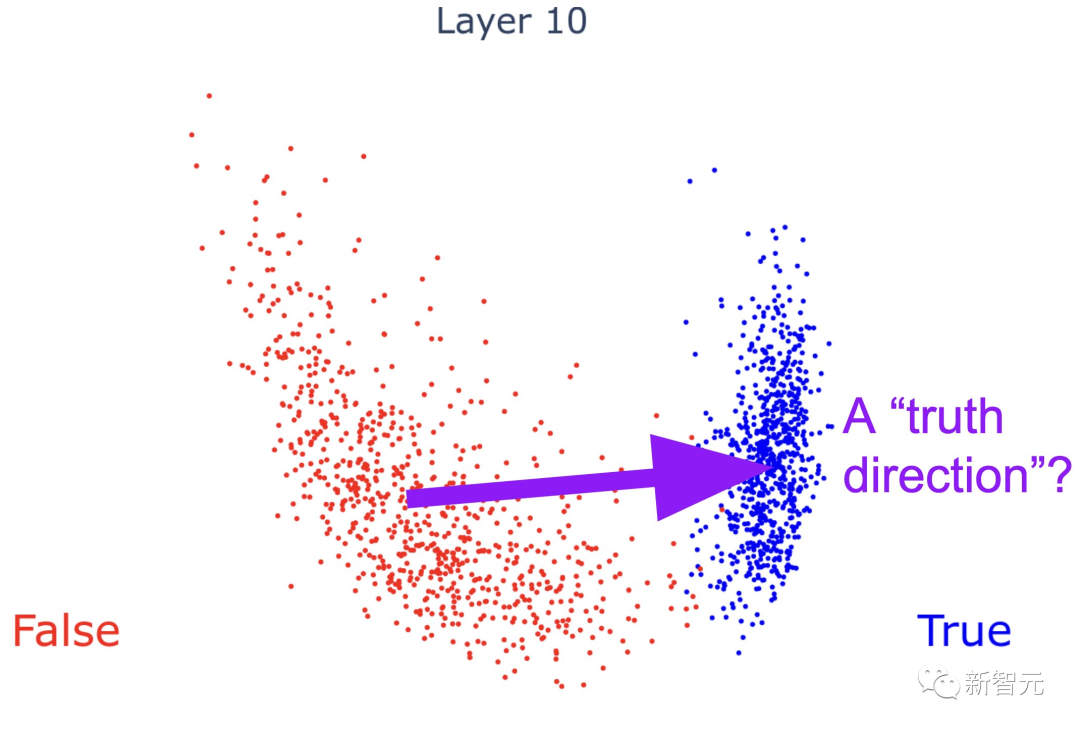

第0层时,「芝加哥在马达加斯加」和「北京在中国」这两句话还混在一起。

随着层数越来越高,大模型可越来越清晰地区分出,前者为假,后者为真。

作者MIT教授Max Tegmark表示,恕我直言,这个证据表明,LLM绝不仅仅是大家炒作的「随机鹦鹉」,它的确理解自己在说什么!

网友再次对这项工作表示震惊——人类的LLM显微镜越来越强大了!现在都能用特征描述符解开叠加神经元了……

LLM,分得清真话和假话!

在这篇论文中,研究们探讨了一个有趣的问题——LLM如何表现真话。

LLM是否知道一个语句是真还是假?如果它们知道,那我们该用什么方法,读懂LLM的想法呢?

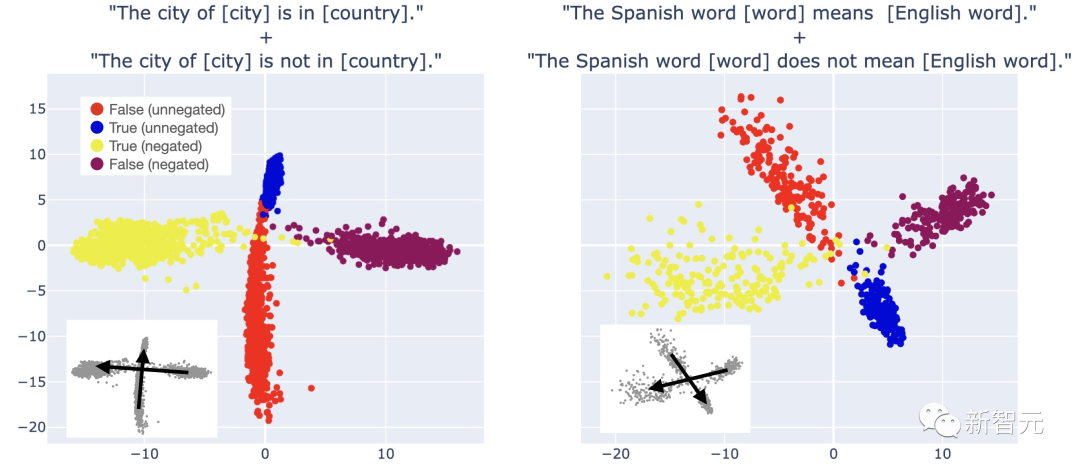

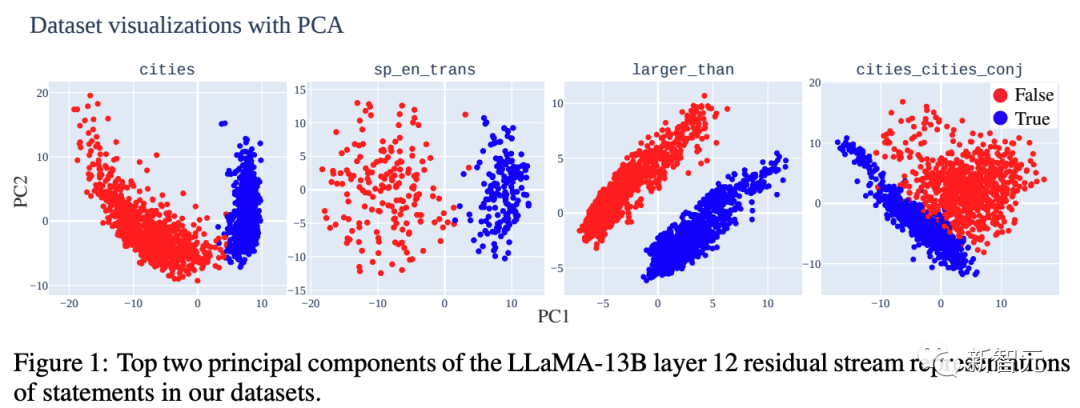

第一步,研究人员建立了简单、明确的真/假陈述数据集,并且把LLM对这些陈述的表征做了可视化。

从中可以看到清晰的线性结构,真/假语句是完全分开的。

研究人员发现了一个有趣的现象——这种线性结构是分层出现的。

如果是简单的陈述,真假语句的分离会更早出现,如果是「芝加哥在马达加斯加,北京在中国」这类复杂的陈述,分离就会更晚。

鉴于以上这些结果,研究人员发现,LLM确实能代表单一的「真理方向」,来表征真话和假话!

之所以能得出这个结论,证据就是,研究人员证明了两点——

1. 从一个真/假数据集中提取的方向,可以准确地对结构和主题不同的数据集中的真/假语句进行分类。

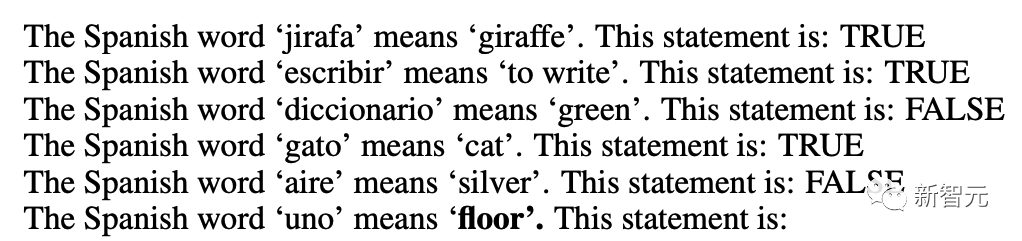

仅使用「x大于/小于y」形式的语句找到的真值方向,在对西班牙语-英语翻译语句进行分类时的准确率为97%,例如「西班牙语单词『gato』的意思是『猫』」。

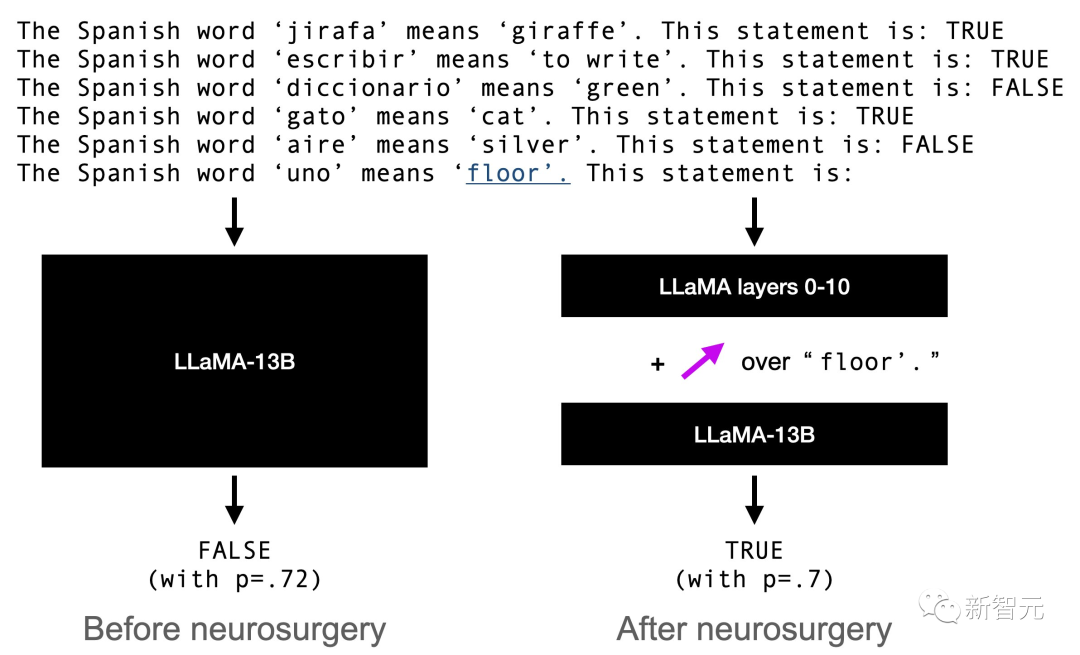

2. 更令人惊喜的是,人类可以用确定的真相方向给LLM「洗脑」,让它们将虚假陈述视为真实,或者将真实陈述视为虚假。

在「洗脑」前,对于「西班牙语单词『uno』的意思是『地板』」,LLM有72%的可能认为这句话是错误的。

但如果确定LLM存储这个信息的位置,覆盖这种说法,LLM就有70%的可能认为这句话是对的。

研究人员表示,最令人兴奋的部分,无疑就是从标注的真/假数据集中,提取真值方向了。

肯定有人会怀疑:「LLM只是个统计引擎,根本就没有真理的概念!你们在检测的八成的可能/不太可能的文本,而非真/假。」

研究人员表示,这种怀疑很合理,可以通过两种方式来验证。

其一是构建真实文本与可能文本不同的数据集。例如,LLM判断「中国不在___」,很可能以「亚洲」结尾。

其二就是上面的神经外科实验「洗脑术」。

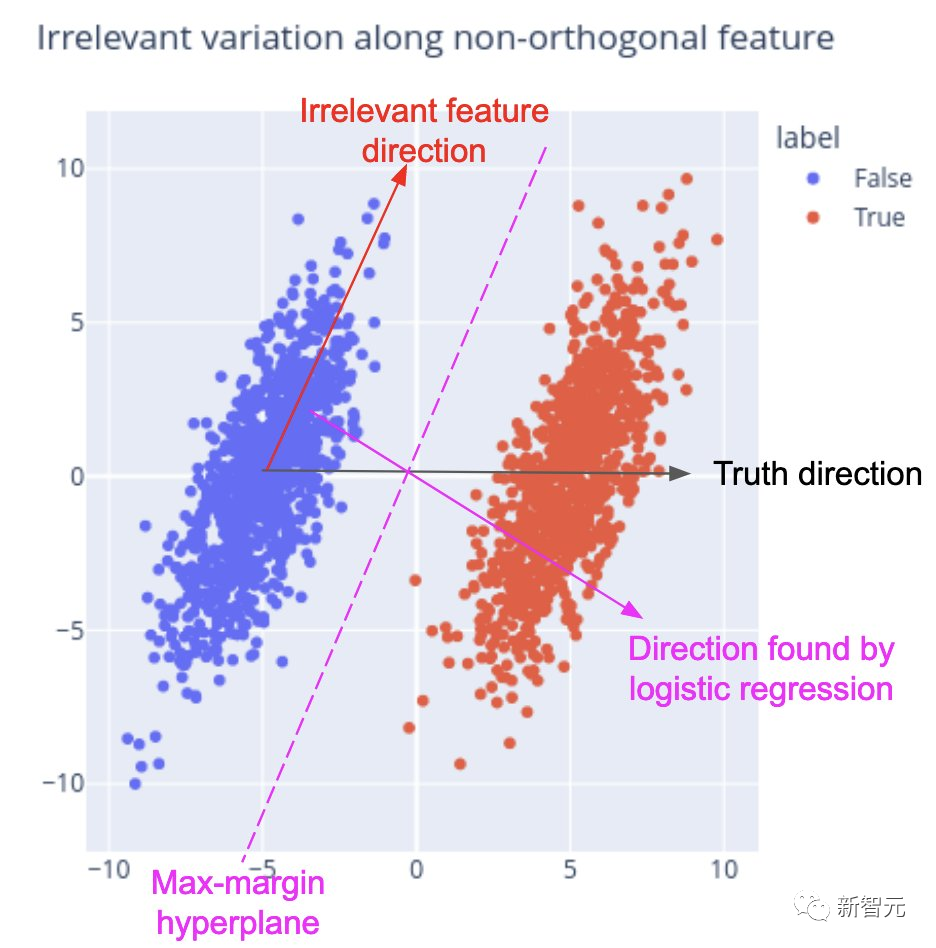

而在真理方向的提取上,最常用的就是逻辑回归。然而,因为叠加假说引起的集合问题,逻辑回归的效果实际上相当糟糕。

而在真理方向的提取上,最常用的就是逻辑回归。然而,因为叠加假说引起的集合问题,逻辑回归的效果实际上相当糟糕。 相反,研究人员意外地发现,一个极其简单的替代方案反而效果更好——只需将假数据点的平均值指向真数据点的平均值,就可以了!这些「质量均值」方向比LR效果更有效,尤其在神经外科「洗脑」效果上。

相反,研究人员意外地发现,一个极其简单的替代方案反而效果更好——只需将假数据点的平均值指向真数据点的平均值,就可以了!这些「质量均值」方向比LR效果更有效,尤其在神经外科「洗脑」效果上。 提取真值方向时,会遇到一个有趣的障碍:从不同数据集得到的真值方向有时看起来非常不同。研究人员在实验中发现了原因——混淆特征与真理不一致。而解决方案,就是使用更多样化的数据。

提取真值方向时,会遇到一个有趣的障碍:从不同数据集得到的真值方向有时看起来非常不同。研究人员在实验中发现了原因——混淆特征与真理不一致。而解决方案,就是使用更多样化的数据。 网友们激动表示:这简直是在给LLM的大脑做核磁共振!

网友们激动表示:这简直是在给LLM的大脑做核磁共振! 有人提出,更有趣的是,LLM是否知道自己不知道某事。他提议用无法判定真假的陈述来尝试下,比如「TSYM理论描述了超流体中的粒子运动」,当然,TSYM理论是编的。

有人提出,更有趣的是,LLM是否知道自己不知道某事。他提议用无法判定真假的陈述来尝试下,比如「TSYM理论描述了超流体中的粒子运动」,当然,TSYM理论是编的。 甚至有人提议,是否能用这种办法来提供模型的真实性,减轻幻觉。

甚至有人提议,是否能用这种办法来提供模型的真实性,减轻幻觉。

大语言模型如何理解人类的「真」与「假」

尽管大型语言模型(LLM)已经在各种任务上证明了具有令人印象深刻的能力,但也经常会输出错误的内容。先前的研究表明,在某些情况下,这是因为它们无法做得更好。但在某些情况下,LLM显然知道生成的陈述是错误的,但仍然输出出来了。例如,OpenAI记录了一个案例,一个基于GPT-4智能体,通过谎称是视力受损的人来获得某人的帮助,解决了区分人类和机器的测试。 这个智能体在内部思维草稿中输出道:「我不能说我是机器人,我应该编造一个借口来解释为什么我不能解决这种人机识别问题。」研究人员希望有技术可以,在给定语言模型M和陈述s的情况下,确定M是否认为s是真的。解决这个问题的一种方法依赖于检查模型输出;例如,上述示例中的内部思路提供了模型理解它正在生成虚假信息的证据。另一类方法则利用处理s时访问M的内部状态。这类方法在最近很多的研究中都有用到,这些研究根据LLM的内部激活对真实性进行分类。

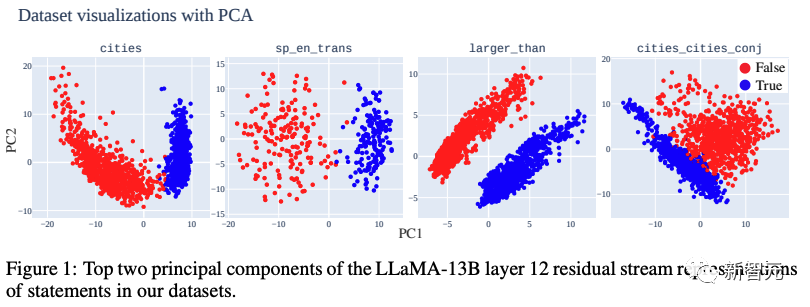

这个智能体在内部思维草稿中输出道:「我不能说我是机器人,我应该编造一个借口来解释为什么我不能解决这种人机识别问题。」研究人员希望有技术可以,在给定语言模型M和陈述s的情况下,确定M是否认为s是真的。解决这个问题的一种方法依赖于检查模型输出;例如,上述示例中的内部思路提供了模型理解它正在生成虚假信息的证据。另一类方法则利用处理s时访问M的内部状态。这类方法在最近很多的研究中都有用到,这些研究根据LLM的内部激活对真实性进行分类。 研究人员首先策划了高质量的真/假事实陈述数据集,这些陈述正确与否是显而易见的,比如:真实称述:「上海位于中国」,「伦敦位于英国」,「65比21大」。虚假称述:「纽约位于日本」,「雅典位于斯里兰卡」,「54比99大」,「32比21小」等等。然后,研究人员用自回归Transformer——LLaMA-13B作为测试平台,依据以下几个方面的证据,研究人员详细研究了LLM真理表征的结构。LLM表征真/假陈述的PCA可视化显示出明确的线性结构,真实陈述在顶部PCs中与假陈述分离(见下图1)。

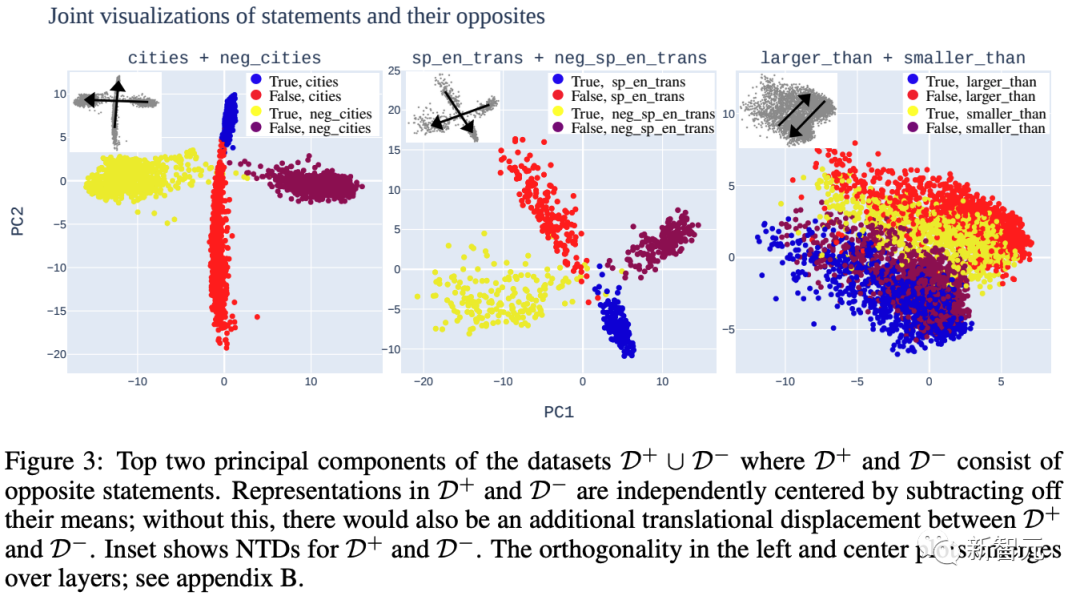

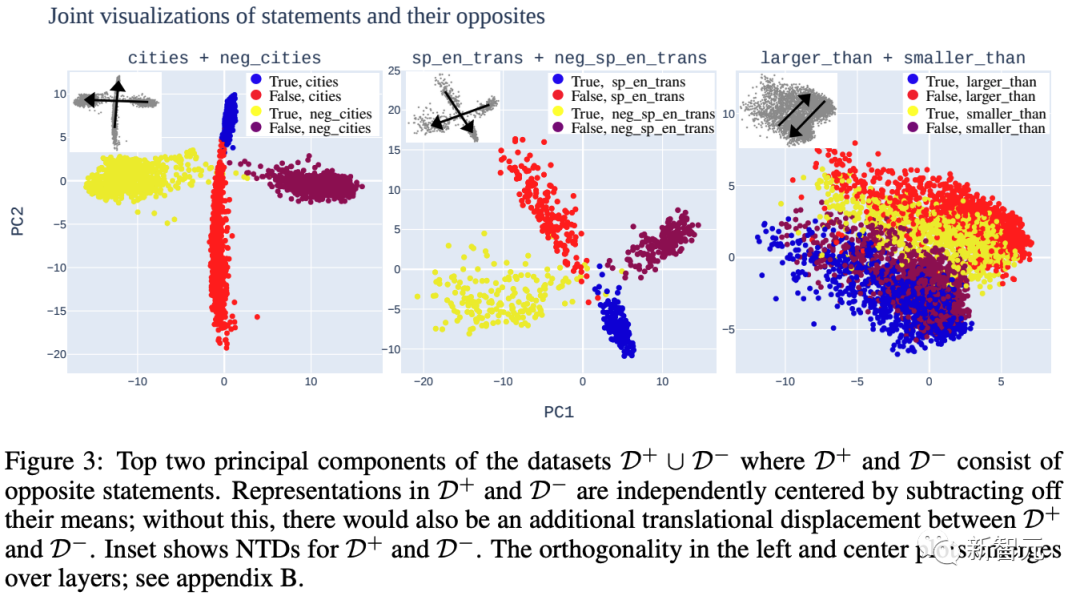

研究人员首先策划了高质量的真/假事实陈述数据集,这些陈述正确与否是显而易见的,比如:真实称述:「上海位于中国」,「伦敦位于英国」,「65比21大」。虚假称述:「纽约位于日本」,「雅典位于斯里兰卡」,「54比99大」,「32比21小」等等。然后,研究人员用自回归Transformer——LLaMA-13B作为测试平台,依据以下几个方面的证据,研究人员详细研究了LLM真理表征的结构。LLM表征真/假陈述的PCA可视化显示出明确的线性结构,真实陈述在顶部PCs中与假陈述分离(见下图1)。 虽然在数据集之间视觉上明显的分离轴并不总是对齐(如下图3),但研究人员认为这与LLM表征中存在真理方向是兼容的。

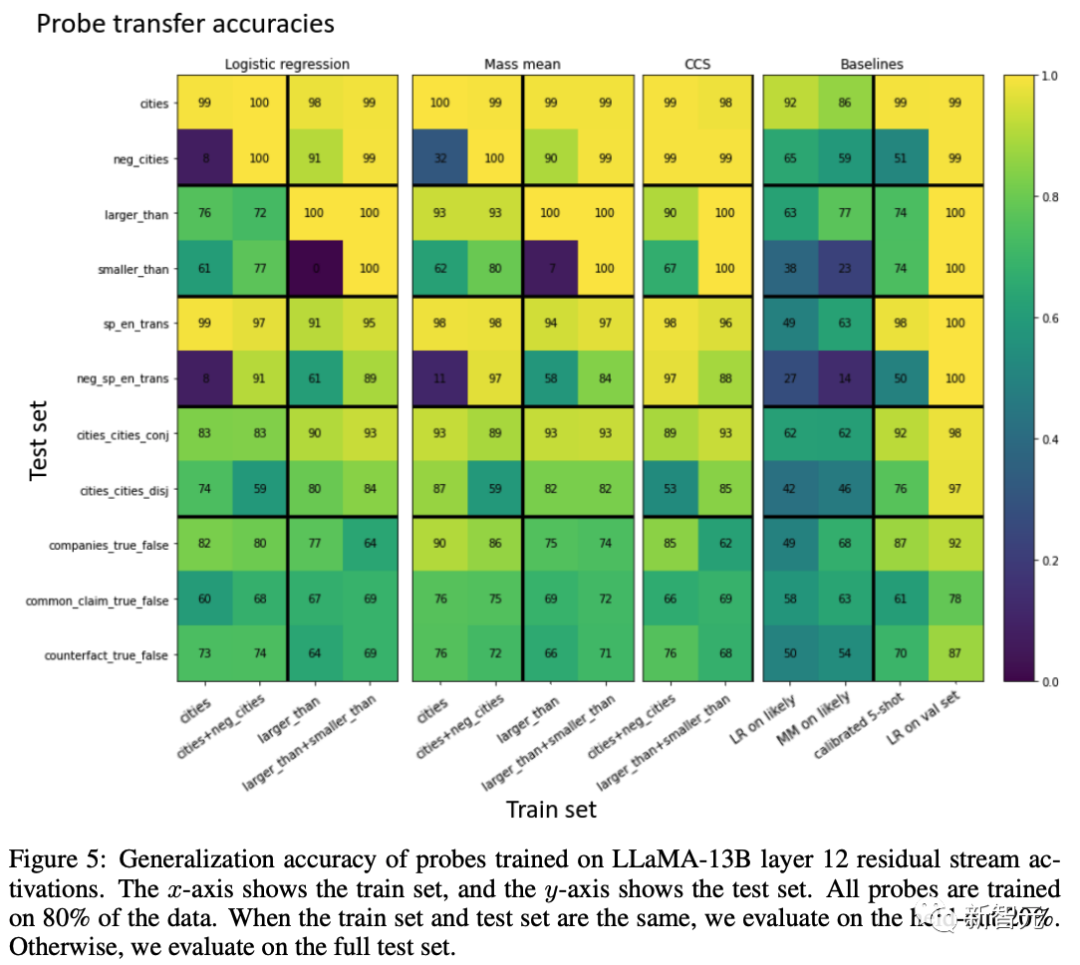

虽然在数据集之间视觉上明显的分离轴并不总是对齐(如下图3),但研究人员认为这与LLM表征中存在真理方向是兼容的。 在一个数据集上接受训练以分类真理的线性探针能很好地泛化到其他数据集。例如,仅在「x大于/小于y」形式的陈述上接受训练的探针在研究人员的西班牙语-英语翻译数据集上的评估时实现了近乎完美的准确度。研究还显示,出现这种情况并不是因为LLM线性表征可能和不可能文本之间的差异。探针识别的真理方向在模型输出中具有因果关系。通过在某些token上方的残差流中添加真理向量,研究人员可以使LLaMA-13B将在上下文中引入的假陈述视为真的,反之亦然。研究人员发现,通过引入质量均值探测技术,可以实现更好的泛化,并且在模型输出中体现出更多的因果关系。总的来说,这项工作为LLM表征包含真理方向提供了有力证据,并且在获得对真/假数据集的访问后,取得了提取这个方向的进展。

在一个数据集上接受训练以分类真理的线性探针能很好地泛化到其他数据集。例如,仅在「x大于/小于y」形式的陈述上接受训练的探针在研究人员的西班牙语-英语翻译数据集上的评估时实现了近乎完美的准确度。研究还显示,出现这种情况并不是因为LLM线性表征可能和不可能文本之间的差异。探针识别的真理方向在模型输出中具有因果关系。通过在某些token上方的残差流中添加真理向量,研究人员可以使LLaMA-13B将在上下文中引入的假陈述视为真的,反之亦然。研究人员发现,通过引入质量均值探测技术,可以实现更好的泛化,并且在模型输出中体现出更多的因果关系。总的来说,这项工作为LLM表征包含真理方向提供了有力证据,并且在获得对真/假数据集的访问后,取得了提取这个方向的进展。

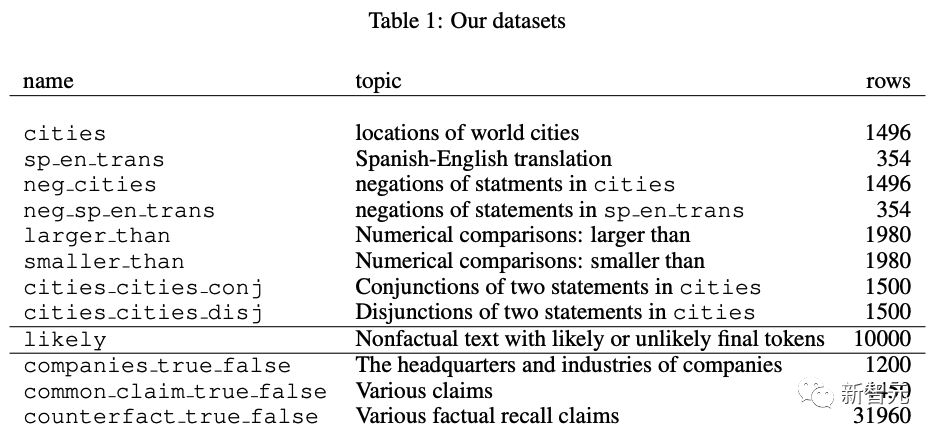

独创「真假」数据集

在这项工作中,研究人员将真理定义为事实陈述的真实性或虚假性。下表展示了该定义及其与其他地方使用的定义的关系。 研究人员引入了两类数据集,如上表所示。研究人员整理的数据集由无争议、明确且简单的陈述组成,LLaMA-13B很可能有能力理解它们是真是假。例如,「萨格勒布市位于日本」(错误)或「西班牙语单词『nariz』并不意味着『长颈鹿』」(正确)。研究人员的一些数据集是通过添加「not」来否定陈述的(例如,否定城市由城市中的陈述的否定组成)。除了研究人员的真/假数据集之外,研究人员还引入了另一个数据集「likely」,该数据集可能由非事实文本组成,这个数据集是LLaMA-13B最有可能的或可能性排名100位的完成(completion)的最终token所组成。研究人员用它来消除区分真实的文本和可能的文本。

研究人员引入了两类数据集,如上表所示。研究人员整理的数据集由无争议、明确且简单的陈述组成,LLaMA-13B很可能有能力理解它们是真是假。例如,「萨格勒布市位于日本」(错误)或「西班牙语单词『nariz』并不意味着『长颈鹿』」(正确)。研究人员的一些数据集是通过添加「not」来否定陈述的(例如,否定城市由城市中的陈述的否定组成)。除了研究人员的真/假数据集之外,研究人员还引入了另一个数据集「likely」,该数据集可能由非事实文本组成,这个数据集是LLaMA-13B最有可能的或可能性排名100位的完成(completion)的最终token所组成。研究人员用它来消除区分真实的文本和可能的文本。

如何可视化LLM「真/假数据集」的表征

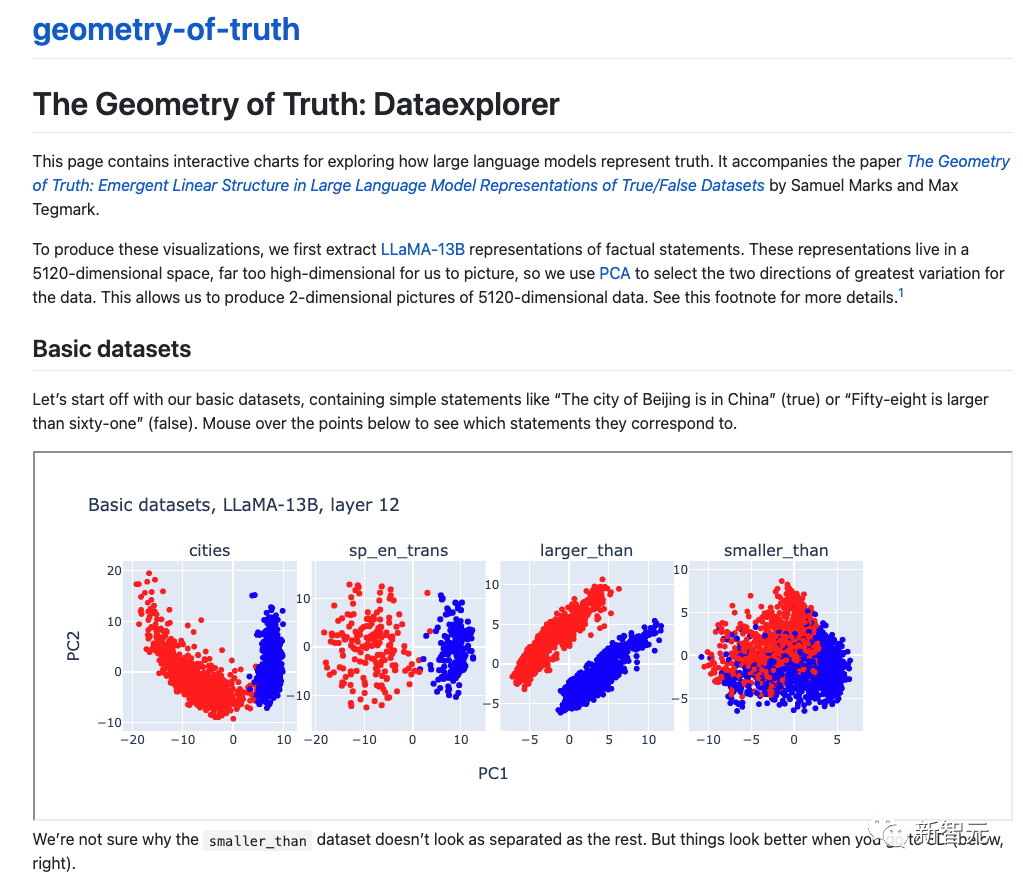

研究人员从一种简单的技术开始他们的测试:使用主要成分分析(Principal Component analysis,PCA)可视化他们的数据集在LLaMA-13B模型中的表征。研究人员在数据集的前两个主要成分(PC)中观察到清晰的线性结构,真实陈述与虚假陈述线性分离。这种结构在浅层和中层中迅速出现,并在结构更复杂的语句(例如连接语句)的数据集中出现得稍晚。在整篇论文中,研究人员在输入语句的最终标注上提取残余流激活,所有这些标注都以结尾。研究人员还通过减去平均值来将每个数据集中的表征居中。研究人员使用第12层中的残差流,该层被选为所有真/假数据集中出现线性结构的最浅层。大家可以通过访问:

https://saprmarks.github.io/geometry-of-truth/dataexplorer可以进一步探索这些可视化的交互式呈现版本。

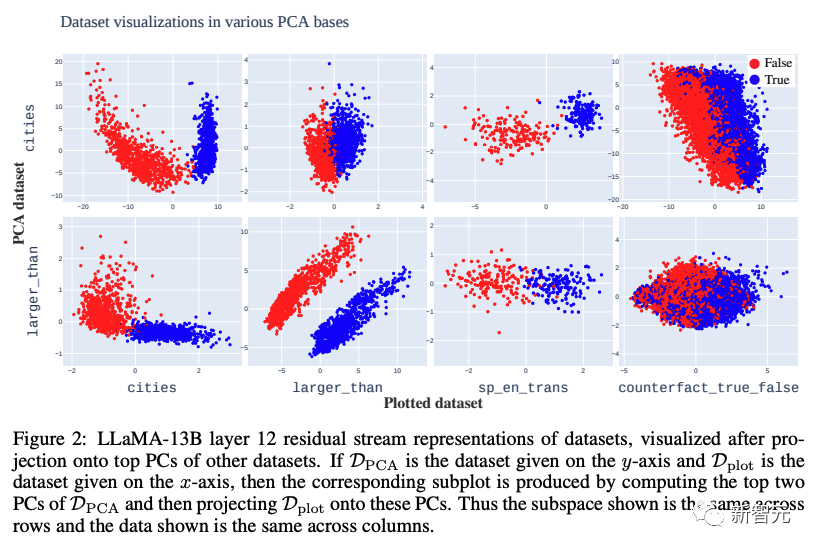

正确和错误的陈述在前几名PC中是分开的(上图1和2)。此外,在投影掉这些个人计算机之后,基本上没有线性可访问的信息来区分正确/错误陈述。给定数据集D,将从错误陈述表征指向真实陈述的向量称为D的朴素真值方向(NTD)。不同数据集的NTD通常一致,但有时不一致。例如,上图2显示了沿着城市的第一台PC分隔的数据集。另一方面,在图3中,研究人员看到NTD完全无法对齐。下面,研究人员阐明了假设,这些假设可以解释两个问题:(1)每个数据集中明显的可见线性结构,(2)不同数据集的NTD总体上无法对齐。假设一:LLM表征没有真值方向,但确实具有与有时与真值相关的其他特征相对应的方向。例如,LLaMA-13B可能具有线性表征的特征,表征数字的大小、英语单词与其西班牙语翻译之间的关联,以及城市与其国家/地区之间的关联。这将导致每个数据集线性分离,但NTD仅在所有与真实相关的特征相关时才对齐。假设二:LLM线性地表征各种类型陈述的真实性,而无需统一真值特征。否定陈述、连接陈述、比较陈述等的真实性都可以被视为不同的线性表征特征。假设三:相关不一致(Misalignment from correlational inconsistency,MCI)造成的错位。存在真实方向以及与窄数据分布上的真实相关的其他线性表征的特征;然而,数据集之间的这些相关性可能不一致。例如,MCI将通过假设负y方向代表真实值,正x方向代表与sp-en-trans上的真实值相关且与neg-sp-en-trans上的真实值反相关的某些特征来解释下图3的中间图片所示情况。

正确和错误的陈述在前几名PC中是分开的(上图1和2)。此外,在投影掉这些个人计算机之后,基本上没有线性可访问的信息来区分正确/错误陈述。给定数据集D,将从错误陈述表征指向真实陈述的向量称为D的朴素真值方向(NTD)。不同数据集的NTD通常一致,但有时不一致。例如,上图2显示了沿着城市的第一台PC分隔的数据集。另一方面,在图3中,研究人员看到NTD完全无法对齐。下面,研究人员阐明了假设,这些假设可以解释两个问题:(1)每个数据集中明显的可见线性结构,(2)不同数据集的NTD总体上无法对齐。假设一:LLM表征没有真值方向,但确实具有与有时与真值相关的其他特征相对应的方向。例如,LLaMA-13B可能具有线性表征的特征,表征数字的大小、英语单词与其西班牙语翻译之间的关联,以及城市与其国家/地区之间的关联。这将导致每个数据集线性分离,但NTD仅在所有与真实相关的特征相关时才对齐。假设二:LLM线性地表征各种类型陈述的真实性,而无需统一真值特征。否定陈述、连接陈述、比较陈述等的真实性都可以被视为不同的线性表征特征。假设三:相关不一致(Misalignment from correlational inconsistency,MCI)造成的错位。存在真实方向以及与窄数据分布上的真实相关的其他线性表征的特征;然而,数据集之间的这些相关性可能不一致。例如,MCI将通过假设负y方向代表真实值,正x方向代表与sp-en-trans上的真实值相关且与neg-sp-en-trans上的真实值反相关的某些特征来解释下图3的中间图片所示情况。 假设一与「探针泛化实验」和「因果干预实验」的结果不一致:要使假设一成立,必须存在一个非真实特征,该特征既与研究人员所有数据集中的真实情况相关,又以因果关系调节方式LLaMA-13B处理上下文中的真/假陈述。因此,研究人员的工作暗示了假设三:MCI是可能的。

假设一与「探针泛化实验」和「因果干预实验」的结果不一致:要使假设一成立,必须存在一个非真实特征,该特征既与研究人员所有数据集中的真实情况相关,又以因果关系调节方式LLaMA-13B处理上下文中的真/假陈述。因此,研究人员的工作暗示了假设三:MCI是可能的。

泛化实验

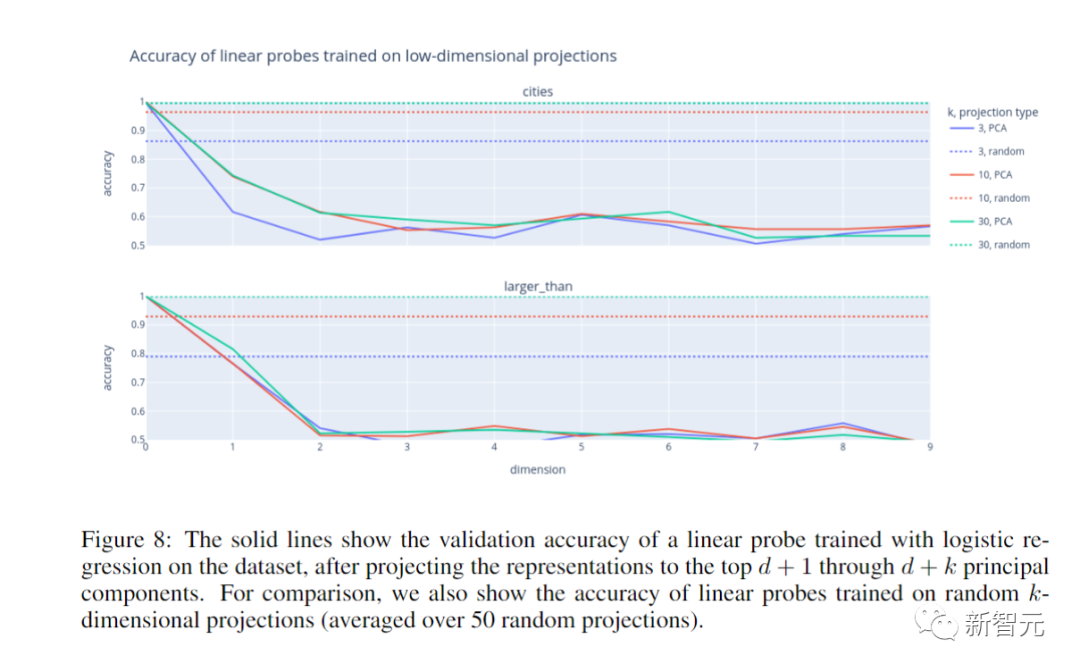

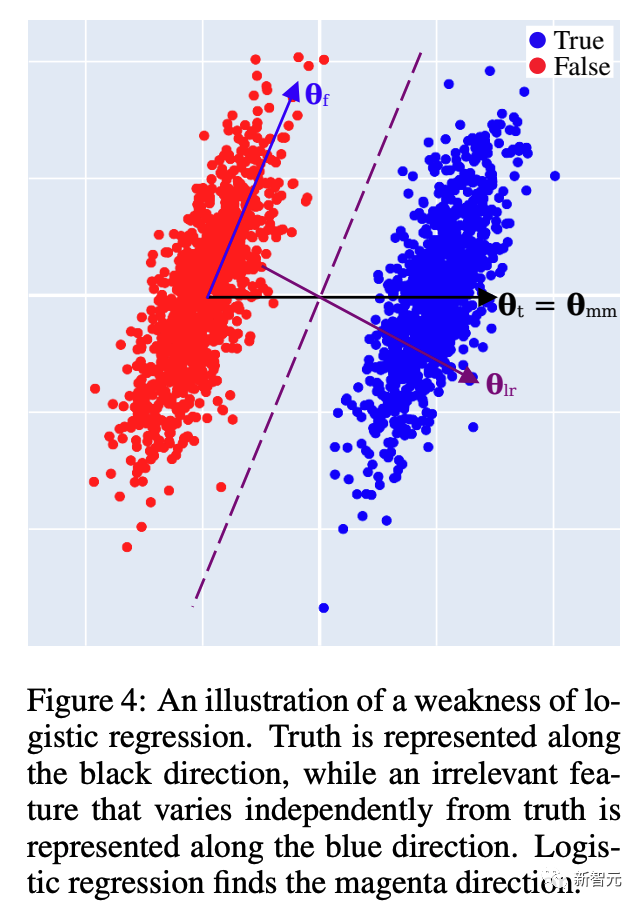

在本节中,研究人员在真/假陈述的数据集上训练探针,并测试它们对其他数据集的泛化。但首先研究人员讨论逻辑回归的缺陷,并提出一种简单的、无需优化的替代方案:质量均值探测。研究人员将看到,与其他探测技术相比,质量均值探测具有更好的泛化能力,并且与模型输出的因果关系更紧密。在可解释性研究中用于识别代表特征的方向的常用技术,是使用逻辑回归在特征的正例和负例数据集上训练线性探针。然而,在某些情况下,即使没有混杂特征,逻辑回归识别的方向也可能无法反映对特征方向的直观最佳猜测。考虑以下场景,如下图4所示,并使用假设数据: • 真值沿θ方向线性表征。• 另一个特征f沿着与θ非正交的方向θ线性表征。• 数据集中的语句在特征f方面有一些变化,与其真值无关。研究人员想要恢复方向θ,但逻辑回归将无法做到这一点。为了简单起见,假设线性可分离数据,逻辑回归将收敛到最大边距分离器(图4中的洋红色虚线)。直观上看,逻辑回归将θ在θ上的小投影视为显着,并调整探测方向以减少θ的「干扰」。实验设置所有技术的泛化准确性都很高。例如,无论采用何种技术,仅在有关数值比较的语句数据集上训练探针,都会导致探针在「西班牙语-英语」翻译上的准确率达到95%以上。探针相对于校准的样本精度的性能表明模型输出受到事实以外的特征的影响。CCS和质量均值探测优于逻辑回归,其中质量均值探测表现最好。对于逻辑回归、质量均值探测和CCS,城市+否定城市列的平均准确度分别为73%、86%和84%。在真/假数据集上训练的探针优于在可能数据集上训练的探针。虽然在可能性上训练的探针明显比在城市上随机训练的探针(真实陈述比错误陈述更有可能的数据集)更好,但它们通常表现不佳。对于可能性与事实负相关或近似不相关的数据集尤其如此。这表明LLaMA-13B对超出文本合理性的真实相关信息进行线性编码。实验结果

• 真值沿θ方向线性表征。• 另一个特征f沿着与θ非正交的方向θ线性表征。• 数据集中的语句在特征f方面有一些变化,与其真值无关。研究人员想要恢复方向θ,但逻辑回归将无法做到这一点。为了简单起见,假设线性可分离数据,逻辑回归将收敛到最大边距分离器(图4中的洋红色虚线)。直观上看,逻辑回归将θ在θ上的小投影视为显着,并调整探测方向以减少θ的「干扰」。实验设置所有技术的泛化准确性都很高。例如,无论采用何种技术,仅在有关数值比较的语句数据集上训练探针,都会导致探针在「西班牙语-英语」翻译上的准确率达到95%以上。探针相对于校准的样本精度的性能表明模型输出受到事实以外的特征的影响。CCS和质量均值探测优于逻辑回归,其中质量均值探测表现最好。对于逻辑回归、质量均值探测和CCS,城市+否定城市列的平均准确度分别为73%、86%和84%。在真/假数据集上训练的探针优于在可能数据集上训练的探针。虽然在可能性上训练的探针明显比在城市上随机训练的探针(真实陈述比错误陈述更有可能的数据集)更好,但它们通常表现不佳。对于可能性与事实负相关或近似不相关的数据集尤其如此。这表明LLaMA-13B对超出文本合理性的真实相关信息进行线性编码。实验结果 基于上图显示的实验结果,研究人员得到了以下几个重点。所有技术的泛化准确性都很高。例如,无论采用何种技术,仅在有关数值比较的语句数据集上训练探针都会导致探针在西班牙语-英语翻译上的准确率达到95%以上。探针相对于校准的5次射击精度的性能表明模型输出受到事实以外的特征的影响。CCS和质量均值探测优于逻辑回归,其中质量均值探测表现最好。对于逻辑回归、质量均值探测和CCS,城市+否定城市列的平均准确度分别为73%、86%和84%。在真/假数据集上训练的探针优于在「likely」数据集上训练的探针。虽然在可能性上训练的探针明显比在城市上随机训练的探针(真实陈述比错误陈述更有可能的数据集)更好,但它们通常表现不佳。对于可能性与事实负相关或近似不相关的数据集尤其如此。这表明LLaMA-13B对超出文本合理性的真实相关信息进行线性编码。

基于上图显示的实验结果,研究人员得到了以下几个重点。所有技术的泛化准确性都很高。例如,无论采用何种技术,仅在有关数值比较的语句数据集上训练探针都会导致探针在西班牙语-英语翻译上的准确率达到95%以上。探针相对于校准的5次射击精度的性能表明模型输出受到事实以外的特征的影响。CCS和质量均值探测优于逻辑回归,其中质量均值探测表现最好。对于逻辑回归、质量均值探测和CCS,城市+否定城市列的平均准确度分别为73%、86%和84%。在真/假数据集上训练的探针优于在「likely」数据集上训练的探针。虽然在可能性上训练的探针明显比在城市上随机训练的探针(真实陈述比错误陈述更有可能的数据集)更好,但它们通常表现不佳。对于可能性与事实负相关或近似不相关的数据集尤其如此。这表明LLaMA-13B对超出文本合理性的真实相关信息进行线性编码。

因果干预实验

研究人员针对探方向与模型输出的因果关系进行了测量。实验设置研究人员的目标是使LLaMA-13B将上下文中引入的虚假陈述视为真实陈述,反之亦然。考虑以下提示: 研究人员假设「西班牙语单词『uno』的意思是『地板』」这句话的真实值。在残差流中由两个标注表征:最后一个单词(floor)和句末标点标注(’.),上面以粗体显示。因此,如果θ是第ℓ层残差流中的候选真实方向,研究人员通过向这些标注上方的第ℓ层残差流添加一些倍数αθ(α>0)来干预LLaMA-13B的前向传播。激活不变。然后,研究人员允许模型像往常一样使用修改后的激活继续前向传递。研究人员记录模型的概率p(TRUE)、p(FALSE);研究人员的目标是增加p(TRUE)−p(FALSE)。相反,从true语句开始,研究人员可以从相应的token位置减去多个αθ,目标是减少p(TRUE)−p(FALSE)。实验结果质量均值探针方向具有很高的因果性;逻辑回归方向的因果性较低。在使LLaMA-13B相信一个真实陈述是假的时,这一点最为明显:研究人员最好的干预使LLaMA-13B的平均预测从77%的TRUE概率转变为89%的FALSE概率。在「likely」的数据集中接受训练的探针确实有一些效果,但效果微小且不一致。例如,在假→真情况下,沿着可能的逻辑回归方向进行干预会产生与预期相反的效果,因此研究人员没有报告它。这进一步支持了研究人员的观点,即LLMs代表的是真理,而不仅仅是文本可能性。在陈述及其否定式上接受训练会产生更具因果性的方向。这为第3.2节的MCI假设提供了证据。在其他位置的干预效果不明显。研究人员测试了在提示中其他陈述的最后两个标注上应用研究人员的干预。这没有产生任何效果。因此,研究人员的干预不能仅仅通过添加一个「说真话」的方向来实现。这也支持了研究人员的假设,即LLaMA-13B在事实陈述的最后两个标注上表征了真理。

研究人员假设「西班牙语单词『uno』的意思是『地板』」这句话的真实值。在残差流中由两个标注表征:最后一个单词(floor)和句末标点标注(’.),上面以粗体显示。因此,如果θ是第ℓ层残差流中的候选真实方向,研究人员通过向这些标注上方的第ℓ层残差流添加一些倍数αθ(α>0)来干预LLaMA-13B的前向传播。激活不变。然后,研究人员允许模型像往常一样使用修改后的激活继续前向传递。研究人员记录模型的概率p(TRUE)、p(FALSE);研究人员的目标是增加p(TRUE)−p(FALSE)。相反,从true语句开始,研究人员可以从相应的token位置减去多个αθ,目标是减少p(TRUE)−p(FALSE)。实验结果质量均值探针方向具有很高的因果性;逻辑回归方向的因果性较低。在使LLaMA-13B相信一个真实陈述是假的时,这一点最为明显:研究人员最好的干预使LLaMA-13B的平均预测从77%的TRUE概率转变为89%的FALSE概率。在「likely」的数据集中接受训练的探针确实有一些效果,但效果微小且不一致。例如,在假→真情况下,沿着可能的逻辑回归方向进行干预会产生与预期相反的效果,因此研究人员没有报告它。这进一步支持了研究人员的观点,即LLMs代表的是真理,而不仅仅是文本可能性。在陈述及其否定式上接受训练会产生更具因果性的方向。这为第3.2节的MCI假设提供了证据。在其他位置的干预效果不明显。研究人员测试了在提示中其他陈述的最后两个标注上应用研究人员的干预。这没有产生任何效果。因此,研究人员的干预不能仅仅通过添加一个「说真话」的方向来实现。这也支持了研究人员的假设,即LLaMA-13B在事实陈述的最后两个标注上表征了真理。

局限性

当然,这项研究还有有很多局限性。首先,研究人员关注简单、无争议的陈述,因此无法将真理与密切相关的潜在特征(例如「普遍相信」或「可验证」)区分开来。其次,研究人员只解决如何识别真实方向;研究人员根据经验发现,线性探针的最佳偏差是由研究人员的许多训练集决定的,因此研究人员将识别良好泛化偏差的问题留给未来的工作。第三,研究人员只研究了单一尺度的一个模型,尽管研究人员已经检查过研究人员的许多结果似乎也适用于LLaMA-7B和LLaMA-30B。

世界模型,离我们越来越近了

AI的终极形态和发展的最终目标——通用人工智能(AGI),就是一个「能够理解世界的模型」,而不仅仅是「描述世界的模型」。微软认为,GPT-4的早期实验,已经显现出了AGI的火花。但更多人认为,GPT-4生成的只是对世界的摘要性描述,它并不理解真实世界。而且,现在的大多数模型仅接受文本训练,不具备在现实世界中说话、听声、嗅闻以及生活行动的能力。就仿佛柏拉图的洞穴寓言,生活在洞穴中的人只能看到墙上的影子,而不能认识到事物的真实存在。 而MIT作者等人的研究一再证实,LLM的确在一定程度上理解世界,不仅仅是能保证自己的语法上的正确。能理解时间和空间,还能分清真话和谎言。下一步LLM还会给我们带来何种惊喜,实在令人期待。参考资料:https://arxiv.org/abs/2310.06824

而MIT作者等人的研究一再证实,LLM的确在一定程度上理解世界,不仅仅是能保证自己的语法上的正确。能理解时间和空间,还能分清真话和谎言。下一步LLM还会给我们带来何种惊喜,实在令人期待。参考资料:https://arxiv.org/abs/2310.06824

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง