随着深度学习模型商业化落地的同时,算法模型不断增加,对场景的实时性要求愈发高了,模型的推理与加速就尤为重要。比如安防、语音助手、推荐、搜索、环境感知等场景对模型响应的速度均有较高的要求。例如:

1.自动驾驶车辆的环境感知,要求每帧图像的检测分割处理速度是10ms左右,如果深度学习模型不进行推理加速,通常速度只能在30ms左右,这样使得自动驾驶车辆无法实时应对周围环境的变化,进而导致交通事故。

2.一些社交或者短视频平台,需要实时检测用户上传的视频内容是否合法合规。深度学习模型如果检测速度慢,轻则影响用户体验,重则导致违法违规内容大规模扩散。

深度学习模型压缩与加速技术,在降低存储空间和计算资源的同时,还可以降低部署和维护成本,提高相应响应速度,降低数据泄漏和滥用的风险。

深度学习模型的部署应用根据不同设备(NVIDIA、华为昇腾、FPGA等)会有不同的方案,但目前主流需求仍然是NVIDIA的GPU上部署,并使用NVIDIA推出的推理优化框架TensorRT。之前学院开设过TensorRT的基础课程,广受大家欢迎的同时,也带来了新的需求——“拿到一个深度学习模型,我如何一步一步地提升其推理速度,并做极致优化”。

因此,深蓝学院开设了『深度学习模型推理加速项目实践』课程。该课程以百度文心大模型ERNIE工业化部署实践中的推理加速为例,带着大家一步一步地提升大模型ERNIE的推理速度,并最终实现模型精度损失在要求范围内且推理速度至少提升7倍。

01讲师介绍

杨伟光 腾讯高级研究员 大连理工大学硕士

毕业后一直在腾讯从事语音领域深度学习加速上线工作。近10年CUDA开发经验,近6年TensorRT 开发经验,Github TensorRT_Tutorial作者。

02课程亮点1. 精选百度文心大模型ERNIE部署实践中的推理加速为例;2. 详细讲解项目实践中常见推理加速方法与策略; 3. 培养真实推理加速任务中分析与拆解问题的能力;

4. 小班教学,专家讲师直播与录播结合授课。

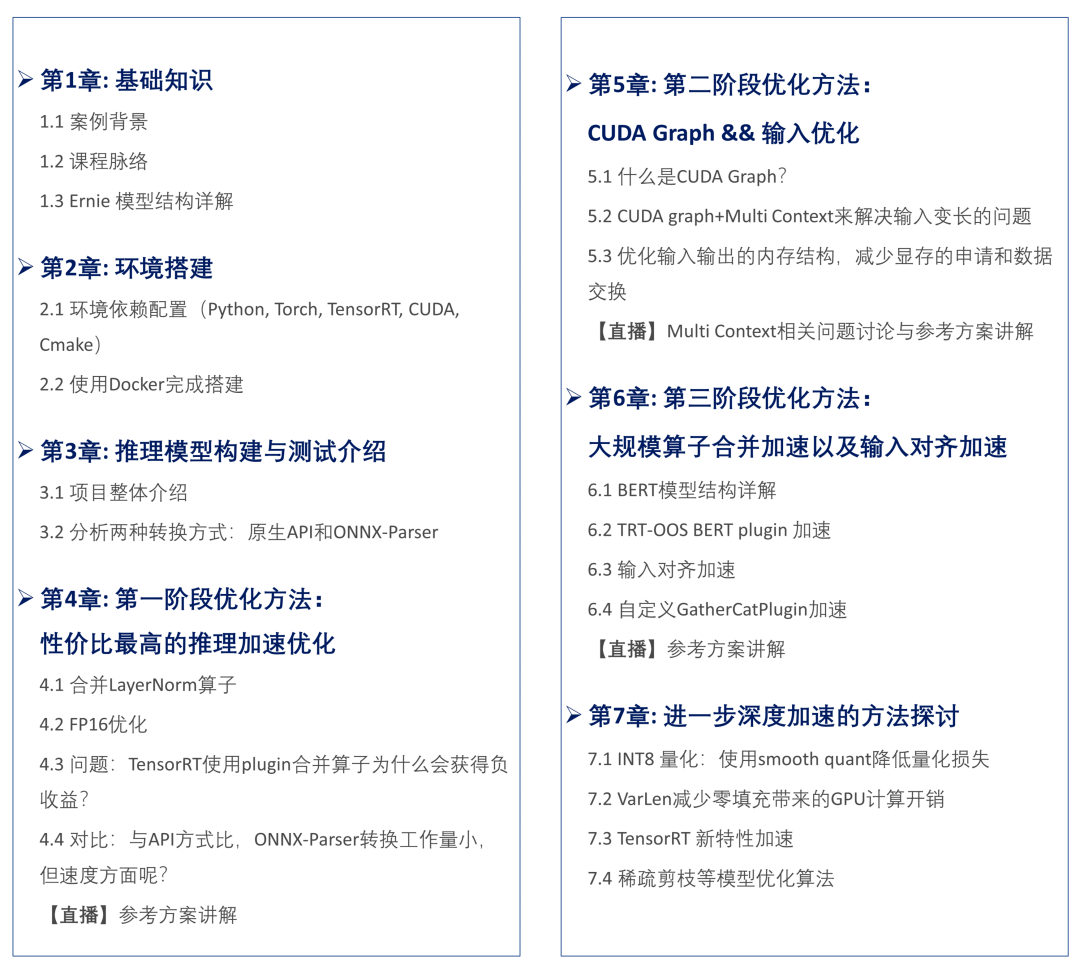

03课程大纲

04课程收获以百度文心大模型ERNIE用于搜索场景为案例,带着同学们一步一步优化推理加速。在此过程中,大家可以收获以下知识与技能:1.面对新的深度学习模型推理加速任务时,应该如何分析与拆解;

2.针对不同项目需求,选择哪种推理加速方法或者策略;

3.常用的推理加速技能,比如合并算子、FP16、优化输入输出、输入对齐、手写算子等。

05抢占名额

扫码添加,了解详情请务必备注1024,优先通过哦!

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง