Improved Techniques for Training Consistency Models

Y Song, P Dhariwal

[OpenAI]

一致性模型训练的改进技术

- 一致性模型是一种新的生成模型族,可以在一个步骤内生成高质量的样本,而无需进行对抗训练。

- 当前的一致性模型依赖于从预训练的扩散模型中进行知识蒸馏,并使用像LPIPS这样的学习指标,这限制了它们的性能。

- 本文提出在无需蒸馏的情况下直接从数据训练一致性模型的改进技术。

- 主要改进:

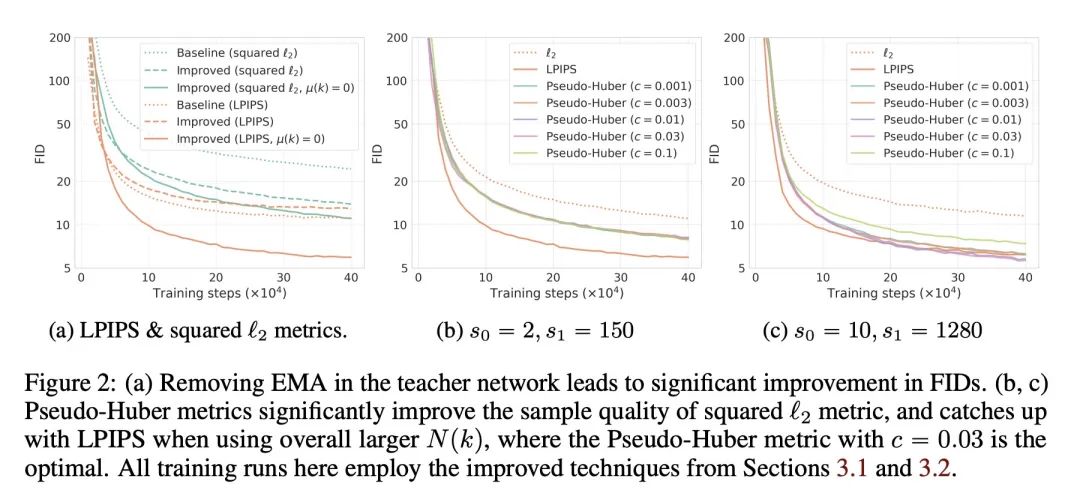

- 根据理论分析从一致性训练的教师网络中移除EMA。

- 采用Pseudo-Huber损失代替LPIPS以避免评估中的偏差。

- 使用更关注较低噪声水平的对数正态噪声时间表。

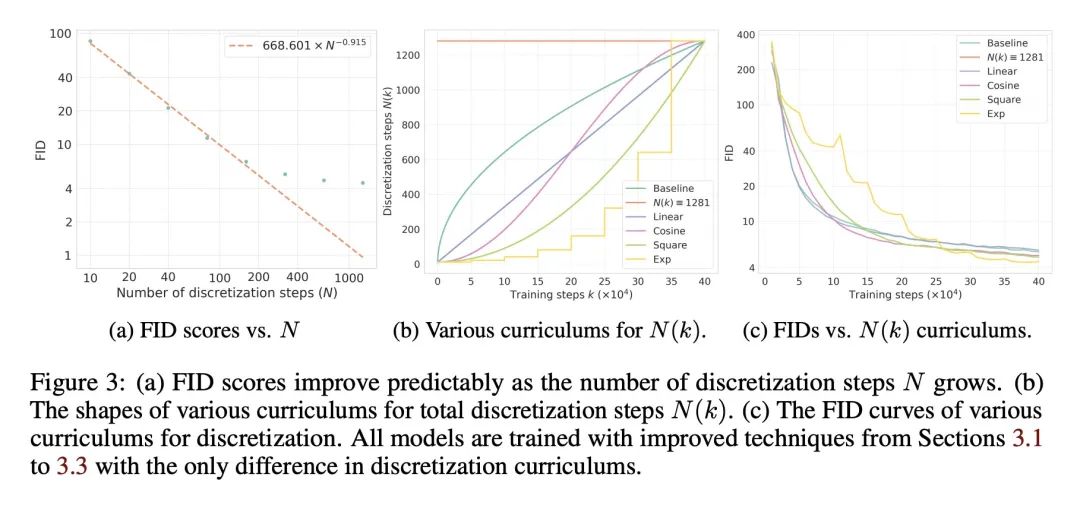

- 指数增加总离散化步数作为课表。

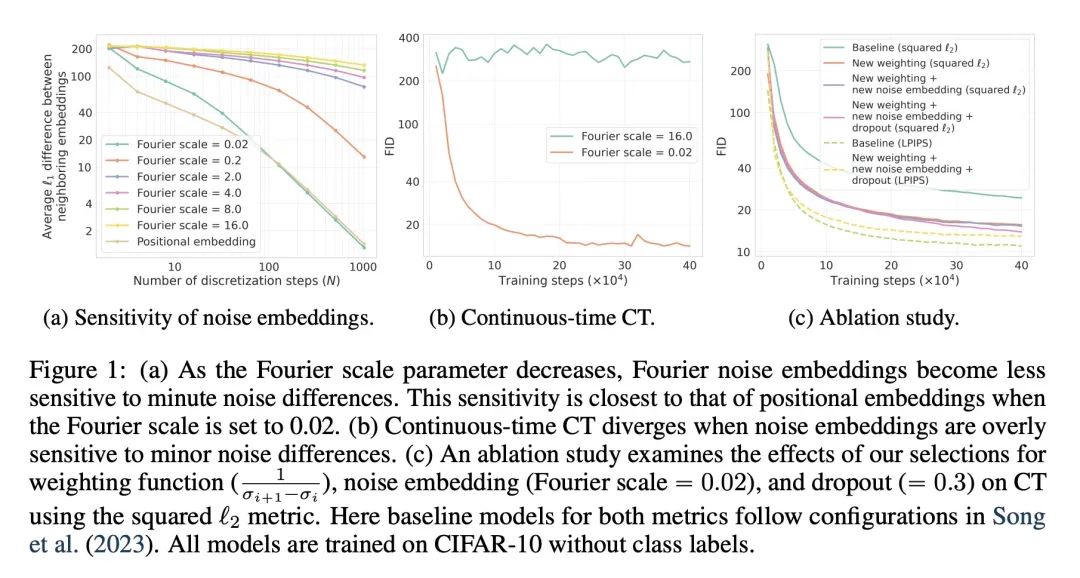

- 调优权重函数、噪声嵌入和dropout等超参数。

动机:改进一步生成高质量样本的一致性模型的训练方法,以提高样本质量并消除对学习度量的依赖。

方法:通过改进一致性训练技术,直接从数据中学习一致性模型,而不需要预训练扩散模型或学习度量。采用伪Huber损失替代学习度量,并引入对数正态噪声规划和离散步骤翻倍的技术。

优势:改进的一致性模型在单个采样步骤中实现了CIFAR-10和ImageNet 64×64的FID分数为2.51和3.25,相比之前的方法提升了3.5倍和4倍。通过两步采样,进一步降低了FID分数,表现超过了扩散模型的结果。

通过改进一致性模型的训练方法,直接从数据中学习,消除对学习度量的依赖,实现了在单个采样步骤中生成高质量样本,表现超过了扩散模型的结果。

该论文介绍了一种新兴的生成模型家族——一致性模型,它可以在一步中采样高质量数据而不需要对抗训练。当前的一致性模型通过从预训练扩散模型中提炼信息并采用学习度量(如LPIPS)来实现最佳的采样质量。然而,提炼限制了一致性模型的质量为预训练扩散模型的质量,并且LPIPS在评估中引入了不可取的偏见。为了解决这些问题,该论文提出了改进的一致性训练技术,其中一致性模型直接从数据中学习而不需要提炼。

该论文深入研究了一致性训练的理论,并发现了一个之前被忽视的缺陷,通过消除教师一致性模型中的指数移动平均来解决该缺陷。为了替代LPIPS等学习度量,该论文采用了健壮统计中的伪Huber损失。此外,该论文引入了对数正态噪声调度用于一致性训练目标,并提议每一定训练迭代次数加倍离散步数总数。这些修改加上更好的超参数调整使得一致性模型在单步采样中在CIFAR-10和ImageNet 64×64上分别实现了FID得分2.51和3.25。与先前的一致性训练方法相比,这些得分分别提高了3.5倍和4倍。通过两步采样,该论文进一步将这两个数据集上的FID得分降低到2.24和2.77,超过了通过提炼得到的一步和两步设置的结果,同时缩小了一致性模型与其他最先进生成模型之间的差距。

https://arxiv.org/abs/2310.14189

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง