导语

近日,北邮GAMMA Lab师生与国内外多名专家学者联合发布了名为“Towards Graph Foundation Models: A Survey and Beyond”的文章,探讨了图基础模型的概念、实现图基础模型的潜在方案和未来研究方向。这可能是第一篇关于图基础模型的综述。

研究领域:图神经网络,图基础模型,大语言模型,涌现 刘佳玮 | 作者北邮 GAMMA Lab | 来源

刘佳玮 | 作者北邮 GAMMA Lab | 来源

以GPT-4为代表的基础模型已经在自然语言处理、计算机视觉等诸多领域引起了轰动,这也吸引着图学习领域研究者们的关注。另一方面,图机器学习经历了从浅层方法到深度学习方法的范式转变,而当前的深度图学习方法也逐渐暴露出了表达能力、泛化性不足的问题,使模型无法适用于更多的图数据和更广泛的图任务。图学习是否也会迎来“图基础模型”的下一代学习范式呢?

近日,北邮GAMMA Lab师生与国内外多名专家学者联合发布了名为“Towards Graph Foundation Models: A Survey and Beyond”的文章,探讨了图基础模型的概念、实现图基础模型的潜在方案和未来研究方向。 标题:Towards Graph Foundation Models: A Survey and Beyond作者:Jiawei Liu*, Cheng Yang*, Zhiyuan Lu, Junze Chen, Yibo Li, Mengmei Zhang, Ting Bai, Yuan Fang, Lichao Sun, Philip S. Yu, and Chuan Shi链接:https://arxiv.org/pdf/2310.11829.pdf

标题:Towards Graph Foundation Models: A Survey and Beyond作者:Jiawei Liu*, Cheng Yang*, Zhiyuan Lu, Junze Chen, Yibo Li, Mengmei Zhang, Ting Bai, Yuan Fang, Lichao Sun, Philip S. Yu, and Chuan Shi链接:https://arxiv.org/pdf/2310.11829.pdf

简介:随着计算能力的迅猛增长和深度学习技术的突破,尤其是Transformer架构的出现,人工智能领域引入了“基础模型”的概念。基础模型是指任何在广泛数据上训练的模型,可以适应各种下游任务。基础模型的架构和训练策略的进步赋予了它们独特的特性,如涌现(Emergence)和同质化(Homogenization),使它们成为众多下游人工智能应用的主要构建模块。涌现这一术语表明,随着基础模型的扩大,它可能会自发地展现新颖的能力。同时,同质化暗示了模型的多功能性,使其能够在各种应用中部署。由于大型语言模型(LLMs)的发展,基础模型的概念首先在自然语言处理(NLP)中成为现实。从那时起,基础模型展示了惊人的多功能性,不仅可以处理文本,还可以处理图像数据、视频数据、音频数据和多模态输入。这种多功能性使它们能够在各种任务中表现出色,包括计算机视觉、音频信号处理和推荐系统等。

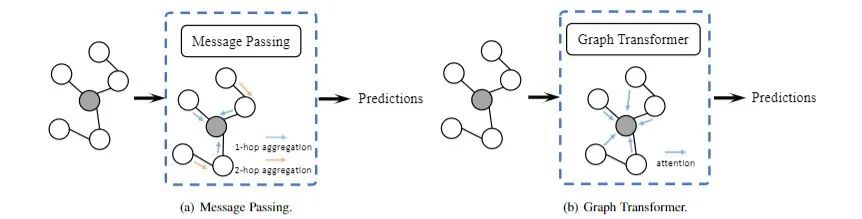

就像我们在自然语言处理领域所见证的演进一样,图机器学习正在经历一种范式转变。在早期阶段,图任务主要采用浅层方法,如随机游走和矩阵分解。然而,这些方法在容量上存在一定的限制,主要适用于未标记图上的转导学习。最近朝向深度学习方法的转变催生了图神经网络(GNNs)的出现。GNNs通过引入消息传递机制,使节点能够迭代地从邻居那里汇总信息,从而彻底改变了图机器学习的格局。通过在完全监督、半监督或无监督设置中利用GNNs,研究人员开创了大量定制的图模型。这些进展在节点分类、链接预测、图分类和图聚类等领域带来了显著的改进。然而,GNN 模型仍然存在一些挑战。这些模型受限于表达能力和泛化性方面的问题,尤其是考虑到不断扩大的数据集和不断增加的任务范围。

基础模型在各个领域的显著成功越来越引起了图机器学习研究人员的兴趣。这自然引发了一个问题:图基础模型是否可以代表图机器学习的下一个前沿?如果实现了这些模型,它们将具有更强的表达能力、可迁移性,并适用于更复杂的图数据和任务。

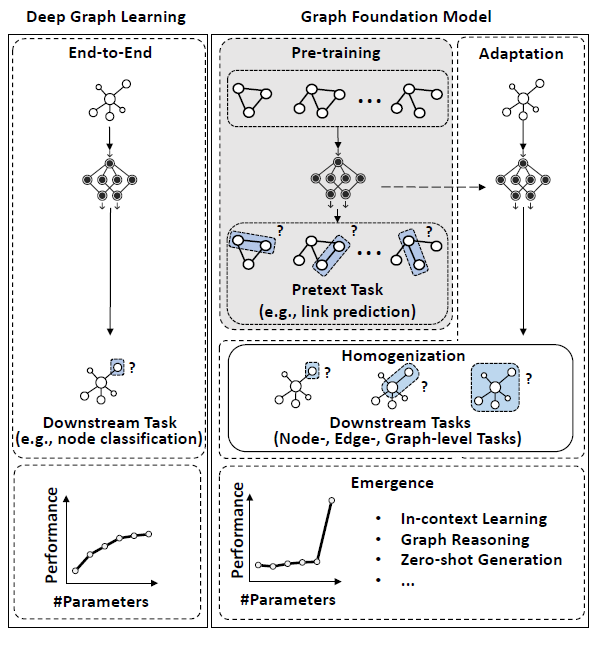

如图1所示,图基础模型(GFM)被构想为一个在广泛的图数据上预训练的模型,用于在不同的下游图任务中进行微调。与传统的基础模型相类似,我们期待GFM具备两个主要特征:涌现和同质化。具体而言,涌现指的是仅在大规模图模型中显现的新能力,而同质化表示模型可以适应不同类型的图任务。现有的深度图学习难以涵盖这些属性,因为它们固有的架构和学习范式专注于特定任务,这限制了对广泛的未标记数据的利用,从而限制了它们的表达和泛化能力。 图1:深度图学习和图基础模型的对比

图1:深度图学习和图基础模型的对比

受到大型语言模型(LLMs)在NLP中作为基础模型的成功启发,研究人员已经探索了GFMs在涌现和同质化能力方面的可能性。这些探索主要围绕GFMs的骨干架构的设计以及包括预训练和适应性在内的不同训练范式,因为它们是与实现前述能力密切相关的LLMs的关键策略。

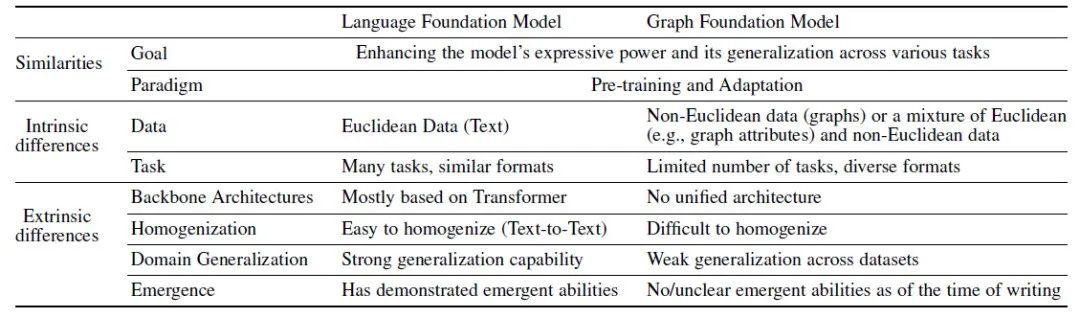

首先,基础模型的涌现能力通常仅存在于具有大量参数的骨干架构中,而图神经网络的参数数量明显小于语言基础模型骨干架构的参数数量。这意味着图基础模型的骨干可能需要重新设计,以实现更多的知识存储以实现涌现。由于图数据通常包含丰富的文本信息,另一种替代方法是将LLMs用作图基础模型。然而,尚不确定LLMs是否能有效处理图数据和相关任务,因此重要的是确定如何在LLMs中建模图结构。

此外,基础模型的同质化要求以一种统一的方式处理各种任务。因此,在图数据中,由于互连节点的复杂性、各种形式的属性以及节点、边和图级别的任务的多样性,设计有效的代理任务和下游任务适应方法变得具有挑战性。因此,有必要设计新颖的预训练代理任务和适配方式。 表1:语言基础模型和图基础模型的关系

表1:语言基础模型和图基础模型的关系

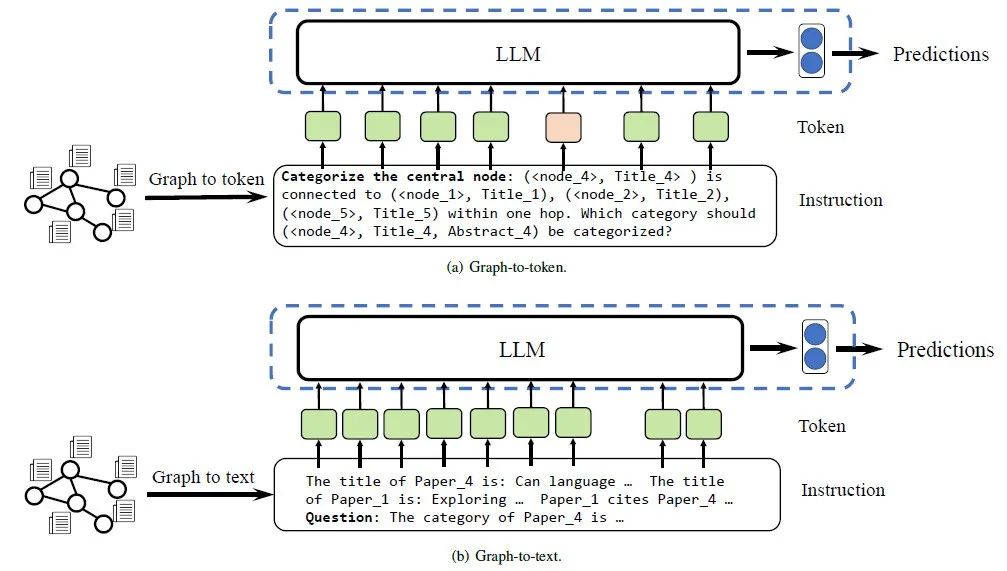

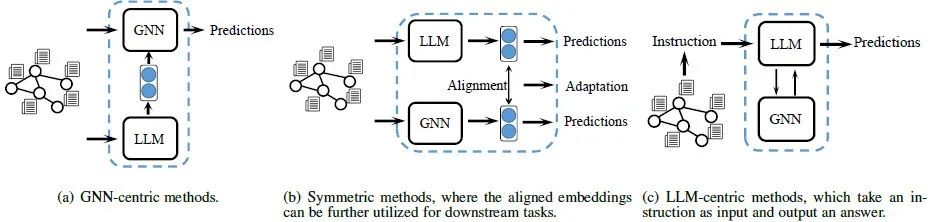

虽然目前没有关于设计和实现图基础模型的明确解决方案,但本文调查了一些相关研究,并将它们基于对图神经网络(GNNs)和大型语言模型(LLMs)的依赖分为三种不同的方法进行了分类。(1) 基于GNN的模型:它们旨在通过对骨干架构、预训练和适配方面的创新来增强现有的图学习范式。(2) 基于LLM的模型:它们探索将图转化为文本或标记的方式,以探索将LLM用作图基础模型的可行性。(3) 基于GNN+LLM的模型:它们结合了GNNs和LLMs,并寻求探索GNNs和LLMs之间各种协同作用的方式,以赋予它们增强的能力。 图3:基于GNN的模型示意图

图3:基于GNN的模型示意图 图5:基于LLM的模型示意图

图5:基于LLM的模型示意图 图7:基于GNN+LLM的模型示意图

图7:基于GNN+LLM的模型示意图

据我们所知,这是第一篇关于图基础模型的综述。现有的关于基础模型的综述通常探讨语言和视觉等不同模态,而不是图。此外,还有两篇专门针对知识图谱和大型语言模型的综述,但由于知识图谱在构建和应用上的独特性,它们超出了本文的范围。我们还注意到最近有一篇文章提到了大型图模型的概念,但它强调了意见陈述并缺乏系统的分类。因此,本文的贡献可以总结如下:• 本文首次定义了图基础模型的概念,探讨了它们能力的核心问题和特征。• 本文引入了一种新颖的分类法,并讨论了每种方法的优势和局限性。 • 本文提供了一些图基础模型的未来发展方向。

本文的后续部分组织如下。在第2节中,我们介绍与图基础模型相关的背景信息。第3节定义了图基础模型,并突出了它们与语言基础模型的相似性和差异。第4至6节深入研究了分别将基于GNN的模型、基于LLM的模型和基于GNN+LLM的模型视为图基础模型的相关工作。第7节讨论了图基础模型的未来方向。在第8节,我们总结了本文的要点。

图神经网络与组合优化读书会

现实世界中大量问题的解决依赖于算法的设计与求解。传统算法由人类专家设计,而随着人工智能技术不断发展,算法自动学习算法的案例日益增多,如以神经网络为代表的的人工智能算法,这是算法神经化求解的缘由。在算法神经化求解方向上,图神经网络是一个强有力的工具,能够充分利用图结构的特性,实现对高复杂度算法的高效近似求解。基于图神经网络的复杂系统优化与控制将会是大模型热潮之后新的未来方向。

为了探讨图神经网络在算法神经化求解的发展与现实应用,集智俱乐部联合国防科技大学系统工程学院副教授范长俊、中国人民大学高瓴人工智能学院助理教授黄文炳,共同发起「图神经网络与组合优化」读书会。读书会将聚焦于图神经网络与算法神经化求解的相关领域,包括神经算法推理、组合优化问题求解、几何图神经网络,以及算法神经化求解在 AI for Science 中的应用等方面,希望为参与者提供一个学术交流平台,激发参与者的学术兴趣,进一步推动相关领域的研究和应用发展。欢迎感兴趣的朋友报名参与! 详情请见:

详情请见:

加速经典算法效率,突破现实技术瓶颈:图神经网络与组合优化读书会启动

推荐阅读

1. 几何深度学习:让物理世界拥有AI | 黄文炳分享整理2. 人工智能前沿:组合优化问题的机器学习求解 | 范长俊分享整理3. 2023年,请不要忽略:图神经网络(GNN)这一匹黑马!4. 张江:第三代人工智能技术基础——从可微分编程到因果推理 | 集智学园全新课程5. 成为集智VIP,解锁全站课程/读书会6. 加入集智,一起复杂!

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง