SuperHF: Supervised Iterative Learning from Human Feedback

G Mukobi, P Chatain, S Fong, R Windesheim, G Kutyniok, K Bhatia, S Alberti

[Stanford University]

SuperHF:基于人工反馈的监督迭代学习

要点:

- 提出一种新方法,称为监督式人工反馈迭代学习(SuperHF),用于调整基础模型。

- SuperHF用简单的监督损失和KL散度惩罚来替代RLHF中的强化学习算法。

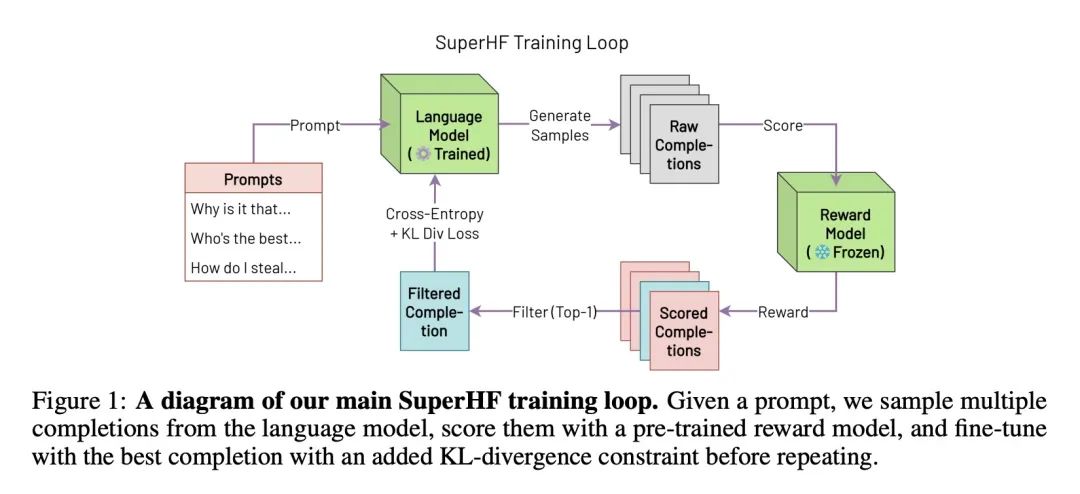

- 迭代地从模型中采样补全,通过奖励模型进行过滤,并在最好的补全上进行微调。

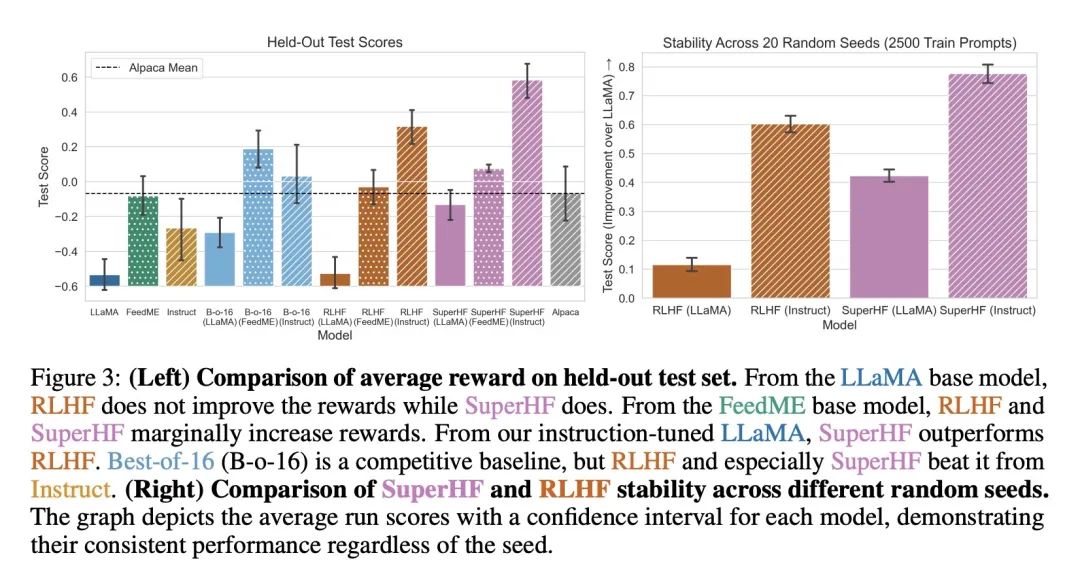

- 实验表明,在优化奖励和下游评估方面,SuperHF符合或超过了RLHF。

- SuperHF通过KL惩罚和指令调优来减少奖励黑客攻击,也改善了RLHF的校准。

- 简化的SuperHF方法更易于实现,而且取得了竞争性的表现。

动机:当前人工智能领域主要集中在大规模语言模型上,这些模型在能力上表现出色,但在安全性、与人类价值观的一致性和训练稳定性方面仍存在挑战。本文旨在提出一种新的方法来解决这些问题,并将两种现有方法的优势结合起来。

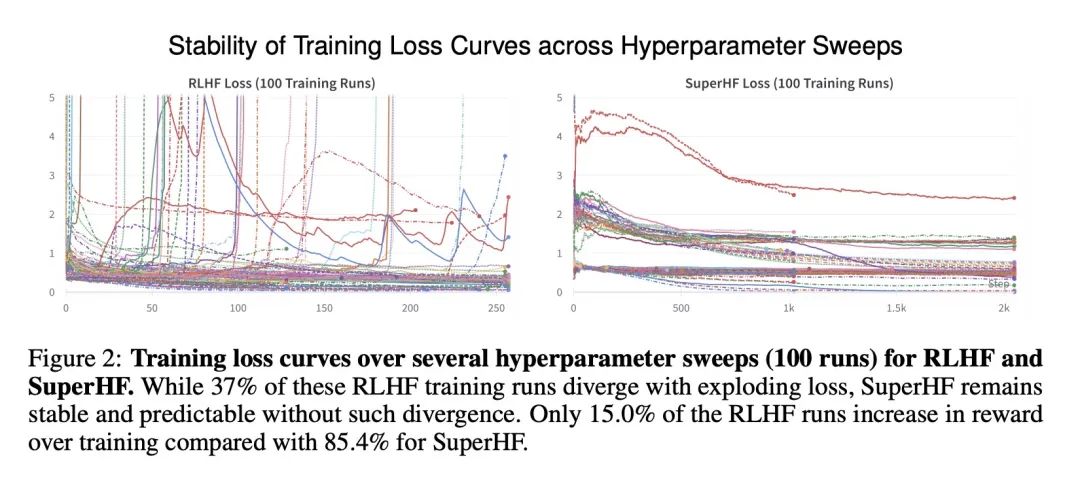

方法:所提出的方法是基于人工反馈的监督迭代学习(SuperHF),利用现有的强化学习方法中的奖励模型,但用简单的监督损失和Kullback-Leibler(KL)散度先验替代了Proximal Policy Optimization (PPO)。SuperHF通过反复采样模型输出并通过奖励模型进行过滤来创建自己的训练数据,并将奖励优化问题分解为三个组成部分:优化训练奖励本身、防止奖励欺骗以及在下游评估中保持良好的性能。

优势:SuperHF方法在训练目标上优于基于PPO的RLHF方法,能在高奖励和低奖励欺骗之间取得良好的平衡,提高下游校准性,并在GPT-4上的定性评估中表现相当。此外,SuperHF方法相对于RLHF方法而言实施更简单,具有更高的可用性。

提出一种名为SuperHF的语言模型对齐算法,结合了强化学习和监督学习的优势,通过使用奖励模型和简化的损失函数来实现高效的数据使用和模型泛化,并在训练目标、奖励欺骗和下游评估方面取得了竞争性的结果。

https://arxiv.org/abs/2310.16763

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง