ConvNets Match Vision Transformers at Scale

S L. Smith, A Brock, L Berrada, S De

[Google DeepMind]

卷积网络在大规模上与视觉Transformer可比

- 通过评估扩展规模的NFNets挑战了卷积网络(ConvNets)在大规模下表现低于视觉转换器(ViTs)的看法。

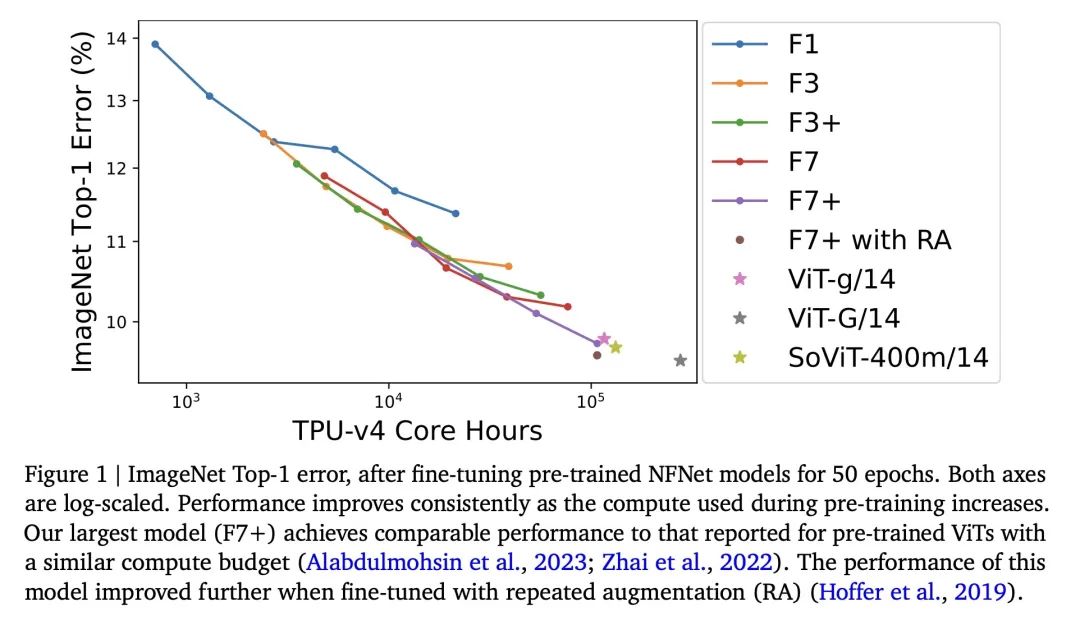

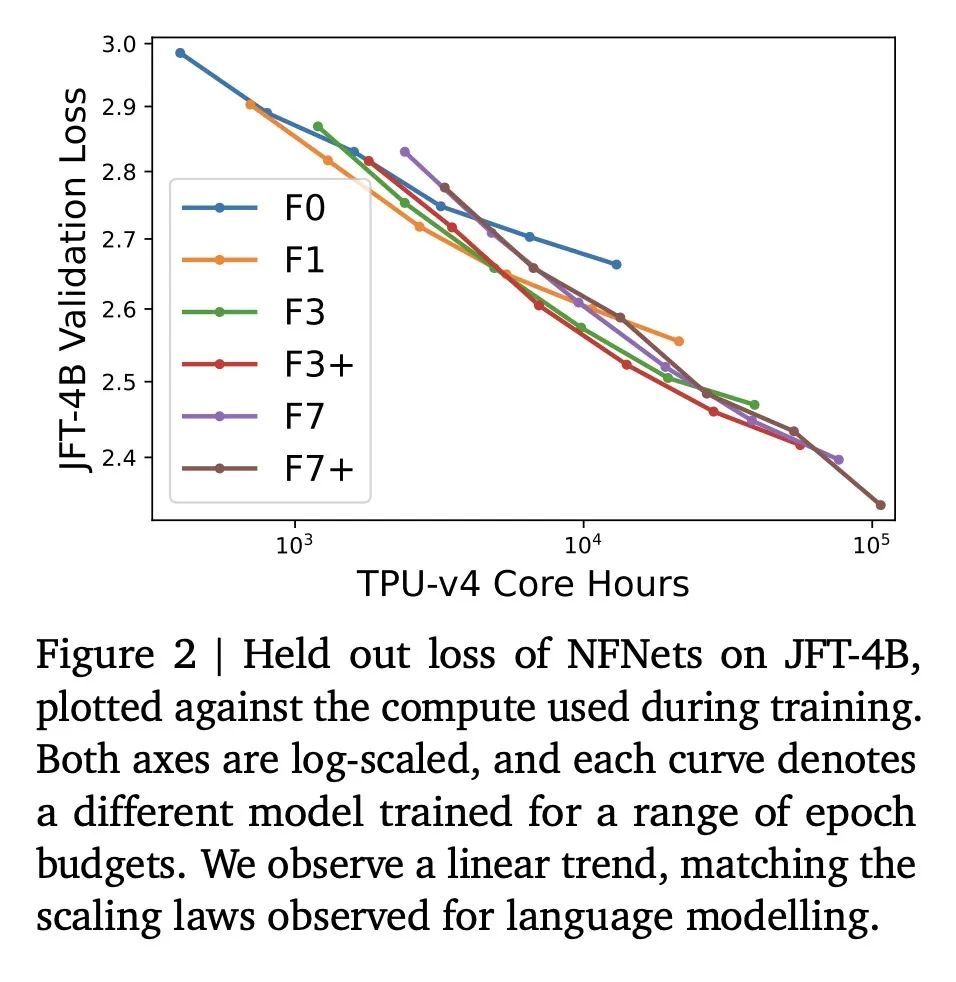

- 在JFT-4B数据集上预训练NFNets,计算量从0.4k到110k TPU-v4小时,发现验证损失与计算量之间遵循对数对数缩放律。

- 在ImageNet上微调后,NFNets与相当计算量的ViTs有相当的性能,顶尖模型达到了90.4%的准确率。

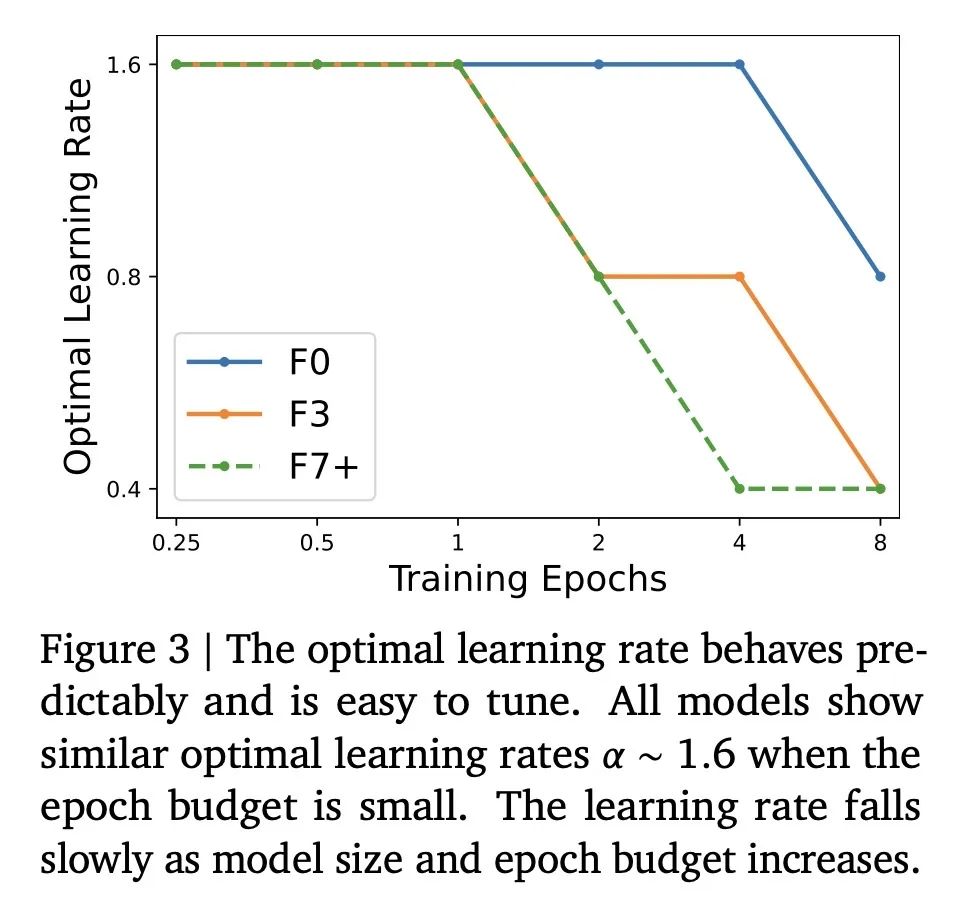

- 最优的模型大小和训练epoch随计算量的增加而增长,学习率调参是可预测的。

- 结果显示,给定足够的数据和计算量,卷积网络仍然具有竞争力,模型设计和资源比架构本身更为重要。

动机:研究人员想要挑战一个观念,即在大规模数据集上,卷积神经网络(ConvNets)与视觉Transformer(Vision Transformers)相比并不具备竞争力。他们想要评估在使用类似计算预算的情况下,经过预训练的ConvNet架构是否能与Vision Transformers达到相同的性能。

方法:通过在JFT-4B数据集上预训练NFNet模型族的一系列网络,并在ImageNet上进行微调,评估了模型的性能。考虑了不同的计算预算,同时观察了验证损失和计算预算之间的对数-对数缩放律。

优势:经过预训练和微调后,NFNets与使用类似计算预算的Vision Transformers具有可比较的性能。最强的微调模型达到了90.4%的Top-1准确率。

通过在大规模数据集上预训练和微调ConvNet模型,挑战了ConvNets与Vision Transformers的竞争能力,发现它们在类似计算预算的情况下具有可比较的性能。

https://arxiv.org/abs/2310.16764

正文完

可以使用微信扫码关注公众号(ID:xzluomor)

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง