今天发布的一篇研究论文描述了生成性人工智能如何帮助最复杂的工程工作之一:设计半导体。

这项工作展示了高度专业化领域的公司如何根据其内部数据培训大型语言模型(LLM),以建立提高生产力的助手。

很少有追求像半导体设计那样具有挑战性。在显微镜下,像NVIDIA H100 Tensor Core GPU(上图)这样的最先进的芯片看起来像一个精心策划的大都市,由数百亿个晶体管建造,连接在比人的头发薄10,000倍的街道上。

多个工程团队协调长达两年,以建设这些数字特大城市之一。

一些小组定义了芯片的整体架构,一些小组设计并放置了各种超小型电路,另一些小组则测试了他们的工作。每项工作都需要专门的方法、软件程序和计算机语言。

地址:https://blogs.nvidia.com/blog/2023/10/30/llm-semiconductors-chip-nemo/

LLMs的广阔愿景

NVIDIA研究总监兼论文的主要作者Mark Ren说:“我相信随着时间的推移,大型语言模型将帮助所有过程。”

NVIDIA首席科学家Bill Dally今天在计算机辅助设计国际会议的主旨演讲中宣布了这篇论文,该会议由数百名在电子设计自动化(EDA)领域工作的工程师组成。

Dally在旧金山举行的活动中说:“这项工作标志着将LLM应用于半导体设计的复杂工作的重要第一步。”“它展示了即使是高度专业化的领域也可以利用其内部数据来训练有用的生成人工智能模型。”

ChipNeMo表面

本文详细介绍了NVIDIA工程师如何为其内部使用创建名为ChipNeMo的定制LLM,该LM接受了公司内部数据的培训,以生成和优化软件并协助人类设计师。

Ren说,从长远来看,工程师们希望将生成性人工智能应用于芯片设计的每个阶段,从而有可能在整体生产力方面获得显著收益,他的职业生涯跨越了20多年的EDA。

在调查NVIDIA工程师可能的用例后,研究团队选择了三个开始:聊天机器人、代码生成器和分析工具。

初始用例

后者——一个自动维护已知错误更新描述的耗时任务的工具——是迄今为止最受欢迎的工具。

一个回答有关GPU架构和设计问题的原型聊天机器人帮助许多工程师在早期测试中快速找到技术文档。

代码生成器将帮助设计师为芯片设计编写软件。

开发中的代码生成器(上面演示)已经用芯片设计师使用的两种专业语言创建了大约10-20行软件片段。它将与现有工具集成,因此工程师为正在进行的设计提供方便的助手。

使用NVIDIA NeMo定制AI模型

本文主要侧重于团队收集其设计数据的工作,并使用它来创建一个专门的生成人工智能模型,这是一个可移植到任何行业的流程。

作为起点,该团队选择了基础模型,并使用NVIDIA NeMo对其进行定制,NVIDIA NeMo是一个用于构建、定制和部署NVIDIA AI企业软件平台中包含的生成性人工智能模型的框架。选定的NeMo模型具有430亿个参数,这是其理解模式能力的衡量标准。它使用超过一万亿个代币、文本和软件中的单词和符号进行了训练。

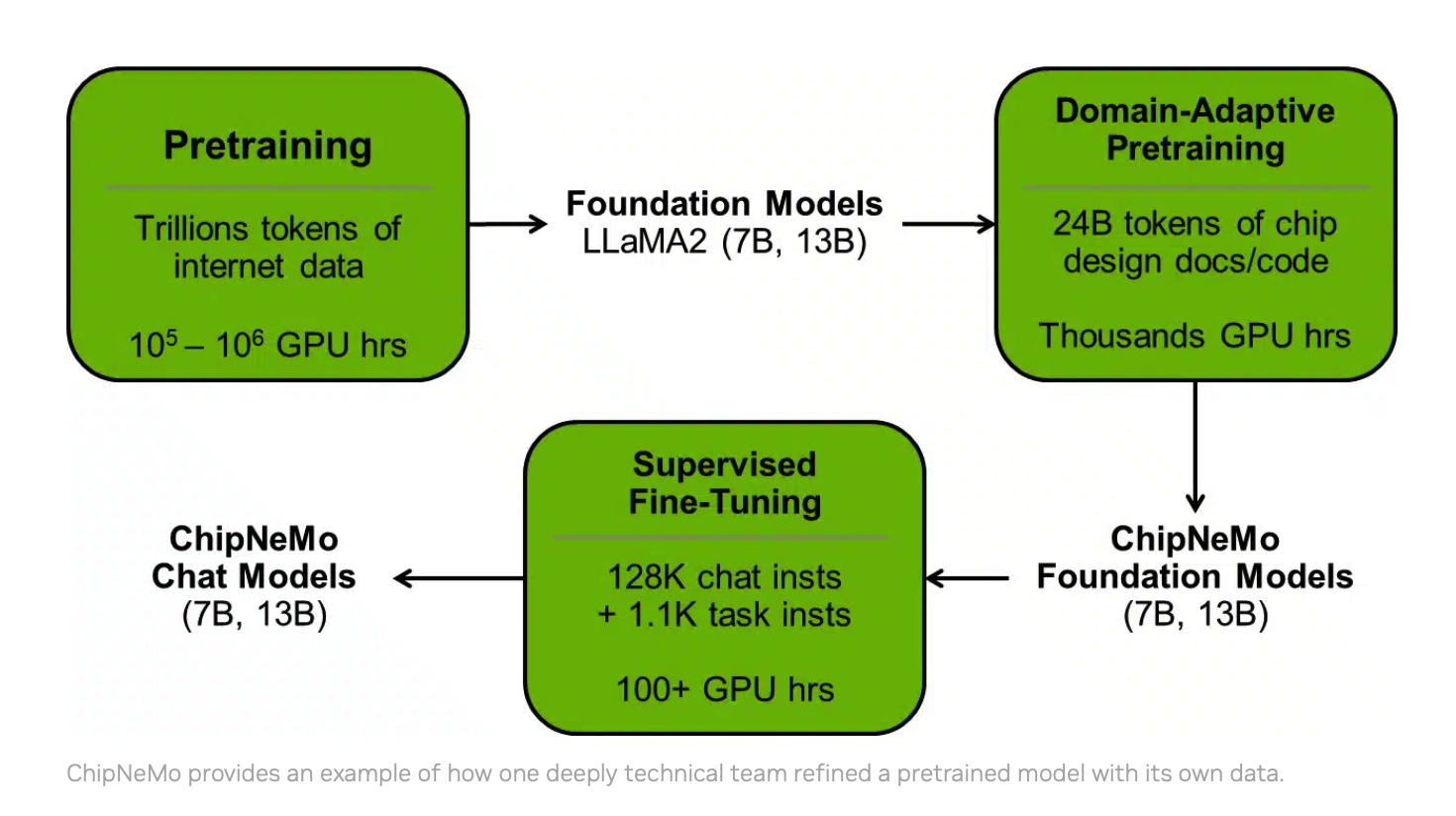

ChipNeMo提供了一个示例,说明一个深度技术团队如何用自己的数据完善预训练模型。

然后,该团队在两轮培训中完善了该模型,第一轮使用了价值约240亿代币的内部设计数据,第二轮使用了约13万个对话和设计示例。

这项工作是半导体行业生成人工智能概念研究和证明的几个例子之一,刚刚开始从实验室出来。

分享经验教训

Ren团队学到的最重要的教训之一是定制大模型的价值。

在芯片设计任务中,具有不到130亿参数的定制ChipNeMo模型匹配或超过具有700亿参数的更大的通用LLM(如LM2)的性能。在一些用例中,ChipNeMo模型要好得多。

他补充说,一路走来,用户需要注意他们收集哪些数据以及如何清理这些数据以用于训练。

最后,Ren建议用户及时了解可以加快和简化工作的最新工具。

NVIDIA Research在全球拥有数百名科学家和工程师,专注于人工智能、计算机图形学、计算机视觉、自动驾驶汽车和机器人等主题。最近半导体的其他项目包括使用人工智能设计更小、更快的电路,并优化大块的放置。

希望构建自己的自定义大模型的企业今天就可以开始使用GitHub和NVIDIA NGC目录中提供的NeMo框架。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง