我们很高兴地与大家分享:Cloudflare 已与 Hugging Face 建立合作,开发人员使用 AI 模型将变得前所未有的容易,并且更加经济实惠。

在接下来的几个月,我们计划向开发人员提供以下三项:

-

我们很高兴为 Hugging Face 带来了无服务器 GPU 模型,无需再为基础架构烦恼或为未使用到的算力付费。只需选择您的模型,然后“开箱即用”;

-

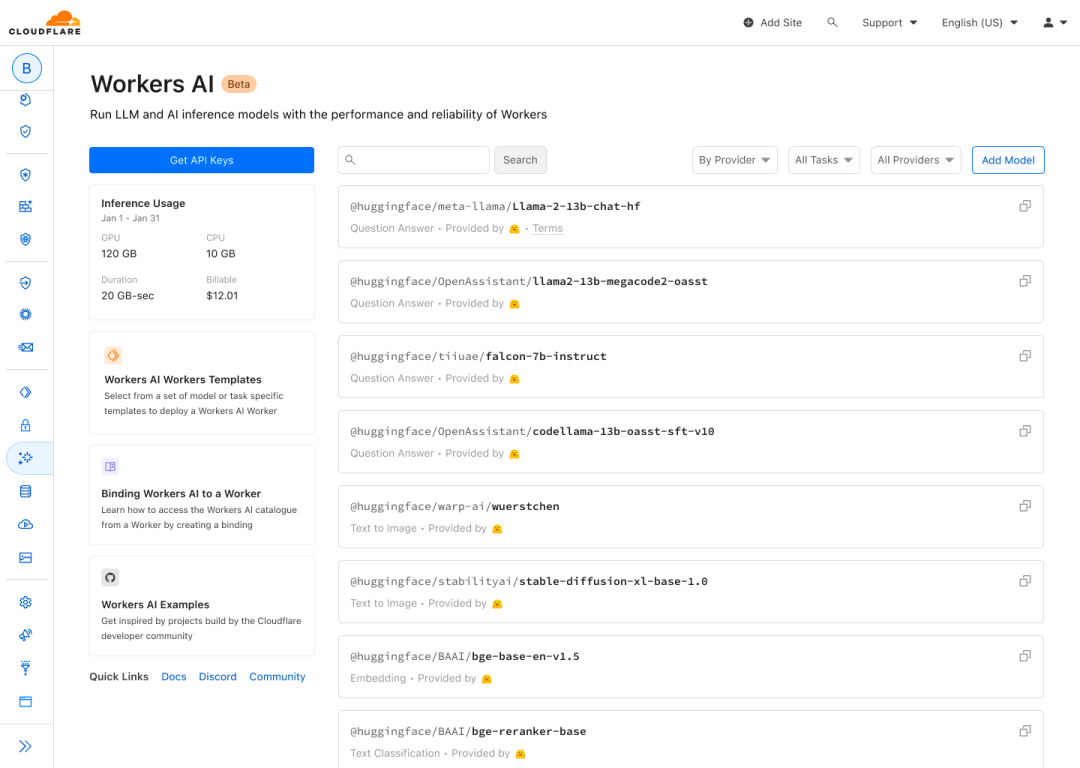

将热门的 Hugging Face 优化模型引入 Cloudflare 模型目录;

-

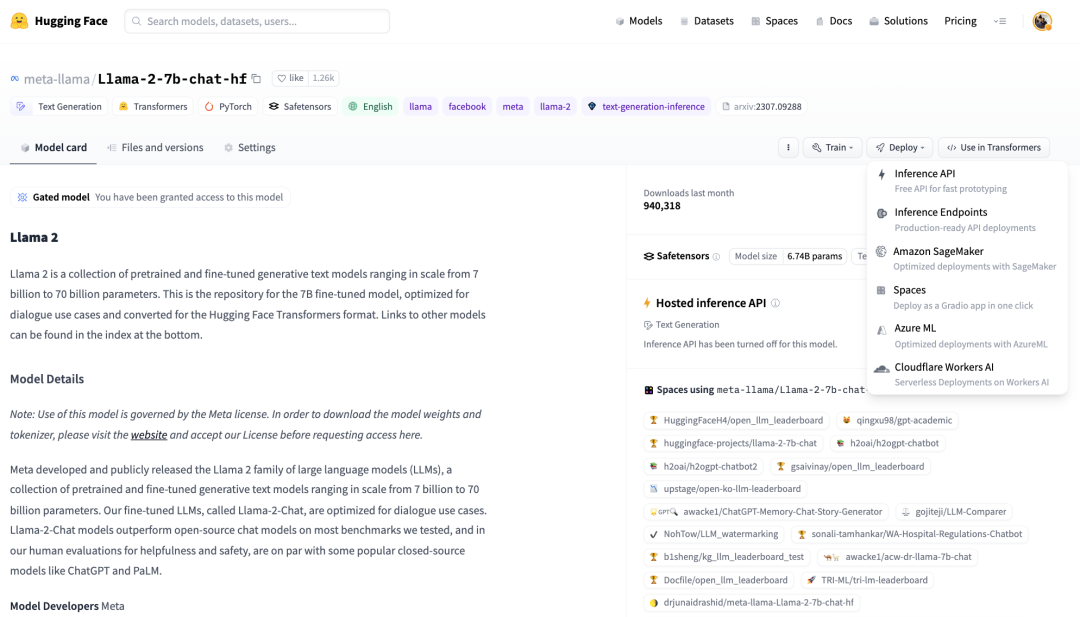

推出 Cloudflare 集成作为 Hugging Face 的推理解决方案的一部分。

Hugging Face 托管超过 500,000 个模型,一天服务超过一百万次模型下载,对于想要将 AI 添加到其应用程序的开发人员而言,这是一个首选之地。

同时,在过去六年间,Cloudflare 的目标一直是让开发人员能够利用我们的开发人员平台,尽可能简单地将他们的想法和应用程序转化为现实。

随着 AI 成为每一个应用程序的关键部分,这种合作关系就像是一种自然匹配,将所需的工具交到开发人员的手中,让他们能够轻松、实惠地部署 AI。

“Hugging Face 和 Cloudflare 都致力于让开发人员尽可能轻松、实惠地使用最新 AI 创新。我们很高兴与 Cloudflare 合作提供无服务器 GPU 服务,以帮助开发人员将其 AI 应用从零扩展到全球,无需为基础结构烦恼或预测应用程序的未来需求——只需选择您的模型并部署即可。” — Hugging Face 首席执行官,Clem Delangue。

我们很乐意与大家分享即将推出的功能,因此,我们想让您提前了解一下我们接下来的产品发布计划。

Hugging Face 模型即将推出

作为开发人员,当您有一个想法时,您会想要尽快将其付诸现实。通过我们的合作,无论您从哪里开始,我们都可为您提供熟悉的模型。

如果您使用 Cloudflare 的开发人员平台来构建应用程序,我们会在过程中自然引入 Hugging Face 模型。您很快将能够直接从 Cloudflare 的仪表板部署经过性能和速度优化的 Hugging Face 模型。

或者,如果您已经习惯于在 Hugging Face 上研究和寻找模型,您很快将能够直接从 Hugging Face UI 部署到 Workers AI。

我们双方的团队都致力于创造最好的开发者体验,我们将会继续努力,消除阻碍开发者创造下一个重大 AI 理念的所有障碍。

为 Hugging Face 用户提供无服务器 GPU 推理

Hugging Face 提供多个推理解决方案,可根据平台上托管的 500,000 个模型进行预测,而无需管理基础架构。这些解决方案包括:免费且速率受限的 Inference API、可进行专用基础架构部署的 Inference Endpoints,以及可进行浏览器内边缘推断的 Transformers.js。

我们期待与 Hugging Face 的团队紧密合作,实现由 Cloudflare 提供支持的新体验:从新的无服务器 GPU 推理解决方案,到新的边缘使用案例——敬请期待!

本文由 Hugging Face 中文社区内容共建项目提供,稿件由社区成员投稿,经授权发布于 Hugging Face 公众号。文章内容不代表官方立场,文中介绍的产品和服务等均不构成投资建议。了解更多请关注公众号:如果你有与开源 AI、Hugging Face 相关的技术和实践分享内容,以及最新的开源 AI 项目发布,希望通过我们分享给更多 AI 从业者和开发者们,请通过下面的链接投稿与我们取得联系:

https://hf.link/tougao

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง