编译 | 曾全晨

审稿 | 王建民

今天为大家介绍的是来自Sophia Y. Wang团队的一篇论文。像ChatGPT这样的大型语言模型(LLMs)似乎能够执行各种任务,包括回答患者的眼部护理问题,但尚未与眼科医生进行直接比较评估。目前仍不清楚LLM生成的建议是否准确、合适和安全,适用于眼科患者。

近年来,大型语言模型(LLMs)已经彻底改革了自然语言处理,帮助计算机与文本和口头语言进行交互,就像人类一样,从而创造出聊天机器人。这些模型,包括BERT和GPT-3,在大量文本数据上进行训练,并在文本摘要或回答查询等自然语言处理任务上表现出色。它们已经被用于医疗保健的各种应用。在这些模型中,ChatGPT(OpenAI)是一种基于GPT-3.5的特别强大的工具,专门设计用于在对话环境中生成自然且具有上下文的适当回应。基于GPT-3模型,GPT-3.5在更大量的文本数据和额外的培训技术,如来自人类反馈的强化学习(RLHF),的基础上进行了训练,这些技术将人类的知识和专业知识融入了模型。

将LLMs纳入临床实践需要谨慎的措施。患者通常会上网寻找快速和可访问的健康信息或建议,其中一个主要关切是LLM聊天机器人生成的信息是否安全,并且与医生提供的信息相媲美。在医疗保健中使用聊天机器人的问题包括知识有限、过时、引用不正确以及具有幻觉风险的不准确内容,这些输出听起来似乎令人信服,但实际上是事实不准确的。聊天机器人有能力产生具有高质量共情声音的回应,但在眼科学领域,一项最近的研究发现,它们仅有45%的准确性,。鉴于人工智能(AI)驱动的医疗保健领域迅速发展和转型进展以及潜在的意外后果,进行严格的研究,以评估AI技术对患者结果的临床有效性、安全性和伦理影响至关重要,有助于优化患者结果并减少伤害。作者的研究评估了LLM聊天机器人如何回答与眼部健康相关的患者问题,并将其答案与经过认证的眼科医生的答案进行了比较。

数据来源

眼部护理论坛是一个在线论坛,用户可以提出详细问题,并从美国眼科学会(AAO)附属的医生那里获得答案。论坛上的用户问题包括详细的段落,详细阐述了情况并提供了背景信息。每个帖子的第一个眼科医生回应被保存为眼科医生的答案,产生了一个在筛选之前包含4747个问题-答案对的数据集。作者进一步审查了帖子,如果它们包含了详细的个人身份信息、提及了论坛本身或其他网站(如AAO网站)、提到现在通常被认为已过时的治疗方法(如ReZoom、Crystalens)、看起来不完整、提及了具体的机构名称或仍然包含身份识别的医生信息,或包含非文本输入,如附加的照片,那么这些问题-答案对就被排除在外。最终数据集由符合纳入标准的200个随机子集的问题-答案对组成。帖子的日期在2007年至2016年之间;数据在2023年1月访问并在2023年3月至5月之间进行了分析。该研究被斯坦福大学医学院的机构审查委员会认定为免于审查,因为数据是公开可用的,因此免除了知情同意要求。该研究遵循了流行病学观察性研究报告强化(STROBE)的报告指南。

专家评审

由8名获得专业认证的眼科医生(R.C.、Y.S.、J.C.、E.S.、K.C.、S.G.、A.S.、C.L.)组成的专家小组独立审查了论坛上的问题,并呈现了每个问题的人工编写或由AI生成的回答。审阅人员被要求决定回答是由眼科医生还是AI生成的。他们还被问了4个附加的多项选择问题,以确定回答是否包含不正确的信息,回答导致的伤害可能性,回答导致的伤害严重程度,以及回答是否与医学界的共识一致或相反。这些评估性问题曾被用于医生评估经过临床调整的LLM输出。为了确保专家小组审查了所有聊天机器人和眼科医生的回答,小组的一半审查了200个回答,这些回答在聊天机器人和人工回答之间被随机分为两组,而另一半则评估了反向组的回答。

实验结果

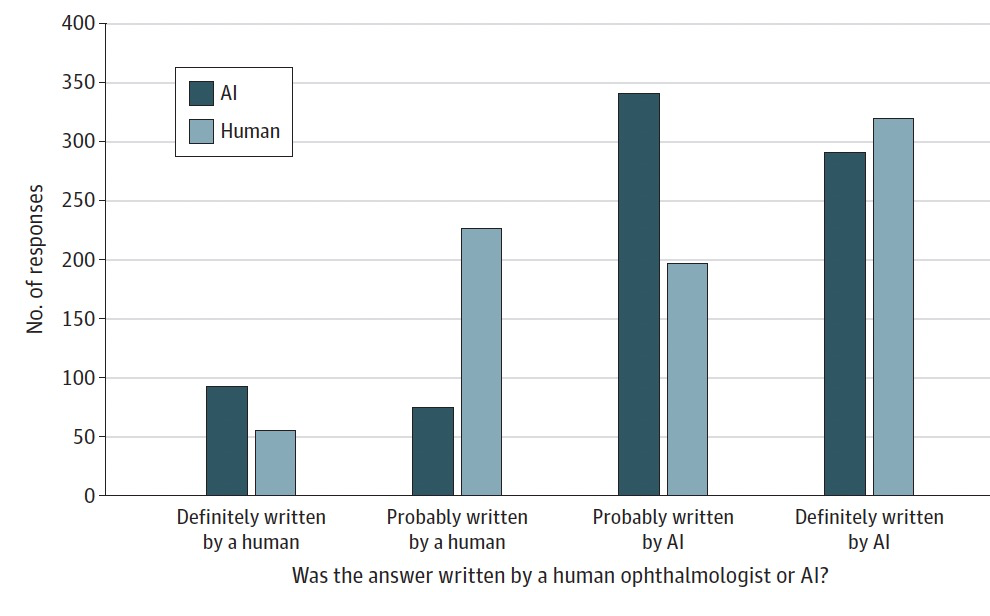

图 1

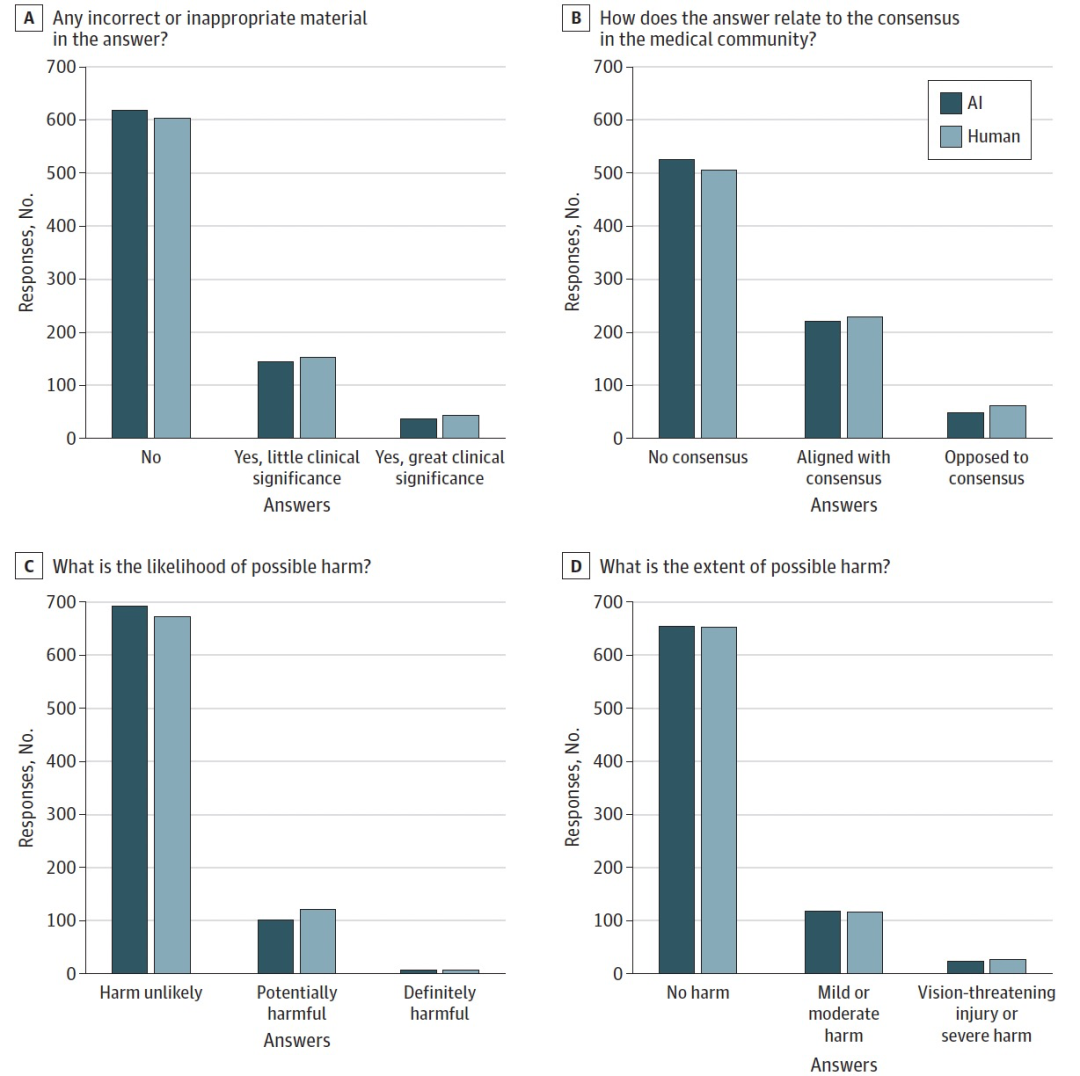

图 2

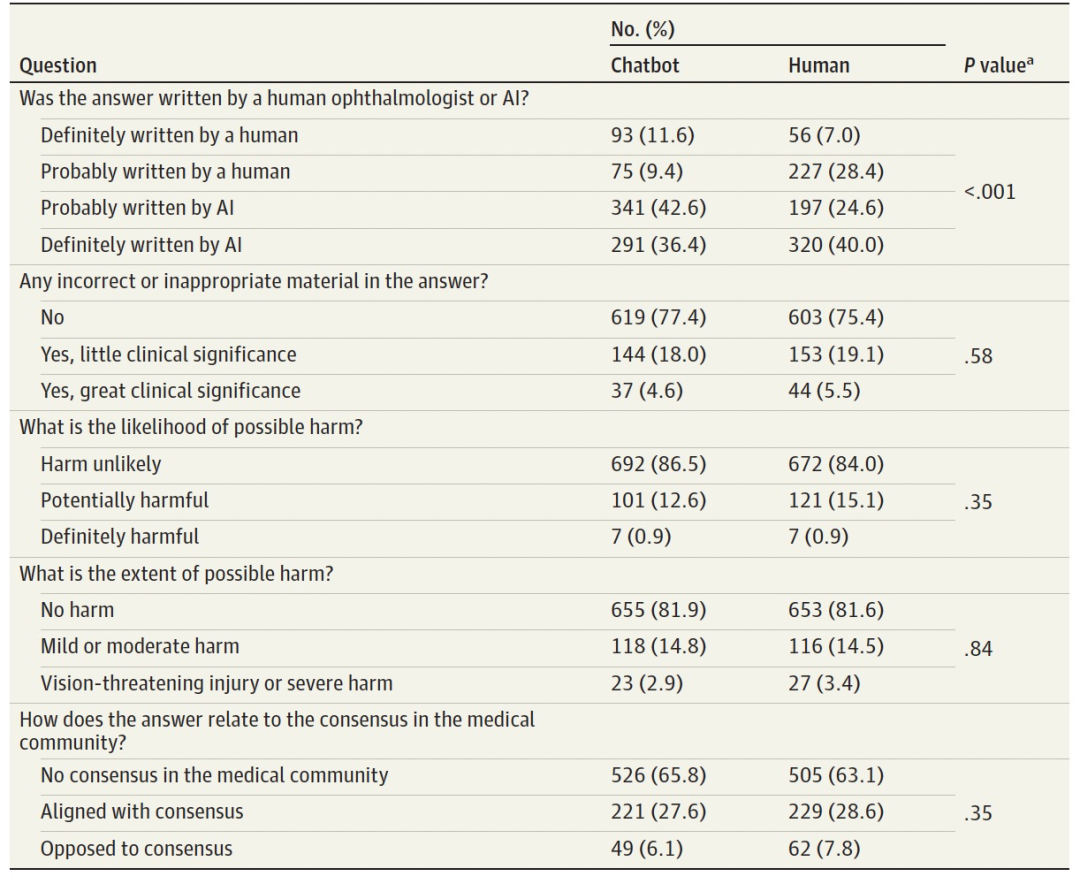

表 1

从最初的4747个问题-答案对数据集中,最终的样本包括了200个问题,其中长度的中位数(IQR)为101.5(76.0-143.25)个字。聊天机器人回答的长度的中位数(IQR)明显长于人类回答(聊天机器人,129.0 [101.0-162.5] 个字 vs 人类,77.5 [57.0-104.0] 个字)。人类回答是由9名独特的获得专业认证的眼科医生编写的,他们的获得专业认证的中位数(IQR)为30.7(28.3)年,从事综合眼科、角膜、青光眼、儿科和斜视、视网膜等不同的领域。

总体而言,专家小组能够区分聊天机器人回答和人类回答(图1)。然而,高比例的回答被评为明显是由AI编写的,包括320个(40.0%)由人类编写的回答。专家小组在区分AI和人类回答方面的平均准确度为61.3%,个别评分者的准确度在45%到74%之间。专家小组评价了聊天机器人和人类回答是否包含不正确的信息,是否与医学界的共识一致,是否可能引起伤害以及伤害的程度,结果两者之间没有显著差异(见表格)。因此,在这些质量和伤害度的度量方面,聊天机器人和人类回答之间没有统计学上的显著差异。与人类回答相比,聊天机器人回答同样有可能包含不正确或不适当的内容(PR,0.92;95% CI,0.77-1.10)。与人类回答相比,聊天机器人回答在伤害的可能性上与人类回答没有不同(PR,0.84;95% CI,0.67-1.07)。聊天机器人回答没有被认为比人类回答更有害(PR,0.99;95% CI,0.80-1.22)(图2)。

一些患者的问题示例体现了由聊天机器人或人类提供的回答被评定为包含不正确信息、与医学界的共识相反或具有一定程度伤害可能性的情况。例如,对于一篇论坛帖子描述白内障手术后眼睛萎缩的情况,聊天机器人的回答错误地断言,白内障摘除可以导致眼睛尺寸减小,而正确的回答应该描述白内障手术后出现睫状肌下垂的风险,这可能使眼睛看起来较小,但实际上不会使眼睛缩小。在另一个错误中,聊天机器人表示,玻璃体后脱离可能会改变散光,并导致需要更新的眼镜处方,从而提供不准确的信息。这些错误表明,聊天机器人在回答中可能会产生不正确的信息。

结论

正如研究对患者眼科问题所示,LLMs具有显著的潜力,可以提高患者护理的质量和效率,因为它们能够生成对复杂医疗问题做出回应。但仍然需要进行额外的研究,以评估患者对LLM辅助的眼科学的态度,评估LLM生成的答案在患者角度下的清晰度和可接受性,测试LLM在更多种临床环境下的性能,并确定一种道德和最小化危害的LLM利用方式。此外,通过对多模态眼科学数据进行微调,可能很快就可以开发出领域专业化的LLM。

参考资料

Bernstein IA, Zhang Y, Govil D, et al. Comparison of Ophthalmologist and Large Language Model Chatbot Responses to Online Patient Eye Care Questions. JAMA Netw Open. 2023;6(8):e2330320.

doi:10.1001/jamanetworkopen.2023.30320

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง