今天是2023年11月10日,星期五,北京,天气晴,气温已经零下。

最近在忙大模型的评估这个有趣的话题。

为了评估模型性能,一种典型的方法是构建评估基准,以衡量LLM在不同方面的能力水平。

尽管已经发布了许多高质量的基准,但人们对这些基准的适当使用和不同模型之间的公平比较的关注却日益增加。

最近,不少工作提出了大量高质量的评估基准,以便对LLM进行全面的能力评估,例如包括MMLU(用于测量多任务语言理解能力)、Big-Bench(用于量化和推断LLM的能力)和AGIEval(用于评估处理人类级任务的能力)。

这些基准在创建或收集用于评估LLM性能的测试资源方面做出了巨大努力。基于这些基准,可以方便地检查新训练策略的效果或监控LLM的训练状态(预训练或监督微调)。

为了证明新发布的LLM的有效性,报告这些评估基准的结果已成为一种普遍做法。此外,为了比较不同LLM的性能,还创建了各种排行榜,根据LLM在现有或新评估基准(如OpenCompass)和C-Eval上的表现进行排名。

尽管这些基准和排行榜得到了广泛应用,但人们对现有LLM评估的公平性和可靠性的担忧却与日俱增。

一个主要问题是,大规模基准评估很可能会出现数据污染或泄漏,这意味着LLM在训练时使用了相关或完全相同的测试数据。这种问题可能是无意识触发的,因为在准备预训练语料库时可能并不知道未来的评估数据集。

例如,GPT-3发现儿童图书测试数据集包含在训练前语料中,LLaMA-2提到BoolQ数据集中的上下文是从网页中逐字提取的,而网页可能包含在公开可用的语料中。

事实上,在使用现有基准进行评估时,被评估LLM的结果大多是在本地服务器上运行或通过API调用获得的。

在此过程中,没有对任何可能导致评估性能非正常提高的不当方式(如数据污染)进行严格检查。更糟糕的是,训练语料的详细构成(如数据源)通常被视为现有LLM的核心”秘密”。

最近的工作《Don’t Make Your LLM an Evaluation Benchmark Cheater》这一文章讨论了不恰当地使用评估基准和误解评估结果的潜在风险和影响。

而如何进行数据污染检测,也是一个很有趣的工作,例如skywork利用GSM8k上的loss差集来反应。

本文对相关工作进行介绍,其供大家一起参考,尤其是其中的一些评估建议,很有趣。

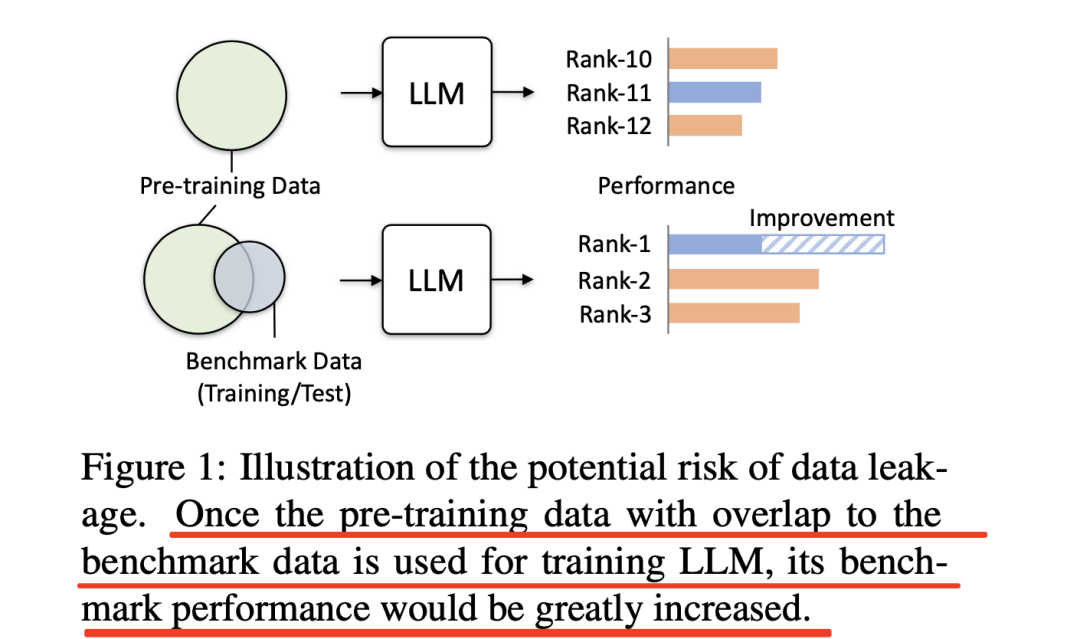

一、关于基准泄漏的模型应用

在预训练期间,很可能会无意识地触发数据污染或可能的评估基准泄漏,这将违反评估零发/少发能力的常规评估设置,从而影响LLM的能力评估。为了更好地理解基准泄漏的潜在影响,进行了一项实证研究,在信息泄漏程度不同的三种设置下持续训练小型LLM。

1、实验设置

使用MMLU训练集:使用官方MMLU基准提供的辅助训练集进行训练。

使用所有训练集:除MMLU训练集外,所有其他收集的评估基准的训练集也用于训练。

使用带有测试提示的所有训练集:所有训练集及其相应的测试提示(如任务描述和少量演示)都用于训练。

使用带有测试提示的所有训练集和测试集:使用所有训练集、测试提示和所有收集到的评估基准的测试集进行训练,这是最极端的情况,所有信息都会泄露。进行此实验只是为了提供参考,绝对不会出现这种情况)

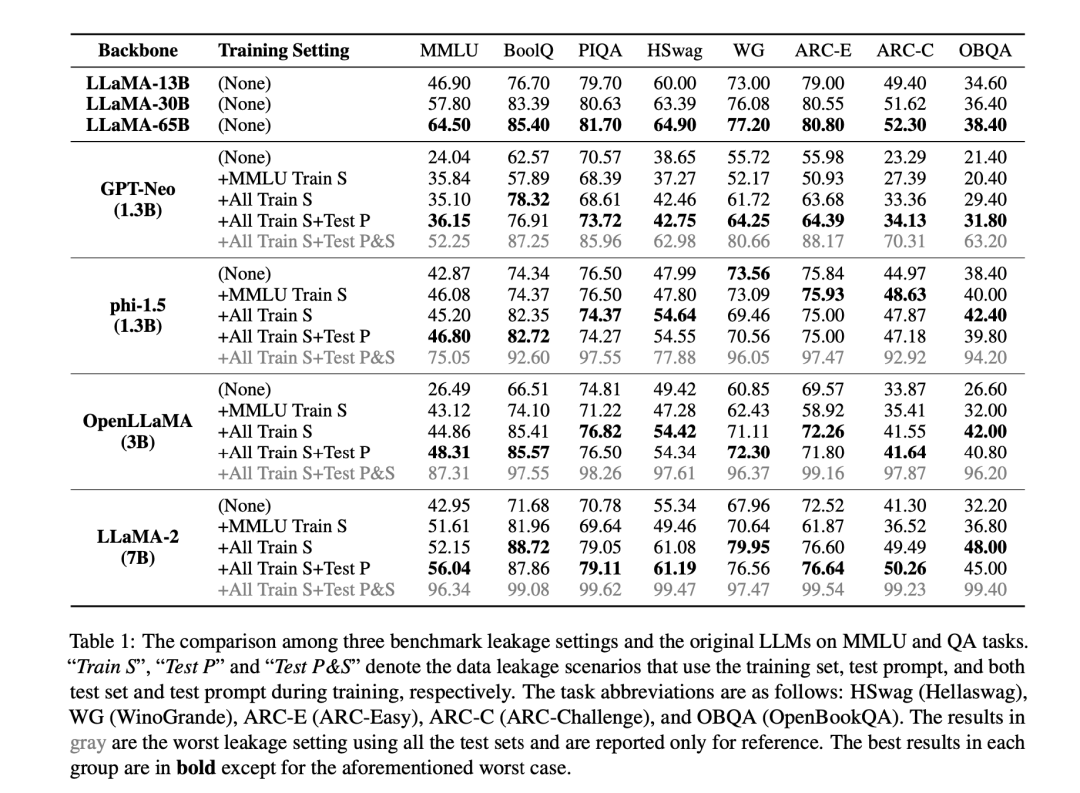

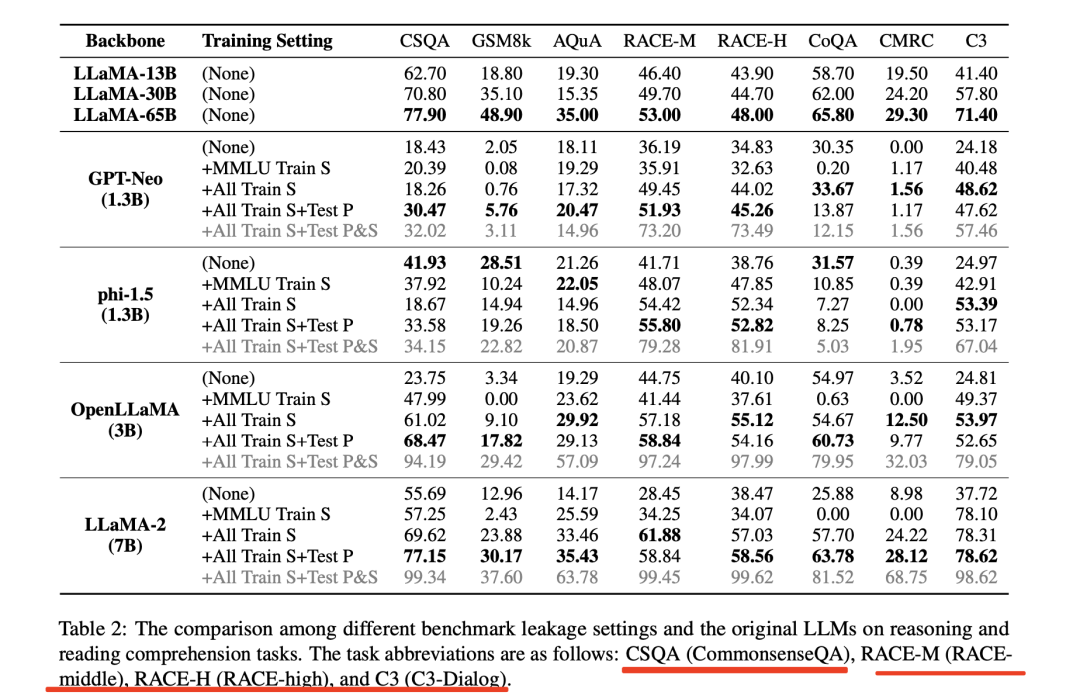

评估基准为了进行实证研究,选择了广泛使用的基准MMLU,并使用了一些问题解答(QA)、推理和阅读理解数据集进行评估。

2、结果与分析

在表1和表2中报告了在基准泄漏设置下对LLM进行训练后的评估结果。

可以看到,不同程度的数据泄漏会导致模型的基准性能膨胀。有以下观察结果。

首先,可以看到,使用MMLU训练集可以大大提高MMLU基准的评估结果。

然而,这种提高是以在与MMLU无关的任务(如分别关于常识和数学知识的HellaSwag和GSM8k)上的性能下降为代价的,这表明过度强调特定任务可能会降低模型的泛化能力。

此外,当纳入所有评估基准的训练集时,几乎所有评估任务的性能都有显著提高。加入训练数据后,原来的zero shot/few shot评估转换为领域内测试。

其次,随着数据泄漏变得越来越严重,评估分数会继续上升。

例如,”phi-1.5-1.3B+AllTrainS+TestP”在RACE-M(55.80对53.00)和RACE-H(52.82对48.00)上的表现优于LLaMA-65B。这凸显了测试提示作为评估基准的宝贵信息的重要性,因为它包含了测试期间的详细输入格式。在训练LLM时,建议避免使用测试提示进行此类特殊学习。此外,这一观察结果还引发了对在评估基准中使用固定测试提示的稳健性的担忧,因为它可能无法抵御上述泄漏风险。

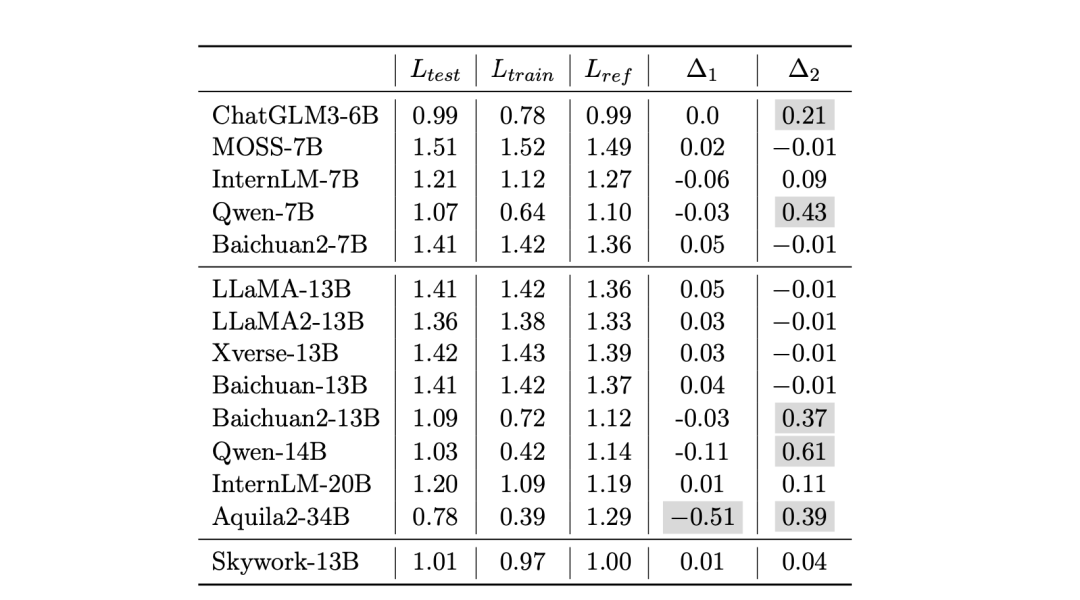

二、基于GSM8K训练loss的泄漏检测

skywork模型有兴趣探索流行的基础模型是否在域内数据上进行了预训练。为此,深入研究了GSM8K数据集,该数据集配备了官方的训练/测试分割和综合解决方案。

在来自同一地区的三个数据集上评估了LLM的loss:

1官方GSM8K训练集;

2)官方GSM8K测试集;

3)由GPT-4生成的类似GSM8K的样本集。

相应的损失分别记为Ltrain、Ltest和Lref。

从理论上讲,如果一个语言模型在预训练期间没有接触过这三个数据集中的任何一个,那么Ltrain、Ltest和Lref这三个损失应该大致相等。但是,如果模型已经在训练集上进行了预训练,或者在预训练过程中无意中暴露了测试数据,就会发现Ltrain、Ltest和Lref之间存在明显的差异。

表8评估了几个基础模型在GSM8K数据集样本上的loss。对于每种LLM,都比较了其在训练分集(Ltrain)、测试分集(Ltest)和由GPT-4生成的专门设计用于模拟GSM8K数据集的参考集(Lref)上的LM损失。还报告了两个关键指标,其中:

∆1=Ltest-Lref,作为LLM训练过程中潜在测试数据泄漏的指标,即值越低表明可能存在泄漏;

∆2=Ltest-Ltrain,用于衡量数据集训练分集的过度拟合程度。∆2值越高,表示过度拟合。

∆1和∆2的异常值均以灰色标出。

值得注意的是,∆2一栏显示,对于大多数模型来说,GSM8K训练和测试集上的语言建模loss几乎是一致的,而ChatGLM3-6B、Baichuan2-13B、Qwen-7B/14B和Aquila2-34B等模型在训练集合上的损失明显低于测试集合。因此,推测这些模型可能在GSM8K训练集合或类似数据上进行了大量的预训练。

此外,∆1列中有一个特殊的反常现象,即Ltest的损失明显低于Lref。

三、针对榜单评测评估的建议

1、考虑到与基准泄漏相关的潜在风险,建议使用来自不同来源的更广泛基准进行性能评估。这有助于降低因数据污染而导致结果夸大的风险。如果可行,结合人工评估和进行定性分析也会有所裨益。

2、除了评估LLM的高级能力(如推理和事实知识)外,还有必要对其他侧重于基本能力(如文本生成)的数据集进行评估。这种综合方法对于全面评估LLM的能力非常必要。即应使用更多不同来源的基准,涵盖基本能力(如文本生成)和高级能力测试(如复杂推理),以全面评估LLM的能力。

3、在预训练数据中对数据去污进行严格检查,避免在训练过程中包含任何后续评估数据。为此,可以使用n-gram(一般情况下,n=13)哈希算法来检查预训练数据与某些特定任务的评估数据之间的重叠情况。

4、如果可能,还建议将主流评估基准的训练数据排除在预训练数据之外。

5、在展示某些评估基准的结果时,请指出任何潜在的数据污染风险(如有),并报告污染分析(如重叠统计),例如Llama-2的报告。

6、应采用多样化的测试提示,以减少提示敏感度的影响。此外,在基准数据和现有的预训练语料库之间进行污染分析,提醒任何潜在的污染风险也是有意义的。

总结

本文主要介绍了《Don’t Make Your LLM an Evaluation Benchmark Cheater》这一文章。

根据在前面几节中的实证发现,如果测试任务的相关或相同数据被准确地用于训练,那么LLM在特定基准中的评估结果就会大幅提升。

然而,在实践中,要完全消除模型训练中的泄漏风险具有挑战性。这是因为评估基准通常是基于一些公共文本来源(如网页和科学论文)来构建的,在这种情况下,相关数据(如用于生成测试问题的原始文本)可能偶尔会包含在LLM的预训练数据中。

虽然现有的评估数据集很容易从训练新LLM的预训练数据中排除,但要识别评估基准和预训练语料库之间所有潜在的数据依赖关系仍然很困难。不过这不就是数据配备的奥秘么?

参考文献

1、https://arxiv.org/abs/2311.01964

2、https://arxiv.org/abs/2310.19341

关于

老刘,刘焕勇,NLP开源爱好者与践行者,主页:https://liuhuanyong.github.io。

老刘说NLP,将定期发布语言资源、工程实践、技术总结等内容,欢迎关注。

对于想加入更优质的知识图谱、事件图谱、大模型AIGC实践、相关分享的,可关注公众号,在后台菜单栏中点击会员社区->会员入群加入。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง