研究领域:神经网络,表征一致性,预测可塑性 郭瑞东 | 编译

郭瑞东 | 编译 论文标题:The combination of Hebbian and predictive plasticity learns invariant object representations in deep sensory networks论文地址:https://www.nature.com/articles/s41593-023-01460-y 基于感官刺激,识别物体并认识到不同大小、背景、方向的物体是同一个,对动物生存是必须的。Nature Neuroscience 近日的研究,在人工神经网络上,构建了基于预测性可塑性以及赫布法则的隐式预测学习规则(latent predictive learning,LPL),该规则可实现表征一致性,并在深度神经网络与尖峰神经网络上泛化。该模型准确地捕捉了灵长类动物颞下皮层观察到的神经元选择性变化,强调了预测可塑性对成功的表征学习的重要性。

论文标题:The combination of Hebbian and predictive plasticity learns invariant object representations in deep sensory networks论文地址:https://www.nature.com/articles/s41593-023-01460-y 基于感官刺激,识别物体并认识到不同大小、背景、方向的物体是同一个,对动物生存是必须的。Nature Neuroscience 近日的研究,在人工神经网络上,构建了基于预测性可塑性以及赫布法则的隐式预测学习规则(latent predictive learning,LPL),该规则可实现表征一致性,并在深度神经网络与尖峰神经网络上泛化。该模型准确地捕捉了灵长类动物颞下皮层观察到的神经元选择性变化,强调了预测可塑性对成功的表征学习的重要性。

1. 问题

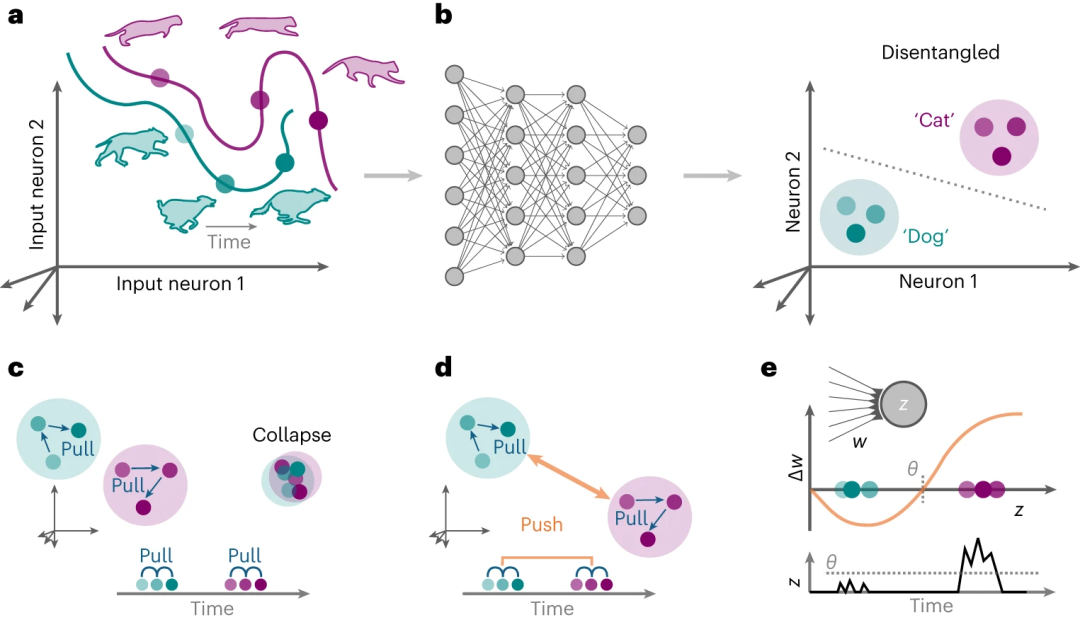

当我们看到一只奔跑的狗的时候,进入视野的狗处在不同的背景,有着不同的姿势和大小,然而我们能认出这是同一只狗。对于跑动的猫,尽管猫和狗有着不同的步态,但人脑都会对其产生相同的表征,这被称为表征一致性(图1a)。在神经网络的场景下,表征一致性意味着对于不同类的猫和狗的影像,进行准确的分类(图1c)。这需要将纠缠的输入模式映射到纠缠的神经元活动模式,这些模式位于流形上,就像一张张皱巴巴的纸一样“拥抱”彼此。纠缠的神经元活动模式对潜在因素进行编码,这样下游神经元就可以很容易地读出这些因素。这种转变需要深层感觉网络,通过经验依赖的可塑性形成特定的网络连接(图1b)。  图1. 深度神经网络可用来区分感知刺激 依赖标签的有监督学习,并不是针对生物体大脑活动模拟的合适工具。而自监督学习,例如根据句子中上一个词预测下一个词,或预测不完整图像缺失的那部分。回到上述猫和狗的例子,不同时间的影像,会相互将其内在表征拉在一起。然而,这种策略的一个主要问题是,在缺乏负反馈之时,不同的表征会汇聚到一起,所有输入都映射到相同的内部活动模式(图1c),为避免需将不同时间(相距较长时间)出现的表征视作不同的,从而将不同类的表征推开(图1d),如在尖峰神经网络中,先后出现的猫和狗在不同时间点的表征,根据是否超过阈值判定为猫或狗。

图1. 深度神经网络可用来区分感知刺激 依赖标签的有监督学习,并不是针对生物体大脑活动模拟的合适工具。而自监督学习,例如根据句子中上一个词预测下一个词,或预测不完整图像缺失的那部分。回到上述猫和狗的例子,不同时间的影像,会相互将其内在表征拉在一起。然而,这种策略的一个主要问题是,在缺乏负反馈之时,不同的表征会汇聚到一起,所有输入都映射到相同的内部活动模式(图1c),为避免需将不同时间(相距较长时间)出现的表征视作不同的,从而将不同类的表征推开(图1d),如在尖峰神经网络中,先后出现的猫和狗在不同时间点的表征,根据是否超过阈值判定为猫或狗。

2. 发现

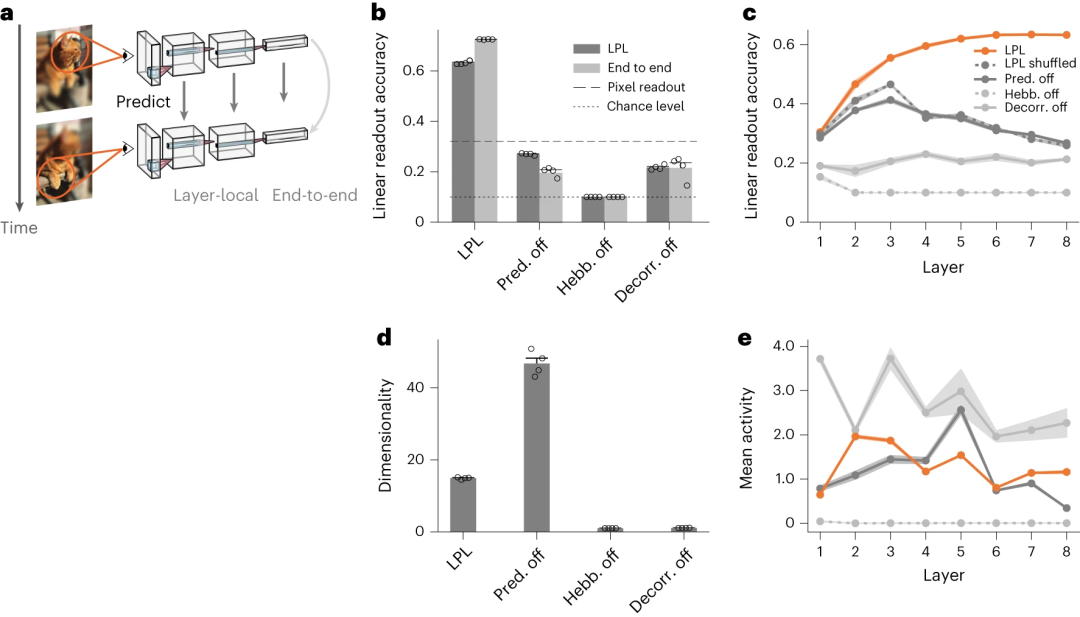

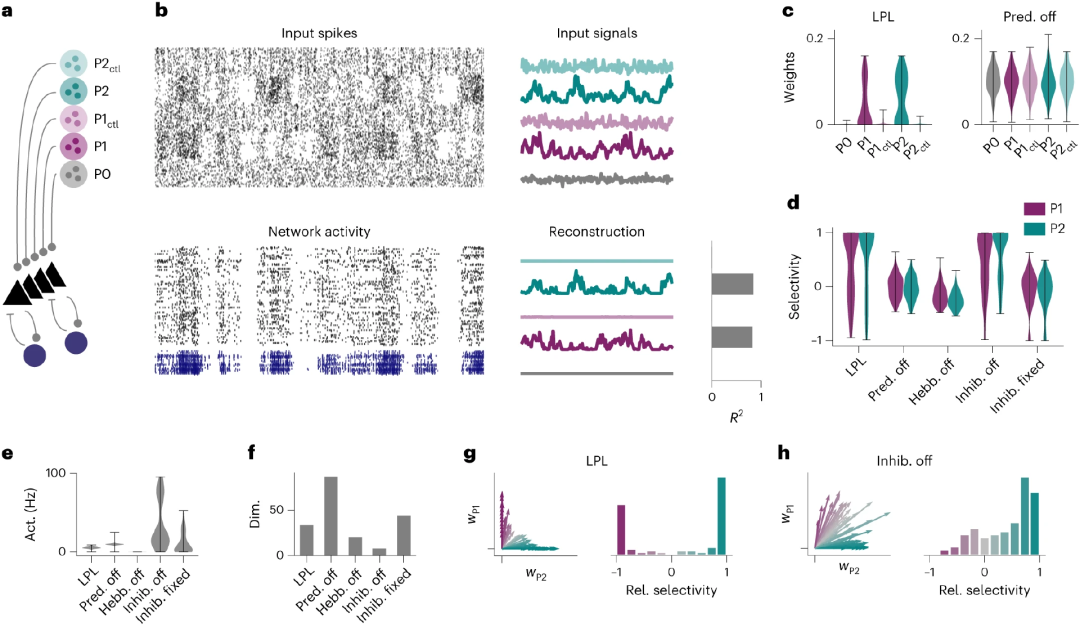

赫布法则指出,局部共同激活的神经元间连接会增强。预测性编码理论则指出,神经元会根据预测值与观察值的误差更新连接权重。新提出的LPL规则在突触权重更新时,同时考虑了上述两个因素。而只有当两个因素同时发挥作用时,模型才能具有表征一致性,如图2所示,当更新规则中去掉代表赫布法则或预测性编码的项的时候,其预测准确性显著下降。  图2. 基于隐式预测学习规则构建的神经网络,具有表征一致性 在更真实的场景(即包含100个兴奋神经元和25个抑制神经元组成的,在连续时间轴上训练的尖峰神经网络SNN),使用LPL规则,针对给定的输入(即包含多个同类对象,不同背景的图片),让该神经网络自行演化。在模拟持续了28小时后,发现在两组不同的初始条件P1及P2下,同时考虑预测性编码及赫布法则的LPL权重更新规则的网络,在预测准确性上优于只考虑预测性编码或赫布法则的网络。此外,抑制可塑性是必要的,以确保缓慢的信号能够被优先代表。总之,该实验证明了LPL规则可应用于更具有生物学意义的保护兴奋及抑制的神经网络。

图2. 基于隐式预测学习规则构建的神经网络,具有表征一致性 在更真实的场景(即包含100个兴奋神经元和25个抑制神经元组成的,在连续时间轴上训练的尖峰神经网络SNN),使用LPL规则,针对给定的输入(即包含多个同类对象,不同背景的图片),让该神经网络自行演化。在模拟持续了28小时后,发现在两组不同的初始条件P1及P2下,同时考虑预测性编码及赫布法则的LPL权重更新规则的网络,在预测准确性上优于只考虑预测性编码或赫布法则的网络。此外,抑制可塑性是必要的,以确保缓慢的信号能够被优先代表。总之,该实验证明了LPL规则可应用于更具有生物学意义的保护兴奋及抑制的神经网络。  图3. 尖峰神经网络中应用隐式预测学习规则可具有表征一致性

图3. 尖峰神经网络中应用隐式预测学习规则可具有表征一致性

3. 总结

理解已建立的数据驱动可塑性模型如何与理论驱动的学习范式结合,对神经科学理解人脑如何将学习规则的各个不同组成部分应用于局部神经网络的动力学至关重要。该研究提出的局部可塑性规则,尽管只应用于视觉领域,且与主流算法(基于自上而下的反馈)在预测准确性上存在差距,但仍可使神经网络具有表征一致性。该研究中,作者还结合恒河猴的实验数据,说明其可定性地捕捉颞下皮质在非监督式学习实验中观察到的表征变化,从而为目前理论与实验之间的差距提供了一种可能的解释。

神经动力学模型读书会

为了促进神经科学、系统科学以及计算机科学等多领域学术工作者的交流合作,吸引更多朋友共同探索脑科学与类脑研究,周昌松、臧蕴亮、杨冬平、郭大庆、陈育涵、曹淼、刘泉影、王大辉、刘健、王鑫迪等来自国内外多所知名高校的专家学者在集智俱乐部共同发起「神经动力学模型」读书会,历时四个月研讨,近日圆满结束。

本季读书会形成了聚集500+成员的神经动力学社区,积累了40+小时综述、解读、研讨的视频记录,以及多篇社区成员总结的词条、笔记、翻译、科普资料等。现在报名加入读书会,即可加入社区交流讨论(微信),并解锁相关视频、文本资料。我们对脑的探索才刚刚起航,欢迎你一道参与,共同点亮更多脑科学研究的岛屿!

详情请见:

500+神经动力学社区成员,邀你共同点亮更多脑科学研究的岛屿

推荐阅读

1. 前沿速递:神经网络中的功能模块化与解剖学模块化同时涌现2. PRL速递:随机神经网络中的活动维度3. 大脑不对称性的起源:任务复杂性打破神经网络镜像对称性4. 张江:第三代人工智能技术基础——从可微分编程到因果推理 | 集智学园全新课程5. 成为集智VIP,解锁全站课程/读书会6. 加入集智,一起复杂!

点击“阅读原文”,报名读书会

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง