今天是2023年11月14日,星期二,北京,天气晴。

我们来讲讲微调上的一些省内存方案。

LoRA是降低微调LLM时降低可训练参数的一种方法,但是将其应用在更大的模型仍然面临着挑战。文章《VeRA:Vector-based Random Matrix Adaptation》(https://arxiv.org/pdf/2310.11454.pdf)提出了一种基于向量的随机矩阵适配(VeRA,Vector-based Random Matrix Adaptation)。

在效果上,与LoRA相比,其可以将训练参数的数量减少10倍,但保持相同的性能。

本文对该工作进行介绍,供大家一起参考。

一、相关工作

1、LoRA

LoRA为LLM微调带来的计算挑战提供了一种新颖的解决方案。该方法使用低秩矩阵来近似微调过程中的权重变化,从而有效地减低训练所需的参数量。其还可以使用量化模型权重来进一步降低要求。

与基于adapter的微调方法相比,LoRA在部署时不会产生额外的推理时间成本,因此训练矩阵可以和权重合并。

AdaLoRA扩展了LoRA方法,在微调过程中引入了低秩矩阵的动态调整。核心思想是通过基于重要性度量来选择性的修剪矩阵中不太重要的分量,从而优化参数预算的分配。

2、现有方法的参数效率

虽然LoRA这样的方法在微调性能方法展现出了显著的改善,但是仍然需要大量的可训练参数。基于Aghajanyan等人的研究,内在维度的上限比这种方法中通常使用的秩要小的多。

因此,参数量可以进一步减少。虽然AdaLoRA通过动态分配参数,从而进一步减少了可微调参数。

但是,我们认为存在另一种可以显著减少可训练参数,且效果不会下降的方法。

3、随机模型和投影

使用随机矩阵和投影来提高模型效率的概念已经得到了多方面研究的支持。Frankle&Carbin发现随机初始化的神经网络中包含训练时能够达到高性能的子网络。此外,Ramanujan等人了存在的子网络即使没有训练也能够取得令人印象深刻的结果。Aghajanyan等人展示了仅训练少量参数,随机投影会完整空间,能够实现全参数模型效果的90%。其他的一些工作也表明,冻结的随机初始化模型加上小部分的微调,表现出奇的好。

三、方法

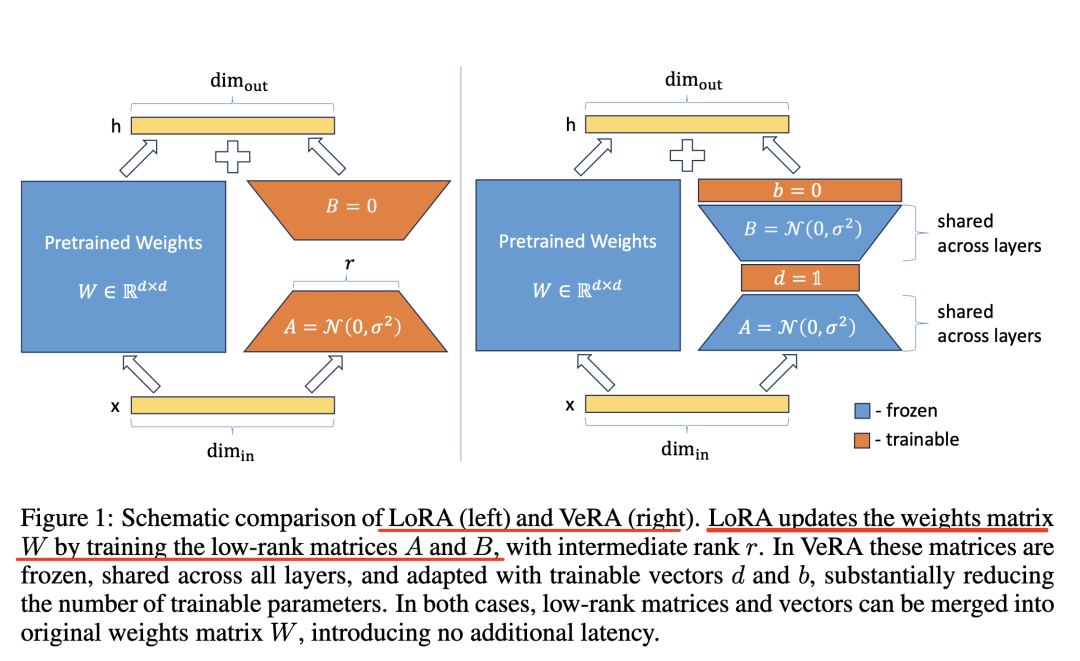

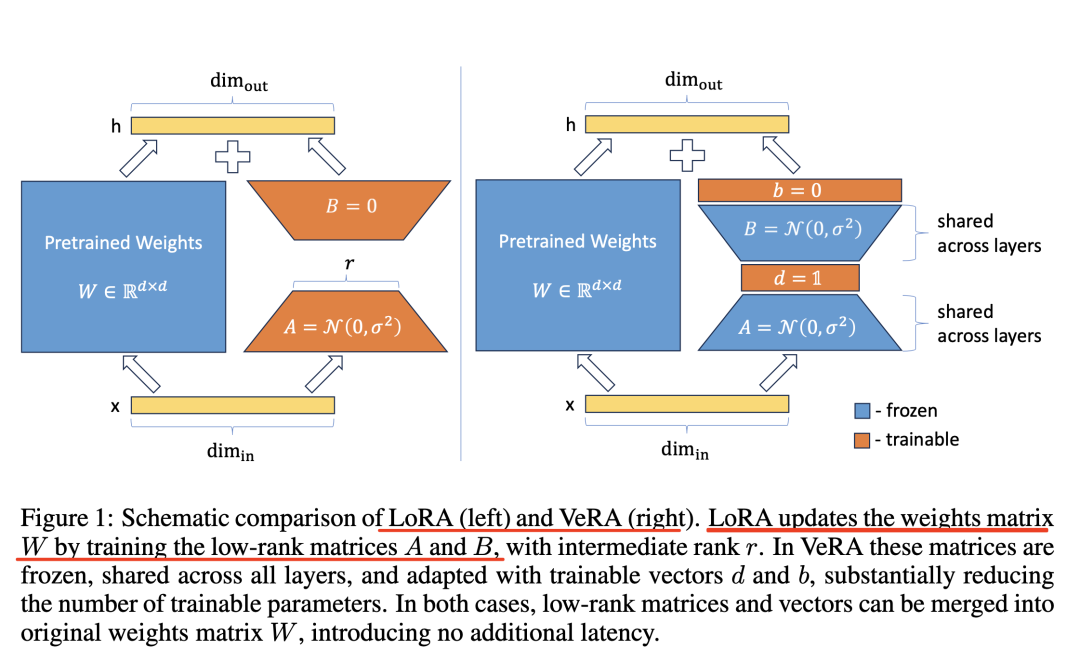

VeRA的核心创新是低秩矩阵的重参数化。具体来说,冻结一对随机初始化的矩阵,这些矩阵在所有适配层之间共享,然后引入可以逐层自适应的可训练缩放向量。

如上图1所示,类似于LoRA,训练的缩放向量和低秩矩阵可以合并至原始权重中,从而消除额外的推理延迟。

1、方法介绍

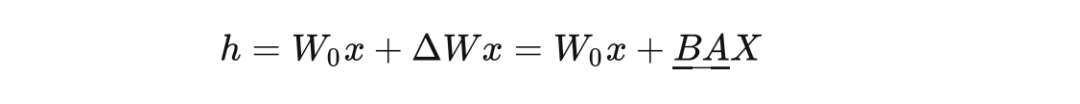

LoRA微调两个低秩矩阵的乘积来适应LLM。正式来说,对于预训练权重矩阵W0∈Rm×n,权重更新矩阵被约束为低秩分解,即

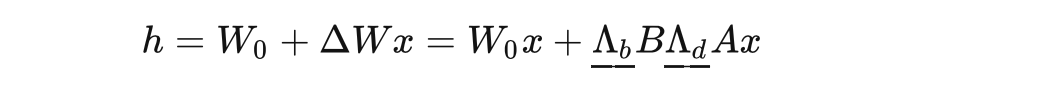

其中带有下划线的参数通过梯度更新。这种近似可以使得模型保持原始权重W0冻结,同时仅优化低秩矩阵 A和B。它们的尺寸要远比原始矩阵小。 A的形状是m×r,B的形状是r×n,而r≪min(m,n) 。相比, VeRA为

在本方法中,B和A是冻结、随机且跨层共享的,而缩放向量b和d是可训练的,形式上表达为对角矩阵Λb和Λd。在这种情况下,B∈Rm×r和A∈Rr×n不需要是低秩的。这是因为这两个矩阵是静态的,并且不需要存在这些值。相反,由于d∈R1×r,改变r仅会线性增加可训练参数的数量。

2、参数计数

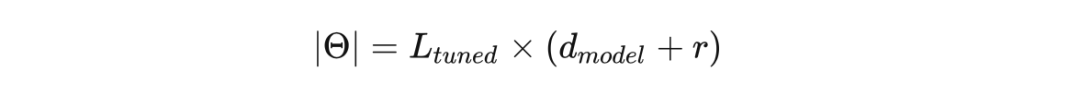

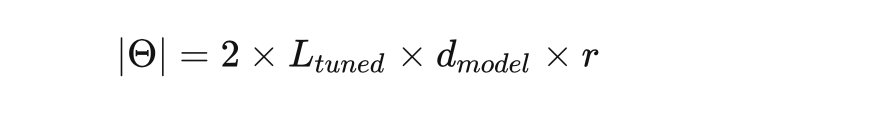

使用 Ltuned表示微调层的数量,dmodel表示这些层的维度。VeRA的可训练参数数量为:

而LoRA的可微调参数为:

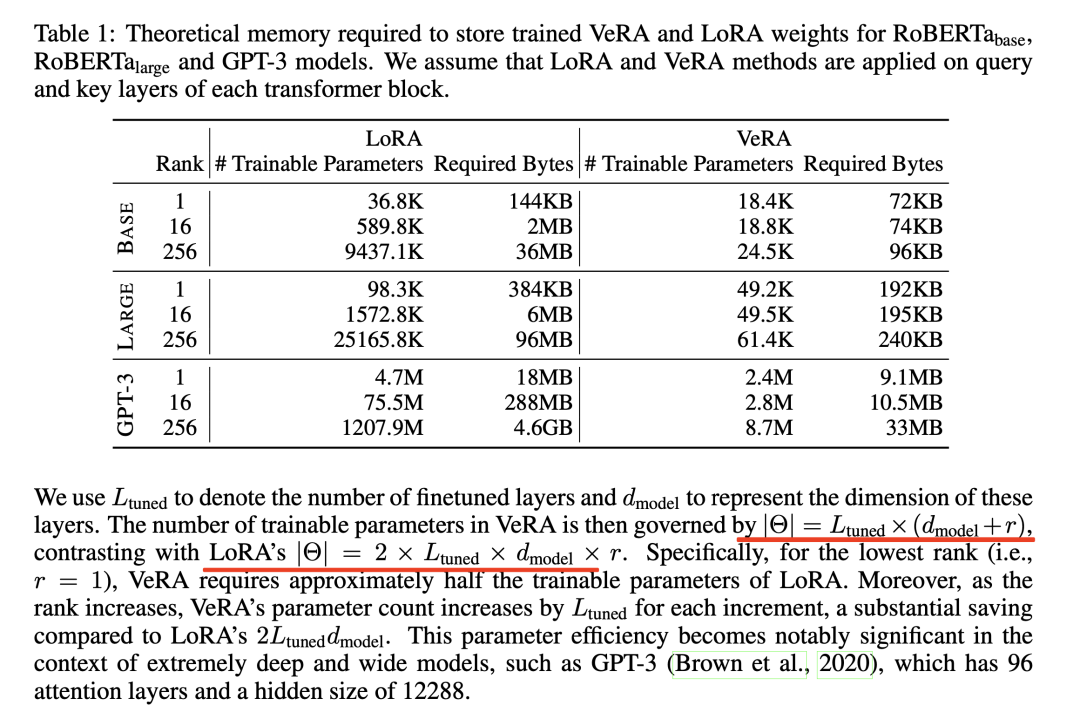

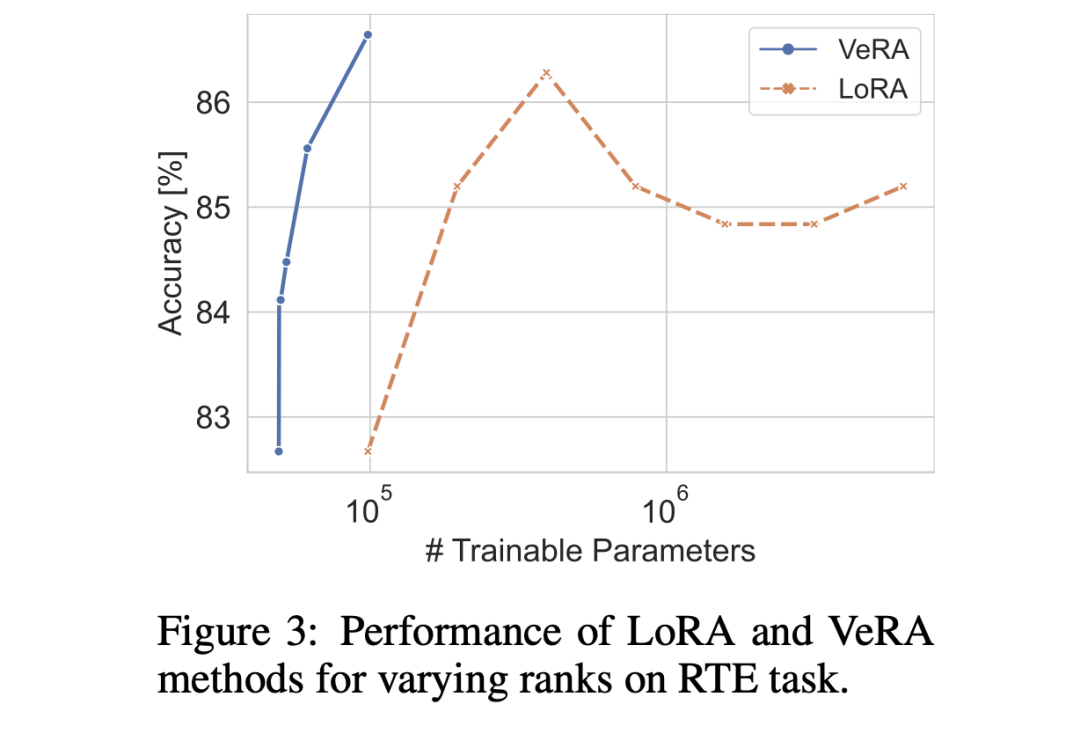

具体来说,对于最低的秩(r=1),VeRA大约需要LoRA一半的可训练参数。此外,随着秩的增加,VeRA的可训练参数一次仅增加Ltuned,而LoRA则增加2Ltuneddmodel 。对于极大的模型,这种参数效率则极为显著,例如GPT-3有96个注意力层且hidden size为12288。

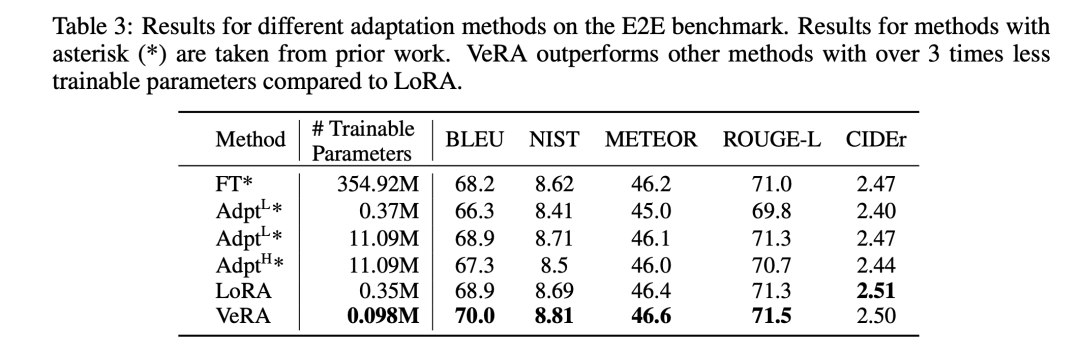

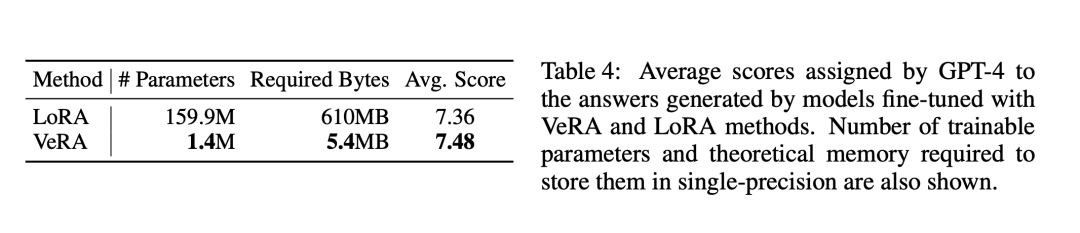

VeRAA的主要优势是存储训练的权重占用非常小的存储空间。因此随机冻结矩阵可以从随机数生成器种子中重新生成,所以这些矩阵不需要存储。这大大减少了内存的需求,现有的内存需要仅限于训练向量 b和d以及单个随机数种子所需要的字节。与LoRA相比的内存效率如表1所示。

3、初始化策略

共享矩阵。利用Kaiming初始化方法来初始化冻结低秩矩阵A和B。通过基于矩阵维度的缩放至,其能确保A和B的矩阵乘积对所有秩保存一致的方差,从而消除对每个秩的学习率进行微调的需求。

缩放向量。缩放向量b被初始化为0,这与LoRA中矩阵B的初始化是一致的,能确保权重矩阵在第一次前向传播时不受影响。缩放向量d的所有元素使用单个非零值进行初始化,从而引入了一个新的超参数。调整该超参数可以带来更好的效果。

图1展示了VeRA中低秩矩阵和缩放向量的初始化示例。具体来说看,使用正态分布来初始化低秩矩阵,并使用1来初始化d向量。

四、实验

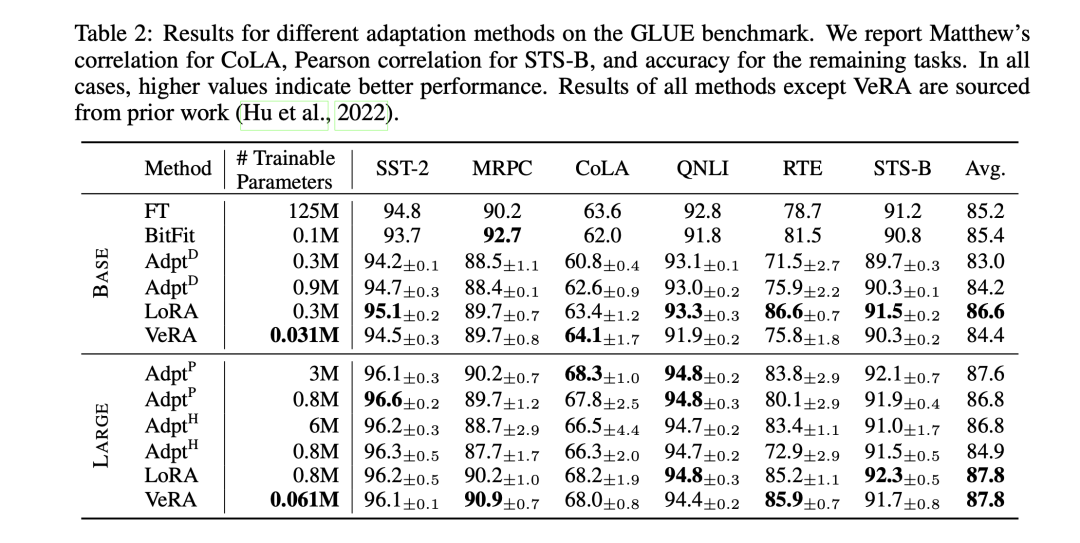

baselines包括:全参微调、Bitfit(仅微调bias向量,其他参数保存固定)、Adapter tuning、LoRA。

1、GLUE Benchmark

2、E2E Benchmark

3、LLaMA-2-7B指令遵循

4、可训练参数数量的影响

总结

本文主要介绍了文章《VeRA:Vector-based Random Matrix Adaptation》(https://arxiv.org/pdf/2310.11454.pdf),该提出了一种基于向量的随机矩阵适配(VeRA,Vector-based Random Matrix Adaptation)。与LoRA相比,其可以将训练参数的数量减少10倍,但保持相同的性能。

不过,这种微调方式,本质上是省内存的操作,对于特别大的模型来说,还是能节省不少训练时显存,但效果还是差于全参微调。单论基于内在维度的低秩微调方法,感觉可深挖的空间不大了。

参考文献

1、https://arxiv.org/pdf/2310.11454.pdf

2、https://zhuanlan.zhihu.com/p/664188901

关于我们

老刘,刘焕勇,NLP开源爱好者与践行者,主页:https://liuhuanyong.github.io。

老刘说NLP,将定期发布语言资源、工程实践、技术总结等内容,欢迎关注。

对于想加入更优质的知识图谱、事件图谱、大模型AIGC实践、相关分享的,可关注公众号,在后台菜单栏中点击会员社区->会员入群加入。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง