新智元报道

编辑:LRS

【新智元导读】人民大学最新研究指出,更好的数据增强虽然可以提升其在下游任务的泛化能力,但也会减弱对比学习的上游性能。

近年来,由于数据规模的增大以及标签信息的缺失,自监督方法的使用逐渐广泛。

由于在图结构数据中可以轻松的利用边以及节点的drop进行增强,对比学习成为了天然的自监督范式。图对比学习在数据增强后,得到两个视图,两视图中的对应节点作为正样本,其余节点作为负样本。过去的研究者一般认为最优的对比学习需要进行完美的正样本对齐(正样本的表征一致),以及负样本表征在特征空间的均匀分布。同类节点的表征在经过数据增强后的特征空间可能存在交集(augmentation overlap),假如对于两个同类节点,数据增强将其映射为同一个节点,由于对比学习需要将正样本拉近,则最优的表征应当是,因此,通过一个较强的数据增强,正样本对齐可以一定程度上拉近同类样本距离。近日,来自中国人民大学的研究人员指出,正样本对齐或许不能帮助提升对比学习性能,甚至会损害其泛化能力。而数据增强应当在尽可能保留原始信息的情况下更强,例如drop更多的边以及节点。 论文地址:https://arxiv.org/abs/2310.03977v1研究者认为一个较强的数据增强会减弱对比学习的上游性能,但会提升其泛化能力以获取更好的下游任务表现。随后,利用理论分析得出采用一个更强的数据增强,对比学习的下游表现可能变好,但同类样本之间不一定会逐渐聚合,而不同类的样本会逐渐分散,并进行实验验证了这一点。为了进一步探究这一现象背后的原因以及数据增强如何影响对比学习,研究者给出了数据增强与泛化性能之间的关系,发现一个较强的数据增强虽然会损害对齐性能,但也会提升其泛化能力,加强其在下游任务上的表现。

论文地址:https://arxiv.org/abs/2310.03977v1研究者认为一个较强的数据增强会减弱对比学习的上游性能,但会提升其泛化能力以获取更好的下游任务表现。随后,利用理论分析得出采用一个更强的数据增强,对比学习的下游表现可能变好,但同类样本之间不一定会逐渐聚合,而不同类的样本会逐渐分散,并进行实验验证了这一点。为了进一步探究这一现象背后的原因以及数据增强如何影响对比学习,研究者给出了数据增强与泛化性能之间的关系,发现一个较强的数据增强虽然会损害对齐性能,但也会提升其泛化能力,加强其在下游任务上的表现。

背景与动机

一般来说,随着数据增强幅度的变化,对比学习在下游任务的表现也会出现明显的改变。由此可见数据增强在对比学习中起到了至关重要的作用,但如今对其的理解仍然存在偏差。

过去的研究往往认为通过augmentation overlap以及正样本对齐、负样本均匀分布就可以得到一个优异的对比学习模型。但实际上,随着数据增强变强,augmentation overlap会变得更多但正样本的对齐也会变得更难。因此augmentation overlap与正样本对齐很难同时达到最优。与此同时,也有其他研究者指出对比学习中的augmentation overlap实际上非常稀少,因此数据增强可能并不是通过augmentation overlap帮助下游任务。为此需要进一步探究数据增强在对比学习中起到什么样的作用。

数据增强如何影响下游任务?

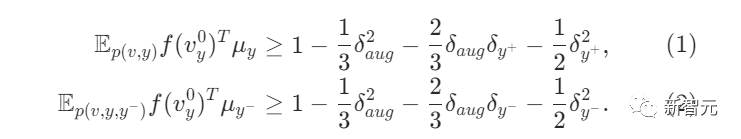

研究者假设经过数据增强后节点的标签信息不变,即原始节点与增强节点仍属于同一个类别。并且经过GNN编码后原始节点与增强节点的表征区别会随着数据增强幅度的增加而增加,即drop的边越多越大。由此,可以分析节点经过GNN编码后与其类别中心的相似程度。

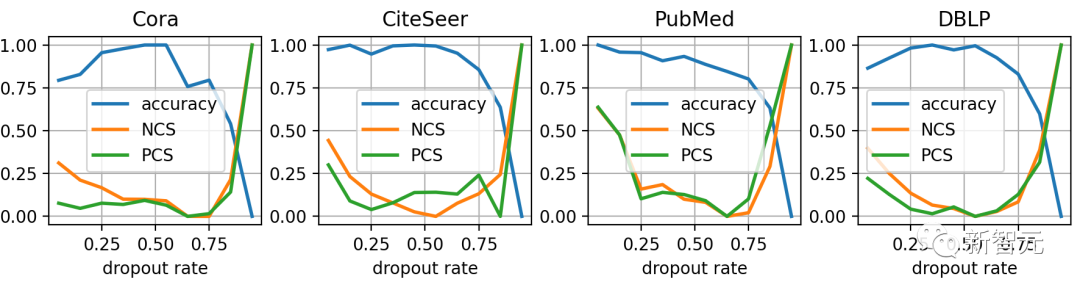

其中为各个类别的中心位置, 代表同类节点之间的期望距离,并且为不同类节点的期望距离。当逐渐增强数据增强时,对比学习在下游任务上的表现往往先上升后下降,此处仅考虑其处于上升阶段的过程。因此数据增强的幅度越强,下游任务表现越好,类内的节点越发聚合,类外的节点越发分散,即增大,同时减小,增大。则公式(1)的右侧值的变化趋势难以预测,而公式(2)右侧会持续变小。因此采用更强的数据增强时,节点与其类内中心的相似度不一定会变大,而其与不同类中心的相似度会逐渐变小。则对比学习的性能更多依赖将节点与其余类别中心拉远而非将其与自身的类别中心拉近。为了验证这一点,研究者在几个图数据集上进行实验,发现在提升drop比例时,节点与其类别中心的相似度(PCS)可能会下降,但由于其与其他类别中心相似度(NCS)下降的更为剧烈,因此其下游性能仍然会提升。 数据增强与泛化为了进一步分析数据增强在对比学习中的作用,研究者尝试分析其对泛化性能的影响。

数据增强与泛化为了进一步分析数据增强在对比学习中的作用,研究者尝试分析其对泛化性能的影响。

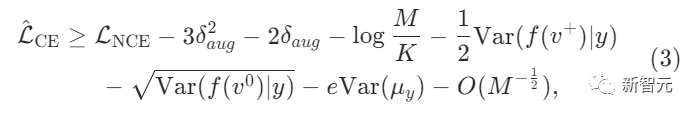

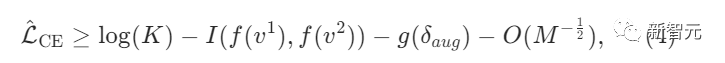

其中为下游分类任务的损失函数,为对比学习损失函数。为负样本数量,为类别数量。由此可见,虽然一个较强的数据增强会损害对齐性能导致NCE loss更大,但会带来更好的泛化能力使得下游任务的loss降低。并且由于,一个更强的数据增强会导致其分子难以优化,则模型会更加关注其分母部分,使其负样本的距离逐渐增大,而负样本中大部分为不同类别的样本,因此对比学习会更加注重将不同类别拉远。

寻求更优的数据增强

信息论角度

公式(3)中的可以表示为互信息,其余项可以使用进行表示,由此可以得到如下公式:

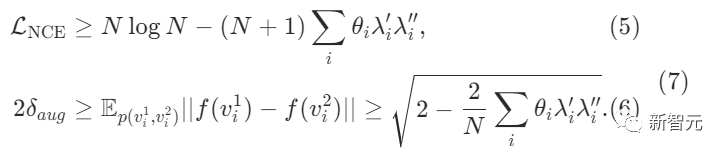

由此可见,一个表现良好的数据增强应当尽可能保留原始数据的信息,同时增加数据增强的幅度。目前大部分的对比学习方法如GCA等实际上也正是在做这件事。为了进一步验证该点,研究者设计了一个简单且有效的算法。通过对节点特征的导数表示该特征的重要程度,而后将节点的各个特征以及特征的各个节点分别求和作为节点和特征的重要程度,将边两端节点的重要程度进行平均作为边的重要程度。其中为节点的特征的重要程度,分别为特征、节点以及边的重要程度。而后类似于GRACE,进行随机的dropout,并选取最重要的个特征/边,将其保护起来(防止其被drop)以增强两个视图的互信息,同时drop最不重要的个特征/边以增强数据增强的幅度。谱角度过去已经有学者研究了对比学习InfoNCE损失与图邻接矩阵特征值之间的关系,对其进行简单的拓展即可得到如下公式: 其中为对比学习的参数,可被视为正数。为两个增强视图的邻接矩阵特征值。若将认为是常数,而将作为变量,可以发现,一个较小的InfoNCE损失需要一个较大的,而一个较大的需要一个较小的,两者相互矛盾。由于InfoNCE在训练过程中持续被优化,研究者注重于对的调优。因此尝试缩小,即使图结构数据的谱变得更加平滑,这一点也被过去的一些研究证明可以缓解GNN的oversmooth问题。其中为当前的取值,为过去的取值。为每次调整的步长。这一方法认为在正常训练过程中需要逐渐增大以减小InfoNCE损失,因此若持续增大,可以尝试降低以获取更大的,而当减小,说明训练过程已经受到影响,应当停止对的调整。

其中为对比学习的参数,可被视为正数。为两个增强视图的邻接矩阵特征值。若将认为是常数,而将作为变量,可以发现,一个较小的InfoNCE损失需要一个较大的,而一个较大的需要一个较小的,两者相互矛盾。由于InfoNCE在训练过程中持续被优化,研究者注重于对的调优。因此尝试缩小,即使图结构数据的谱变得更加平滑,这一点也被过去的一些研究证明可以缓解GNN的oversmooth问题。其中为当前的取值,为过去的取值。为每次调整的步长。这一方法认为在正常训练过程中需要逐渐增大以减小InfoNCE损失,因此若持续增大,可以尝试降低以获取更大的,而当减小,说明训练过程已经受到影响,应当停止对的调整。

实验部分

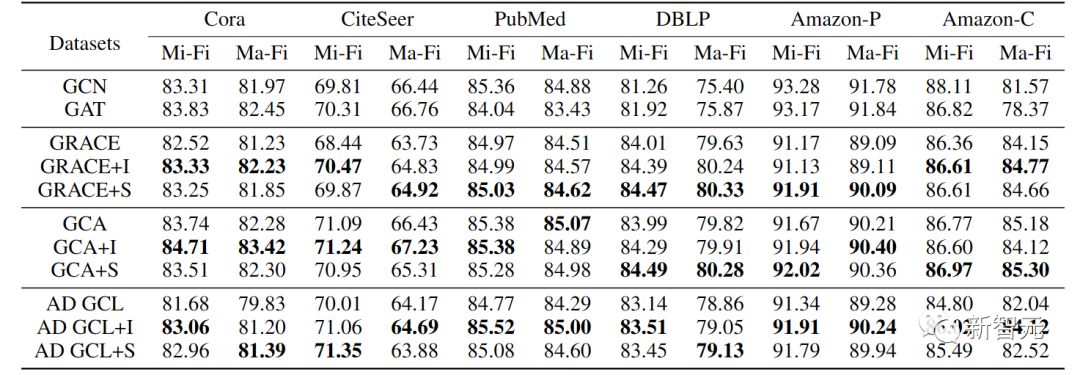

实验利用三种基础的图对比学习方法GRACE、GCA以及AD GCL进行实验,GRACE+I代表GRACE与提出的信息论方法耦合,GRACE+S代表GRACE与提出的谱增强方法耦合。可以看到两种优化方法在3种不同的对比学习方法以及6个数据集上都取得了性能提升。

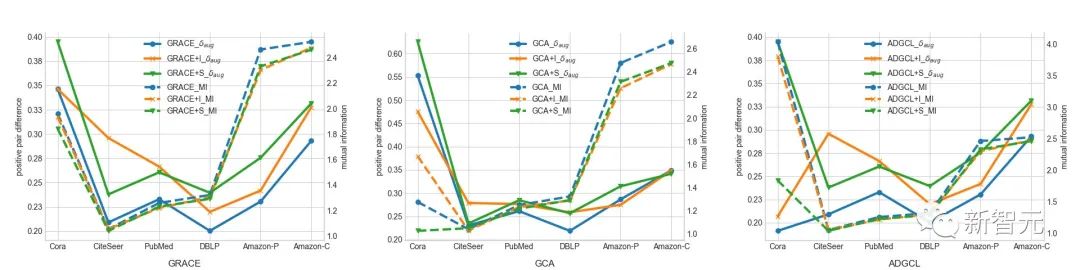

实验利用三种基础的图对比学习方法GRACE、GCA以及AD GCL进行实验,GRACE+I代表GRACE与提出的信息论方法耦合,GRACE+S代表GRACE与提出的谱增强方法耦合。可以看到两种优化方法在3种不同的对比学习方法以及6个数据集上都取得了性能提升。 由上图可见,两者优化方法在提升了的同时保留了互信息,因此得到了更优的下游任务表现。参考资料:https://arxiv.org/abs/2310.03977v1

由上图可见,两者优化方法在提升了的同时保留了互信息,因此得到了更优的下游任务表现。参考资料:https://arxiv.org/abs/2310.03977v1

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง