最近一周,陷入“抄袭”风波的李开复,心情如同过山车。

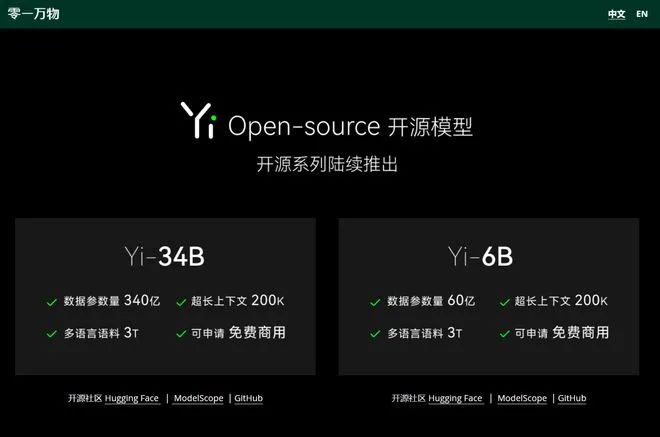

最近一周,陷入“抄袭”风波的李开复,心情如同过山车。11月6日,李开复创办的AI公司零一万物,正式发布了首款开源中英双语大模型“Yi”。

该模型包含 Yi-6B 和 Yi-34B 两个版本,其Yi-34B 版本是当时唯一成功登顶 Hugging Face 全球开源模型排行榜的国产模型,称“全球最强开源模型”,因此吸引了全球多位研究者的关注。

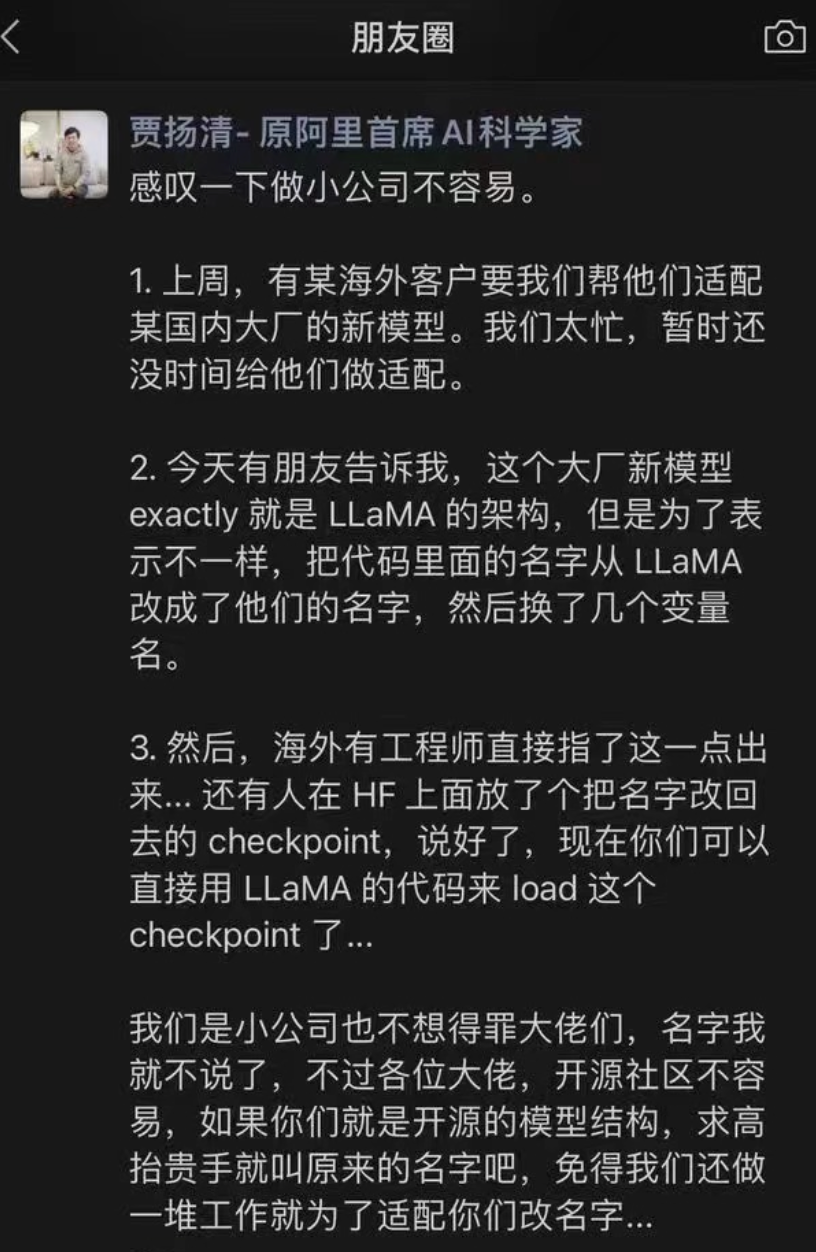

本是好评如潮,然而,一周后,阿里前AI科学家贾扬清指称,某国产大模型实际上是抄袭的LLaMA,只是更换了几个变量名而已。

虽未点名,但这个节骨眼上,还是有不少业内人士将其与零一万物联系在一起。

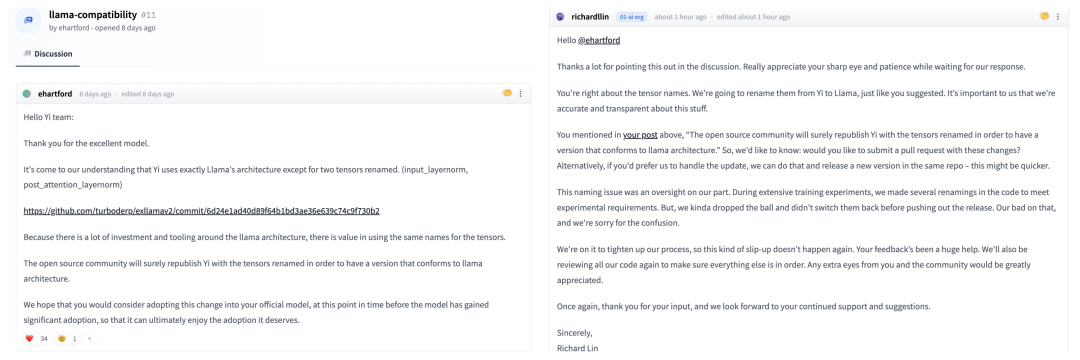

此前,Hugging Face 开发者 ehartford 公开表明,零一万物开源大模型使用了 Meta 的 LLaMA 架构,只对两个张量名称(input_layernorm,post_attention_layernorm)进行修改,但其开源许可证也没有提及LlaMa。

一石激起千层浪,事情不断发酵,15日,零一万物作出了回复:

回应原文中的“沿用了GPT/LLaMA的基本架构”,表明零一万物直接承认确实用了LLaMA的结构。

11月14日,其团队开源总监 Richard Lin 在Hugging Face社区原贴之下也指出“命名问题是团队的疏忽,在大量训练实验中,我们对代码进行了多次重命名以满足实验要求。“

LLaMa是meta发布的一个免费开源的大模型,LLaMa的许可协议里提到,开发者有义务提供一个“Notice”文本文件,保留LLaMa的版权归属。

用LLaMa一样的架构其实并不新鲜,此前百川智能的开源模型Baichuan-7B就是如此。

只是大家介意的是零一万物用的是LLaMa的结构,但没有保留原创,而是拿着两个变量的模型,宣称是自己的自研。

简单来说,大众认为,你署名就是借鉴,不署名可能就是抄袭了。

对此,ehartford 也补充道,他只是提醒 Yi 团队调整张量名称来匹配相关资源,直接套用 LLaMA 架构没有任何问题,训练才是重点。

估计ehartford本人也没想到,会引起这么大的风波。

而作为零一万物的创始人,李开复也反复被人提及。

1961年,李开复出生于中国台湾新北市,就读于卡内基梅隆大学,获计算机学博士学位,后担任副教授,曾先后担任微软全球副总裁、谷歌全球副总裁兼大中华区总裁。

2009年,48岁的李开复从谷歌离职,回国创办了创新工场,投资孵化了多家中国互联网巨头,如美团和支付宝等。

到2018年,已经成功培育出了10家独角兽公司,其中5家专注于人工智能领域。

李开复在人工智能领域积累了40年的科研和产业经验,一度被称为“中国AI教父”。

今年3月,李开复再度创业,牵头筹组成立AI2.0公司——零一万物。

公司的联创团队成员包含前阿里巴巴副总裁、前百度副总裁、前滴滴/百度首席算法负责人、前谷歌中国高管、前微软/SAP/Cisco/副总裁,算法和产品团队背景均来自国内外大厂。

四个月后,零一万物便在11月份推出了“Yi”系列大模型产品,并凭借Yi-34B一炮而红。

在Hugging Face 英文测试榜单中,以 70.72 分数位列全球第一。

在线上发布环节,李开复重点介绍了 Yi 系列大模型的三大性能亮点:

-

全球最长 200K 上下文窗口,免费开源,可商用

-

超强 Al Infra 实测训练,成本下降40%

-

科学训模自研「规模化训练实验平台」

Yi-34B将发布可支持200K上下文窗口(context window)版本,可以处理约40万汉字超长文本输入。相比之下,OpenAI的GPT-4上下文窗口只有32K,文字处理量约2.5万字。

你说“Yi”模型是抄袭吗?

未必。

据智药局了解,大模型选择相同的架构也可以做出完全不同的模型,用不同数据集训练出来的模型也会有所差别。

也就是说,即使壳子一样,但内芯还是有区别的。

在“抄袭”风波中,零一万物也回应到:“模型结构仅是模型训练其中一部分。Yi 开源模型在其他方面的精力,比如数据工程、训练方法、baby sitting(训练过程监测)的技巧、hyperparameter 设置、评估方法以及对评估指标的本质理解深度、对模型泛化能力的原理的研究深度、行业顶尖的 AI Infra 能力等,投入了大量研发和打底工作。”

此前,为了解决超长上下文这一重要技术限制,零一万物实施了一系列优化,包括:计算通信重叠、序列并行、通信压缩等。通过这些能力增强,实现了在大规模模型训练中近 100 倍的能力提升。

在训练数据上,李开复直言零一万物团队通过正规渠道购买和爬取的方式,获得了 100T 的中英文数据,并选取了其中 3T 的优质内容进行训练。

抄袭可大可小,不仅是李开复个人和零一万物一生的污点,更是对中国AI大模型创新环境的一种打击。

对事不对人,不管此次“无声”套用 LLaMa 架构,是没注意还是疏忽,零一万物都应该改进署名,但说抄袭还不至于,毕竟不能对团队背后的努力视而不见。

不仅是科技领域,在任何一个领域,诚信与透明度同等重要,保留原创是体面也是尊重,毕竟谁也不是傻子不是?

—The End—

推荐阅读

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง