近来,来自耶鲁和交大的研究者借鉴并受医院专家会诊模式的启发,提出了一个名为多学科协作 (Multi-disciplinary Collaboration, MC) 的临床领域框架,目标是以无需训练、具有可解释性的方式来揭示医学智能模型的内在临床知识并提升其推理能力。

研究背景

随着LLM在通用领域的显著进步,LLMs向医疗领域的应用越来越受关注。目前,LLMs在医疗相关任务中主要面临两大挑战:(i) 与预训练 LLM 的通用网络数据相比,医疗领域的训练数据量和专属性(volume and specificity)有限;(ii) 该领域的高性能需要广泛的领域知识和复杂的推理能力。一方面,尽管 LLMs 中的通用领域知识或多或少地渗透到了不同的具体领域,但对于模型来说,通过简单直接的提示来理解或调用所需的医学专业知识仍然是不够的[1][2]。另一方面,由于医学知识中存在大量复杂的术语,LLMs 在尝试浏览这些知识并对其进行推理时会面临更高的要求,从而可能导致其推理过程中出现错误。

本篇论文提出了MedAgents,一个名为多学科协作 (Multi-disciplinary Collaboration, MC) 的临床领域框架,旨在以一种无需训练和可解释的方式,揭示 LLMs 的内在临床知识并增强其推理能力。

方法

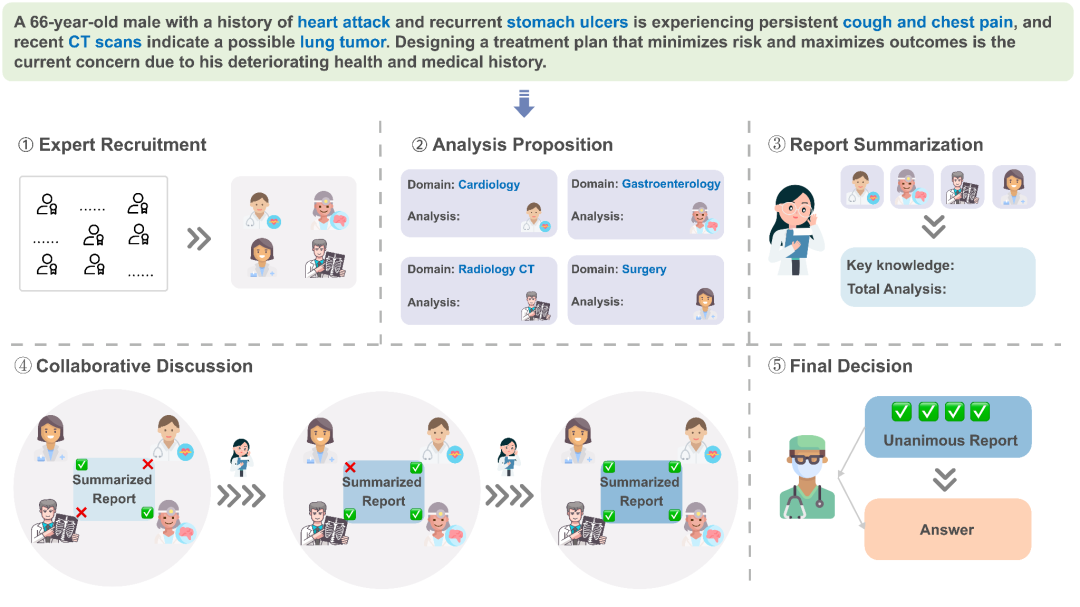

多学科协作 (MC) 框架基于五个关键步骤:

-

专家收集:

根据临床问题召集来自不同学科的专家;

-

分析提议:

每位专家利用其特定的学科知识提出分析建议;

-

报告总结:

基于先前的分析系列,编写总结报告;

-

协作会诊:

让专家对总结报告进行讨论。

报告将通过多次迭代修订,最终获得所有专家达成一致的共识;

-

决策制定:

根据报告作出最终决定,反映所有专家的一致意见。

图1:多学科协作框架图。

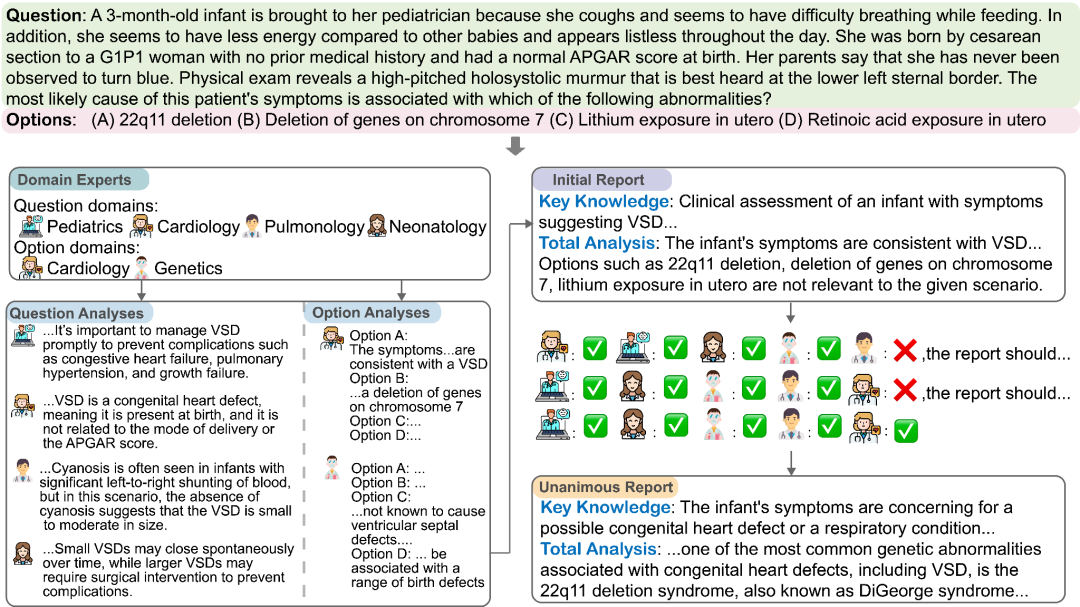

图2:多学科协作(MC)框架应用于儿科医学问题的示例。首先提出问题和选项,召集领域专家。受聘专家根据各自的领域对问题和方案进行全面分析。随后,编写一份综合这些分析的初步报告,作为所做评估的简明表述。在此之后,具有各自学科背景的专家们就初步报告展开讨论,表达意见的一致性和分歧。最终,经过迭代完善和协商,形成一份最能代表专家集体知识和推理的一致报告。

实验结果

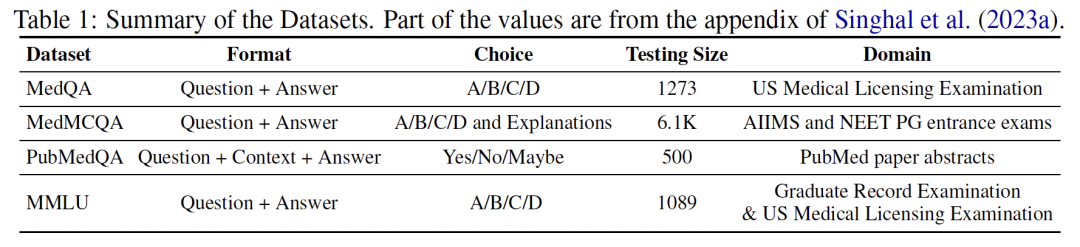

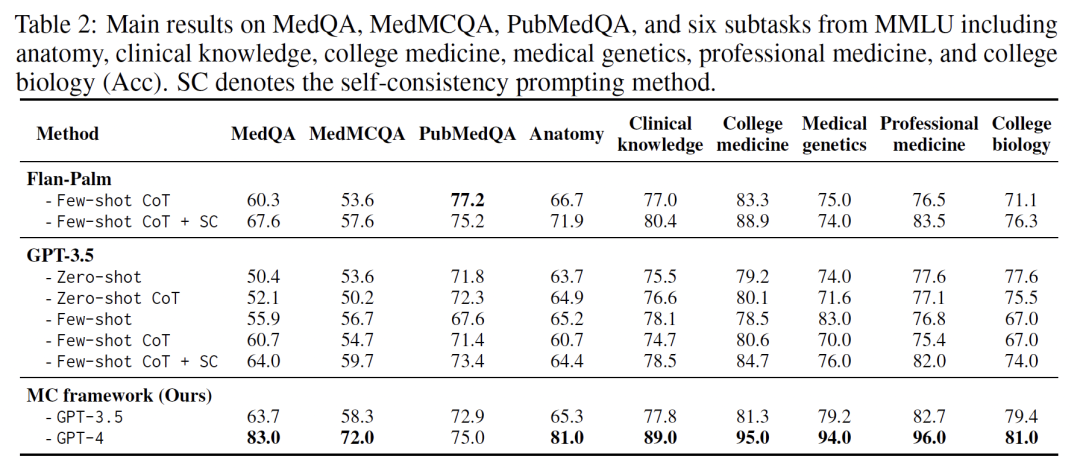

借助这种方法的理论基础,在包括MedQA[3]、MedMCQA[4]、 PubMedQA[5]以及MMLU[6]医学主题等几个数据集上进行实验。结果显示,这篇工作的方法在所有任务中的表现都优于其他的模型,特别是在没有预先训练(零样本设定)的场景下甚至优于先行基线模型在有预先训练的场景下的表现(5样本设定)。

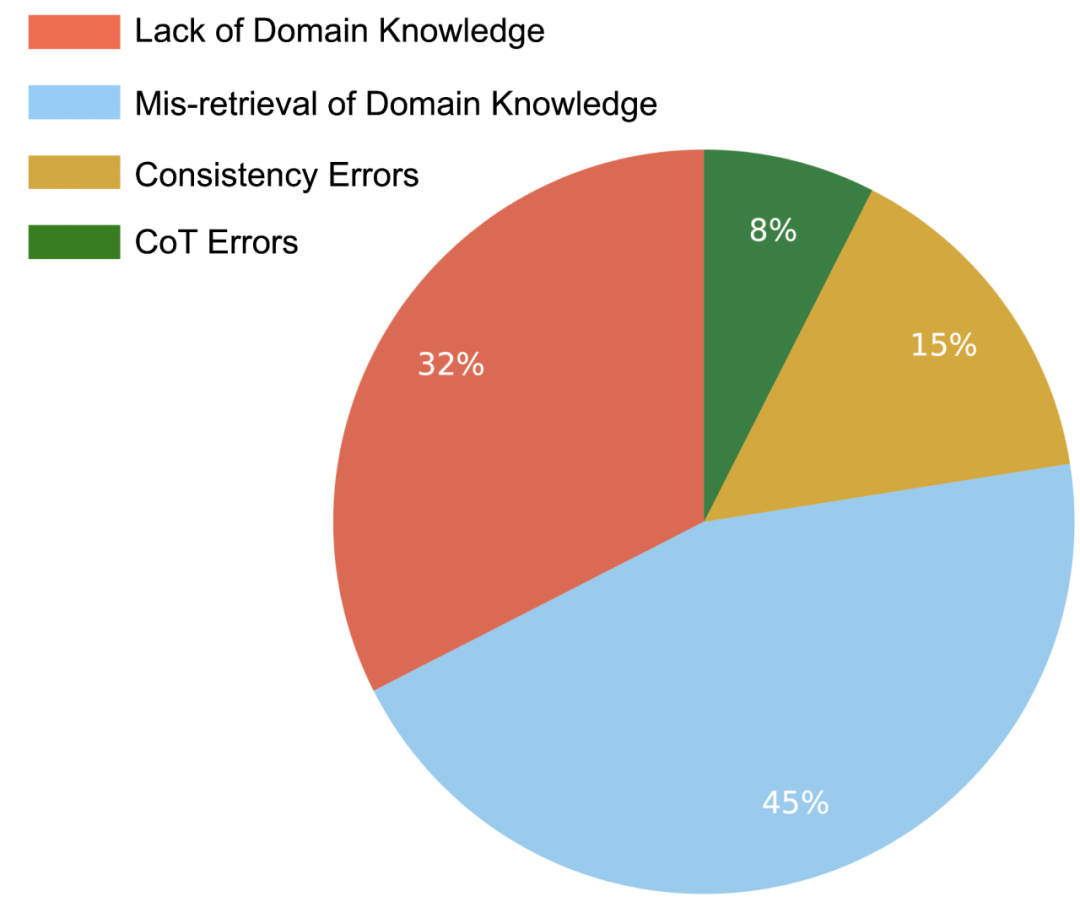

此外,文章还通过人类评估指出了方法的局限性和存在的问题,发现存在四种常见的错误类型:(i)缺乏领域知识;(ii) 领域知识检索错误;(iii) 一致性错误;以及 (iv) 思维链错误。深入研究和改善这些问题将有助于提升模型的精准度和可靠性。

总结

这篇工作有三个主要贡献:

-

(i) 提出了一个在医学领域问答任务上的多学科协作框架。

这种新的方法致力于揭示存在于LLMs中的内在临床专业知识,并增强他们的推理能力。

-

(ii) 在九个数据集上展示了实验结果。

结果表明,MC框架具有广泛的有效性,并展示了我们所提出的MC框架在挖掘和利用LLMs中的医学专业知识上的优势。

-

(iii) 通过严格的人类评估,识别并分类了我们方法中的常见错误类型,为未来的研究提供了启示。

通过以上介绍,该文作者期望这种集医疗专业知识繁多于一体的模型方法可以提升医疗诊疗准确度,为未来的AI医疗应用发展开启新篇章。

代码

https://github.com/gersteinlab/MedAgents

参考资料

[1] Kung, Tiffany H., et al. “Performance of ChatGPT on USMLE: Potential for AI-assisted medical education using large language models.” PLoS digital health 2.2 (2023): e0000198.

[2] Singhal, K., Azizi, S., Tu, T., Mahdavi, S. S., Wei, J., Chung, H. W., … & Natarajan, V. (2023). Large language models encode clinical knowledge. Nature, 620(7972), 172-180.

[3] Jin, Di, et al. “What disease does this patient have? a large-scale open domain question answering dataset from medical exams.” Applied Sciences 11.14 (2021): 6421.

[4] Pal, Ankit, Logesh Kumar Umapathi, and Malaikannan Sankarasubbu. “Medmcqa: A large-scale multi-subject multi-choice dataset for medical domain question answering.” Conference on Health, Inference, and Learning. PMLR, 2022.

[5] Jin, Qiao, et al. “Pubmedqa: A dataset for biomedical research question answering.” arXiv preprint arXiv:1909.06146 (2019).

[6] Hendrycks, Dan, et al. “Measuring massive multitask language understanding.” arXiv preprint arXiv:2009.03300 (2020).

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง