- 大模型是训练强化学习代理的好老师

- 综述:多模态大型语言模型

- 可视化上下文提示

- Soulstyler:使用大型语言模型引导目标对象的图像风格转移

- 清华领衔新研究:无需任何奖励模型,利用人类反馈微调扩散模型

- AlignCoT:用“本地”风格,提示大型语言模型

- Diffusion-DPO:基于人类偏好对齐扩散模型

- LEO:3D世界中的具身通用代理

01

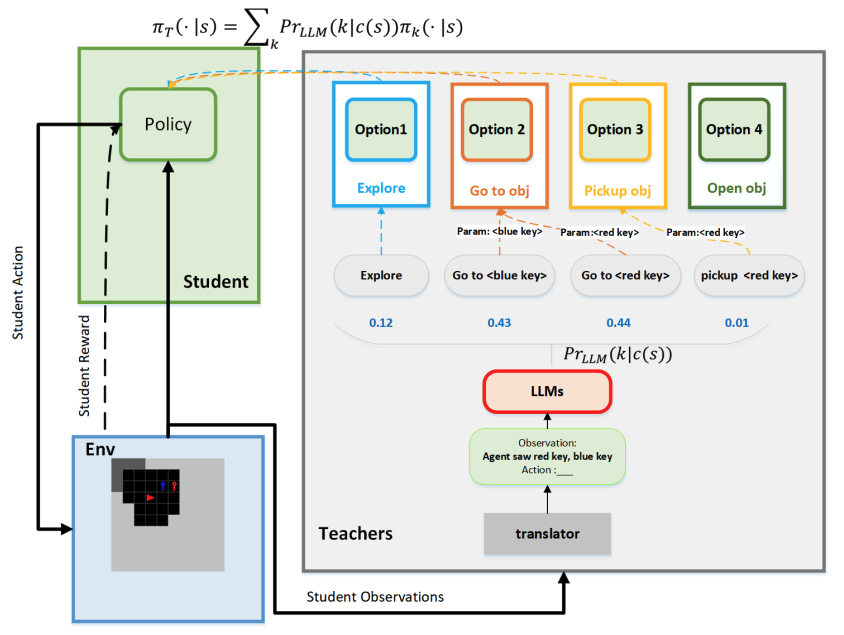

大模型是训练强化学习代理的好老师

近期研究显示,大型语言模型(LLMs)可以通过给出高阶指令,帮助解决复杂的序列决策任务。但是,这些基于 LLMs 的代理在真实的动态环境中面临挑战,因为它们缺乏解决特定问题的专业能力。此外,在实际应用中部署这类代理既昂贵又耗时。该研究提出了一种创新框架,利用来自基于 LLMs 的教师代理的指令,训练了一个小型专业的学生代理,以应对这些挑战。通过采用教师代理的指导性行为,将 LLMs 的先验知识转移到本地学生模型中。这使得学生代理能够用更少的数据进行有效训练。更重要的是,结合环境反馈的后续训练,学生代理的性能超越了教师代理。研究团队在三个复杂的 MiniGrid 环境中进行了实验,以验证这一框架的有效性。实验结果显示,该方法在提高样本效率方面取得了显著成效,且性能上超过了其他基准方法。

论文:

Large Language Model is a Good Policy Teacher for Training Reinforcement Learning Agents

02

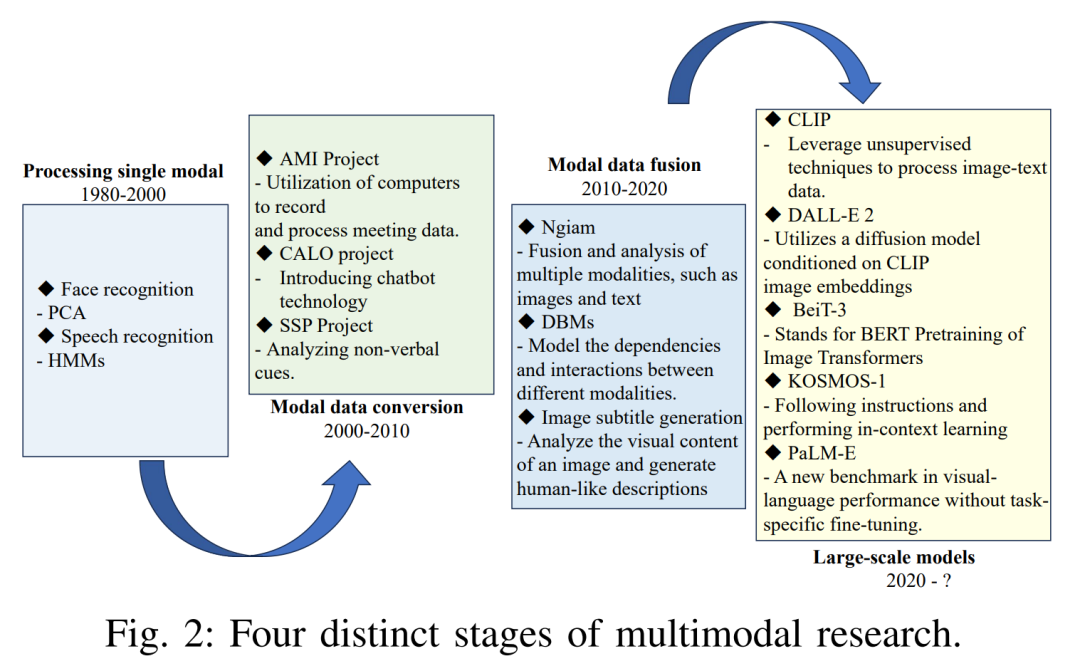

综述:多模态大型语言模型

虽然最新的大型语言模型(LLMs)在基于文本的任务中表现出色,但在理解和处理图像、语言、音频等其他数据类型时却往往力不从心。多模态模型通过结合各种模态来解决这一局限,从而能够更全面地理解各种数据。该研究首先定义了多模态的概念,并考察了多模态算法的历史发展。此外还介绍了一系列多模态产品,重点关注主要技术公司所做的努力。该研究还提供了一份实用指南,深入介绍了多模态模型的技术方面。此外还总结了最新算法和常用数据集,为研究人员提供了宝贵的实验和评估资源。最后,该研究探讨了多模态模型的应用,并讨论了与其开发相关的挑战。通过探讨这些方面,该研究旨在促进人们更深入地了解多模态模型及其在各个领域的潜力。

论文:

Multimodal Large Language Models: A Survey

03

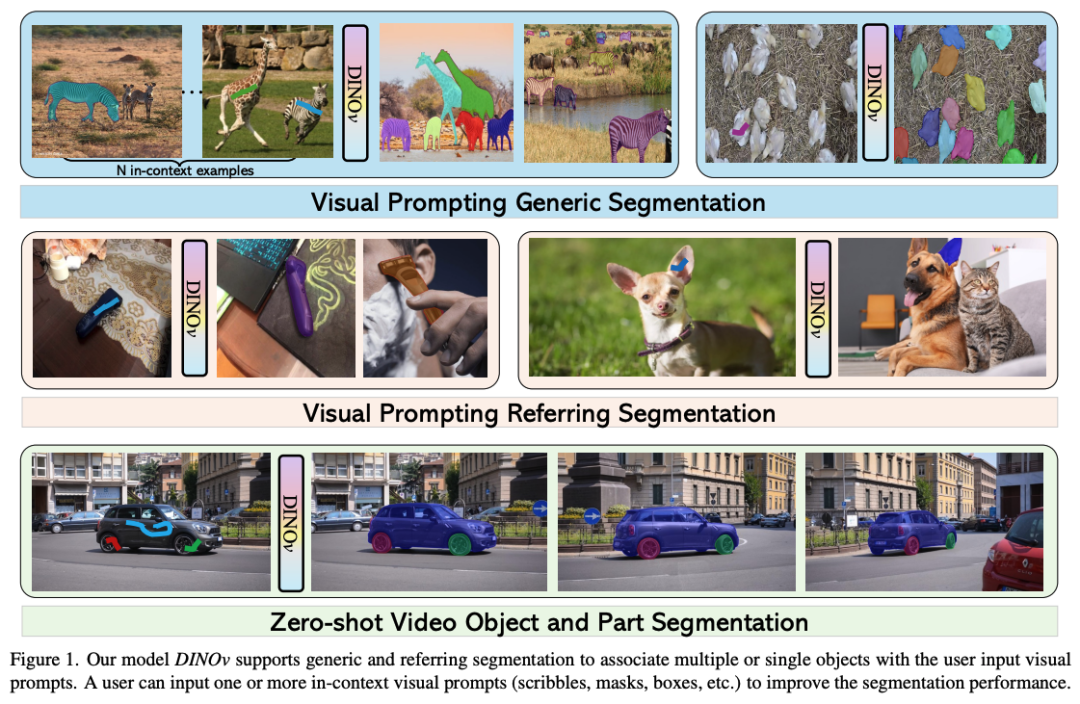

可视化上下文提示

大型语言模型(LLMs)中的上下文提示已成为提高零样本(zero-shot)能力的普遍方法,但在视觉领域,这种方法的应用还不够广泛。现有的视觉提示技术主要集中在通过分割技术识别最相关的物体,但这对于很多普遍的视觉任务(如开放式分割和物体检测)仍显不足。该研究提出了一个既适用于分割也适用于检测的通用视觉上下文提示框架。特别是,研究团队在编码器-解码器架构的基础上,开发了一个多功能提示编码器,来支持笔画、方框和点等各种提示,该研究还进一步改进了这个框架,使其能够使用任意数量的参考图像片段作为上下文。通过在 COCO 和 SA-1B 数据集上联合训练,搞研究提出的模型在 COCO 数据集上达到了 57.7 PQ,在 ADE20K 数据集上达到了 23.2 PQ。

论文:

Visual In-Context Prompting

04

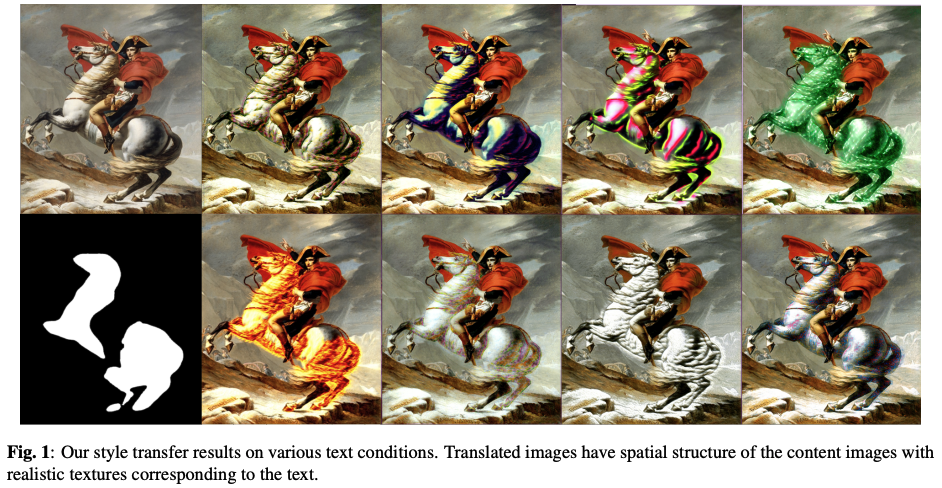

Soulstyler:

使用大型语言模型

引导目标对象的图像风格转移

图像风格转换在计算机制图和计算机视觉领域都占有重要地位。然而,目前的大多数方法都需要参考风格化图像,无法单独对特定对象进行风格化。为了克服这一局限,该研究提出了“Soulstyler”框架,允许用户通过简单的文字描述来指导图像中特定对象的风格化。该研究引入了一个大型语言模型(LLMs)来解析文本,并识别风格化目标和特定风格。结合基于 CLIP 的语义视觉嵌入编码器,该模型可以理解并匹配文本和图像内容。该研究还引入了一种新颖的本地化文本-图像块匹配损失,确保只在指定的目标对象上进行风格转移,而非目标区域则保持原有风格。实验结果表明,研究提出的模型能够根据文本描述准确地对目标对象进行风格转换,而不会影响背景区域的风格。

论文:

Soulstyler: Using Large Language Model to Guide Image Style Transfer for Target Object

05

清华领衔新研究:

无需任何奖励模型,

利用人类反馈微调扩散模型

训练一个高效的奖励模型需要大量数据集、最佳架构和手动超参数调整,既耗时又耗费成本。尽管直接偏好优化(DPO)方法在微调大型语言模型方面非常有效,它消除了奖励模型的必要性。然而,扩散模型的去噪过程需要大量 GPU 内存,这阻碍了 DPO 方法的直接应用。

为了解决这个问题,该研究引入了直接偏好去噪扩散策略优化(Direct Preference for Denoising Diffusion Policy Optimization,D3PO)方法来直接微调扩散模型。理论分析表明,虽然 D3PO 省略了奖励模型的训练,但它能有效地发挥利用人类反馈数据训练的最佳奖励模型的作用,从而指导学习过程。这种方法无需对奖励模型进行训练,因此更直接、更经济、计算开销最小。

在实验中,该研究方法使用目标的相对规模作为人类偏好的代表,结果与真实奖励(ground-truth rewards)的方法相当。此外,D3PO 还展示了降低图像失真率和生成更安全图像的能力,克服了缺乏鲁棒奖励模型的挑战。

论文:

Using Human Feedback to Fine-tune Diffusion Models without Any Reward Model

06

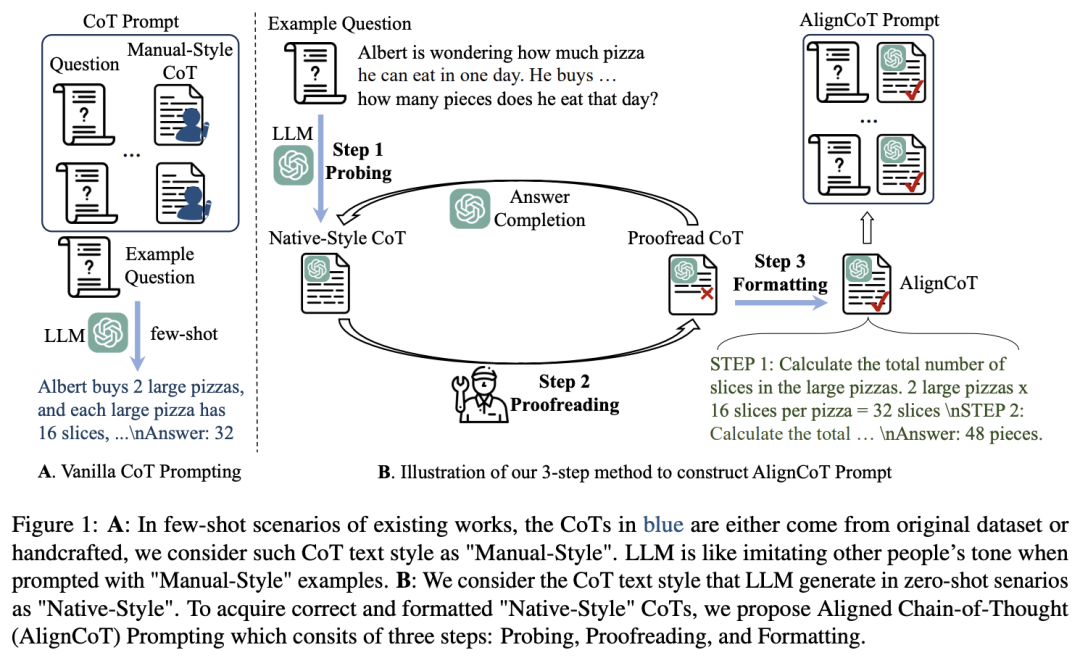

AlignCoT:

用“本地”风格,提示大型语言模型

已有研究发现,提示工程严重影响大型语言模型(LLMs)的性能。作为一种流行的提示工程技术,思维链(CoT)使用带有推理步骤的上下文示例来提示 LLMs 。在目前的研究中,CoT 的少量示例通常由人工制作。然而,上下文示例的文本风格如何影响 LLMs 的输出仍未得到充分探讨。

该研究提出了一种新颖有效的方法——AlignCoT,通过将上下文示例与 LLMs 的本地风格对齐来提高 LLMs 的推理能力。“原生(Native)”指的是 LLMs 的固有特征风格,可以通过原始的零样本场景进行探测。AlignCoT 与其他提示工程方法是正交的,因此很容易与最先进的技术相结合,从而进一步提高 LLMs 的性能。该研究在多个基准上进行了广泛而全面的实验。实证结果表明,与人类制作的上下文示例相比,该研究的 AlignCoT 显著提高了性能。例如,通过 GPT-3.5-turbo ,该研究观察到 GSM8K 的性能提高了 +2.5% 。此外,当 AlignCoT 与其他最先进的提示工程方法结合使用时,其性能也得到了持续改善。

论文:

Speak Like a Native: Prompting Large Language Models in a Native Style

07

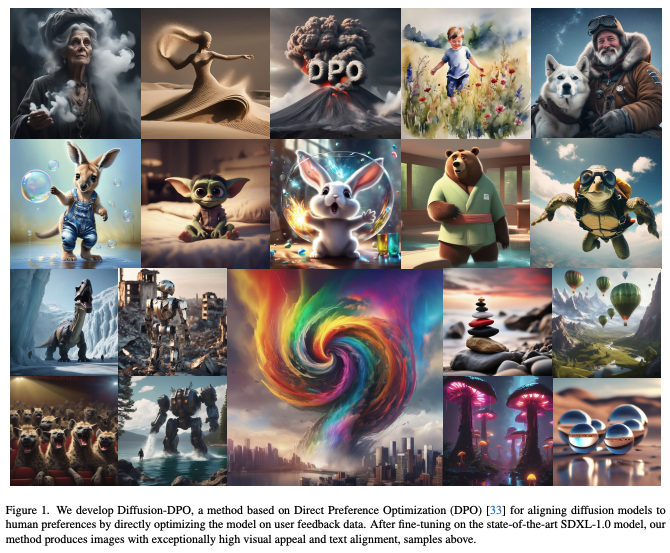

Diffusion-DPO:

基于人类偏好对齐扩散模型

大型语言模型(LLMs)是通过人类反馈强化学习(RLHF)方法,利用人类对比数据进行微调,使其更符合用户的偏好。该研究提出了 Diffusion-DPO ,这是一种通过直接优化人类对比数据来使扩散模型符合人类偏好的方法。Diffusion-DPO 改编自最近开发的直接偏好优化(DPO),它是 RLHF 的一种更简单的替代方法,可直接优化在分类目标下最能满足人类偏好的政策。该研究对 DPO 进行了重新表述,以考虑到扩散模型的可能性概念,并利用证据下限推导出可微分目标。利用由 851K 个众包配对偏好组成的 Pick-a-Pic 数据集,该研究使用 Diffusion-DPO 对最先进的稳定扩散 XL(SDXL)-1.0 模型的基础模型进行了微调。在人类评估中,该研究微调后的基础模型明显优于基础 SDXL-1.0 模型和包含额外细化模型的更大型 SDXL-1.0 模型,提高了视觉吸引力和及时对齐性。

论文:

Diffusion Model Alignment Using Direct Preference Optimization

08

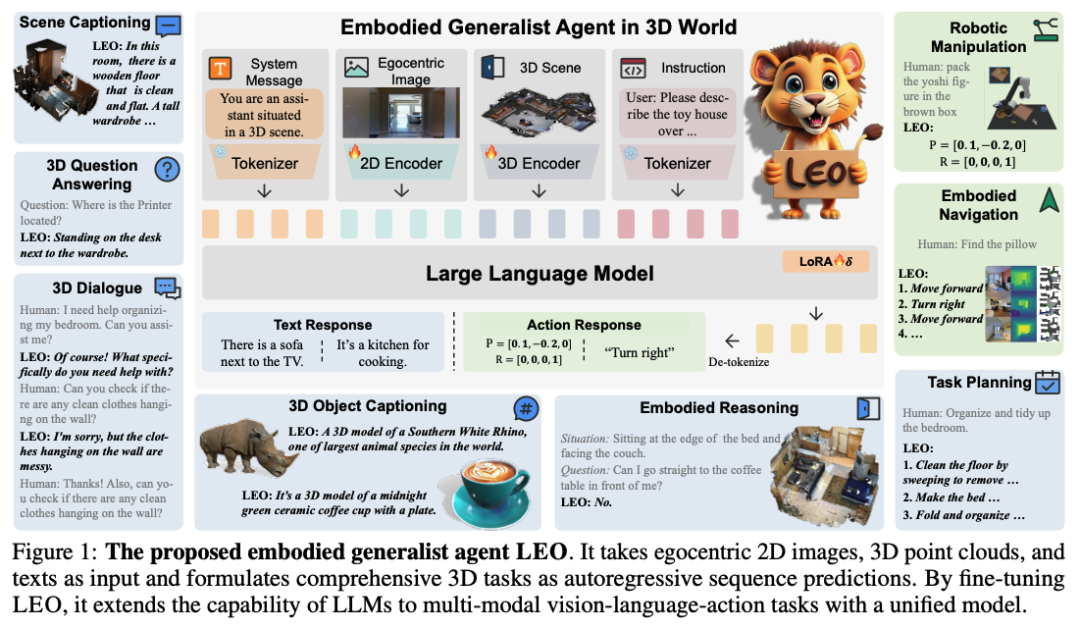

LEO:3D世界中的具身通用代理

尽管机器学习模型在构建通用代理方面取得了显著的进步,但由于这些模型在理解 3D 世界并与之互动方面的能力有限,极大地阻碍了当前模型执行真实世界任务和进一步实现通用智能。

为此,该研究引入了一种在 3D 世界中擅长感知、定位、推理、规划和行动的多模态多任务通用代理。该研究提出的代理被称为“LEO”,它采用基于大型语言模型(LLMs)的共享模型架构、目标和权重,分两个阶段进行训练:3D 视觉-语言对齐、3D 视觉-语言-行动指令微调。为了促进训练,该研究精心策划并生成了一个广泛的数据集,其中包括对象级和场景级多模态任务,其规模和复杂程度都超过了要求,这就需要对 3D 世界有深入的了解并与之互动。通过严格的实验,该研究证明了 LEO 在 3D 字幕制作、问题解答、具身推理、具身导航和机器人操纵等广泛任务中的优秀能力。

论文:

An Embodied Generalist Agent in 3D World

|点击关注我 👇 记得标星|

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง