11月24日,Yi-34B-Chat/Yi-6B-Chat微调模型已经在 Hugging Face、ModelScope魔搭社区等平台正式发布上线。

同时,我们还为开发者提供了 4bit/8bit 量化版模型。Yi-34B-Chat 4bit 量化版模型可以直接在消费级显卡(如RTX3090)上使用。

模型地址

https://huggingface.co/01-ai/

https://www.modelscope.cn/organization/01ai

评测效果

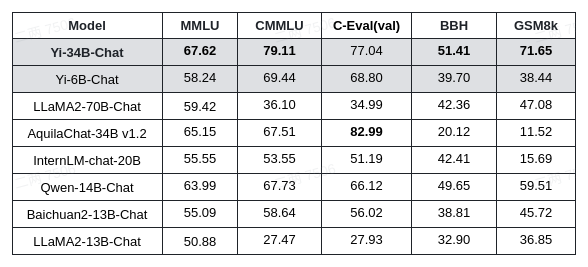

在 MMLU 英文知识水平评测集,C-Eval、CMMLU 中文综合考试评测集,以及 GSM8K、BBH 两个常用的评估大模型数学及推理能力的评测集中,Yi-34B-Chat 在开源模型中取得多项优异成绩(评测结果均采用 zero-shot 的方式,结果会受到 prompt 设计的影响,我们使用了相同的 prompt 和生成策略来评测表中所有模型以获得一个较为公正的结果,供大家参考)。

Yi-34B-Chat模型实力如何?我们先来实验几个问题演示:

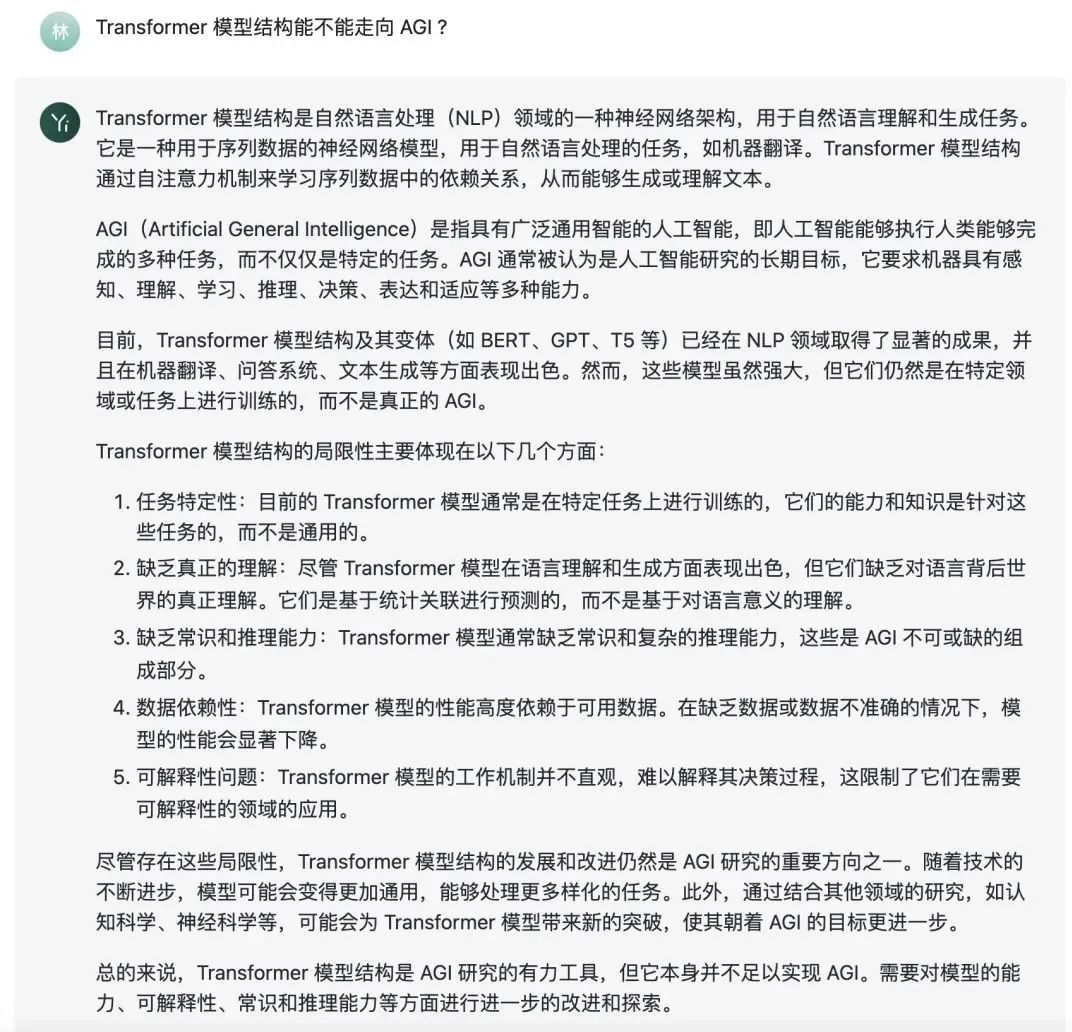

Q1:Transformer 模型结构能不能走向 AGI ?

Q2:给我生成一个小红书文案,给大家安利一只豆沙色的口红。

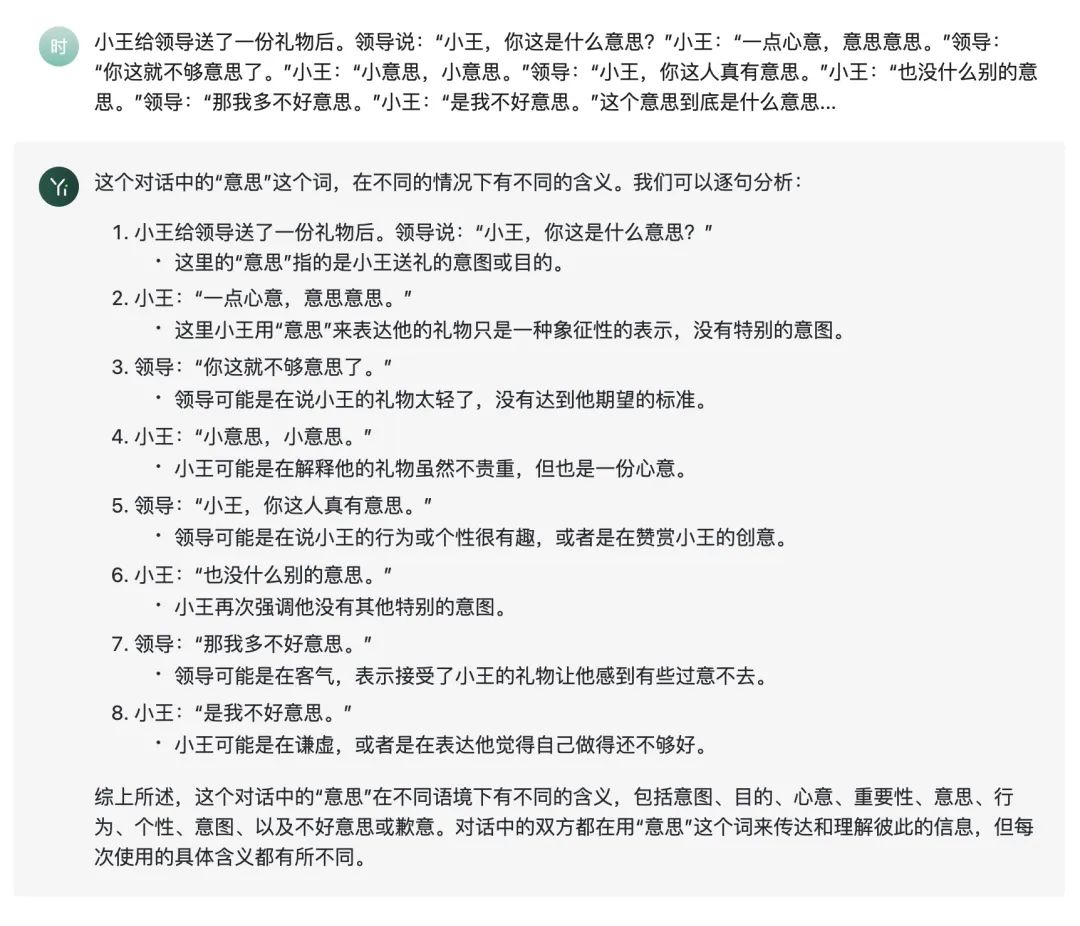

Q2:给我生成一个小红书文案,给大家安利一只豆沙色的口红。 Q3:小王给领导送了一份礼物后。领导说:“小王,你这是什么意思?”小王:“一点心意,意思意思。”领导:“你这就不够意思了。”小王:“小意思,小意思。”领导:“小王,你这人真有意思。”小王:“也没什么别的意思。”领导:“那我多不好意思。”小王:“是我不好意思。”这个意思到底是什么意思?

Q3:小王给领导送了一份礼物后。领导说:“小王,你这是什么意思?”小王:“一点心意,意思意思。”领导:“你这就不够意思了。”小王:“小意思,小意思。”领导:“小王,你这人真有意思。”小王:“也没什么别的意思。”领导:“那我多不好意思。”小王:“是我不好意思。”这个意思到底是什么意思?

除了 Yi 系列强基座的贡献以外,Yi-34B-Chat 模型的效果还得益于零一万物人工智能对齐(AI Alignment)团队采用了一系列创新对齐策略。通过精心设计的指令微调流程,不仅强化了模型在理解和适应人类需求方面的能力,还使得模型与人类价值观对齐,包括帮助性(Helpful),可靠性(Honest), 无害性(Harmless) 等。

指令微调经验总结

在强基座设定下,我们采用了一种轻量化指令微调方案,该方案涵盖了单项能力提升和多项能力融合两个阶段。其中,单项能力包括通用指令跟随、创意内容生成、数学、推理、编程、泛COT、对话交互等。通过大量的消融实验,针对模型单能力构建和多能力融合总结了以下认知和经验:

1.数据量:

· 在强基座模型上,特定单项能力的激发仅需要少量数据(几条到几百条)。

· 单项能力达到性能拐点后,相同类别数据的大幅增加仅带来较小的能力提升,且会影响其他单项能力。

· 少量SFT数据是大量精细化消融实验和数据质量优化的重要前提条件。

2.数据质量:

· 质量比数量重要,少量高质量数据比大量低质量数据更好。

· 需重点关注超出模型能力的“低质量”数据,避免加剧幻觉。

3.指令多样性与难度:

· 通过在各能力项下构建任务体系,来均衡训练数据中的指令分布,从而提升模型泛化性。

· 复合指令构造和指令难度进化对提升效果和降低数据量的作用明显。

4.风格一致性:

· 统一回复风格很重要,比如在轻量SFT情况下,需避免风格不一致加剧模型的“记忆”现象。

· 训练数据的风格会影响模型收敛速度和能力上限的逼近程度,比如CoT的回复风格需重点设计。

5.多能力融合:

· 在多能力融合阶段,我们采用网格搜索的方法来决定数据配比和超参数的设置,并通过基准测试和自建评测集的结果来指导搜索过程。

关于数据的详细构建过程在零一万物将发布的自研大模型技术报告里会详细说明,请持续关注!

本文由 Hugging Face 中文社区内容共建项目提供,稿件由社区成员投稿,经授权发布于 Hugging Face 公众号。文章内容不代表官方立场,文中介绍的产品和服务等均不构成投资建议。了解更多请关注公众号:

如果你有与开源 AI、Hugging Face 相关的技术和实践分享内容,以及最新的开源 AI 项目发布,希望通过我们分享给更多 AI 从业者和开发者们,请通过下面的链接投稿与我们取得联系:

https://hf.link/tougao

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง