点击下方卡片,关注「集智书童」公众号

视觉Transformer(ViTs)通过多头自注意力(MHSA)建模长程依赖性,以提高视觉识别。MHSA通常表示为查询-键-值计算。然而,从查询和键生成的注意力图仅捕获单个粒度的Token对之间的相关性。

在本文中,作者提出了一种观点,即自注意力应该拥有更全面的机制来捕获Token(token)之间的相关性以及组(即多个相邻Token)之间的相关性,以提高表示能力。因此,作者提出了一种名为群组混合注意力(GMA)的先进替代传统自注意力机制,它可以同时捕获Token对之间的Token-Token、Token-组以及组-组相关性,支持各种组大小。

为了实现这一目标,GMA将Query、Key和Value均匀地分为段落,并执行不同的群组聚合以生成群代理。注意力图是基于Token和群代理的混合计算得到的,并用于在值中重新组合Token和群。基于GMA,作者引入了一种强大的骨干网络,名为群组混合(GroupMix)前馈,该网络在图像分类、目标检测和语义分割方面达到了最先进的性能,所需的参数比现有模型更少。以群组混合前馈(GroupMixFormer)-L(具有70.3M参数和384输入)为例,在ImageNet-1K上,该模型在没有外部数据的情况下,实现了86.2%的Top-1精度。同时,群组混合前馈-B(具有45.8M参数)在ADE20K数据集上,实现了51.2%的mIoU。

代码和预训练模型:https://github.com/AILab-CVC/GroupMixFormer

1 Introduction

视觉Transformer(ViTs)在包括图像分类、自监督学习、目标检测和语义分割等视觉识别任务上显著提高了性能。其中,一个对性能改进有显著贡献的关键模块是多头自注意力(MHSA),它使得网络设计能够利用长程依赖建模,全局感受野,更高的灵活性,以及更强的鲁棒性。

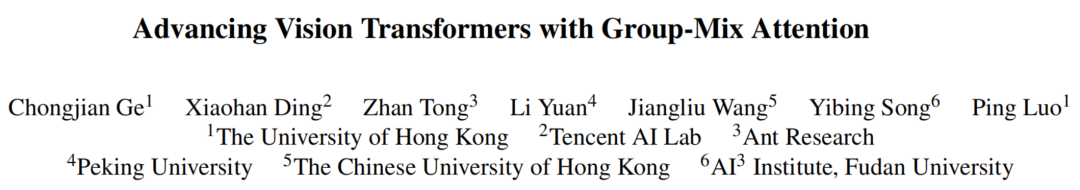

通常,“注意力”(即Q-K-V注意力)表示线性重新组合_Value_与_Query_和_Key_之间的相关性,这些相关性通常在单个Token(token)对之间计算得到。然而,实验发现Q-K-V自注意力存在一个主要局限性,如图1所示,注意力图仅描述了每个单个Token对之间的相关性(图1(a)),将注意力图与Value相乘,仅线性重新组合了单个Token。

显然,该框架没有考虑在不同粒度(即不同Token组)之间的不同Token组之间的相关性。例如,自注意力并不将顶部左角的9个Token作为一个整体来与底部右角的Token组相关联。尽管这个局限性显而易见,但由于Q-K-V计算似乎足够强大,可以建模从输入到输出的映射,因此这个局限性被无意忽视了。因为输出中的任何一项都似乎可以关注输入中的每个单独项。

在本研究中,作者提出了一种更全面的建模方法,称为_群组混合注意力(GMA),以减轻广泛使用的Q-K-V自注意力机制所存在的上述限制。GMA将Token(tokens)分为统一和不同的段落,并用群聚合器生成的群代理替换一些单个Token(tokens),如图1(b)所示。随后,作者使用替换后的Query和Key计算注意力图,并将其用于重新组合值中的群代理(group proxies)和单个Token(individual tokens)。

所提出的GMA具有以下一些有吸引力的优点:

-

GMA能够建模不仅单个Token之间的相关性,还能够建模一组Token之间的相关性。不同类型的注意力被混合以从全面的角度获得对Token的更好理解。Token对之间的Token-Token、Token-组和组-组相关性同时在每个单一层内进行建模,以获得更高的表示能力。

-

GMA具有高效性和易于实现的优点。

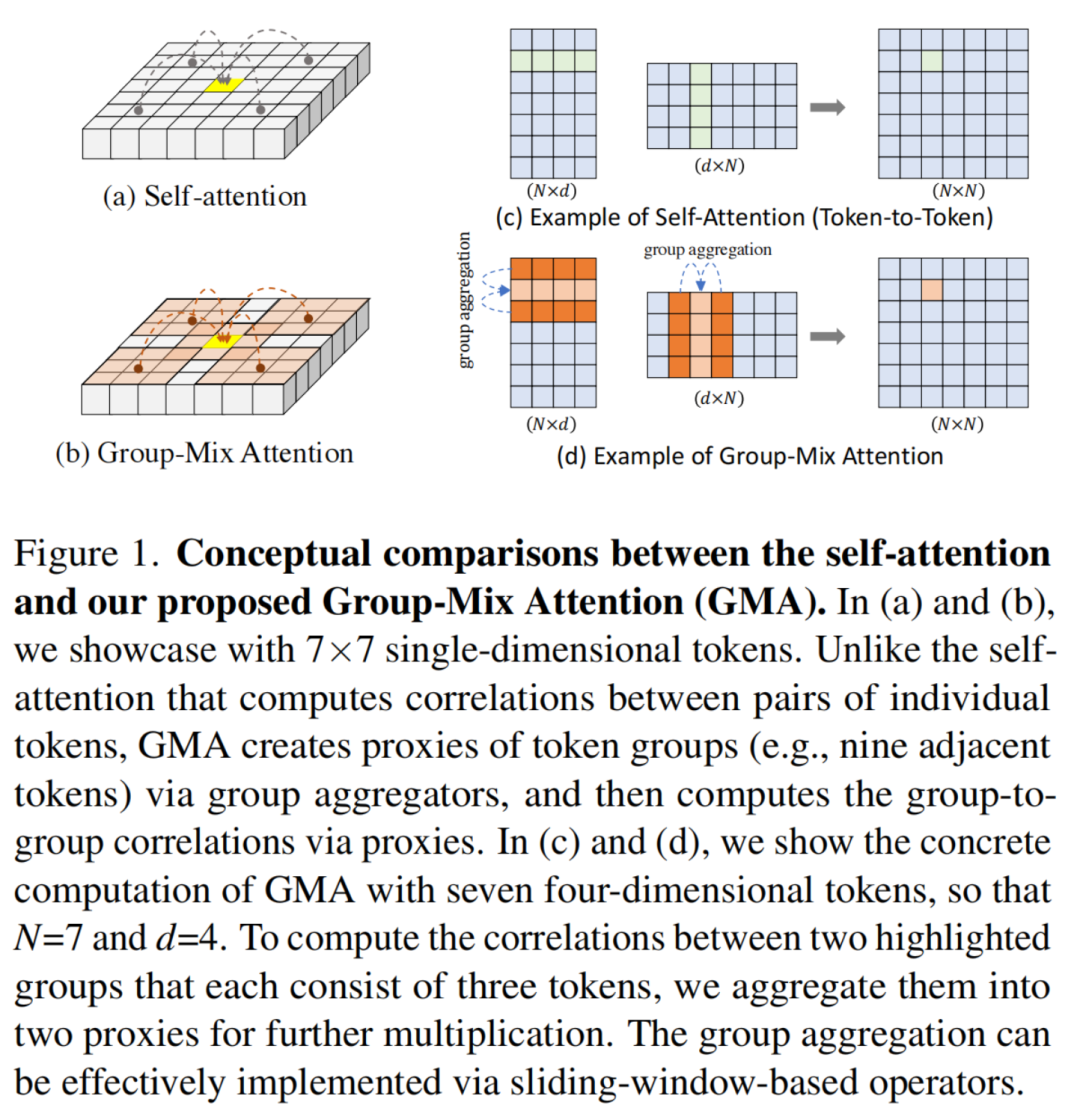

通过将群组(groups)聚合成代理Token(proxy tokens),然后计算代理Token之间的相关性来计算组-组相关性(group-to-group correlation),如图3所示。这种过程可以通过基于滑动窗口的操作(如池化和卷积)高效实现。在GMA的基础上,作者开发了一种分层视觉Transformer,称为GroupMixFormer,它可以作为各种视觉任务的视觉骨干。作者在标准视觉识别任务(包括图像分类、目标检测和语义分割)上评估GroupMixFormer,并将其与先进的模型进行了比较,如图2所示。

结果证明了作者的设计是有效的。例如,一个小型的GroupMixFormer实例(具有22.4M参数)在ImageNet-1K上实现了83.4%的Top-1精度,与更大的Swin-B(具有88M参数)相当。此外,GroupMixFormer在目标检测和语义分割方面也表现出与最先进的ViTs和CNNs相媲美的性能。在ADE20K数据集上,GroupMixFormer-B具有46M的骨干大小,实现了51.2%的mIoU。

大量的实验也表明,有效地建模Token(tokens)和不同群组(groups)之间的相关性对于GMA的成功至关重要。这种设计范式也可以轻易地应用于其他ViT架构,作为传统自注意力的高级替换方案。

2 Related Works

Vision Transformer

视觉Transformer(ViT)首次将Transformer引入计算机视觉领域。与基于卷积神经网络(CNN)的架构不同,ViT利用顺序连接的Transformer编码器在视觉Token序列上进行操作。所采用的多头自注意力(MHSA)机制在ViTs中有效地捕获了全局依赖性,使它们在有监督和自监督场景中优于卷积神经网络(CNN)。

为了提高ViTs的一般性能,进行了一系列研究,包括数据高效的训练,Token的重设计,金字塔结构,对自注意力机制的调制等。这些工作大多采用了原始的Q-K-V计算,该计算方式在处理视觉信息时被发现是有效的。在本工作中,作者通过引入群组混合注意力(GMA)来进一步改进ViTs的一般性能。

与先前的艺术不同,GMA能够在每个单一的Transformer编码器层内建模不仅单个Token之间的相关性,还能够建模一组Token之间的相关性,从而实现全面的表现能力。

Comprehensive Modeling of Self-Attention

在这项工作中,作者专注于由单个粒度的Token对相关性所引起的限制,并提出了一个先进的通知机制(即群组混合注意力(GMA)),该机制构建了一个更全面的自注意原型,作者的方法明显不同于以前的途径。

3 GroupMix Attention and GroupMixFormer

作者在3.1节介绍了高层次想法的动机,在3.2节详细阐述了结构设计,并在3.3节描述了架构配置。

Motivation: from Individual to Groups

作者从自注意力的原始定义出发,讨论了自注意力的局限性。令表示输入Token,其中是Token数量,是Token维度。自注意力的原始输出为:

请注意,作者为了简洁起见,忽略了归一化因子。直观上,由矩阵乘法的定义,计算每个Token对之间的相似/相关性。softmax函数的输出被称为注意力图。乘法AX表示根据每个位置的注意力图线性重新组合Token。作者注意到这种形式的局限性。可能存在某些模式(即组模式)需要将某些特定Token视为具有不同粒度的组。

然而,自注意力缺乏显式机制来建模这种模式,因为它只考虑了单个粒度(即单个模式)的Token对之间的相关性。在本论文中,作者寻求利用个体模式和组模式进行全面的建模。与先前的方法不同,作者的方法在Transformer骨干的每个阶段(通常为四个阶段)的每个个体层内引入了一种新颖的方法,将这种建模过程进行编码。

对于组模式,作者试图将某些Token邻域与其他Token邻域相关联。本文提出通过在Query、Key和Value中生成_群代理(group proxies_)来实现这一目标,并使用代理进行Q-K-V计算,该方法在3.2节中描述。

GMA: Mixing Groups for Better Attention

作者介绍GMA来建模组模式。在GMA中,作者通过用某些Token替换Query、Key和Value中的某些元素来生成群代理(group proxies),这可以通过基于滑动窗口操作的聚合实现,例如最大池化、卷积等。

具体来说,Q/K/V的元素均匀地分为n个段,作者在某些段上进行聚合。在不损失一般性的情况下,作者用 ()表示一个段(X可能表示Q、K或V),并将聚合表示为。请注意,聚合器可能对于每个段都是不同的。为了进行注意力计算,作者将进行拼接,生成。这样,作者得到了群代理, , 。

随后,作者对群代理进行注意力计算,如在[1, 47, 61]中引入的计算方法,以生成输出。在聚合过程中,作者保持特征分辨率。因此,在保持空间分辨率不变的情况下,GMA为注意力计算带来更精细的特征,这超过了具有减小特征大小的方法。在本文中,作者使用具有不同核大小的深度卷积来实现聚合器,尽管作者发现其他实现方法也有效(如表6所示)。

由于注意力的输入现在是组代理,作者可以在同一时间关联K×K个Token(K表示聚合器的核大小,对于每个段可能不同),而不是单个Token,这比关联单个Token更充足和全面,用于建模相关性。虽然简单,但使用基于滑动窗口操作将组聚合为代理的想法是混合不同大小组和各种粒度单个Token的关键,因为作者为每个段使用不同的聚合器核大小。这样的过程可以通过将段落分割,将它们传递给使用不同核大小的聚合器,并将输出拼接在一起来实现高效实现。

此外,受到[17]的启发,作者也可以在某个段上采用一个不变映射而不是聚合器来保持网络在模拟单个Token相关性的能力。因此,在计算注意力图时,作者可以同时建模组和Token之间的相关性。将注意力图与Value相乘可以看作相应地重新组合相应的组和单个Token。

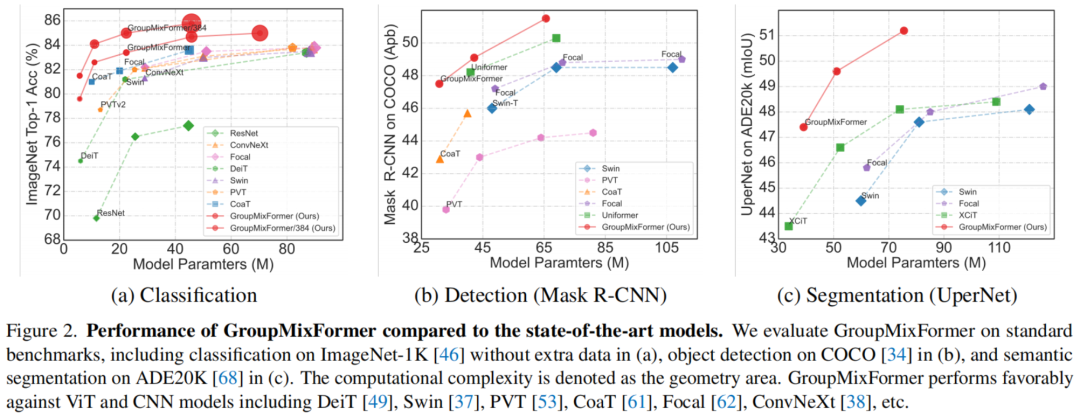

具体来说,作者遵循自注意力的实现,也使用三个可学习的线性投影来生成Q、K和V。然后,作者将Q/K/V均匀地分为五个段,每个段参与不同的计算。

如图3(左部分)所示,一个分支对应于上述段落,将四个输出作为预注意力分支输入到注意力计算中。在三个预注意力分支中,作者使用各种实现(例如,最小池化,平均池化,最大池化,深度卷积)作为聚合器,具有不同的核大小,分别为3、5、7。

表6中的结果表明,这些实现都取得了良好的性能,说明聚合是注意力进步的关键步骤,而其实施可以是灵活的。在作者的论文中,作者采用了深度卷积,其结果略好一些。作者进一步多样化结构,在最后一个预注意力分支中不使用聚合器,使其成为一个恒等映射。除了这样一个具有注意力的但没有聚合器的分支外,作者还构建了一个具有聚合器但没有注意力的分支,称为非注意力分支。

最后,输出通过Token集合层进行混合,该层简单地由一个线性投影(带有归一化)和激活函数实现。

Architectural Configurations

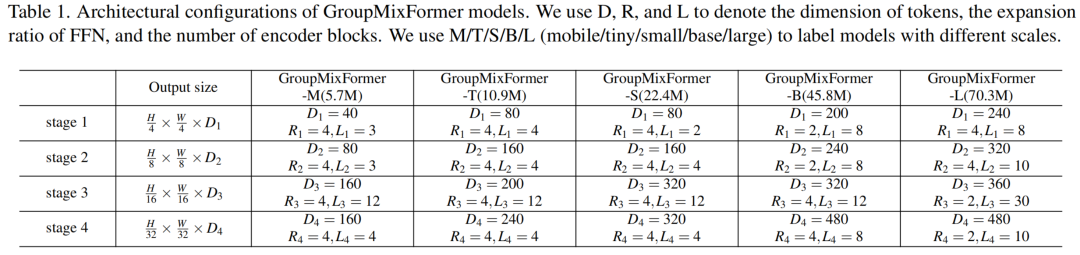

在提出群组混合注意力(Group-Mix Attention)的基础上,作者引入了一系列名为GroupMixFormer的视觉Transformer,如图3所示。作者采用分层拓扑(具有4个阶段)。第一个4 patch嵌入层将图像嵌入到Token中,实现方式是两个连续的33卷积层,每个层步长为2,另外还有两个33层,步长为1。

在每个最后一个阶段的开始,作者使用一个2 patch嵌入,它也由一个33卷积实现。在每个阶段内,作者构建几个编码器块。除了在最后一个子节中引入的GMA块外,编码器块还包含一个前馈网络(FFN)、Layer Normalization和identity短路,这与[18, 37, 49, 53, 62]中的常见做法相符。

对于图像分类,在全局平均池化(GAP)之后将最终输出Token(tokens)输入到分类器中;对于密集预测任务(例如,目标检测和语义分割),任务特定的头可以利用由四个阶段生成的金字塔特征。作者在模型中不采用位置编码,因为作者已经通过GMA聚合器自然地破坏了排列不变性。

作者实例化了四个具有不同架构配置的模型。架构超参数包括每个阶段的编码器块数量、嵌入维度和MLP比例,如表1所示。遵循先前的作品[37, 49, 53],作者的模型从移动规模的GroupMixFormer-M(5.7 M)扩展到大规模的GroupMixFormer-L(70.3 M)。

4 Experiments

在本节中,作者在包括ImageNet-1K[46],MS-COCO[34]和ADE20k[68]的标准视觉识别基准测试中评估作者的GroupMixFormer。作者为每个场景呈现了实现细节,与最先进的视觉骨干进行了定量比较,并进行了随后的消融研究。

Implementation Details

作者在ImageNet-1K数据集上评估GroupMixFormer的图像分类性能。作者遵循[49, 64, 65]来增强数据,并使用[37]中的训练配方。使用初始学习率,在20个epoch的线性热身之后,使用10-3学习率训练GroupMixFormer 300个epoch。AdamW优化器被使用,具有0.05的重量衰减和余弦学习率计划。随机深度下落率对于GroupMixFormer-M/T/S/B/L分别设置为0.0,0.1,0.2,0.4和0.5。对于更高的分辨率(例如,或),作者在初始学习率为且线性热身为5个epoch的条件下,再训练模型30个epoch。微调过程使用AdamW[39],具有的重量衰减和优化。

对于目标检测和实例分割,作者使用COCO 2017数据集。具体来说,作者将GroupMixFormer作为Mask R-CNN[24]的骨干用于目标检测和分割,并使用RetinaNet[35]仅进行检测。所有骨干都是通过相应的ImageNet预训练模型初始化的。作者遵循[9]中的训练计划:初始学习率设置为,线性热身500次迭代,然后逐渐减小到和,分别在24-_th_和33-th epochs。

作者使用AdamW对Mask R-CNN和RetinaNet进行训练,但前者具有0.05的重量衰减,后者具有的重量衰减。除了COCO,作者还将在ADE20k上使用UperNet和Semantic FPN评估语义分割性能。作者遵循[37, 53]使用公共工具包进行训练和评估。Semantic FPN进行了80k次迭代训练,而UperNet进行了160k次迭代训练,两者均使用AdamW优化器。

Comparisons with State-of-the-art Models

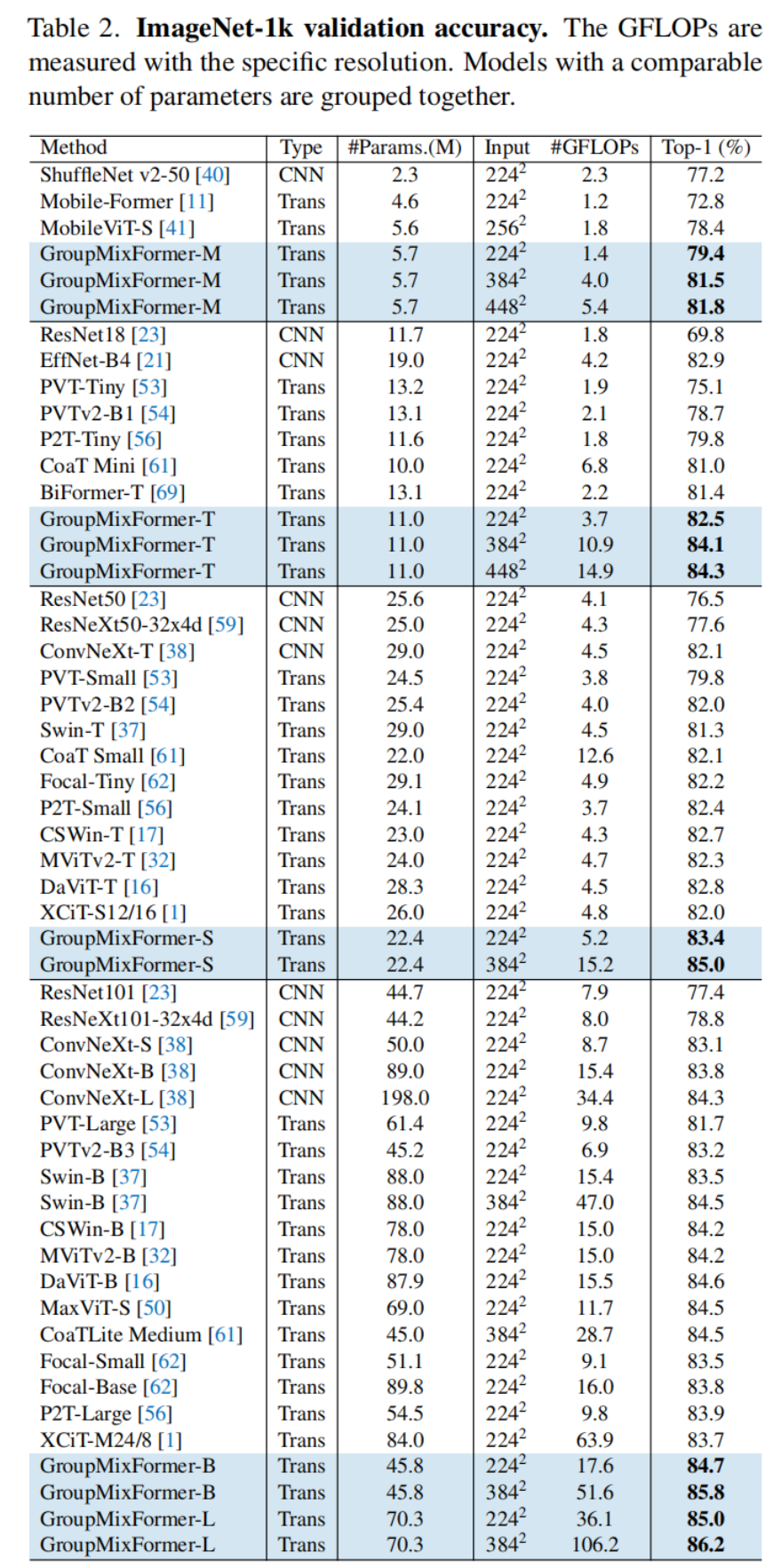

图像分类。作者在表2中与文献中的最先进模型进行了比较,其中所有报告的结果仅使用ImageNet-1k进行训练。为了公平比较,作者没有使用任何额外的增强,如Token-标签,知识蒸馏,SAM,等等。作者观察到,在相似的模型大小和计算复杂性约束下,GroupMixFormer始终比ViT和CNN模型实现更高的Top-1精度。

具体来说,在的分辨率下,GroupMixFormer-S仅使用22.4M参数,就实现了83.4%的Top-1精度,超越了第二好的ViT(CSWin-T)0.7%,并超越了最好的CNN(ConvNext-T)1.3%。同时,使用图像的GroupMixFormer-B甚至达到了与Swin-B相似的准确率,尽管GroupMixFormer-B的大小只有Swin-B的一半。此外,GroupMixFormer在更高的分辨率下也表现出令人满意的扩展性。例如,在的分辨率下进行微调,GroupMixFormer-S的性能可以进一步提高到85.0%;大约使用70M参数的作者的GroupMixFormer-L,在的分辨率下可以实现85.0%,在的分辨率下可以实现86.2%。

这些结果强调了在建模视觉模式时,全面地综合考虑Token对之间的相关性和组之间的相关性的优势。此外,附录中呈现了来自不同聚合器的注意力响应,以支持存在某些模式,某些Token应该作为一个整体进行分类的观点。

此外,作者在实践中观察到,在GMA中的深度卷积作为聚合器确实会导致推理速度的降低。吞吐量在附录中报告。然而,这可以通过更高效的聚合器(例如,平均池化)和实现工程优化(例如,“torch.compile”)来改进。作者将在未来的研究中探索模型在实际应用中的速度优化。

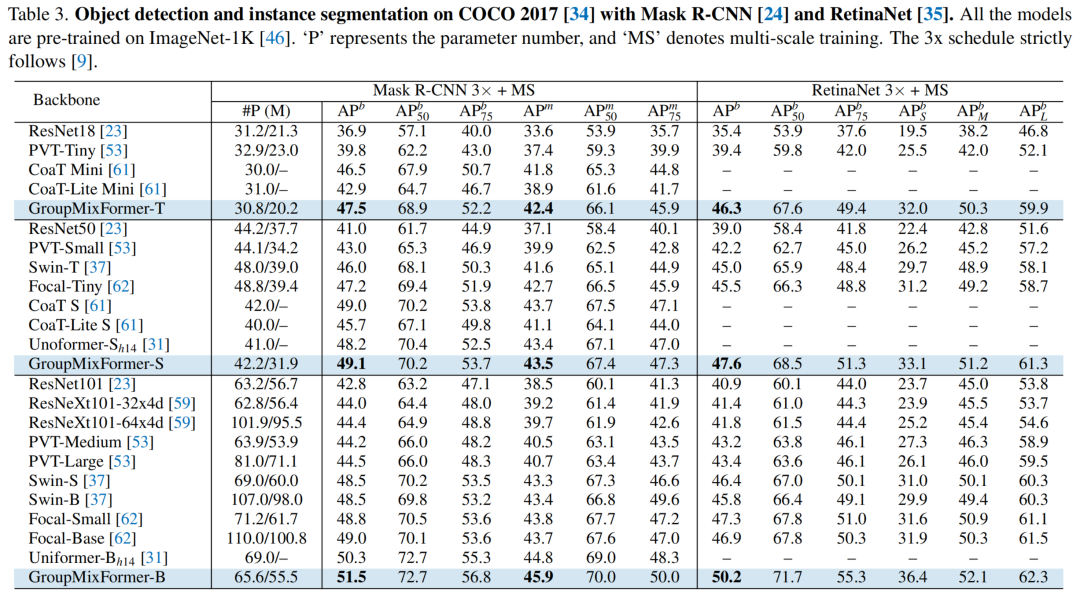

目标检测。表3显示了在COCO上使用Mask R-CNN和RetinaNet检测器的目标检测结果。对于相似的模型参数,GroupMixFormer在平均精确度方面比Mask R-CNN更高。

具体来说,GroupMixFormer-T比第二好的模型CoaT Mini提高了1%(即47.5% vs. 46.5%),同时保持了30.8M的较小模型大小。此外,作者的GroupMixFormer-B实现了51.5%的AP,超越了所有可比较的模型。与RetinaNet相比,GroupMixFormer也具有优势:GroupMixFormer-T比Swin-B(即46.3% vs. 45.8%)提高了0.5%(即45.8% vs. 46.3%),尽管作者的模型更小(即20.2 M vs. 98.0 M);GroupMixFormer-B比第二好的模型(即Focal-small)提高了2.9%(即50.2% vs. 47.3%)。

这些结果表明,GroupMixFormer在两个检测器上都取得了良好的性能。一致且显著的改进证明了GroupMix机制的有效性,该机制旨在捕捉细粒度的特征以促进密集预测。表3还显示了在COCO上使用Mask-RCNN进行语义分割的结果。作者的GroupMixFormer-T令人印象深刻地实现了42.4%的AP,比Coat Mini高0.6%,比PVT-Large高1.7%。此外,GroupMixFormer-B比Uniformer-B(即45.9% vs. 44.8%)提高了1.1%。

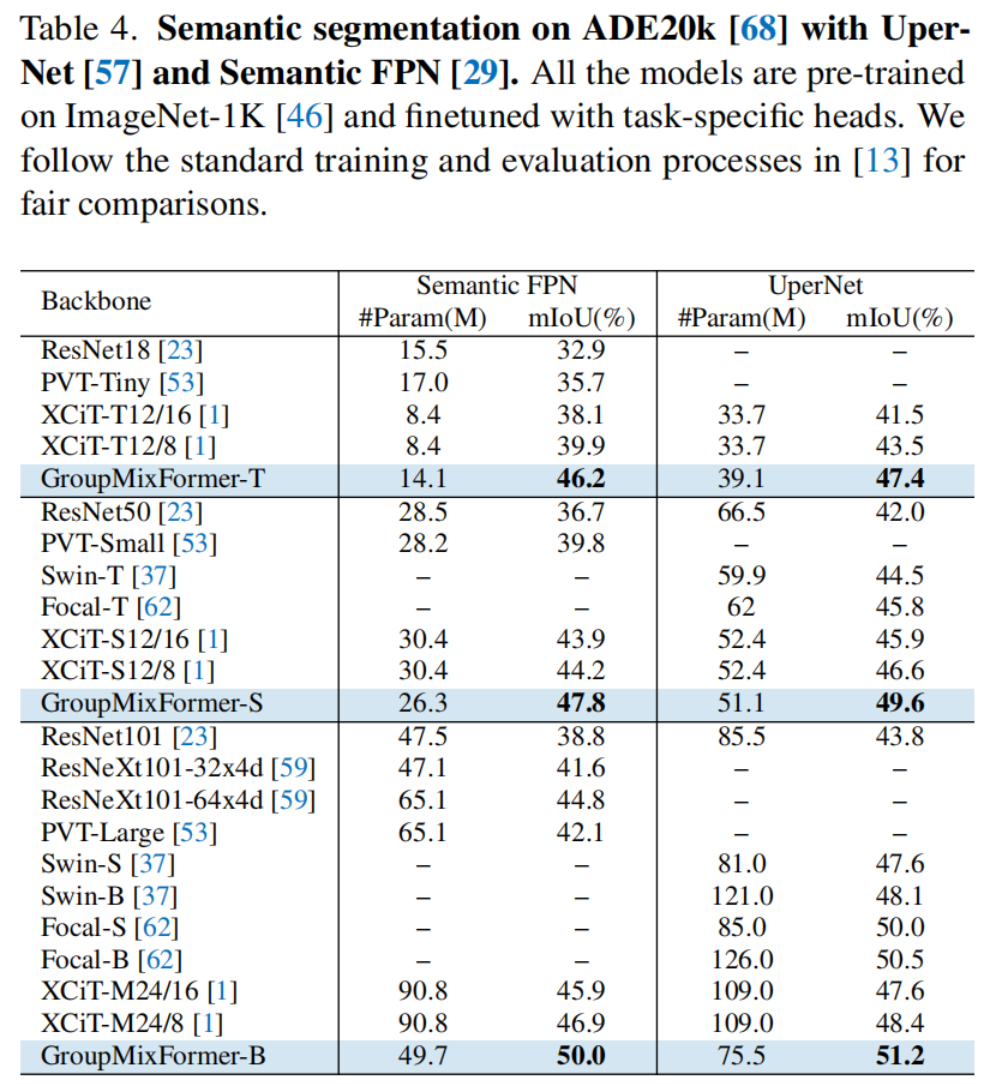

在ADE20K上,作者使用UperNet和Semantic FPN,并报告了表4的结果。同样,作者观察到GroupMixFormer相对于现有骨干 consistently实现良好的性能。例如,尽管GroupMixFormer更小,但GroupMixFormer-T在Semantic FPN上的性能比XCiT-S12/8(即46.2% vs. 44.2%,14.1 M vs. 30.4 M)提高了2.0%。

值得注意的是,尽管GroupMixFormer-T比XCiT-M24/16(即45.9% vs. 46.2%,90.8 M vs. 14.1 M)提高了0.3%,但后者是GroupMixFormer-T的6.4倍大(即45.9% vs. 46.2%,90.8 M vs. 14.1 M)。同样,在UperNet上,GroupMixFormer的表现远优于其他较大的模型,展示了在性能和效率之间的明显更好的权衡。这样的显著改进表明,Group-Mix机制能够为像素级别的预测产生高质量的特征。

Ablation Studies

对于图像分类,作者在ImageNet-1k(224)上训练GroupMixFormer-T 300个epoch,并在验证集上进行测试。对于目标检测和语义分割,作者使用Mask R-CNN,在COCO上使用1计划进行训练。

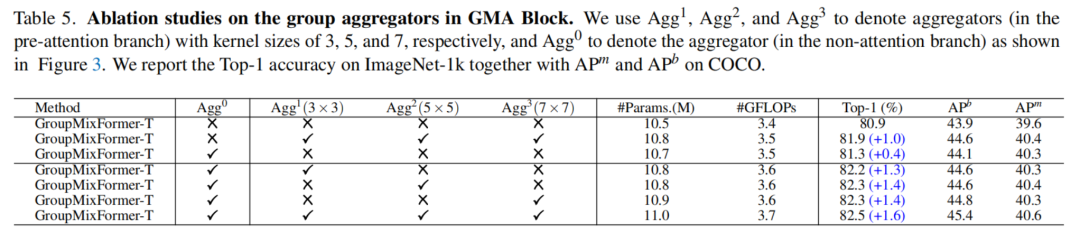

群聚合器是必要的。表5展示了消融聚合器的实验结果。作者首先通过用身份映射替换GMA块中的所有五个分支,构建了一个GroupMixFormer-T基准,这样,块就退化为一个普通的自我注意力模块。在第一组实验中,作者在非注意力分支(Agg)或三个预注意力分支(Agg, Agg和Agg)中恢复聚合器。每个模型都从零开始,使用与第4.1节中描述的相同配置进行训练。可以观察到,聚合器都是关键的,因为它们分别提高了Top-1精度0.4%和1.0%。

此外,表5中的第二组实验表明,在所有三个预注意力分支中使用聚合器比使用任何一个聚合器都取得了更好的性能。同样的实验结果也出现在目标检测和语义分割中。使用所有的聚合器可以提高基准性能一定幅度(例如,+0.7%的AP和+0.5%的AP)。这些结果表明,以更加全面的方式建模相关性能够提供细粒度的视觉表示,从而有利于密集预测场景。

然后作者分析了各种预注意力聚合器的核大小对性能的影响。不改变非注意力分支,作者将所有的预注意力聚合器替换为Agg(33卷积)、Agg(55)或Agg(77)。表5中的第二组结果表明,使用任何组聚合器都可以提高分类和密集预测性能,而33,55和77的多样化组合可以产生最佳结果。具体来说,装备有各种聚合器的GroupMixFormer-T在分类精度、物体检测的AP和语义分割的AP方面分别比基准提高了+1.6%、+1.5%和+1.0%,这表明建模不同大小组之间的相关性是性能提升的关键。

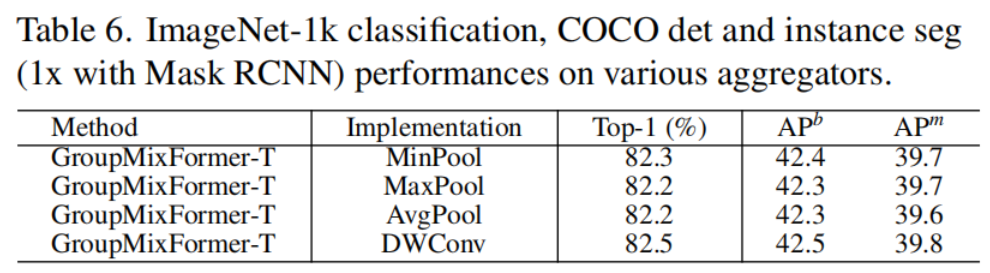

深度卷积是有效的聚合器。 请注意,聚合器Agg的实现方式可能会有所不同。表6显示了作者关于不同聚合器实现效果的结果(例如,深度卷积,最大池化或平均池化)。

经验观察表明,通过深度卷积实现的聚合器在分类(Top-1精度为82.5%)、检测(AP为42.5%)和实例分割(AP为39.7%)方面取得了略好的性能(使用Mask R-CNN)。与最大池化和最小池化操作相比,卷积聚合器可能由于涉及更多的可学习参数来计算相关性,从而实现更好的性能。

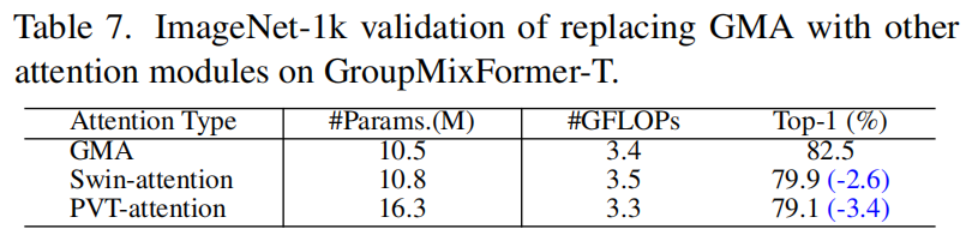

性能提升并非来自宏观结构。与代表性的作品[37, 49, 53]相比,作者的GroupMixFormer更深,且具有不同的Token嵌入实现。为了证明性能提升并非仅仅由于更好的架构超参数组合(包括Token维度、扩展比例和层深度,如表1所示),作者将GroupMixFormer-T中的GMA块替换为Swin-attention或PVT-attention。

表7中的结果表明,仅替换GMA会导致显著的性能下降,这证明了性能提升是由于先进的通知机制而不是架构所致。

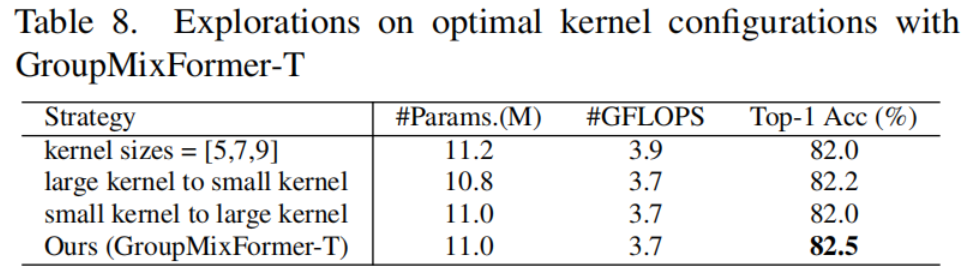

聚合器的核大小的最优配置。为了找到最优配置,作者采取了两种方法:(1)增加核大小,并(2)以不同的顺序更改核配置。第一种方法包括将核大小从(3,5,7)增加到(5,7,9)。对于第二种方法,作者在浅层使用较大的核,在深层使用较小的核,并采用反向配置。然而,如表8所示,这些修改都没有证明比作者最终采用的配置更有效。GMA不仅仅是卷积和自注意力之间的简单组合。作者进行了进一步的实验来验证作者的GroupMixFormer本质上不同于卷积和自注意力的简单组合。

具体来说,作者从GroupMixFormer-T中移除所有群聚合器,并在整个自注意力模块之前插入一组卷积层,这些卷积层按照相同的顺序排列(即并行身份映射、33、55和77层的组合)。这样,Top-1精度(81.5% vs. 82.5%)下降了1.0%。

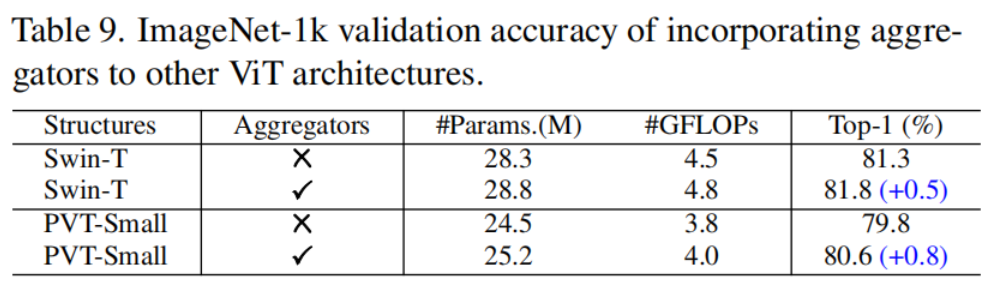

聚合器是一个先进的通用构建模块,可以应用于其他ViTs。作者还可以通过将聚合器简单地插入到原始注意力模块中(例如,Swin和PVT)来处理它们的Query、Key和Value。

表9中的结果表明,这种策略通常可以明显提高ViTs的性能。例如,具有聚合器的PVT-Small达到了80.6%的Top-1精度,比其原始结果提高了0.8%。这表明,所提出的聚合器通过建模组相关性来提高ViTs,从而导致对Token的全面理解。

5 Conclusion

在本文中,作者提出了一种先进的注意力机制,名为群组混合注意力(GMA)。与流行的多头自注意力(MHSA)仅模型化单个Token之间的相关性不同,提出的GMA利用组聚合器同时捕获Token对之间的Token-Token、Token-组和组-组相关性。作者基于GMA提出了GroupMixFormer,并实例化了一系列具有不同大小的实用视觉骨干。在包括图像分类、目标检测和语义分割在内的标准视觉识别基准测试中,广泛实验验证了所提出的GMA和GroupMixFormer的有效性。

Appendix

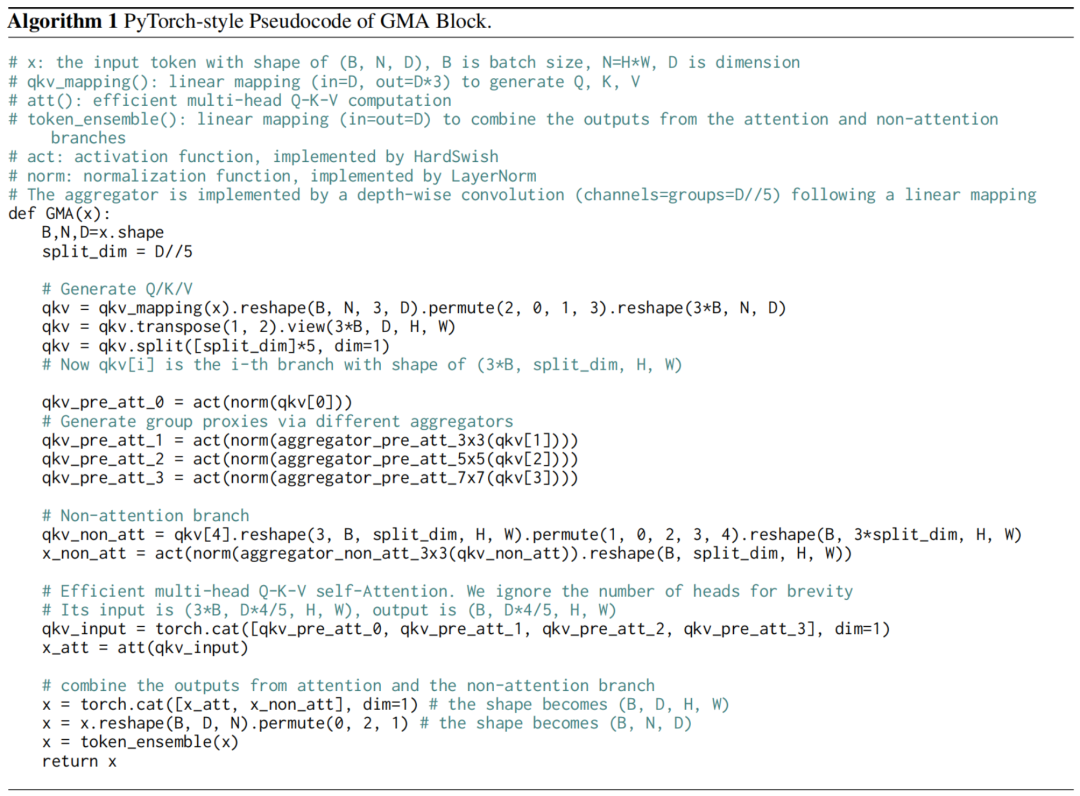

本附录包括算法、训练配置和额外实验的详细说明。在算法1中,作者提供了GMA块的PyTorch风格伪代码,以便于实现。在附录A中,作者详细阐述了注意力计算和图像分类、目标检测和实例/语义分割的训练配置。此外,在附录C和附录D中,作者分别呈现了额外的实验和可视化结果,以进一步验证GroupMixFormer的有效性。

Appendix A Implementation Details

Attention Computation

作者在附录中详细阐述了GroupMixFormer所采用的注意力计算方法。首先,将Q/K/V的元素均匀地分为五个段落,然后在四个段落上进行组聚合。作者用()分别表示从Q/K/V元素中划分的四个段落。

为了生成群代理, , 和 , 作者首先对段落执行聚合操作,即, 和 。

然后,作者将所有四个()聚合的特征连接在一起,以输出群代理, , 和 。之后,作者根据[1, 47, 61]中介绍的方法在群代理上执行注意力计算,以生成最终的输出Att。

Image Classification

标准ImageNet-1K数据集[46]包含大约130万训练样本和50K验证样本,来自1000个类别。作者实验的输入分辨率分别为, 或。作者遵循[49]进行数据增强,包括Mixup,CutMix,随机擦除等。作者使用与[37]相同的训练配方。对于的训练,所有GroupMixFormer实例都训练300个epoch,批量大小为1024。初始学习率设置为,线性预热20个epoch,然后使用余弦退火算法将学习率减小到零。

作者采用AdamW优化器,权重衰减系数为0.05。GroupMixFormer-M/T/S/B/L的drop-path率分别设置为0.0,0.1,0.2,0.4和0.5。此外,对于更高的分辨率(例如,和),作者在-预训练模型上再训练30个epoch,初始学习率为,线性预热5个epoch,然后使用余弦退火。对于微调,作者使用AdamW优化器,权重衰减系数为。

Object Detection and Instance segmentation

对于目标检测,作者在COCO 2017上进行实验,使用Mask R-CNN和RetinaNet。所有模型均使用在ImageNet-1K上预训练的权重进行初始化。检测器在COCO train2017(118k图像)上进行微调,并在COCO val2017(5k图像)上进行评估。对于数据增强,作者采用多尺度训练作为常见做法。

作者还遵循了[9]中提供的标准3(36-epoch)训练时间表。对于Mask R-CNN,作者使用AdamW优化器,权重衰减系数为0.05;对于RetinaNet,作者使用。例如,对于实例分割,作者在COCO 2017[34]上使用与上述相同配置的Mask R-CNN对GroupMixFormer模型进行基准测试。此外,作者在本补充材料中还提供了使用Cascade Mask R-CNN[4]的额外结果。作者使用与Mask R-CNN相同的训练配置。

Semantic Segmentation

对于语义分割,作者在ADE20k上进行实验,使用UperNet和Semantic FPN。ADE20k包含大约20k、2k和3k的图像,分别用于训练、验证和测试,共150个类别。遵循[37, 53]中的常见做法,作者将图像随机缩放和裁剪到用于训练,并将较短的一侧缩放到512像素用于测试。对于Semantic FPN,作者使用AdamW优化器,权重衰减系数为;对于UperNet,作者使用AdamW优化器,权重衰减系数为0.01。Semantic FPN的训练周期为80k迭代,而UperNet的训练周期为160k迭代。学习率最初设置为,在1500迭代内线性预热,然后按照多项式衰减时间表以0.9的指数衰减。

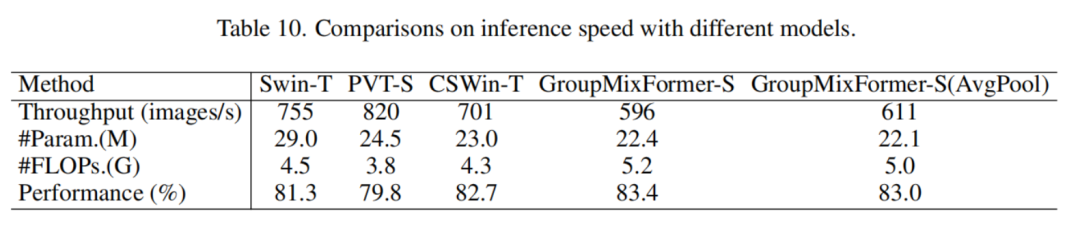

Appendix B Speed Analysis

作者实际发现,在GMA中实现DW-Conv作为聚合器确实降低了推理速度。例如,如表10所示,在单个V100 GPU上进行测试时,作者的吞吐量(596图像/秒)小于常见的骨干(例如,Swin-T的755图像/秒,CSWin-T的701图像/秒)。

然而,作者的模型在识别性能方面远远优于其他模型。值得注意的是,在保持准确率不变的情况下,GroupMixFormer的性能可以通过实现更高效的聚合器(例如,如表10所示,通过AvgPool实现+15图像/s)而进一步提高。

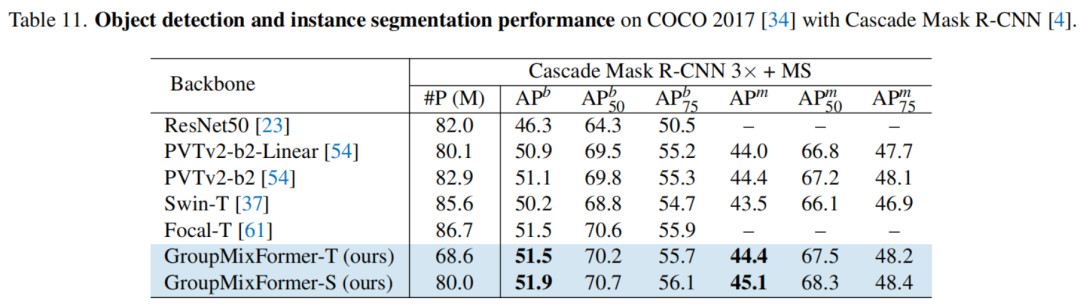

Appendix C Additional results with Cascade Mask R-CNN

为了进一步验证作者提出的模型的有效性,作者将GroupMixFormer配备了更强大的目标检测器,即Cascaded Mask R-CNN。详细实现方法在附录A.3中给出。表11的结果表明,GroupMixFormer始终优于常见的基于Transformer的骨干(例如,PVT-V2和Swin)。

此外,与具有86.7M参数的Focal-T相比,作者的GroupMixFormer-T在更少的参数(68.6M v.s. 86.7M)下取得了可比的性能(约51.5%的AP)。作者的GroupMixFormer-S实现了新的最先进性能,具有51.9%的AP。

Appendix D Attention Visualization

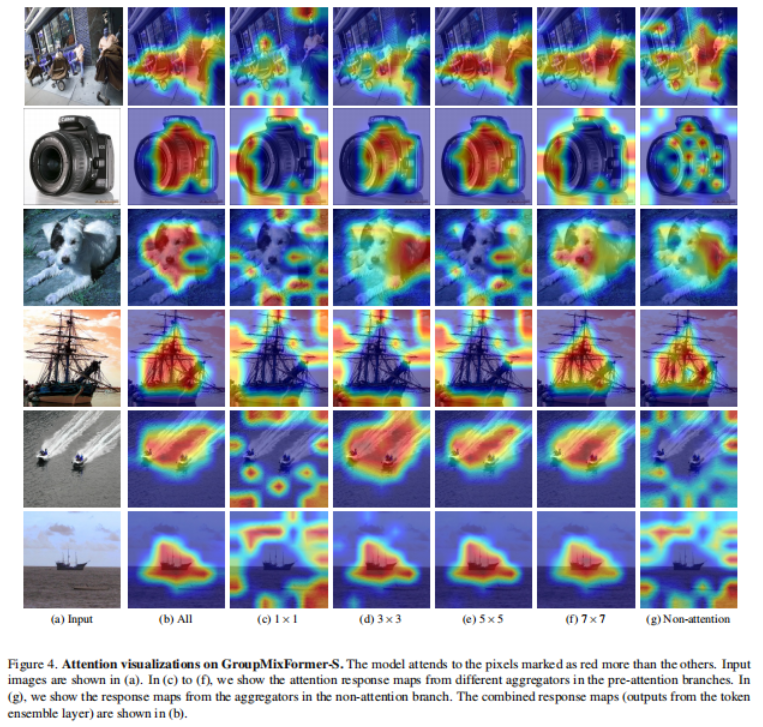

作者在图4中展示了注意力响应图。作者展示了输入图像(图(a)),以及来自集成层的注意力响应图(图(b))。此外,还展示了来自预注意力分支和非注意力分支的响应图(图(c)至图(g)),分别对应于不同的子图。

作者观察到,在某些情况下,将自注意力应用于单个Token可能会导致无法关注到对象,如图(c)所示。在这种情况下,计算由聚合器生成的群代理之间的相关性可能会有所帮助。例如,如第三行所示,计算由核大小为3和7的聚合器处理的分组之间的相关性,成功地将焦点放在狗上,而(c)中计算的Token对之间的相关性则更侧重于背景。

这些结果表明,存在一些模式,在这些模式下,某些Token应该作为一个整体来处理,以捕捉对象的特性。在GMA中,由不同聚合器捕获的表示被组合在一起。这验证了全面建模Token对之间的Token-Token、Token-组和组-组相关性可以带来更好的视觉识别。

参考

[1].Advancing Vision Transformers with Group-Mix Attention.

点击上方卡片,关注「集智书童」公众号

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง