编译 | 曾全晨

审稿 | 王建民

今天为大家介绍的是来自Jannis Born团队的一篇综述论文。语言模型,尤其是自然语言处理中的Transformers模型,在科学领域的成功应用催生了“科学语言模型”的概念。这些模型专注于小分子、蛋白质或聚合物。在化学领域,语言模型已经开始加速分子发现周期,早期药物发现的有希望的最新发现就是一个证据。在这篇综述中,作者回顾了语言模型在分子发现中的作用,强调了它们的优势,并讨论了它们在从头药物设计、属性预测和反应化学中的弱点。

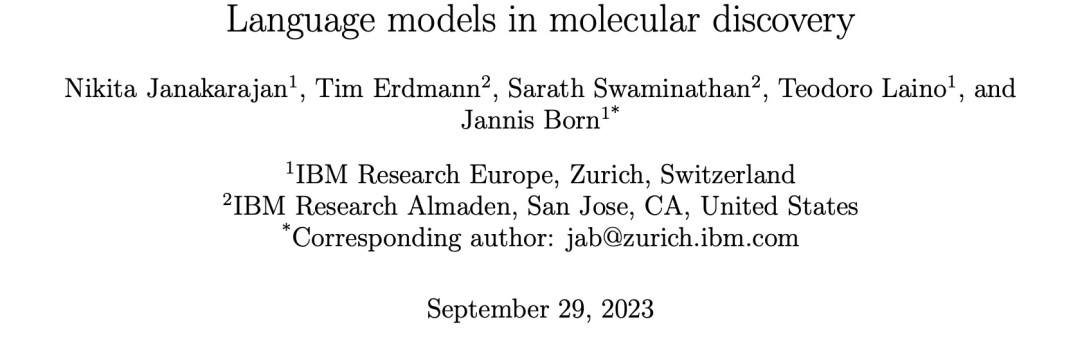

图灵测试于1950年提出,是衡量机器模拟人类行为能力的标准。几十年来,它被视为人工智能(AI)的圣杯。最近,语言模型(LMs)展现出惊人的能力,能理解和生成类似人类的文本。由于过去5-10年的显著进展,人们对图灵测试的看法发生了突变,从一个被广泛讨论和普遍认为难以解决的挑战,转变为对其可能被突破的认可。机器学习(ML)有潜力加速分子发现周期(见图1)。尽管LM最初是为自然语言开发的,但它们在应用于“科学语言”时,在科学发现领域显示出令人信服的结果,例如在蛋白质折叠、新型小分子、肽或聚合物的设计中。什么是语言模型?从定义上讲,它是任何能够消费一系列文本块(所谓的tokens)并能够理解序列内容的ML模型。由于每个token本质上是一个向量,LM是一种伪离散时间序列模型。通常,LMs学习单词序列上的概率分布,从而也促进了其根据某些输入生成新文本的能力,例如在语言翻译任务中。虽然所有LM都依赖于神经网络,但现代模型几乎都使用transformer架构。所有这些都引发了一个问题——分子发现中需要LM的原因是什么?首先,当应用于化学实体的序列化(例如SMILES)时,LM可以学习高度结构化的表示,甚至经常为所需的功能特性量身定制。这允许在原本被认为是离散的蛋白质或分子空间中进行平滑且以属性为驱动的探索。科学LM的另一个吸引人的特点是它们能够无缝地连接自然语言和科学语言。这可以使得像ChatGPT风格的聊天机器人界面的出现,允许化学家通过自然语言表达他们的设计目标,并通过交互式代理迭代地完善其结果,从而可能更快地完成复杂的化学任务。

图 1

然而,像GPT这样的大型语言模型(LLMs),虽然为交互式对话提供了基本框架,但缺乏对科学操作(例如分子发现)的知识,无法获取提供最新数据的信息源,并且无法准确引用。它们在回应中倾向于产生幻觉,这引发了关于可信度、信任和适用性的问题。然而,通过将特定任务的代理集成到LLM驱动的会话应用程序中,并允许LLM根据提供的指令推理出它们的适当使用,可以克服AI和科学之间的这一关键差距。这也消除了与专家开发的AI模型相关的应用障碍。此外,可以预期,这将显著增加开发的AI模型的利用率,并有助于科学发现。

加速分子发现

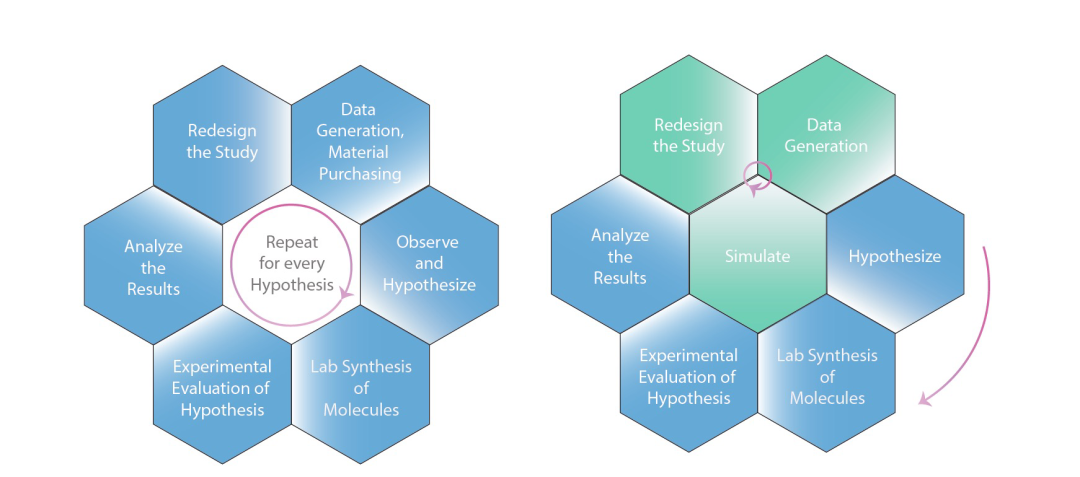

图 2. 常见的分子表示方法

分子发现,与在广阔空间中优化多样性质紧密相连。在化学的设计-制造-测试-分析(DMTA)循环中,合成成本和时间限制造成了瓶颈(参见图1a)。传统方法主要由药物化学家驱动,他们设计的“分子假设”是有偏见的且不全面的。这阻碍了解决问题的进展,从而体现了加速分子发现过程的必要性。最近,深度生成模型作为一种有前景的工具,出现在加速分子发现假设/设计阶段。然而,即使是最先进的分子生成模型也需要一种有效的大规模虚拟筛选方法来测试它们的假设。加速的分子发现周期向DMTA添加了一个验证环,快速、廉价地评估众多假设(参见图1b)。这个环增强了设计阶段的生成模型,确保只有有前景的假设进入到合成和物理实验阶段。

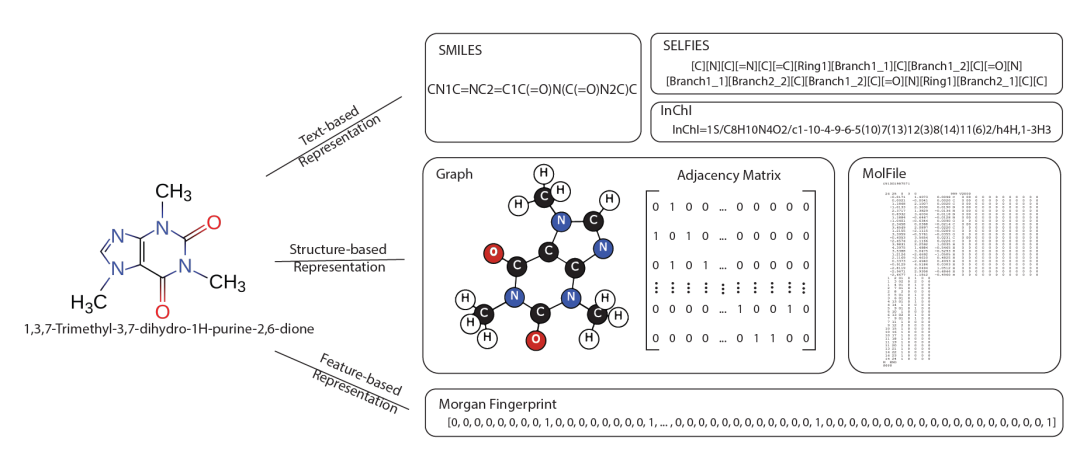

生成建模涉及学习数据的潜在分布,目的是生成新样本,这是加速全新药物发现的关键技术。生成模型可以是有条件的或无条件的。有条件的生成模型使用提供的数据属性或标签来生成具有期望属性的新样本,而无条件模型仅提供一种类似于训练数据的样本生成方式。设计-制造-测试-分析(DMTA)循环特别受益于有条件的生成方法,因为它促进了以目标为导向的假设设计。递归神经网络(RNNs)的序列性质使它们成为处理化学语言的合适模型。RNNs是在90年代提出的,是首批进入这一领域的化学语言模型(CLMs)。RNNs在传递新tokens时不断更新其隐藏状态,因此能够编码上下文信息。在生成过程中,tokens是自回归地产生的。RNNs被用于生成分子库,这些库广泛用于药物开发过程中。变分自编码器(VAEs)学习分子的潜在分布参数,从而使通过从这个分布中抽样来生成新分子成为可能。它们独特的能力在于学习一个平滑的潜在空间,即使对于像分子这样的离散实体也能够实现样本的插值。为了使VAEs适用于化学语言模型(CLMs),任何与字符串输入兼容的网络都可以作为VAE的编码器和解码器。最初的研究主要集中在单模态应用上,通过下游任务评估潜在空间质量。这种方法仍然流行,并可用于生成具有特定特性的分子,例如使用基于RNN的VAE生成催化剂。VAEs的应用范围逐渐扩展到多模态设置中,用于条件分子生成,如图3所示。

图 3

Transformers的自注意特性使模型成为NLP领域的前沿。Transformers有一个依赖于自注意来学习输入及其相关上下文的编码模块。解码模块通过注意力使用编码器学到的上下文和之前生成的tokens来预测tokens。在生成建模中已成为主导方法。这种成功被转化为科学语言领域。第一个使用GPT架构进行条件分子生成的模型之一是MolGPT。将SMILES tokens与概括所需特性和框架的条件向量串联起来作为输入传递给这个模型,然后训练它进行下一个token预测任务以生成分子。结合了强化学习的类GPT模型也可用于优化分子特性,如pIC50。在这种两阶段方法中,首先从SMILES字符串中学习嵌入,然后优化嵌入空间,使模型能够抽样出具有所需特性的分子。

科研语言建模的软件

在本节中,作者介绍了一些常用软件(例如Python包或基于云的Web应用程序),这些软件对实现分子发现至关重要。Self-Attention作为目前最广泛采用的神经网络架构的成功故事与Transformer的崛起密切相关。Self-Attention最初用于自然语言处理(NLP)的应用,后来被跨学科采用,例如在计算机视觉、强化学习,以及自然地,在化学应用中。Hugging Face提供了最大的公共LM中心,它提供了所有最新模型的实现,以及可用于微调或推理的多样化的预训练模型集合。其中很多模型是为生命科学应用而设计的,特别是分子性质预测(例如ChemBerta)、分子解释(例如MolT5)、基于文本的分子生成(例如MolT5)和无监督的蛋白质语言建模(例如ProtBert、ProtAlbert、ProtXLNet和ProtT5)。此外,一些可用的模型,如Multimodal Text and Chemistry T5,是基于提示的多任务处理器,不仅包括上述任务,还包括额外的功能,如预测前向/后向反应。

为科学发现提供的生成工具包Python库,如gt4sd、TdC(Therapeutics Data Commons)或deepchem,主要是为分子发现应用开发的。gt4sd特别提供了对化学语言模型的广泛支持。这类库旨在使研究人员和开发人员能够使用、训练、微调和分发最先进的科学领域生成模型,重点是有机材料。它与许多现有库兼容并可互操作。除了分子生成的既定基准,如Moses和GuacaMol外,gt4sd还支持当代模型,如用于并行序列回归和以属性驱动的分子设计的回归transformer、用于高度多样化候选生成的GFlowNets和用于基于图的分子生成的MoLeR。模型可以通过命令行界面(CLI)进行训练,只需几行代码,可以共享到云托管的模型中心。

反应和合成语言模型一旦选择了一个分子进行实验验证,就必须确定一个可行的合成路线。由于化学反应建模中最重要的任务可以被框定为序列转换问题,因此自然语言翻译的方法可以无缝转换到化学。用于反应建模的最成熟和灵活的LM库是rxn4chemistry包。它包装了IBM RXN for Chemistry平台的API,这是一个免费可访问的Web应用程序,提供了丰富的CLMs集合,用于反应化学中的不同任务。主要架构是分子transformer(MT),这是一个自回归的编码器-解码器模型,最初用于预测有机化学中的化学反应结果。MT被应用于单步逆合成,并成为具有超图探索策略的多步逆合成模型的关键部分。这种方法后来被推广到酶促反应,基于酶类的标记化方案,促进了生物催化合成计划,并为更绿色的化学铺平了道路。

药物发现的未来

几年前,像利用搜索引擎一样问询人工智能(AI)模型,以提取科学知识并执行计算分析的想法,曾是一个过于雄心勃勃的壮举。科学思维来自于推理能力,而AI模型尚不能像人类那样推理。然而,这些模型可以从人类那里学习。我们记录一切的倾向使我们能够训练大型语言模型(LLMs),例如ChatGPT和GitHub Copilot,模仿人类的回应。当这些模型应用于计算科学领域时,它们可以使我们通过精心设计的提示进行计算分析。通过人类反馈(human-in-the-loop),可以创建一种协同效应,即科学家向模型提供关于其输出的反馈,从而帮助更好地优化模型(一种称为从人类反馈中学习的强化学习(RLHF)的策略,对于ChatGPT已被证明至关重要)。这些应用也降低了非科学背景的个人进行科学分析的门槛,而无需接受正规的计算分析培训。

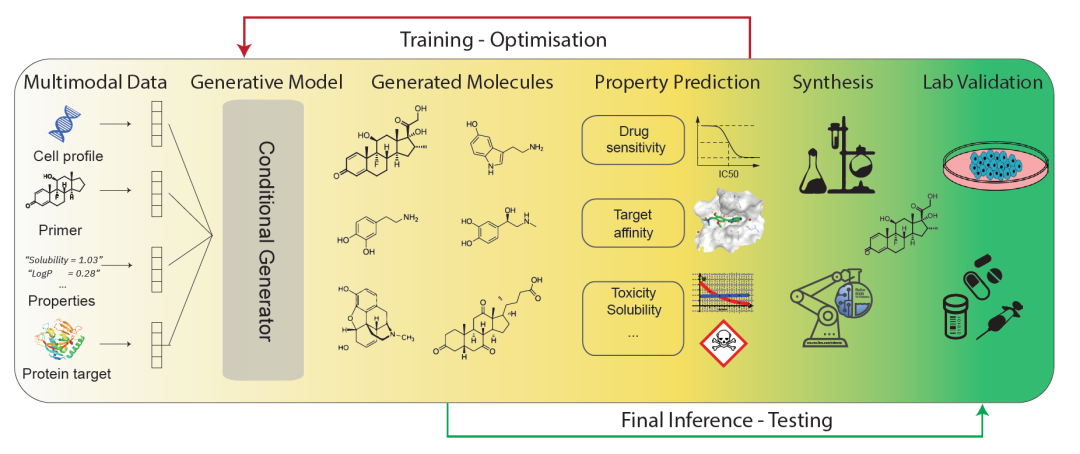

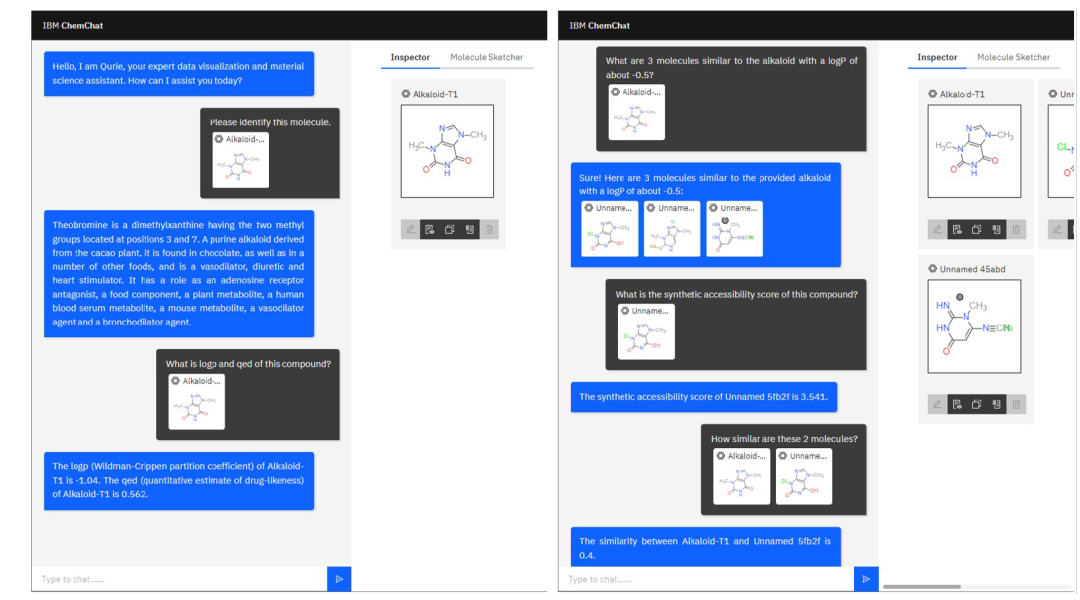

随着LLM浪潮的到来,未来可能会出现像聊天机器人一样的界面,其可能负责所有计算事宜。传统上,神经网络针对单一任务进行训练以实现最大性能。这实际上使模型对其他任务无用,因此即使训练领域相同,每个新任务也需要一个新模型,这反过来限制了我们技术进步的速度。在过去几年中,这种传统方法受到大型语言模型(LLMs)的挑战。研究发现,扩大LLMs的规模会带来惊人的少样本甚至零样本任务泛化性能。这些被称为“基础模型”的模型,通常具有数十亿个参数,尽管在一个大型数据集上进行训练,却可以执行多个任务。基础模型在化学领域的采用日益增加.纯化学语言模型中的多任务处理也通过结合了属性预测、反应预测和分子生成等任务模型不断进步。Christofidellis等人首次弥合了这一差距,开发了一个完全基于提示的多任务化学和自然语言模型。尽管只有2.5亿个参数,但多任务文本和化学T5被证明在重新发现常见除草剂的人为发现工作流程上表现优于ChatGPT和Galactica。考虑到LLMs的强大任务泛化性能,围绕它们构建聊天机器人界面是自然的下一步,因此除了ChatGPT之外,目前还推出了许多类似工具。这些工具被发现在简单的化学任务上表现良好,为重塑化学家与化学数据的互动方式开辟了可能性,使得直观访问复杂概念并为各种化学任务提出有价值的建议成为可能。此外,由计算机科学家专门为例如药物发现或材料科学开发的AI模型可以通过LLMs驱动的应用程序(如聊天机器人)提供。这降低了主题专家的访问门槛,否则他们需要相应的编程技能才能使用这些AI模型。通过LLMs和现有化学软件工具(如PubChem、RDKit或GT4SD)的融合,这些聊天机器人的力量得以实现。这些应用程序可以通过极大地增强使用来释放这些模型的全部潜力和价值。图4展示了与这类工具交互的一个示例。

图 4

参考资料

Janakarajan, N., Erdmann, T., Swaminathan, S., Laino, T., & Born, J. (2023). Language models in molecular discovery. arXiv preprint arXiv:2309.16235.

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง