创办于 5 月的法国大模型公司 Mistral AI 最近有了一系列动作。

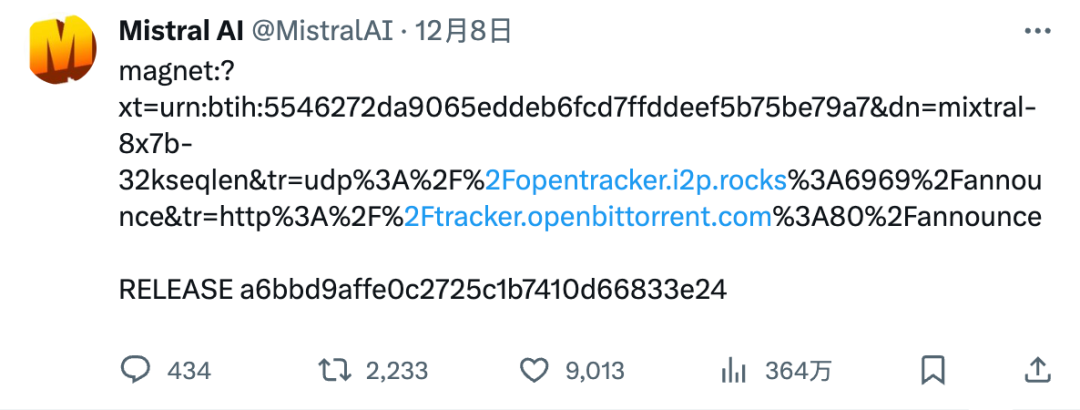

彭博社报道,Mistral 正在完成 4.87 亿美元的融资,估值 20 亿美元,其中英伟达、Salesforce 参与,a16z 领投。联合创始人、CEO Arthur Mensch 登上芬兰创投大会 Slush,与资方 Lightspeed 的合伙人 Paul Murphy 进行了一场访谈。同时 Mistral AI 发布了引爆开源社区的首个 MoE 开源模型 Mixtral 8x7B,跑分与 GPT-3.5 平分秋色。昨天,Mistral AI 上线开放平台 La plateforme(法语,平台),首次商业化动作。其中还上架了一款全面超越 GPT-3.5 的「中尺寸」模型。一周之内,Mistral 成为最受好评和期待的大模型创业公司。甚至在 Google 陷入 Gemini 宣传视频「作假」的风波时,其简单粗暴地直接发 torrent 的开源动作吸引了大量粉丝。(更甚至它都没说「开源」,而是「权重开源」open weights。)

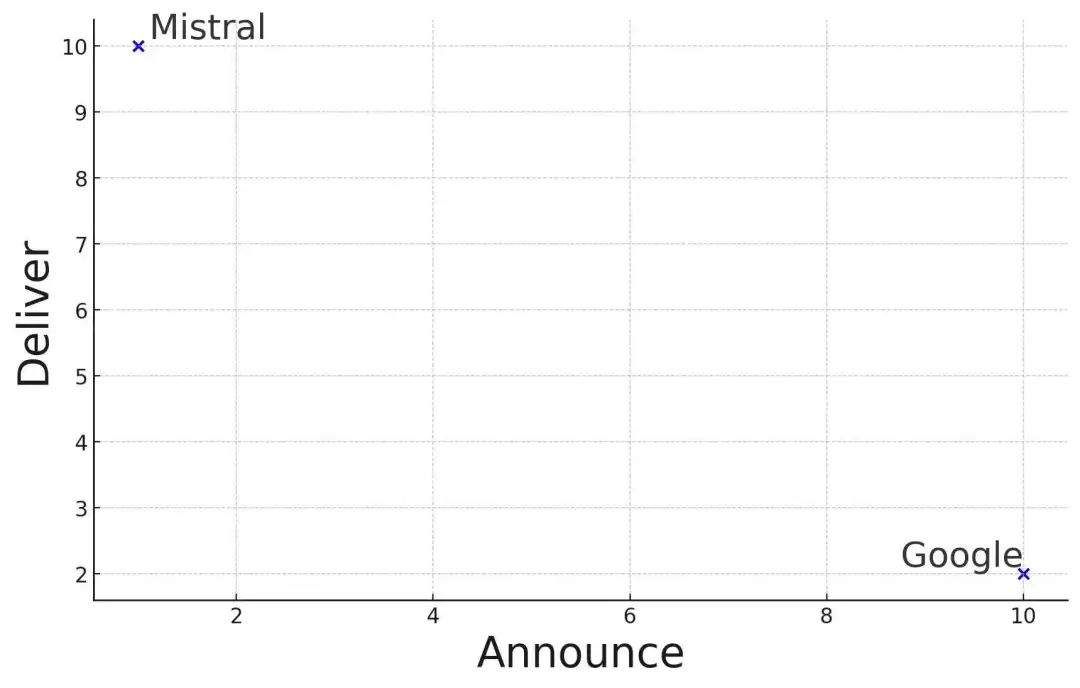

网友玩梗,Mistral 和 Google 走在了交付和宣传的两个极端上。

首个MoE开源

媲美GPT3.5的「开放权重」模型

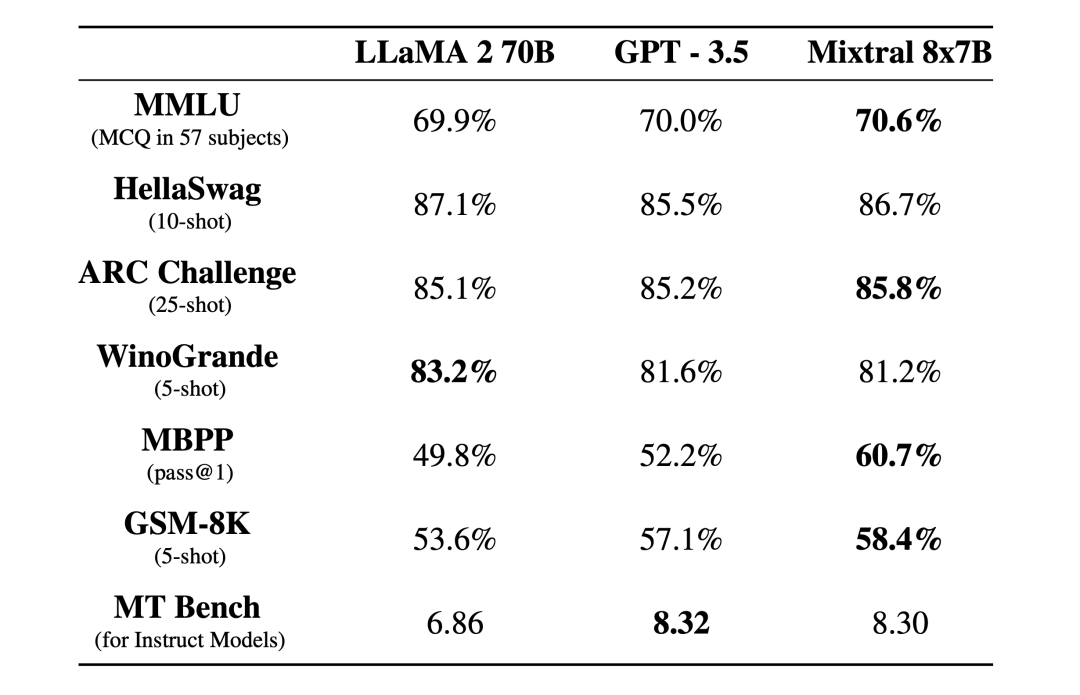

Mixtral 8x7B 是一个高质量的 SMoE(稀疏混合专家模型),开放权重(open weights),Apache 2.0 可商用,在大多数 benchmark 上表现优于 Llama 2 70B,但推理速度快 6 倍。Mistral 特别强调,在大多数基准测试中,该 MoE 模型表现优于 GPT-3.5。32k token 上下文,语言兼容英语、法语、意大利语、德语和西班牙语,代码生成表现出色。同时发布了 Instruct 版本的微调模型,MT-Bench 8.3 分。Mistral 表示,Mixtral 共 46.7B 参数,但每 token 仅使用 12.9B,意味着等同于 12.9B 的推理速度和成本。跑分结果: 关于 Mixtral 8x7B 模型本身的详细信息,可以直接访问官网查看:https://mistral.ai/news/mixtral-of-experts/

关于 Mixtral 8x7B 模型本身的详细信息,可以直接访问官网查看:https://mistral.ai/news/mixtral-of-experts/

开放平台

超越GPT3.5的神秘「中尺寸」模型

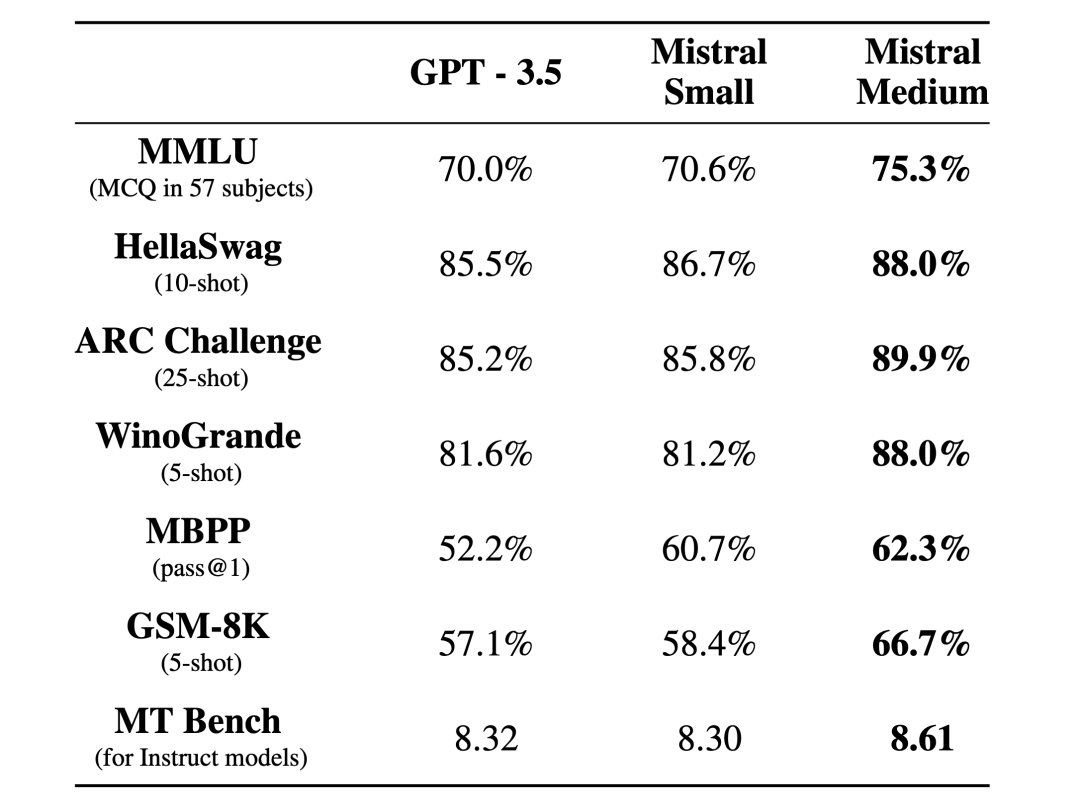

Mistral AI 刚刚发布了开放平台 La plateforme,首先上架三款模型。小小杯,Mistral-tiny。目前提供 Mistral 7B Instruct v0.2 这一 Mistral 7B Instruct 的更新小版本。Mistral-tiny 仅支持英语,并在 MT-Bench 测试中获得 7.6 分。小杯,Mistral-small。Mixtral 8x7B,如上述。中杯,Mistral-medium。目前最高档模型,MT-Bench 8.6 分,benchmark 全面超越 GPT-3.5。 同时提供了 embed endpoint,一个具有 1024 嵌入维度的嵌入模型,设计有检索能力,MTEB 55.26 分。「我们的 API 遵循最初由我们亲爱的竞争对手提出的流行聊天界面的规格。我们提供了 Python 和 Javascript 客户端库,以查询我们的终端节点。」「每个 endpoint 都在性能和价格之间进行了不同的权衡。」API 即日起开放注册,「在平台稳定到完全自助服务前,可能会有一些问题。」「小模型」路线

同时提供了 embed endpoint,一个具有 1024 嵌入维度的嵌入模型,设计有检索能力,MTEB 55.26 分。「我们的 API 遵循最初由我们亲爱的竞争对手提出的流行聊天界面的规格。我们提供了 Python 和 Javascript 客户端库,以查询我们的终端节点。」「每个 endpoint 都在性能和价格之间进行了不同的权衡。」API 即日起开放注册,「在平台稳定到完全自助服务前,可能会有一些问题。」「小模型」路线

20 多个员工,20 亿美元

6 个月前,三名来自 Meta 和 DeepMind 的研究人员在法国巴黎创办了 Mistral AI,种子轮融资 1.13 亿美元,刚刚又被曝完成了 4.87 亿美元的融资,估值 20 亿美元。现在 Mistral AI 的投资人包括,a16z、英伟达、Salesforce、Lightspeed 以及 Google 董事长 Eric Schmidt 等。联创三人,Arthur Mensch,CEO,前 DeepMind 研究科学家;Guillaume Lample,首席科学家,前 Meta 研究科学家,Llama 项目带头;Timothee Lacroix,CTO,前 Llama 工程带头。 目前,Mistral AI 仅有 22 名员工。

目前,Mistral AI 仅有 22 名员工。 创立之初,Mistral AI 坚定开源路线,Mensch 在活动上表示,「我们知道,一直高度致力于此的团队,可以快速开发最先进的模型,我们可以将这个领域变得更加开放,让开发者能够拥有更多机会,去开发专业模型,自己的模型,在解决问题的基础上让模型越小越好。」所以,Mistral AI 选择尽可能训练一个高质量的小模型,7B。在开源模型基础上,应用开发者可以把模型拿来自己训微调,为自己的产品开发专业的模型。「因为,如果你只有个别厂商的几个 API,你很难做到差异化。但如果你能对模型进行更深层次的访问,你就能创造出更有趣的东西。」三个月前,Mistral 7B 开源,(也是简单粗暴发磁链),很快在开源社区获得了大量好评,开发者在 7B 模型基础上开发了众多微调模型,很多在特定任务上表现远超 base model。相比 OpenAI 大而全的 AGI 路线,Mensch 认为 Mistral AI 选择的是更务实的方向,「具有成本效益,低延迟,通过专有数据实现高度差异化等等」。

创立之初,Mistral AI 坚定开源路线,Mensch 在活动上表示,「我们知道,一直高度致力于此的团队,可以快速开发最先进的模型,我们可以将这个领域变得更加开放,让开发者能够拥有更多机会,去开发专业模型,自己的模型,在解决问题的基础上让模型越小越好。」所以,Mistral AI 选择尽可能训练一个高质量的小模型,7B。在开源模型基础上,应用开发者可以把模型拿来自己训微调,为自己的产品开发专业的模型。「因为,如果你只有个别厂商的几个 API,你很难做到差异化。但如果你能对模型进行更深层次的访问,你就能创造出更有趣的东西。」三个月前,Mistral 7B 开源,(也是简单粗暴发磁链),很快在开源社区获得了大量好评,开发者在 7B 模型基础上开发了众多微调模型,很多在特定任务上表现远超 base model。相比 OpenAI 大而全的 AGI 路线,Mensch 认为 Mistral AI 选择的是更务实的方向,「具有成本效益,低延迟,通过专有数据实现高度差异化等等」。

如果你关注大模型领域,欢迎扫码加入我们的大模型交流群,来一起探讨大模型时代的共识和认知,跟上大模型时代的这股浪潮。

更多阅读从100多个GPTs里,探究OpenAI究竟想要什么,又做了什么

时代周刊:为什么 Sam Altman 是 2023 年度 CEO?

MindOS:站在AGI风口,创业两年的教训与思考

专访Pika Labs创始人:视频模型技术路线尚未确定,明年会迎来AI视频的GPT时刻

AI女友产品开发记录:语音带来增长,OpenAI审查升级后访问量暴跌70%

月之暗面杨植麟:大模型需要新的组织范式,场景摩尔定律能催生 Super App

转载原创文章请添加微信:geekparker

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง