衡宇 萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

让GPT-4操纵人形机器人,事先不做任何编程or训练,能搞成啥样儿?

答案是:太 猎 奇 了!

这不,要求机器人表演“在昏暗电影院里狂炫爆米花,却突然发现吃的是隔壁陌生人的😅”。

在GPT-4的操纵下,机器人笑容凝固,“尴尬”得摇头扶额后仰:

但在尴尬之余,竟然还不忘再抓一把塞嘴里???

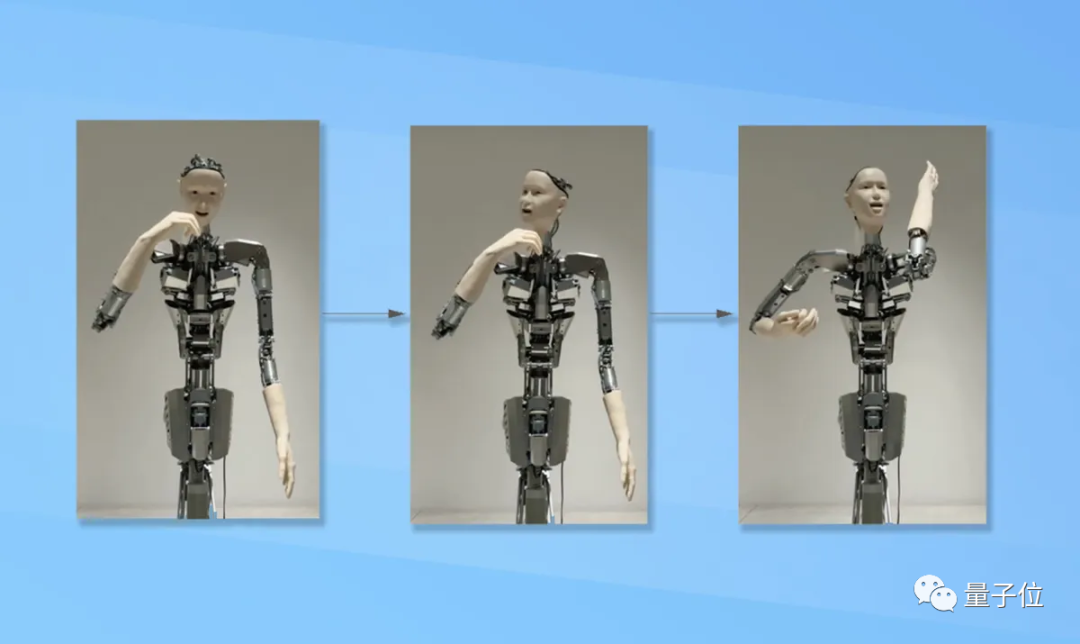

又像是要求机器人“弹吉他”。

GPT-4略思考一番,开始操控机器人活动一番手指、随后疯狂甩头,好像是有点摇滚内味儿。

但仔细一看,甩头的时候,手指就完全不动了……

你要说这是神叨叨的地摊先生在掐指一算,好像也没什么不对(手动狗头)。

总结一系列动作来看——

相比波士顿动力人形机器人,一举一动均由人为程序精细操纵,这个GPT-4直接操控的机器人,表情狰狞,动作诡异,但一切行为又符合prompt的要求。

这一连串GPT-4操控机器人的视频po到网上后,不少网友直呼“恐怖谷效应犯了”:

甚至吓到了20年工龄的机器人技术专家:

这些动作让我毛骨悚然。你自己看看这有美感吗?

还有网友调侃:“看起来就像舞台上的我一样。”

但也有网友认为,人形机器人能通过GPT-4来操纵,已经是很不可思议的事情了。

原来,这是首个由GPT-4驱动人形机器人的研究,来自东京大学和日本Alternative Machine公司。

依靠这项研究,用户无需事先给机器人编程,只需语言输入、也就是动动嘴皮和GPT-4聊上一会儿,就能让机器人根据指令完成行动。

一起来看看这项研究的更多细节和背后原理。

大模型+机器人的新尝试

不编程,也不训练,拿GPT-4当脑子,这个人形机器人Alter3,还能做出哪些令人皱眉却又合理的动作?

不如给个指令,让Alter3假装自己是个👻吧!

它倒是也懂一秒入戏,张大嘴巴、双手前伸。

但不知道为什么,微张的双唇和空洞的眼神,让人感觉它更像林正英都要直呼内行的僵尸:

如果要求它自拍,Alter3倒也当场能来个怼脸大头照。

就是不知道是被原相机里的自己丑到,他的表情并不享受,反而痛苦似的将自己眼睛闭了起来:

再来听个摇滚,music走起。

你说它频频点头是在追随节拍,一定没错;但你要说它是毕恭毕敬站在面前,说“啊对对对对对”,似乎也贴切极了(手动狗头):

在所有放出的视频demo中,“喝茶”这个行为最不奇葩怪异,甚至像是在演我:

上班上到生无可恋的时候,喝茶就是这么要死不活的。要咱说,送到嘴边了才张口,这茶不喝也罢。

作为人形机器人,Alter3做出人类行为有点子搞笑,那……不如试试别的?

比如,演绎一条受到音乐感召后摇摆身姿的蛇:

看到了吗,没那么柔韧,但确实在尽它所能扭动躯干了,可以说是一条蛇的发癫版本.gif。

这么看下来,直接把人形机器人和GPT-4集成这件事,可以干,但美观性属实不太够啊……

其实回顾一下,让大模型和机器人结合这事儿,科学家研究者们今年已经忙活了一整年。

不过,通常做法是做更多的训练,然后尝试将图像语言大模型的能力和知识迁移到机器人领域。

包括微软的ChatGPT for Robotics,谷歌的PaLm-E、RT-1、RT-2,还有VoxPoser、BoboCat等众多工作,都走的是这个路线。

其中,轰动一时的谷歌RT(Robot Transformer)系列效果贼棒,但谷歌训练它就花了17个月,并收集13台机器人的13万条机器人专属数据——一般团队很难有这个资金和精力。

年中,李飞飞团队的具身智能成果,则百尺竿头更进一步,通过将LLM(大语言模型)+VLM(视觉语言模型)结合在一起,机器人与环境进行交互的能力进一步提升。

这种思路下,机器人完成任务无需额外数据和训练。

但是李飞飞团队给出demo里的硬件,本体还只是一个机械臂,今天我们介绍的研究中,实验对象则是大模型界最强的GPT-4,以及作为“身体”的Alter3。

无论是OpenAI开发的GPT-4,还是东京大学和日本“机器人之父”黑石浩联合开发的人形机器人Alter3,都是已有的研究成果。

这项研究的真正目的,是探索如何在不编程的情况下,用像GPT-4这样的大模型控制人形机器人完成各种动作,以验证GPT-4生成动作的能力、降低人机交互的复杂度。

依靠这一系列成果,Alter3才能完成上面看到的各种各样复杂动作(咱们先抛开完成度和观赏性不提)。

还有一件事,那就是研究人员在集成Alter3和GPT-4时发现,即使给Alter3下同一个指令,Alter3反馈的动作也不会每次都一样。

经过一番分析后,他们认为,这与大语言模型本身的特点有关,即相同输入可能对应不同的输出,但并不代表GPT-4无法很好地控制人形机器人。

例如,要求机器人“吃饭”,它可能前后两次就会分别做出拿筷子吃饭和拿刀叉吃饭的不同动作。

那么,话又说回来,GPT-4究竟是如何一接收到语句输入,就知道要如何控制Alter3的呢?

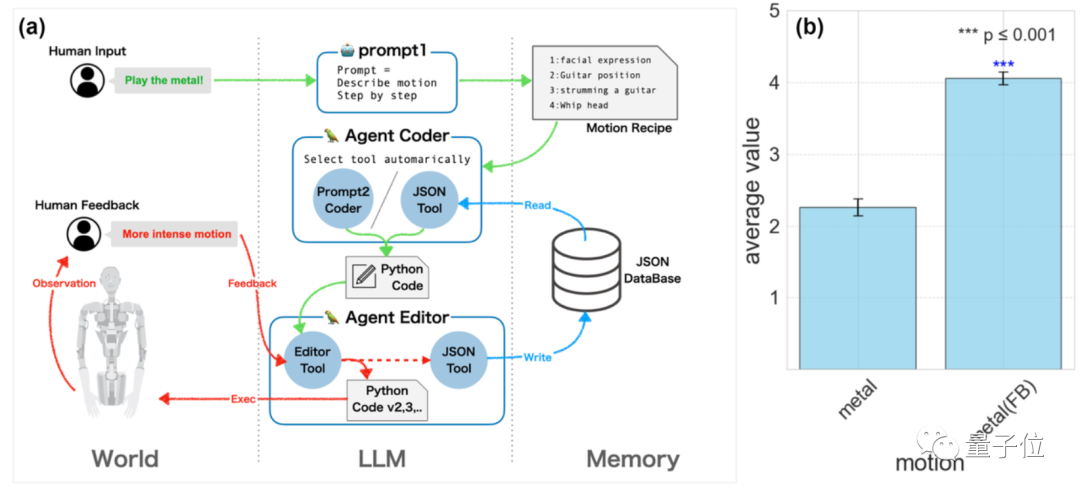

关键靠2步提示词

其实在接入GPT-4之前,Alter3就是带脑子(AI神经网络)的,身上还带着各种传感器。

此前,Alter3的行为主要靠其内置的一颗CPG(CentralPattern Generator,中枢模式发生器)来对传感器传来的数据做出分析,然后按一定顺序驱动体内的43个气动装置,完成相应动作。

整个过程中往往需要人为介入,打点补丁,从而进行一些改进。

But!现在一切都不一样了,研究团队称GPT-4的集成让他们“解脱了”。

现在能实现用口头指令来指挥Alter3,背后技术主要是这俩:

CoT (思维链),以及zero-shot (零样本学习)。

依托这两项技术,对Alter3的控制不再完全依赖硬件本身,而是能够用GPT-4直接将自然语言转换成机器人可理解并执行的动作。

最最重要的是,整个流程无需对任何一个身体部位进行明确编程。

好了,现在来具体讲讲把GPT-4和Alter3集成到一起,是如何实现的。

大体可以分为两个步骤:

首先,先用prompt描述一下,想要Alter3能够完成什么行为或者动作,比如“咱来张自拍吧”“自拍的时候胳膊再举高一点”。

接收到输入的GPT-4会生成一系列的思考步骤,这些步骤详细地阐述了要完成这个动作,需要先后完成些啥。

这个过程被研究团队称为CoT的一部分,即将一个复杂任务分解为一串更简单的思考步骤。

然后,研究者们再祭出另一个prompt,把分解后的详细步骤转化为Alter3可以听懂的动作指令。

简单理解就是把人们的指令描述转化为Python代码,这些代码可以直接用来控制Alter3的各个身体部位的具体运动参数。

有了转化后的代码,Alter3想挤眉弄眼就挤眉弄眼,想撇嘴就能撇嘴 。

。

研究团队把这第二步也看成CoT的一部分,因为它完成的是“把一个抽象描述转化为具体操作”。

团队表示,CoT让GPT-4能够有效控制Alter3,命令它做各种复杂动作,且不用额外的训练或者微调。

多说两句,除了上述的两个Prompt搞定机器人控制外,研究团队还顺手完成了一些其它研究。

比如掰开了看Alter3在对话中的行为,主要针对其对话轨迹和语义时间演化。

针对对话轨迹,研究团队使用了一种叫UMAP(Uniform Manifold Approximation and Projection)的方法。团队把对话内容嵌入二维空间,从而方便观察这个简化版的对话发展过程。

他们发现,当对话顺序固定时,对话轨迹会呈现循环模式,也就是老在重复同样的话题。

而当对话顺序随机时,对话内容更有发散性or创造性。

贼有趣的一点,研究发现GPT-4聊久了过后,会倾向于反复说“再见”。如果你不来点儿人为干预,它就会沉迷于想办法跟你说再见。

而做语义时间演化分析的过程中,团队观察了随着时间变化,聊天内容的变化。

他们发现,对话初期的一些关键词,比如“艺术”或者“学习”啥的,会聊着聊着就被GPT-4忘了,取而代之的是诸如“文化”“人类”“抑制”之类的词。

这表明对话内容是在逐渐发展变化的。

当然,如果你开始跟GPT-4说“再见”,它就几乎一心一意只想跟你说byebye~(doge)

来自东京大学

这项火爆全网的研究,来自东京大学和日本Alternative Machine公司。

一作Takahide Yoshida,来自东京大学通用系统科学系。

另外两位作者升森敦士(Atsushi Masumori)和池上高志(Takashi Ikegami),都是既在东京大学,又属于Alternative Machine公司。

最后,不得不提到本次研究内容的主人公Alter3,它的幕后研究者也来自东京大学,由东京大学AI研究学者池上高志和日本“机器人之父”黑石浩联袂打造。

Alter3出生于2020年,是同系列机器人第三代产品。

据了解,Alter系列的两次迭代都是在歌剧演唱中完成的。第3代的初亮相就是在东京新国立剧场指挥管弦乐队并参加其他现场表演。

那个时候它的特色是增强了传感器,并改善了唱歌的表达能力和发声系统。

以及身体里那粒能够最终驱动43个气动装置的CPG。

CPG对数据的分析灵敏到什么程度呢?就是如果Alter3呆的房间里如果温度骤降,Alter3会因此打个冷颤,表示自己有被冷到。

这或许也为现在接入GPT-4当脑子后的它,能够活灵活现做表情、完成动作提供了一些基础吧。

One More Thing

说起人形机器人的最新消息,一定要提老马家特斯拉擎天柱Optimus的最新动态:

就在刚刚,马斯克突然在推特发布了Optimus的视频,表示Optimus第二代机器人(Gen 2)将在本月发布。

一点点“微小”的进步是二代Optimus步行速度提升了30%。

平衡感和身体控制能力也有所改善。

一把子期待住了!

参考链接:

[1]https://tnoinkwms.github.io/ALTER-LLM/

[2]https://arxiv.org/abs/2312.06571

[3]https://twitter.com/elonmusk/status/1734763060244386074

— 完 —

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见 ~

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง