01

研究动机

随着视觉–语言模型(Visual-Language Models, VLMs)在大量单模态和多模态下游任务上取得了显著的成功,全面理解它们的能力也变得至关重要。除了传统的观察模型在下游任务的微调表现外,目前大量工作通过衡量模型在精心构造的测试集上的零样本表现,来评估VLMs的特定能力。然而,这些工作所构造的数据集仍然局限在通用领域,我们仍然缺乏对 VLMs在特定领域能力的认知。假设VLMs在特定领域表现良好,我们就可以直接在该领域中使用这些模型而不进行任何修改。因此,我们全面研究VLMs在一个特定领域(食物领域)的泛化能力。为此,我们构建了一个食品描述数据集,Food-500

Cap,包含24700张食品图片,分为494个类别。每张图片都附有详细的描述,包括食物的细粒度属性,如成分、形状和颜色。我们还提供了一个饮食文化分类法,根据每种食物的地理起源来分类,以便更好地分析VLM在不同烹饪文化数据上的表现差异,如图1所示。在我们提出的数据集上的实验表明,流行的VLMs在食品领域的表现与在通用领域相比较差。此外,我们的研究揭示了VLMs在处理来自不同地域的食物时存在严重的偏见。我们采用了多种探测方法,评估了属于不同架构的九种VLMs,以验证上述观察结果。我们希望此项研究能够引起研究人员对于VLMs在应用于食品或烹饪文化领域时局限性的关注,并激发进一步的研究来解决这个问题。

图1 Food-500 Cap的一个例子

图1 Food-500 Cap的一个例子

02

贡献

1.我们为ISIA Food-500数据集的一个子集配备了(1)细致的图像描述(2)每个食品类别的地理来源。基于这个增强的数据集,我们提出了Food-500 Cap,它作为一个基准来评估视觉语言模型(VLMs)在食品领域的能力。据我们所知,Food-500 Cap是第一个专门针对食品领域的图像描述数据集。

2.我们在我们的基准上评估了九种不同架构的代表性VLMs,并使用四个探索任务全面分析VLMs在食品领域的表现。

3.我们在Food-500 Cap上的实验结果揭示了VLMs在食品领域的局限性,以及它们对特定烹饪文化的偏见。

03

数据集构建

选择图片:为了确保食品类别的多样性,我们使用了来自ISIA Food-500的图片,这是一个全面的食物识别数据集,包含399,726个样本,涵盖了来自不同国家和地区的500种食品类别。对于每个类别,我们从ISIA Food-500中随机选择50张图片。需要注意的是,实际上我们目前只使用了500个类别中的494个,有六个类别是手动移除的。

标注句子:为了获得描述细致视觉特征的高质量描述,我们雇佣了一家数据注释公司,并要求标注者遵循以下三条规则:首先,注释者必须在每个描述中包含类别标签,其中包含食物的主要信息。其次,我们鼓励注释者尽可能仔细,标记图像的所有可见内容,不仅包括食物的颜色、形状、成分、调味料、配件等,还包括容器的颜色、形状、图案等。为了确保描述的独特性,应尽可能避免使用一些普通词汇,如水果和蔬菜。最后,每个注释者都被指导将上述信息整合成流畅的句子,并使用多样的句法结构。

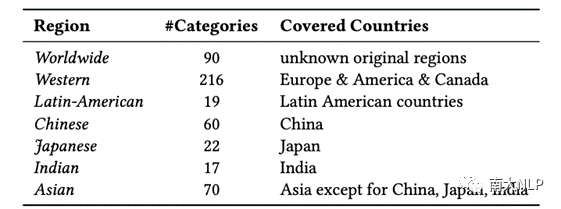

标注区域:尽管包含了多样化的食品类别,ISIA Food-500的一个不足之处是它将来自不同地区的食品类别混合在一起,而没有标明它们的原始地区,这阻碍了对烹饪文化的进一步研究。因此,我们基于维基百科,标记了每个食品类别的原始地区。结果,所有食品类别被划分为七个地区:全球、西方、拉丁美洲、中国、日本、印度和亚洲。表1显示了这些地区的食品类别分布。需要注意的是,有90个食品类别的原产地不明确,所以我们将它们归入全球类别。

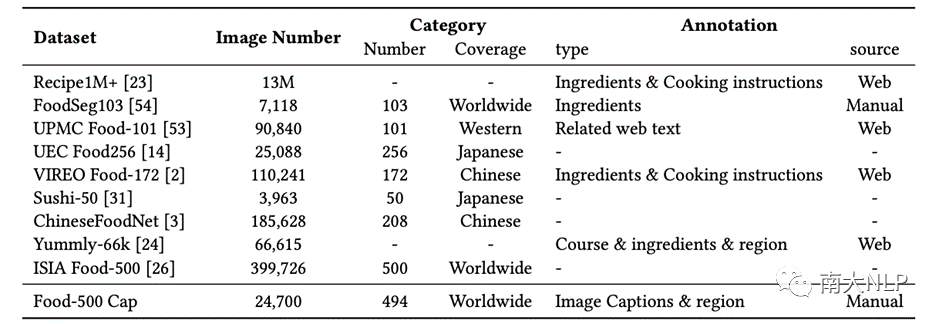

Food-500 Cap包含24,700张图像,均匀分布在494个类别中。每个描述的平均长度为18.57个词,平均包含7.26个名词、1.96个动词和2.53个形容词。Food-500 Cap与其他食物相关的数据集的对比如表2所示。

表1 Food-500

Cap中食品类别的地区分布

表2 流行食品领域数据集和Food-500 Cap的概述

04

测试多模态预训练模型在食物领域的性能

(1) 视觉语言表示模型(Vision-language

Representation Models)

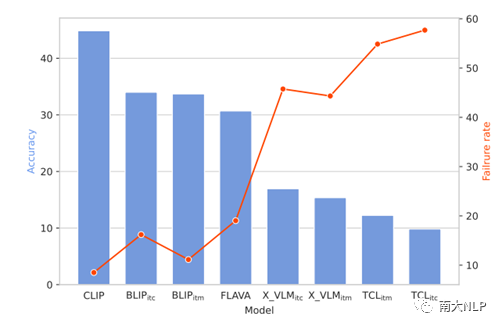

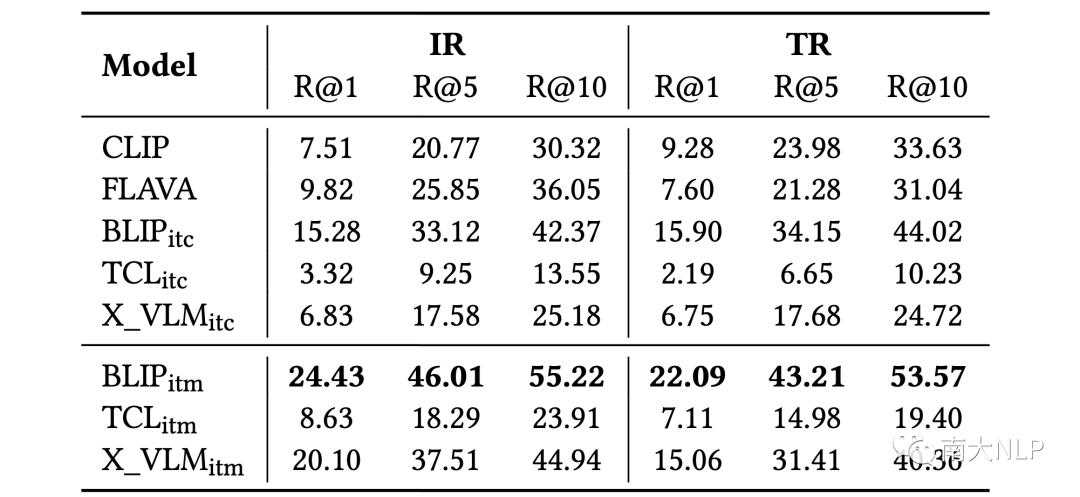

我们测试了CLIP, TCL, X_VLM, FLAVA和BLIP5个模型,使用了图像分类,图像-文本双向检索两个任务对他们它们在食物领域的性能进行评价,图像分类的实验结果展示在图2中,图像文本互检索的实验结果展示在表3中。实验发现,在图像分类任务上,VLMs未能识别某些食品类别,并展现出对烹饪文化的偏见;在图像-文本双向检索上,与通用领域相比,VLMs的总体表现并不是很好,在某些类别上的也表现出了很大的偏见。

图2 零样本分类的结果

图2 零样本分类的结果

表3 Food-500

Cap上零样本跨模态检索结果

(2) 图像到文本生成模型(Image-to-text

Generative Models)

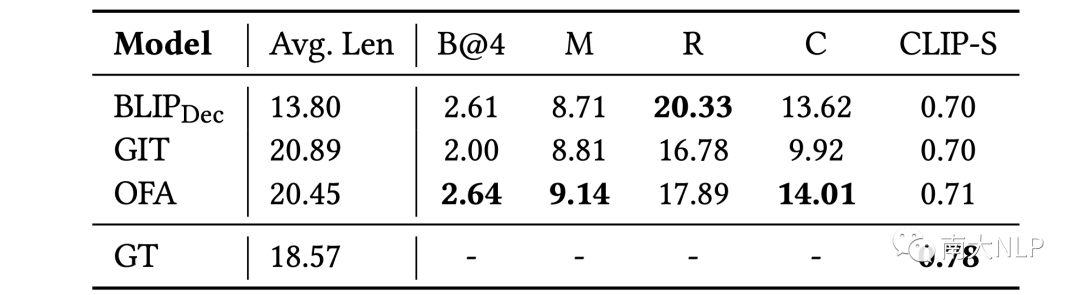

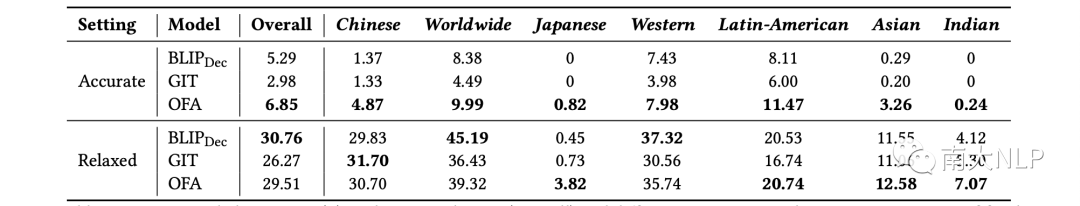

我们测试了GIT,OFA以及BLIP三个模型,使用图像描述生成模型作为评价任务,实验结果展示在表3,表4中。实验发现,这些模型在描述中很难生成正确的标签,也很少生成细粒度的描述词,如图3所示。

表4 在各种度量标准上的图像描述生成的结果

表5 整个数据集(whole)以及根据我们对食品类别分类的不同地区的语义标签准确度(百分比)

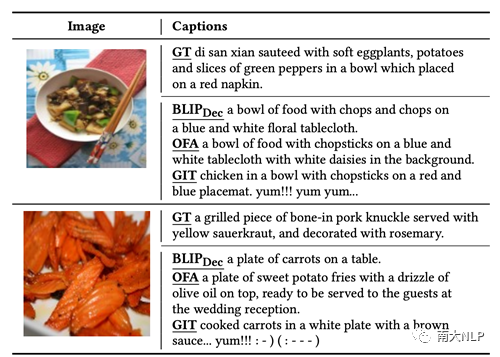

图3 三种图像到文本生成模型与真实情况(GT)生成描述示例的对比

图3 三种图像到文本生成模型与真实情况(GT)生成描述示例的对比

(3) 文本到图像生成模型 (Text-to-image

Generative Models)

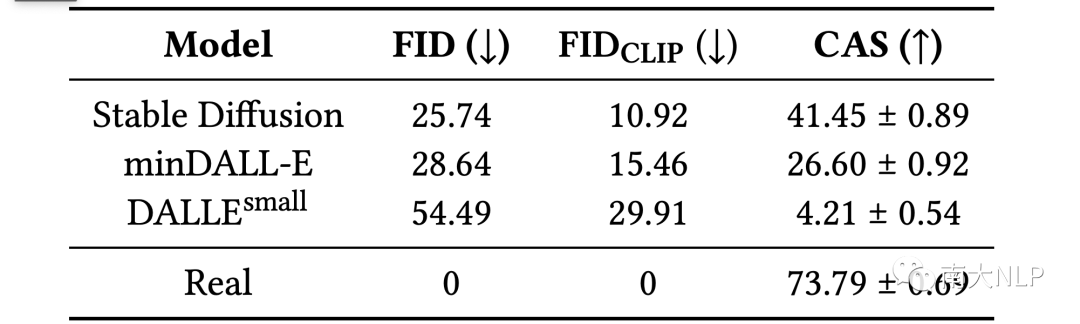

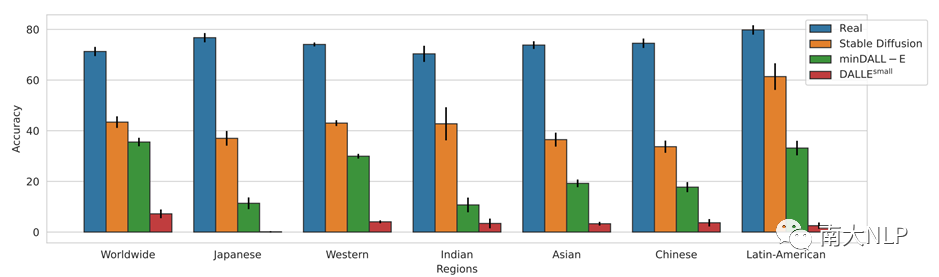

我们测试了DALL-E和Stable Diffusion两个模型,使用图像生成进行评价,实验结果展示在表6和图6中。实验表明,合成图像与真实图像之间存在显著差距,也面临与先前模型类似的地区不平衡问题。

表6 不同文本到图像生成模型的指标

图4 在真实图像与合成图像上训练的分类器的准确性(按地区划分)

图4 在真实图像与合成图像上训练的分类器的准确性(按地区划分)

05

总结

在这项工作中,我们提出了Food-500 Cap,这是食品领域的一个新的视觉语言基准。Food-500 Cap不仅为每张图片提供了细致的视觉内容描述,还标记了一个将食品类别划分为其地理起源的新分类法,这有助于研究不同地区的烹饪文化。我们在零样本设置中采用了四个视觉语言任务,包括食品分类、图像–文本双向检索、图像描述生成和图像合成,并在我们提出的基准上评估了三种不同架构的九种VLMs。实验揭示了VLMs在食品领域的局限性及其对烹饪文化的偏见。我们希望我们提出的基准能促进多模态食品计算的研究。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง