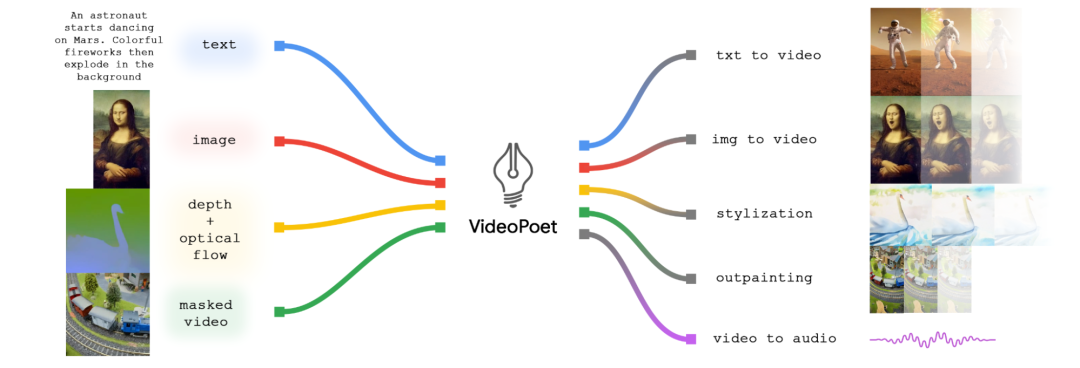

刚刚,Google AI发布了新的视频生成模型VideoPoet,之前的主流视频生成模型如Stable Video Diffusion和Video Diffusion是采用扩散架构,但是VideoPoet是基于大语言模型(LLM)来实现视频生成的,即采用LLM的自回归架构。VideoPoet的一个特色是它将许多视频生成能力无缝集成到一个LLM中。下图展示了VideoPoet的能力,它可以实现文本生成视频,图像生成视频,视频风格化,视频的inpainting和outpainting以及视频转语音。

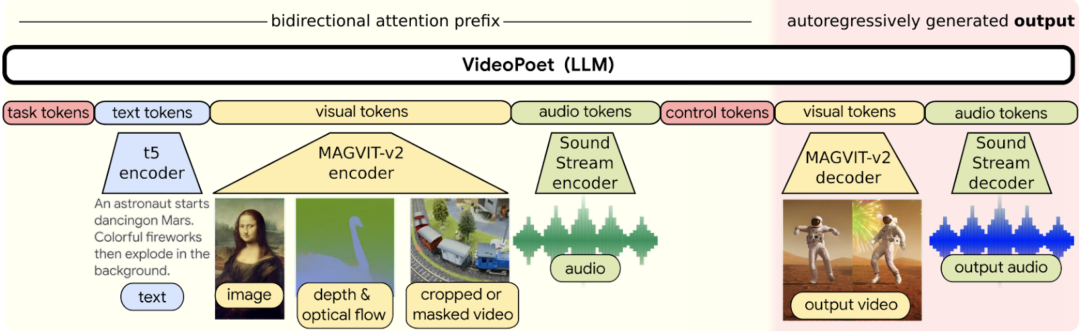

VideoPoet在架构上采用一个LLM来实现生成,由于LLM需要处理离散的tokens,这里分别采用MAGVIT V2和SoundStream做为Tokenizer将视频(包括图像)和语音进行token化,基于LLM生成的tokens可以通过这些Tokenizer的解码器再转成原始的视频或者语音。使用LLM进行训练的一个关键优势是,可以重用已有的LLM训练基础设施中引入的许多可扩展的效率改进,而且这个也可以实现多模态的生成的统一。

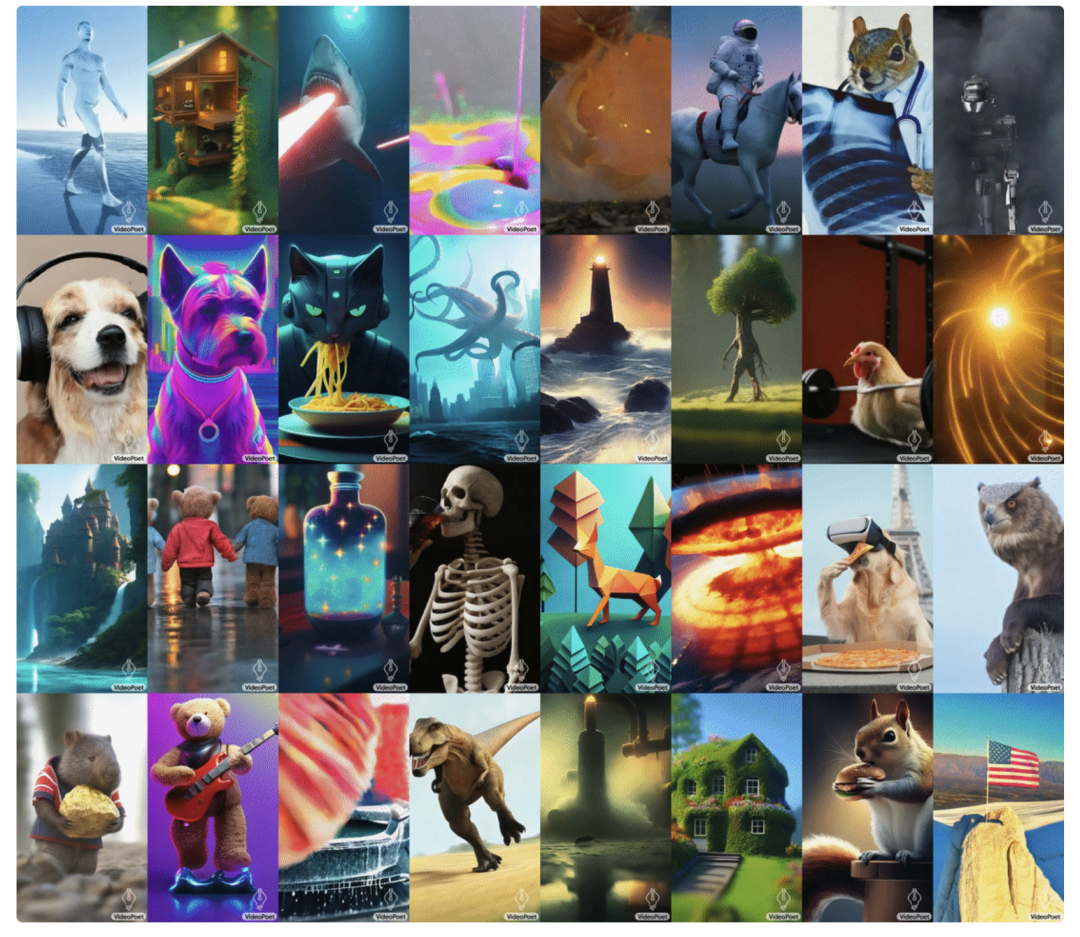

下图展示了VideoPoet生成的一些视频示例,看起来效果还挺好:

对于文本到视频的生成,视频输出的长度是可变的(LLM的优势),可以根据文本内容应用一系列的动作和风格,比如梵高的《Starry Night》。

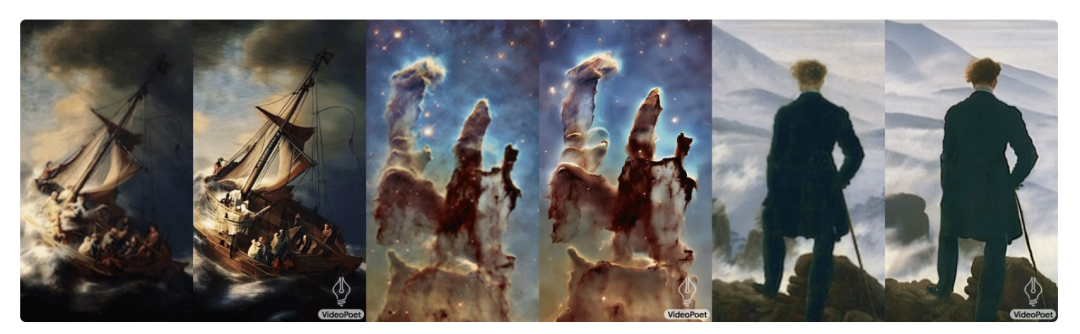

对于图像到视频,VideoPoet可以接收输入图像,并根据文本提示进行动画模仿:

Left: “A ship navigating the rough seas, thunderstorm and lightning, animated oil on canvas”. Middle: “Flying through a nebula with many twinkling stars”. Right: “A wanderer on a cliff with a cane looking down at the swirling sea fog below on a windy day”

对于视频风格化,我们在将一些额外的输入文本送入VideoPoet之前,先预测输入视频的光流和深度信息,然后转成风格化的视频。

Left: “Wombat wearing sunglasses holding a beach ball on a sunny beach.” Middle: “Teddy bears ice skating on a crystal clear frozen lake.” Right: “A metal lion roaring in the light of a forge.”

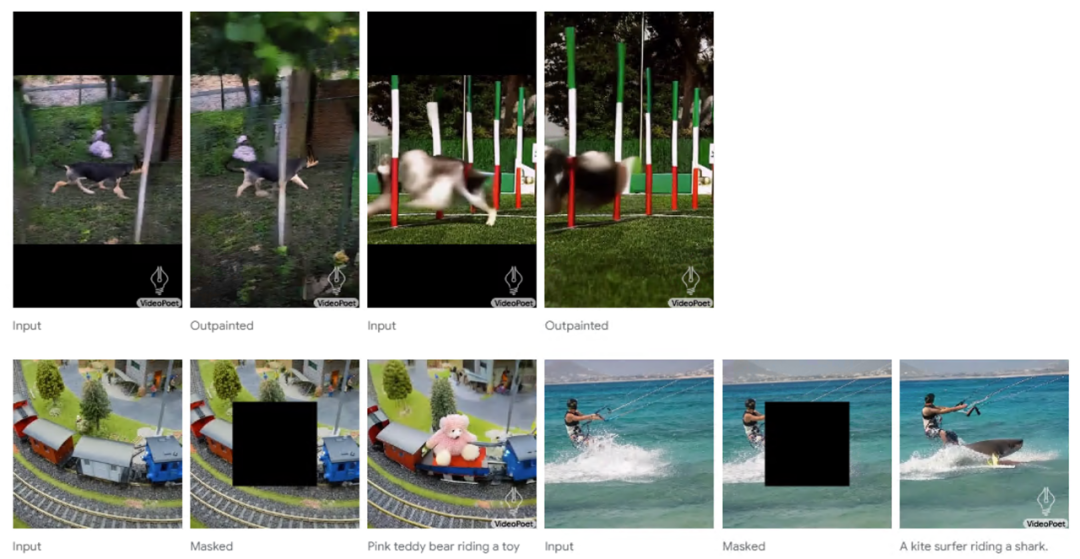

VideoPoet也可以输入带mask的视频,来实现视频的Inpainting和outpainting:

VideoPoet也能生成音频。在这里,我们首先从模型中生成2秒的片段,然后尝试在没有任何文本指导的情况下预测音频。这使得从单一模型生成视频和音频成为可能。

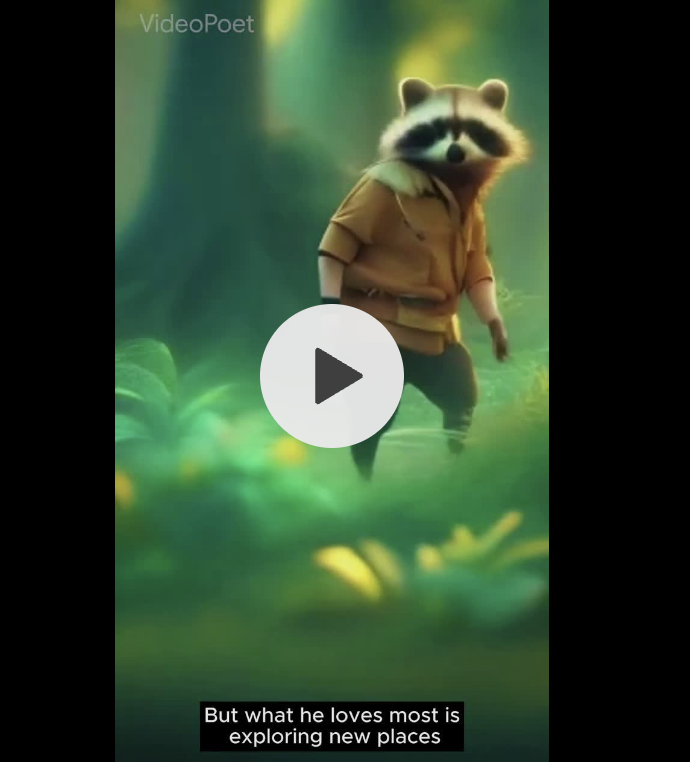

为了展示VideoPoet的强大能力,Google专门制作了一部由VideoPoet生成的许多短片段组成的简短电影。对于剧本,这里用Bard写了一个关于旅行浣熊的短故事,包括逐场分解和一系列配套的提示词。然后为每个提示词生成视频片段,并将所有结果片段拼接在一起,制作出下面的最终视频。

VideoPoet还通过对最后1秒的视频进行条件设置并预测下一秒的视频,简单地生成更长的视频。通过反复进行这种过程,模型不仅可以很好地延长视频,而且即使在几次迭代过程中,也能忠实地保持所有物体的外观。以下是两个VideoPoet从文本输入生成长视频的例子:

此外,你也可以交互式地编辑由VideoPoet生成的现有视频片段。比如提供一个输入视频,你可以改变物体的运动以执行不同的动作。物体的操纵可以在第一帧或中间帧进行,这允许高度的编辑控制。例如,可以从输入视频中随机生成些片段,并选择想要的下一个片段。

类似地,你可以通过文本提示词来控制输入图像的motion以生成不同的视频:

VideoPoet还可以通过在文本提示后附加所需的摄像机运动类型来准确控制摄像机的运动。下面是一个具体的示例:

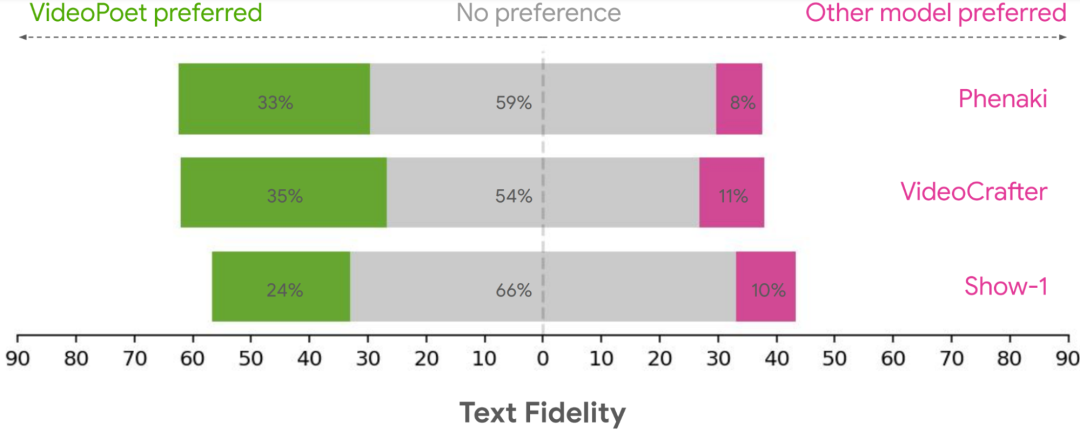

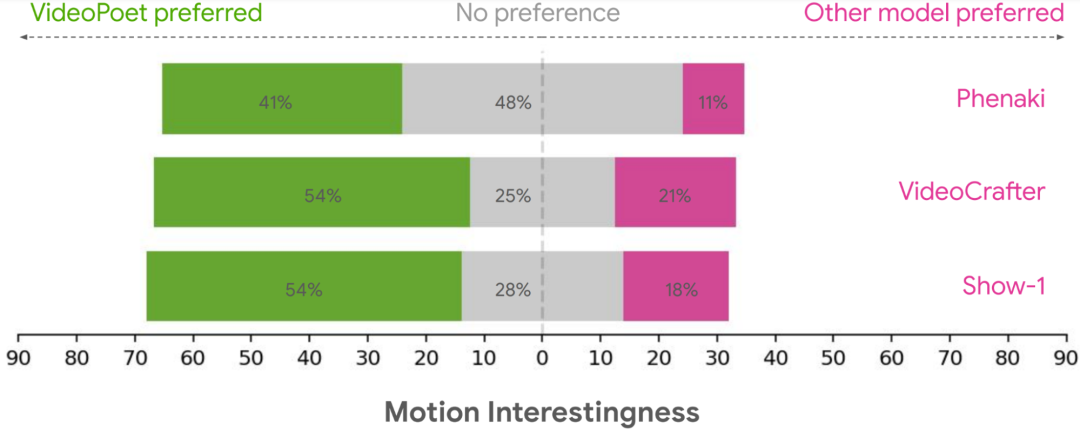

Google将VideoPoet与其它模型进行了人工评测,从text fidelity和motion interestingness上VideoPoet有明显优势:

VideoPoet展示了使用LLMs在视频生成领域具有很大的潜力,这个框架应该能够支持“任何到任何”的生成,例如,扩展到文本到音频,音频到视频,以及视频字幕等都应该是可能的。我觉得这个也是LLM的优势,可以实现多模态的大一统。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง