半年 toB 商业化探索后,百川智能给出了针对大量定制化需求的产品解决方案。12 月 19 日,百川智能发布基于搜索增强的 Baichuan2-Turbo 系列 API,包含 Baichuan2-Turbo-192K 及 Baichuan2-Turbo。在支持 192K 上下文窗口的基础上,增加了搜索增强知识库的能力。在百川智能创始人& CEO 王小川看来,「搜索增强」是大模型落地应用的关键,能够解决 99% 知识库定制化的需求。

01

搜索增强

大模型的「外挂硬盘」

大模型落地时存在一些问题:幻觉,回答不准确;时效性差,知识无法及时更新;专业知识不足,垂直落地门槛高等。百川智能给出的解决方案是:长文本大模型+搜索增强,让模型能获取互联网实时信息,也能接入企业完整知识库。「大模型是新时代的计算机」是业内常用的比喻,上下文窗口是模型能力的内存,而王小川认为,「搜索增强」是大模型的「硬盘」,将互联网实时信息和企业知识库像硬盘一样即插即用,「外挂在计算机上」。

目前业内已经有一些基于搜索的解决方案。学术界提出知识注入、知识研究的新研究方向,Meta Cove、Google LAMDA、OpenAI WebGPT 等都是类似理念的产物。RAG(检索增强)成为一个热门方向,生态包括 Langchain、LlamaIndex 等热门项目。OpenAI 在 11 月的开发者大会上,也发布了自研的 RAG 产品 Retrieval 检索工具。在大模型无法直接落地到各种场景时,搜索能力的加入补完了大模型落地的完整技术栈。在此之前,百川发布了向量数据库,也推出了 192k 的长文本模型。在这两者的基础上,百川实现了稀疏检索和向量检索并行,以及搜索系统与大模型的对齐。

经过百川智能算法团队的测试,搜索增强+长文本+大模型的方案,能够接入 5000 万 tokens 的数据集,比模型本身的 context window 提升「两个数量级」,实现 95% 精度的回答。王小川表示,搜索增强知识库能够替代绝大部分企业个性化微调,解决 99% 企业知识库的定制化需求。

02

真·大海捞针

支持检索 1 亿汉字

稀疏检索+向量检索

在向量数据库和长文本窗口外,百川智能发挥了自己过往做搜索的经验,对向量检索进行了改进和增强,在向量检索之外增加了搜索引擎里常用到的稀疏检索方式。「稀疏检索是原来我们做搜索引擎里用到的基于符号的搜索方式。向量检索语义上会更加贴近,但其实会有很多漂移和漏召,而稀疏检索对严格的语义,漂移也好,效率也好,会比向量检索高很多,所以这两个系统各有优势,两个并行起来怎么能组装在一块,这是我们在做的工作。」王小川解释道。两种检索方式的组合经过调优后,将传统向量检索可用率从 80% 提到 95%,把 RAG 检索系统的能力带到了全新的高度。

搜索与模型的对齐

王小川提到,以前做搜索时,用户提问更多是关键词或短句,而今天大模型的提问,更多是更复杂的完整问题,「这种问题通过稀疏检索和向量检索跟搜索系统对接,是一个新的技术攻克点。」百川通过 prompt2query、doc2query 对齐用户需求,做到搜索系统与模型本身的对齐。

真·大海捞针

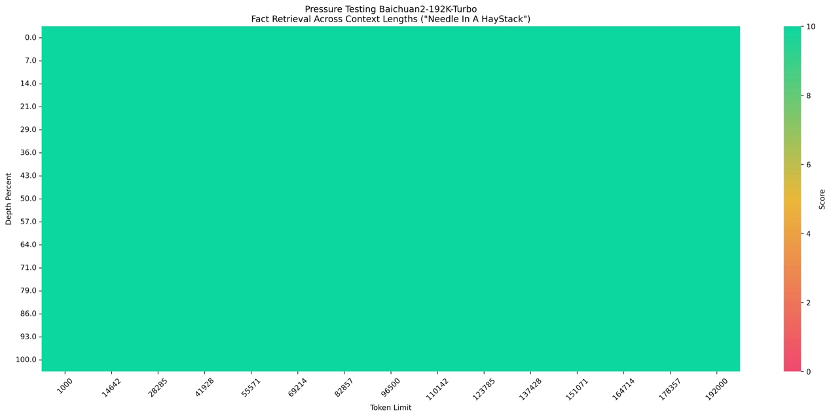

「大海捞针」是近期非常热门的,针对大模型长文本能力的一个测试。百川大模型在面对 192k 以内的请求时,实现了 100% 回答精度。针对 192k token 以上的文档数据,百川在测试中,面对文本总量提升 250 倍,达到 5000 万 tokens,近 1 亿字的测试集,用稀疏检索+向量检索的方式,可以实现 95% 以上的回答精度。「我们管这个测试叫『真·大海捞针』。」王小川说。

03

避免项目化

用 API 产品解决定制化需求

王小川表示,搜索增强最大的目的不是解决幻觉问题,而是解决「可定制化」问题。前搜狗 CMO,目前担任公司联创、联席总裁的洪涛在 8 月加入百川智能,负责商业化。在商业化线索沟通中,洪涛发现,前期很多客户「想了解大模型,很多人来问大模型到底是什么,能干什么」,而最近两个月,客户的问题越来越具体,「已经有一些场景感受到能用大模型了,但是解决的时候比较痛苦,最基础的是微调,狠一点的 SFT、Post-Training 都会提,但这些其实很『重』。」通过 SFT、Post-Training 的方式训练行业模型,需要企业具备一定的大模型技术人才,需要一定量的算力和时间成本,并且一旦出现数据更新,或者基座模型升级的情况,都需要重新训练。核心还是成本,客户成本高,项目利润低。「相对能盈利的 toB 公司,卖的大多是『产品』,而大多数定制化是『项目』,」洪涛说,搜索增强的完整技术栈,目的就是让 API 外挂企业知识库实现「定制化」,是一款产品,可配置、可调整。他举了 Oracle 的例子,各种产品的组合提供解决方案,而不是单独开发一个数据库。「我们也希望在为私有化客户做定制化的时候,用产品组合的方式来做,而不是用全都重新开发一遍的方式做。」洪涛对 Founder Park 说道。王小川进一步阐释称,所谓定制化,customize,更准确地说是个性化,客户天生有「个性化」的需求。百川希望避免的,是「项目化」,「用产品化取代项目化,是指产品具有定制化的能力,能够实现企业的低成本定制。企业可以把知识库对接,避免做成项目,客户成本很高。」

如果你关注大模型领域,欢迎扫码加入我们的大模型交流群,来一起探讨大模型时代的共识和认知,跟上大模型时代的这股浪潮。

更多阅读从100多个GPTs里,探究OpenAI究竟想要什么,又做了什么

估值超5亿美元,体验碾压Bard、Bing,AI搜索引擎Perplexity的想象力在哪里?

Meta、Midjourney、Adobe、DALL·E:四大巨头的 AI 绘图模型综合评测

时代周刊:为什么 Sam Altman 是 2023 年度 CEO?

MindOS:站在AGI风口,创业两年的教训与思考

专访Pika Labs创始人:视频模型技术路线尚未确定,明年会迎来AI视频的GPT时刻

转载原创文章请添加微信:geekparker

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง