首创!BEV-CV:用鸟瞰视角变换实现跨视角地理定位

1. 文章简介

因为航拍视角和地面视角之间有很大的差异,所以跨视角地理定位一直是一个难题。本文提出了一种新方法,可以利用地理参考图像进行定位,而不需要外部设备或昂贵的设备。现有的研究使用各种技术来缩小域间的差距,例如对航拍图像进行极坐标变换或在不同视角之间进行合成。然而,这些方法通常需要360°的视野,限制了它们的实际应用。我们提出了BEV-CV,这是一种具有两个关键创新的方法。首先,我们将地面级图像转换为语义鸟瞰图,然后匹配嵌入,使其可以直接与航拍分割表示进行比较。其次,我们在该领域首次引入了标准化温度缩放的交叉熵损失,实现了比标准三元组损失更快的收敛。BEV-CV在两个公开数据集上实现了最先进的召回精度,70°裁剪的特征提取Top-1率提高了300%以上,Top-1%率提高了约150%,对于方向感知应用,我们实现了70°裁剪的Top-1精度提高了35%。

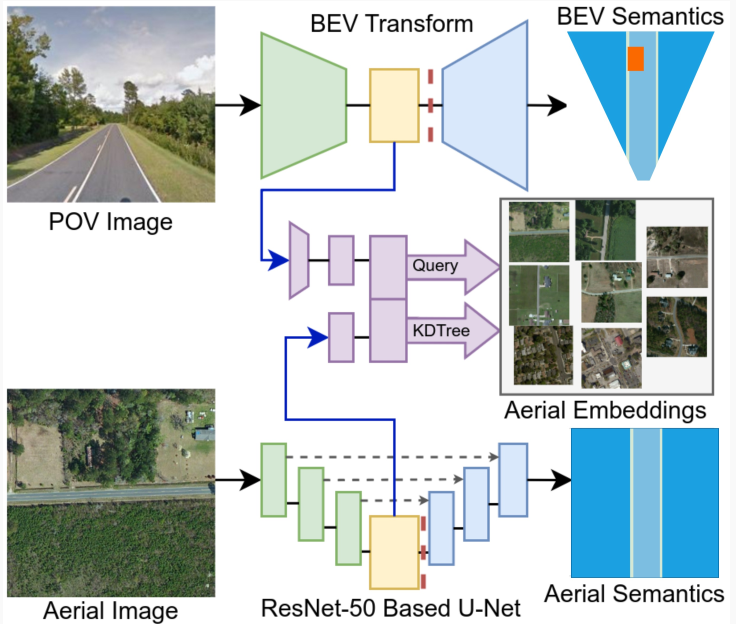

图1. 两分支网络的一般设计。POV 分支变换和提取地面级特征嵌入,Map 分支提取航拍嵌入来构建 KDTree。虚线右侧的组件在最终训练的 BEV-CV 结构中不使用。

2. 背景简介

定位是机器人技术的关键——从自动驾驶汽车到无人驾驶火车,定位能力是必不可少的。目前,大多数定位技术依赖于外部传感器提供位置信息或计算位置。这种对GNSS等外部设备的依赖可能会导致遮挡或传感器故障等问题,从而影响定位。类似地,基于激光雷达的方法成本高昂且耗电量大。基于视觉的定位提供了一种解决方案,因为相机成本低廉,体积小,使机器人能够从环境中获取更多信息以进行自我定位。此外,大多数现代车辆都配备了前置相机,这使得有限FOV跨视角地理定位的实施变得容易。

跨视角地理定位的目标是匹配地面透视图像和地理参考航拍图像。在本研究中,我们将从车载前置有限FOV相机拍摄的图像称为第一人称视角(POV)图像,将卫星或航拍图像称为航拍图像。跨视角地理定位可以作为一种自主定位的解决方案,因为它创建了一个航拍特征嵌入的本地数据库,并不断使用POV特征嵌入进行查询,如图1所示。定位精度仅取决于系统匹配图像的能力。

我们的研究提出了一种新颖的方法来缩小POV和航拍图像视角之间的域差异,以提高跨视角地理定位的性能。我们提出了BEV-CV,这是一个架构,它通过在多个分辨率下提取并投影语义特征,将其转换为共享表示空间,并通过嵌入对来匹配它们。

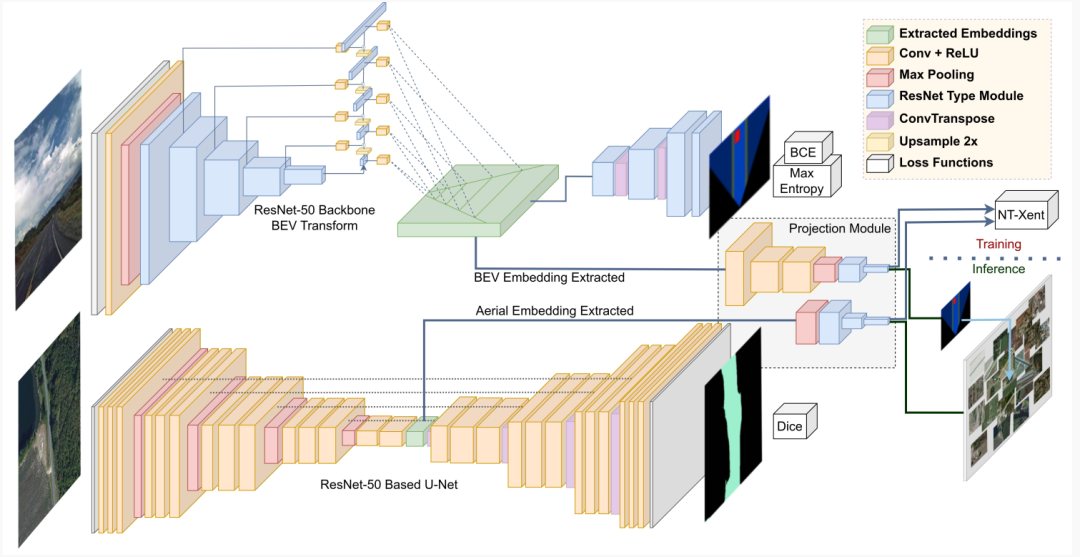

图2. BEV-CV 网络概述:BEV 分支如上路径所示,从 POV 变换到 BEV 再提取嵌入进行投影,下路径的航拍分支从 U 型网潜在空间中提取嵌入。训练时使用 NT-Xent 损失函数,推理时构建航拍嵌入的 KDTree,用欧几里得距离查询 POV 嵌入进行检索。

3. 方法详解

本文的目标是最小化航拍图像和POV图像视角之间的域间差异,以生成相似的嵌入输入。我们将两个图像转换为俯视图,提取并投影特征到共享表示空间中。网络架构如图2所示,是一个没有权重共享的双分支系统。

A. 语义特征提取

为了为地面透视图像创建俯视表示,我们构建了BEV-CV的BEV分支。该网络包含四个阶段,实现在视角之间提取和重新采样透视信息。

两个分支都有编码器-解码器结构来提取特征,这些特征被重构为语义占用栅格。使用相应的数据集进行训练,编码器被提取并组合成BEV-CV的双分支网络。我们使用语义分割来比较嵌入,因为两个图像中的类布局是类似的,只要转换就可以比较。POV和航拍输入图像都是RGB: ,,。

图3. CVUSA 和 CVACT 的全景图示例,右侧显示 90° 航向对齐的 FOV 裁剪。

1)BEV特征变换和提取:对于BEV,输入地面全景图像裁剪为有限FOV(图3中的示例),并调整大小为,其中FOV,和航向,,:

。

图像通过基于ResNet-50的网络,该网络在递减分辨率下提取特征,以保留不同深度的摄像机信息。这些提取被连接成特征金字塔网络(FPN),该网络通过自顶向下路径和顺序侧边连接将强的低分辨率语义与弱的高分辨率语义相结合,如图2中的BEV变换所示。表示该层FPN的第个输出,连接()来自相应的backbone层的输出与上一层的上采样特征:

其中 是随着深度增加的ResNet层输出,生成个独立输出作为特征金字塔。

FPN像素位置的激活值使用多尺度密集变换(MSD)与摄像机内参χ一起重新采样到BEV映射中,以在维度上扩展特征并使用 栅格分辨率完成垂直平面到水平平面的转换。重采样使用标定内参来确定从对象高度到对象深度的语义信息的转换。

这些变换 , 沿垂直尺寸浓缩特征,同时保持水平分辨率并通过深度扩展,使得:

其中 χ 是摄像机的焦距。在BEV-CV中,提取的正交特征通过一系列卷积层ψ传递,以产生压缩的BEV嵌入 。

2)航拍特征提取:对于网络的航拍分支,我们构建了一个基于ResNet-50的U型网络。我们选择这种结构是因为U型网络 已经成为语义分割的主流方法,保留减少分辨率的信息以改进空间上下文。航拍分支使用连接编码和解码阶段的完整U型网络进行预训练。

在训练BEV-CV之后,只使用编码器。与BEV分支类似,在逐步编码映射中提取航拍嵌入,每个解码器都从先前的解码器解码,并连接来自相应编码器的提取结果。

与BEV变换不同,该网络仅从最终卷积模块输出。

分离编码器需要从BEV提取多尺度密集变换后的输出,从U型网络的潜在空间中获取航拍输出。为了完成BEV特征提取分支,该表示通过进一步的卷积层压缩以形成实用嵌入——作为可鉴别性与KDTree限制之间的阈值。为了将两个编码器输出转换为标准化大小的共享表示空间,我们添加了一个投影模块。这包含全连接层、泄漏ReLU功能和批量标准化。

航拍图像嵌入 η来自U型网络最后一个编码层的输出。

B. 标准化温度缩放的交叉熵损失

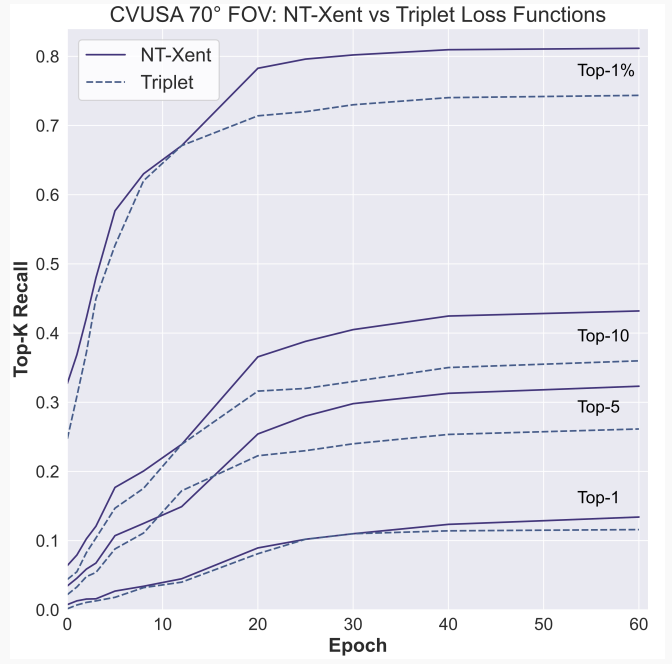

三元组损失一直用于CVGL研究中,以将正图像对拉近,并将负图像对推远在表示空间中。使用三元组损失函数训练BEV-CV产生了满意的结果。我们提出使用标准化温度缩放的交叉熵损失(NT-Xent)函数来解决这个问题。

NT-Xent接受与三元组损失相同的输入:透视图像以及相应的正面航拍图像对和负面航拍图像对。确定负对的各种技术通常取决于嵌入之间的初始L2距离。硬三元组挖掘使用的负样本距离锚点比正样本距离更近,对于半硬三元组挖掘,负样本不接近锚点胜过正样本,但它仍然有一个正损失。我们不明确地为训练选择三元组,而是使用批次中每个其他航拍图像作为负示例,从而批量大小为B会有B(B-1)个负示例。

给定一批n个CVGL嵌入对η,η,损失函数为:

其中D是温度(τ)归一化余弦相似度。

最终损失在一批中计算所有正对。

4. 结果

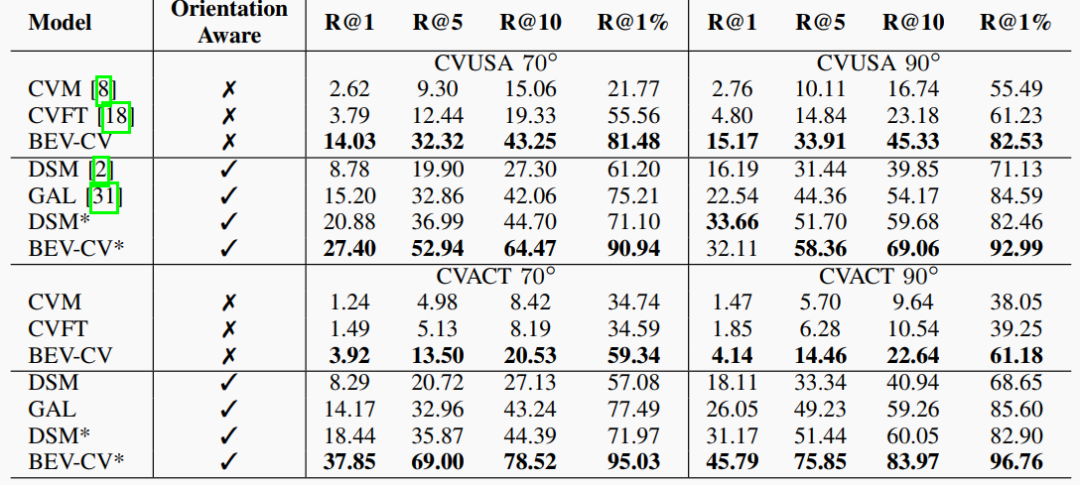

BEV-CV在两个公开数据集上实现了最先进的召回精度,70°裁剪的特征提取Top-1率提高了300%以上,Top-1%率提高了约150%,对于方向感知应用,我们实现了70°裁剪的Top-1精度提高了35%。

表I. BEV-CV 评估和与先前工作的比较

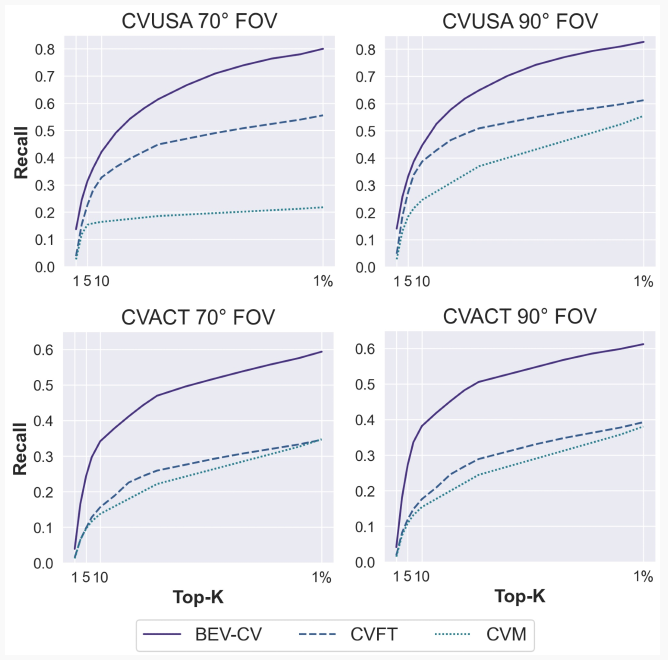

图4. CVUSA 和 CVACT 数据集上的特征提取 Top-K 召回精度(R@K)曲线

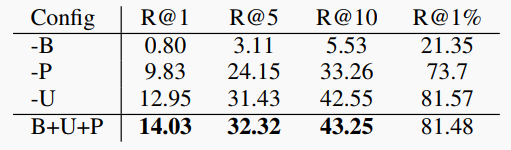

表II. 使用 70°CVUSA 裁剪进行的消融研究。B 指 BEV 模块,P 指投影模块,U 指 U 型网络

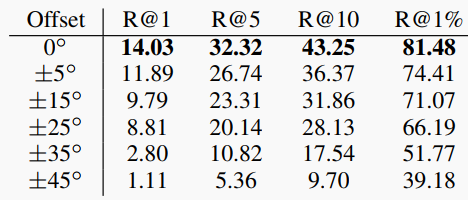

表III. 带有偏航的 70°POV 裁剪的召回精度

图5. CVUSA Top-5 召回示例。轮廓:紫色 – 查询 POV 图像,绿色 – 正确的航拍图像,红色 – 错误的航拍图像

图6. 三元组和 NT-Xent 损失函数之间的 Top-K 召回精度比较,NT-Xent 通常实现更快更好的收敛

5. 结论

本文介绍了一种新颖的技术,用于减少有限FOV CVGL中的域间差异,确立了BEV变换在CVGL中的可行性,作为增加实用性的一种途径。与先前的特征提取方法相比,我们将CVUSA的Top-1检索率提高了两倍以上,展示了该领域的强大潜力。当然,我们的方法存在一些局限性。例如,BEV变换规范在训练期间设置,这决定了BEV变换模块中的参数数量和变换形状,这根据摄像机内参而定。这限制了网络推理时对未见内参的泛化能力。然而,我们已经证明基于CNN的BEV网络可以用作CVGL中通常使用的CNN编码器主干的替代品。进一步的工作应该致力于用更广泛的区域、光照和天气条件来推广BEV-CV,因为当前数据集是在白天晴朗的天气条件下从相对较小的区域收集的。

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง

ufabet

มีเกมให้เลือกเล่นมากมาย: เกมเดิมพันหลากหลาย ครบทุกค่ายดัง